Top500-Supercomputer: Neuer Schwung dank Nvidia H100 und Intel-Chips Update

Die Gesamtleistung der Superrechner auf der 62. Top500-Liste stieg um 34 Prozent. Nvidias H100 punktet in mehreren Systemen, Intels Aurora enttäuscht.

Nun ist es endlich da, das lang erwartete Aurora-System am Argonne National Lab – mit fünf Jahren Verspätung und ganz anderen Prozessoren als ursprünglich geplant. Eigentlich sollte es im Rahmen des US Exascale Computing Projects, finanziert vom Department of Energy (DOE), ein Exascale-Rechner werden, aber darauf muss man weiter warten. Laut der neuen und nunmehr 62. Top500-Liste der Supercomputer schafft Aurora gerade die Hälfte. Aber das reicht immerhin für Platz 2 hinter dem seit Mitte 2022 amtierenden Spitzenreiter Frontier mit AMD-Technik [1].

Zwar jubelten im Juni dieses Jahres Intel und HPE, nun sei Aurora endlich "fully equipped" mit allen 10.624 Blades, deshalb waren die Erwartungen hoch. Doch offenbar fehlen immer noch zahlreiche Sapphire-Rapids-Prozessoren (Xeon CPU Max 9470) und vor allem wohl Ponte-Vecchio-Rechenbeschleuniger (Data Center GPU Max 1550), denn der für die Einstufung in die Top500-Liste zugrunde gelegte Linpack-Benchmark (HPL) lief nur mit halber Kraft und kam so nur auf schlappe 585 Petaflops (PFlops). Das ist nur etwas mehr als die Hälfte dessen, was der Frontier des Oak Ridge National Lab ins Feld führt, der damit weiterhin als einziges Exascale-System die Top500-Liste anführt.

Aurora: halb fertig, schlechte Effizienz

Was hatte Intel zuvor getrommelt? [2] Von 52 Teraflops (TFlops) Spitzenleistung pro Ponte-Vecchio-GPU war die Rede. Bei Vollausbau mit 63.744 GPUs wären das allein schon 3,3 Exaflops (EFlops) theoretische Spitzenleistung (RPeak) und da käme noch die Leistung von über einer Million Rechenkernen der Max-9470-Xeons mit HBM-RAM [3] hinzu.

Im Aurora kommt allerdings eine Custom-Version der Data Center GPU Max 1550 zum Einsatz, die rund 31 TFlops leistet.

Top10 der 62. Top500-Liste vom November 2023 (0 Bilder) [4]

Okay, Intel hat wohlweislich nicht ganz so hoch gestapelt und lediglich von "über 2 EFlops Peak" gesprochen – aktuell sind es aber nur 1,06 EFlops, denn statt mit 21.248 Xeons und 63.744 GPUs wirkten nur 10.878 Xeons und 32.634 GPUs mit.

Auch die Effizienz von Aurora ist weit schlechter als bislang allgemein angenommen: Im HPL-Benchmark liefert er lediglich 55,3 Prozent seiner theoretischen Spitzenleistung, liegt damit in der Liste auf Platz 295. Zum Vergleich: Der führende Frontier kommt auf 71,1 Prozent.

Und bei der Energieeffizienz sieht es noch krasser aus: 23,7 GFlops/W im Vergleich zu 52,6 GFlops/Watt des Frontier. Fazit: Die Blamage von Intel setzt sich fort.

Frontier kommt überdies mit einem speziell optimierten Linpack-Lauf sogar auf 62,7 GFlops/W, belegt damit Platz 2 der Green500-Liste und liegt damit vor drei weiteren HPE/AMD-Rechnern.

Die Spitze der Green500 markiert mit 65,4 GFlops/W weiterhin der speziell auf Energieeffizienz getrimmte, relativ schwache Rechner Henri am Flatiron-Institut mit Intel Xeon und Nvidia H100.

Mini-Auroras

Drei weitere Systeme sind wie Aurora mit Intels Max-CPUs und Max-GPUs bestückt: Dawn von Dell an der Universität in Cambridge mit 19,5 PFlops (Platz 41), SuperMUC NG Phase 2 von Lenovo am Leibniz-Rechenzentrum mit 17,2 PFlops (Platz 52) und Clementina XXI, ebenfalls von Lenovo, in Argentinien am Servicio Meterologico Nacional mit 3,9 PFlops auf Platz 196.

(Bild: c’t Magazin/C. Windeck)

Alle drei haben aber nur je zwei GPUs pro Prozessor eingebaut, während es bei Aurora derer drei sind. Die Effizienzen variieren sehr, bei den beiden Lenovo-Maschinen sind es 61,5 beziehungsweise 64,7 Prozent, beim Dell-System in Cambridge schlappe 36,1 Prozent. Das hängt natürlich auch davon ab, wie viel Aufwand man in die Optimierung des Linpack-Laufs hineingesteckt hat. Das Leibniz-Rechenzentrum hat auch Energieeffizienz gemessen, die sich aber kaum vom schlechten Aurora-Wert unterscheidet.

Es gibt auch Sapphire-Rapids-Systeme ohne GPUs, etwa der Crossroads der National Nuclear Security Administration, aufgebaut von HPE, der mit 12.708 Xeon-Max-Prozessoren mit je 56 Kernen ins Rennen geht und 30 PFlops (Platz 24) erreicht, mit 75 Prozent HPL-Effizienz. Aber hier ist dann die Energieeffizienz mit 4,8 GFlops/W im Abseits. Viele andere neue Xeon-Cluster haben Nvidia-GPUs eingebaut.

Mehr Bewegung in den Top10

Anders als bei der vorangegangenen Top500-Liste vom Sommer 2023 hat sich in der Spitze der Top10 einiges verändert. Knapp hinter Aurora schob sich mit 561 PFlops ein Cloud-System von Microsoft Azure auf Platz 3, ebenfalls mit Sapphire Rapids, aber mit Nvidia H100 als GPU.

Zwei weitere Systeme mit ebendieser Intel/Nvidia-Kombination belegen die Plätze 8 und 9: Der EuroHPC MareNostrum 5 ACC in Barcelona mit 138 PFlops und Nvidias hauseigener Supercomputer EOS mit 121 PFlops.

Der andere EuroHPC-Rechner in den Top10, Lumi mit AMD-CPUs und -GPUs am Standort Finnland, wurde noch ein bisschen von 309 auf 378 PFlops aufgerüstet (Platz 5). Das reicht aber nicht, um den japanische Fugaku mit ARM64FX mit 442 PFlops zu überholen, der nunmehr Platz vier belegt.

Chinas Sunway TaihuLight mit seinen 93 PFlops ist derweil aus den Top10 verdrängt (Platz 11). Aber China ist bezüglich Top500 ja aus dem Rennen. Aus Protest gegen die Exportbeschränkungen der USA werden schon seit einiger Zeit so gut wie keine Neusysteme mehr gemeldet – diesmal genau Null.

Lenovo als Besitzer der alten IBM-Werke kann aber diverse Neusysteme vermelden, wenn auch nur im chinesischen Ausland. Passenderweise findet parallel zur SC23 das Gipfeltreffen der Asiatisch-Pazifischen Wirtschaftsgemeinschaft (APEC) in den USA statt, wo auch Joe Biden und Xi JinPing miteinander sprechen wollen und vielleicht bahnt sich wieder etwas Entspannung an.

Chinesische Systeme auf der Liste

Lenovo behauptet sich trotz der Restriktionen weiterhin gut im Wettbewerb, mit 166 (zuvor 168) Systemen liegt die chinesische Firma klar an der Spitze, die zusammen allerdings insgesamt "nur" 607 PFlops leisten. Demgegenüber hat HPE samt Cray zwar nur 105 Systeme (zuvor 100) platziert, aber mit einer Gesamtleistung von 2,5 EFlops. Dritter ist jetzt Eviden (ehemals Atos/Bull) mit 48 Systemen (zuvor 43/687 PFlops) vor Inspur mit 34 Systemen (zuvor 43/77 PFlops).

China, so verlautete auch schon seit einiger Zeit, soll bereits mehrere Exascale-Systeme in Betrieb haben, mit hausgemachten Prozessoren und Beschleunigern. Einige Details sind inzwischen über den Nachfolger des Sunway-Prozessors SW26010 bekannt, der den Top500-Spitzenreiter TaihuLight seit 2017 antreibt. In einigen Sessions auf der SC23 lassen chinesische Wissenschaftler zumindest ein bisschen etwas zur Performance der neuen Systeme mit über 40 Millionen Kernen heraus. So etwa den Wert für HPL in Mixed Precision (HPL MxP) von über 5 EFlops. Zum Vergleich: der Top500-Spitzenreiter Frontier kommt auf 9,9 EFlops.

In der Länderstatistik führt nun die USA mit 161 vor China mit 104, Deutschland mit 36, Japan mit 32, Frankreich mit 23 und Großbritannien mit 12. Aber die Aussagekraft ist durch den China-Ausstieg natürlich eingeschränkt.

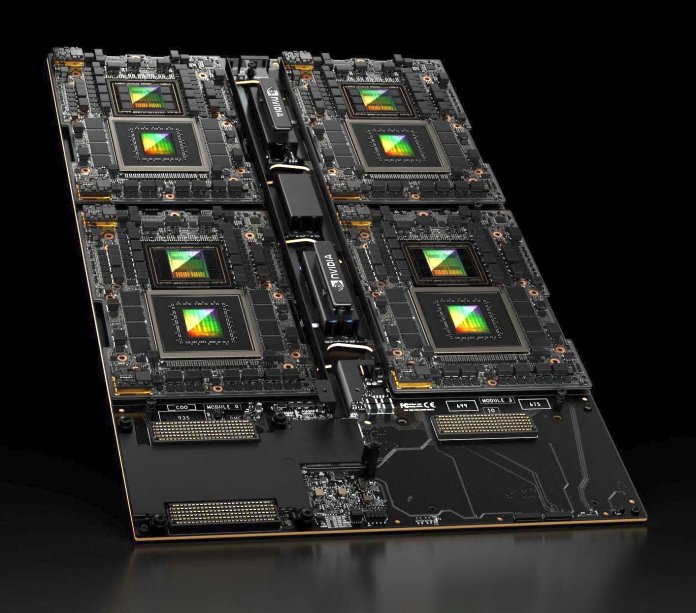

(Bild: Nvidia)

Hinzu kommt insbesondere in Europa, dass die Aufteilung nach Standorten die nationalen Investitionen und Verantwortlichkeiten nicht wirklich ausdrückt. So ist das EuroHPC-System LUMI in Finnland zu Hause, wird aber von zehn Staaten betrieben, aus der EU sowie Schweiz, Norwegen und Island. Die beiden MareNostrum-Rechner in Spanien werden zu 50 Prozent von der EuroHPC-Joint Undertaking und zu 50 Prozent von Spanien, Portugal und der Türkei betrieben. Ähnliches gilt für Leonardo in Bolognia wo neben der EuroHPC-JU die Länder Österreich, Griechenland, Ungarn, Italien, Slowenien, und Slowakei direkt beteiligt sind.

Auch die vier neu in die Liste eingezogenen BullSequana-XH2000-Systeme in Bolognia sind solche Gemeinschaftssysteme im Rahmen des European Centre for Medium-Range Weather Forecasts (ECMWF), dessen Hauptquartier in Reading/ Großbritannien liegt und das auch Bonn ansässig ist.

10 Prozent Neue

Von den insgesamt 50 neuen Systemen auf der 62. Top500-Liste stehen 19 in den USA und ebenfalls 19 in Europa (jeweils vier in Deutschland und Italien), zehn in Asien und jeweils eins in Südamerika und Australien.

Bei den Prozessoren der Neusysteme führt diesmal wieder Intel ganz knapp mit 23 (davon 20 mit Sapphire Rapids) zu 22 gegenüber AMD verteilt auf Zen-2/3/4.

Hinzu kommen drei NEC-Vektormaschinen (zwei davon beim Deutschen Wetterdienst) und zwei A64FX-Systeme für taiwanische Meteorologen.

Insgesamt über alle Systeme in der Liste (inklusive wahrscheinlich gar nicht mehr laufende Systeme, etwa mit Xeon Phi) führt Intel aber nur noch mit 68 Prozentpunkten gegenüber 28 von AMD.

186 der 500 Supercomputer sind derweil mit Beschleunigern bestückt, nur einer mehr als in der vorigen Liste. Davon sind 166 Nvidia-GPUs, 11 AMD Instinct und vier Intel Data Center MAX.

Nvidia hat zu Beginn der SC23 auch bereits die neue H200 Tensor Core GPU vorgestellt, die etwa doppelt so schnell wie die aktuelle H100 sein soll, sowie die für KI optimierte GH200, die das für 2024 geplante Exascale-System Jupiter in Jülich mit 93 EFlops KI-Leistung beglücken soll.

Die Gesamtleistung der Liste ist mit rund 7 EFlops gegenüber der alten Liste um 34 Prozent angestiegen, weit mehr als bei letzten Mal (7,7 Prozent) [6], und liegt damit wieder in den in früheren Zeiten gewohnten Bereichen. Um überhaupt ein System platzieren zu können, muss es aktuell im Linpack mindestens 2,015 PFlops erzielen.

Exkurs: Chinesischer OceanLight mit 40 Millionen Kernen

Der ShenWei-SW26010-Prozessors des früheren Top500-Spitzenreiters TaihuLight [7] ist eine Art überdimensionaler Cell-Prozessor [8], wie ihn IBM, Toshiba und Sony mal gemeinsam entwickelt hatten, sei es für die Playstation 3 oder als "PowerXCell" für Supercomputer [9]. Der PowerXCell 8i des RoadRunner hatte acht solcher "Satelliten" am Zentralgestirn PowerPC.

Der SW26010 vereint gleich vier Zentralprozessoren, die einem DEC-Alpha ähneln sollen, mit jeweils 64 Rechenknechten. Sein Nachfolger SW26010pro hat 6 Zentralprozessoren mit jeweils 64 Satelliten, kommt damit also auf insgesamt 390 Kerne. Die Rechenknechte sind zudem leistungsfähiger geworden, denn die Vektoreinheit wurde von 256 auf 512 Bit erweitert.

Chinesische Wissenschaftler sprechen auf der Konferenz SC23 nun von 39 Millionen beziehungsweise mehr als 40 Millionen Kernen ihres "neuen Sunway-Systems", das unter OceanLight kursiert, gut viermal so viel wie beim Taihulight. Das gäbe schon mal mit der Vektorerweiterung einen Faktor acht, hinzu kommen schnellere Speicher, schnelles Interconnect.

Die Wissenschaftler geben zwar keinen Wert für den Linpack (HPL) an, aber einen für die Mixed-Precision-Version (HPL MxP) von über 5 EFlops. Die bisher veröffentlichten HPL-MXP-Werte weisen einen Speedup von Faktor 4,5 (Fugaku) bis etwa 10 auf. Die Architektur des SW26010pro dürfte eher einen Faktor wie beim Fugaku nahelegen, was einen HPL-Wert von rund 1 Exaflops ergäbe.

| Top10 der 62. Top500-Liste | |||||||

| Platz (zuvor) | System (Hersteller) | Einrichtung | Land |

Linpack Rmax (PFlops) |

Energie-Effizienz (GFlops/W) |

HPCG (TFlops) |

CPU / GPU |

| 1 (1) | Frontier (HPE) | Oak Ridge National Lab | USA | 1102 | 52,6 | 14054 | AMD / AMD |

| 2 (-) | Aurora (HPE/Cray) | Argonne National Lab | USA | 585 | 23,7 | – | Intel / Intel |

| 3 (-) | Eagle | Microsoft Azure | USA | 561 | – | – | Intel / Nvidia |

| 4 (2) | Fugaku (Fujitsu) | Riken | Japan | 442 | 14,8 | 16004 | Fujitsu / – |

| 5 (3, upgrade) | Lumi (HPE/Cray) | EuroHPC/CSC |

Finnland + LUMI-Länder |

380 | 53,4 | 4586 | AMD / AMD |

| 6 (-) | Leonardo | EuroHPC/Cineca |

Italien + EuroHPC JU |

289 | 32,2 | 3114 | Intel / Nvidia |

| 7 (4) | Summit (IBM) | Oak Ridge National Lab | USA | 149 | 14,7 | 2926 | IBM / Nvidia |

| 8 (-) | MareNostrum 5 ACC | EuroHPC/BSC |

Spanien + EuroHPC JU |

139 | 54 | – | Intel / Nvidia |

| 9 (-) | EOS DGX Superpod | Nvidia | USA | 121 | – | – | Intel / Nvidia |

| 10 (5) | Sierra (IBM) | Lawrence Livermore National Lab | USA | 94,6 | 12,7 | 1796 | IBM / Nvidia |

(ciw [11])

URL dieses Artikels:

https://www.heise.de/-9447205

Links in diesem Artikel:

[1] https://www.heise.de/news/Die-Exascale-Aera-ist-eingelaeutet-Die-59-Top500-Liste-der-Supercomputer-7125454.html

[2] https://www.heise.de/news/ISC23-Details-zum-Intel-Supercomputer-Aurora-Falcon-Shores-endgueltig-erst-2025-9062335.html

[3] https://www.heise.de/hintergrund/Sapphire-Rapids-Intels-Xeon-CPUs-fuer-Server-und-Rechenzentren-angekuendigt-7452659.html

[4] https://www.heise.de/bilderstrecke/bilderstrecke_9451123.html?back=9447205;back=9447205

[5] https://www.heise.de/bilderstrecke/bilderstrecke_9451123.html?back=9447205;back=9447205

[6] https://www.heise.de/news/Top500-Liste-Supercomputer-in-der-Flaute-9061381.html

[7] https://www.heise.de/news/Supercomputer-China-ueberholt-die-USA-3241342.html

[8] https://www.heise.de/news/ISSCC-IBM-und-Sony-praesentieren-Cell-Prozessor-132971.html

[9] https://www.heise.de/news/IBMs-PowerXCell-8i-mit-DDR2-und-ueber-100-GFlop-s-Rechenleistung-199182.html

[10] https://www.heise.de/ct/

[11] mailto:ciw@ct.de

Copyright © 2023 Heise Medien