GTC 2016: Nvidia enthüllt Monster-Chip Pascal mit 16 GByte HBM2 und bis zu 3840 Kernen

15 Milliarden Transistoren, 16 GByte HBM2-Speicher, fast 4000 Shader-Rechenkerne: Nvidia enthüllt die Grafikgeneration Pascal. Sie eignet sich zur Beschleunigung von VR, künstlicher Intelligenz, Deep Learning und 3D-Grafik.

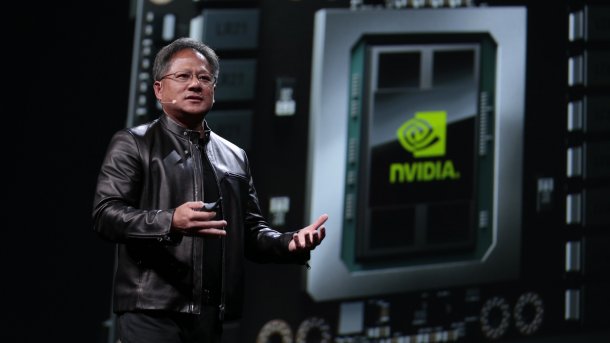

Nvidia hat auf der GPU Technology Conference die neue Grafikarchitektur "Pascal" vorgestellt. Pascal-Chips laufen unter der Bezeichnung "GP100" und sollen sich dank ihrer hohen Rechenleistung und Effizienz besonders gut fürs High Performance Computing und Deep Learning eignen. Nvidia-Chef Huang stellte mit dem Tesla P100 den ersten Rechenbeschleuniger mit GP100-Chip vor. Pascal soll mittelfristig Kepler- und Maxwell-Grafikchips im Profi-Bereich ablösen. Spieler-Grafikkarten mit Pascal-GPUs werden ebenfalls noch in diesem Jahr erwartet; wahrscheinlich kommen schon innerhalb der kommenden sechs Wochen Details zu den GeForce-Grafikkarten ans Licht. Laut Huang sollen zwischen 2 und 3 Milliarden US-Dollar an Forschungs- und Entwicklungskosten in Pascal geflossen sein.

Das volle Programm

Nvidia fertigt die GP100-GPU bei TSMC im 16-nm-FinFET-Verfahren, welches im Vergleich zur bisherigen 28-nm-Technik für eine wesentlich höhere Energieeffizienz sorgt. Beim Speicher setzt Nvidia – zumindest beim Tesla P100 – auf HBM 2 (High Bandwidth Memory 2). Im Vergleich zu HBM 1, den derzeit nur AMD bei Grafikkarten mit Fiji-GPUs verwendet, ermöglicht HBM 2 höhere Transferraten und mehr Speicher pro GPU.

GP100 sitzt wie AMDs Fiji-Pendant auf einem Interposer (oder auch "Carrier") und ist über insgesamt 4096 Datenleitungen mit dem 16 GByte großen und ECC-geschützten HBM-2-Speicher verbunden. Die vier Speicherstapel befinden sich sehr nah an der GPU, um Signalwege zu reduzieren und folglich die Transferrate zu maximieren. Sie liegt beim Tesla P100 bei 720 GByte pro Sekunde.

Über 15 Milliarden Transistoren

Die GP100-GPU besteht aus 15,1 Milliarden Transistoren. Zählt man die HBM-Speicherchips und sonstige Einheiten auf dem Interposer mit, landet man laut Nvidia-Chef Huang bei rund 150 Milliarden Transistoren. Zum Vergleich: Die Maxwell-GPU GM200 besteht aus 8 Milliarden Transistoren, Keplers GK100 aus 7,1 Milliarden Transistoren.

Pascal besteht also aus fast doppelt so vielen Transistoren, die Nvidia aber dank der 16-nm-FinFET-Fertigung auf einer ähnlich großen Die-Fläche unterbringen kann (610 statt 601 mm²). Zwar steigt die Effizienz, unter dem Strich schluckt Pascal aber trotzdem mehr als Maxwell, nämlich 300 statt 250 Watt.

Shader en Masse

Nvidia packt 3584 Shader-Rechenkerne und 224 Textureinheiten in die GP100-GPU des Tesla P100, die in insgeamt 56 Streaming-Multiprozessoren stecken. Theoretisch erlaubt die Pascal-Architektur bis zu 60 Streaming-Multiprozessoren pro Chip, also 3840 Kerne. Möglich, dass Nvidia Pascal-Prozessoren im Vollausbau auf künftigen Titan-Spielerkarten einsetzt und sich das besonders gut bezahlen lässt.

Tesla GP100 läuft mit 1328 MHz, der Turbo-Modus treibt den Takt auf bis zu 1480 Mhz und die theoretische Rechenleistung auf 10,6 Billionen Operationen pro Sekunde (10,6 TFlops) bei einfacher Genauigkeit (Single Precision/SP). Bei doppeltgenauen Berechnungen (Double Precision/DP, FP64) schafft Pascal immerhin noch die Hälfte (5,3 TFlops) und ist damit wesentlich leistungsfähiger als Maxwell (1/32tel der SP-Leistung). Bei sogenannten "Half-Precision"-Berechnungen (FP16), die etwa bei Texturoperationen genutzt werden und sich auch fürs Deep Learning eignen, erreicht Pascal bis zu 21,2 TFlops.

NVLink mit 160 GByte/s, CUDA 8 im Juni

Ausgebaut hat Nvidia außerdem die Größe der Register (14 statt 6 MByte, 80 TByte/s) und des L2-Caches (4 statt 3 MByte). Pro Streaming-Multiprozessor können 2048 Threads aktiv sein, also 64 Warps (Maxwell: 32). Atomare Speicheroperationen führt Pascal über die FP64-"atomicAdd()"-Funktion schneller durch. NVLink kommt als Interconnect zum Systemspeicher oder zwischen mehreren GPUs zum Einsatz und transferiert Daten mit bis zu 80 GByte/s pro Richtung (PCIe: 16 GByte/s), aggregiert in beide Richtungen also 160 GByte/s. Auch beim CUDA-Unified-Memory gibts Verbesserungen mit GP100, der nun in Hardware 49-Bit-Adressierung und Page Faulting unterstützt. CUDA 8.0 soll Pascal unterstützen und ab Juni verfügbar sein. Es gehört nun zum Nvidia-Paket ComputeWorks, welches wiederum ein Teil des neuen Nvidia-SDKs ist. Zu letzterem gehören außerdem die Pakete Gameworks, VRWorks, DesignWorks, DriveWorks und Jetpack.

Laut Jen-Hsun Huang befinde sich GP100 bereits in der Massenproduktion. Erste Tesla GP100 sollen "bald" an Forschungseinrichtungen und Cloud-Anbieter ausgeliefert werden, aber erst im ersten Quartal 2017 für OEM-Hersteller verfügbar sein.

Huang kündigte außerdem die besonders leistungsfähige "Workstation" DGX-1 an, die acht Tesla P100 enthält und für Deep-Learning-Berechnungen gedacht ist. DGX-1 leistet 170 TFlops bei Half-Precision und kostet 129.000 US-Dollar.

| Tesla-Karte | Tesla K40 | Tesla M40 | Tesla P100 |

| GPU | GK110 (Kepler) | GM200 (Maxwell) | GP100 (Pascal) |

| SMs | 15 | 24 | 56 |

| TPCs | 15 | 24 | 28 |

| FP32 CUDA Cores / SM | 192 | 128 | 64 |

| FP32 CUDA Cores / GPU | 2880 | 3072 | 3584 |

| FP64 CUDA Cores / SM | 64 | 4 | 32 |

| FP64 CUDA Cores / GPU | 960 | 96 | 1792 |

| Basistakt | 745 MHz | 948 MHz | 1328 MHz |

| Turbotakt | 810/875 MHz | 1114 MHz | 1480 MHz |

| FP64 GFLOPs | 1680 | 213 | 5304 |

| Textureinheiten | 240 | 192 | 224 |

| Speicherinterface | 384 Bit GDDR5 | 384 Bit GDDR5 | 4096 Bit HBM2 |

| Speichergröße | bis zu 12 GByte | bis zu 24 GByte | 16 GByte |

| L2 Cache | 1536 KByte | 3072 KByte | 4096 KByte |

| Registergröße / SM | 256 KByte | 256 KByte | 256 KByte |

| Registergröße / GPU | 3840 KByte | 6144 KByte | 14336 KByte |

| TDP | 235 Watt | 250 Watt | 300 Watt |

| Transistoren | 7.1 Mrd. | 8 Mrd. | 15.3 Mrd. |

| GPU Die Size | 551 mm² | 601 mm² | 610 mm² |

| Fertigungsverfahren | 28 nm | 28 nm | 16 nm |

(mfi)