Chinesische Chips: SMIC hat nicht genügend 7-Nanometer-Kapazität für Huawei

Baidu soll bereits fortschrittliche KI-Beschleuniger von Huawei erhalten haben. Sie sind eine Alternative zu Nvidias China-Version H20.

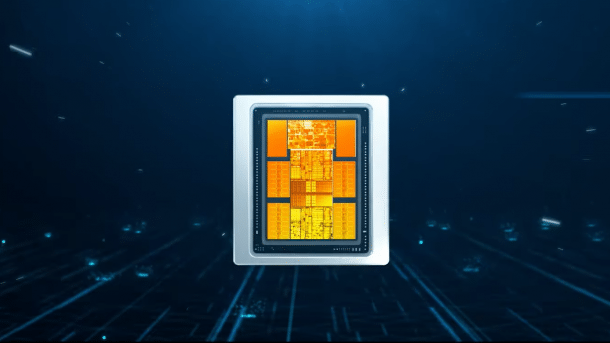

Der Ascend 910 (nicht B) aus dem Jahr 2019.

(Bild: Huawei)

Huawei hat einen neuen KI-Beschleuniger im Programm, den Ascend 910B. Der chinesische Chipauftragsfertiger SMIC produziert ihn offenbar mit 7-Nanometer-Technik. Huawei selbst hat ihn allerdings nicht offiziell vorgestellt, daher gibt es keine Details zu den Spezifikationen.

Den früheren Ascend 910 hat TSMC für Huawei gefertigt, allerdings darf der Chipauftragsfertiger aufgrund von Handelsrestriktionen nicht mehr für Huawei produzieren. Der bisherige Ascend 910 ist ein Chipletdesign, das die Logik auf zwei Chiplets aufteilt und zudem vier HBM2E-Speicherstapel verwendet. Zwei Dummy-Chiplets stabilisieren das Konstrukt.

Fraglich ist, ob der Nachfolger ebenfalls aus mehreren Siliziumbestandteilen oder aus einem monolithischen Chip besteht. SMIC selbst kann Multi-Chiplet-Prozessoren nicht zusammensetzen, laut Webseite aber der Partner JCET für sogenanntes Advanced Packaging.

Huawei muss priorisieren

Die Nachrichtenagentur Reuters berichtet derweil von Produktionsengpässen, weil SMIC offenbar nicht genügend Wafer belichten kann. Bisher hat SMIC den Smartphone-Prozessor Kirin 9000S für Huaweis Mate 60 Pro mit 7-nm-Technik hergestellt. Angeblich haben sich die Partner entschieden, die Smartphone-Produktion zugunsten der KI-Beschleuniger zu reduzieren. Die Stückzahlen sind allerdings nicht bekannt.

Der Weltmarktführer für KI-Beschleuniger ist Nvidia mit seiner H100. AMD versucht jetzt, mit der MI300X und MI300A aufzuschließen. Um mit diesen Produkten aus Geschwindigkeitsperspektive konkurrieren zu können, muss Huawei den Ascend 910B verglichen mit dem bisherigen 910 erheblich beschleunigt haben. Letzterer schafft 256 Billionen Rechenoperationen mit 16-bittigen Gleitkommawerten pro Sekunde (256 FP16-Teraflops) und 512 INT8-TeraOPS mit achtbittigen Ganzzahlen.

Nominell sind Nvidias H100- und AMDs MI300X-Beschleuniger erheblich schneller. Nvidia etwa gibt knapp einen FP16-Petaflops (1000 Teraflops) an, wenn die Tensor-Kerne zum Einsatz kommen. Mit einem Rechentrick, der die Nullen in den Matrizen weglässt, verdoppelt sich die Rechenleistung theoretisch. AMD nennt 1,3 FP16-Petaflops für seine MI300X. Insbesondere bei KI-Beschleunigern sind die Zahlen aber nur bedingt miteinander vergleichbar. Huaweis Ascend 910B soll schnell genug sein, um unter anderem Baidus Interesse geweckt zu haben.

AMD und Nvidia dürfen ihre KI-Topmodelle wegen der Exporteinschränkungen nicht nach China verkaufen. Nvidia soll deswegen eine erneut verlangsamte Version als H20 aufgelegt haben, die etwa halb so schnell ist wie die H100. Vorher kamen bereits die A800 und H800 mit gedrosselten Interconnects, um die US-Sanktionen zu umgehen. Die USA haben daraufhin neue Regeln aufgestellt.

(mma)