Kunst-Ausstellung aus der Ferne: Neuer Roboter überträgt Erlebnis an Operator

Forscher haben ihren Roboter so weiterentwickelt, dass er als Avatar dient und die physische Realität aus der Ferne erleben lässt – wenn auch noch begrenzt.

Die Steuerungs-Einheit im Kopf des Roboters wird von einem Intel Core i7 angetrieben, der mit 1,8 GHz getaktet ist.

(Bild: Screenshot / Istituto Italiano di Tecnologia (IIT))

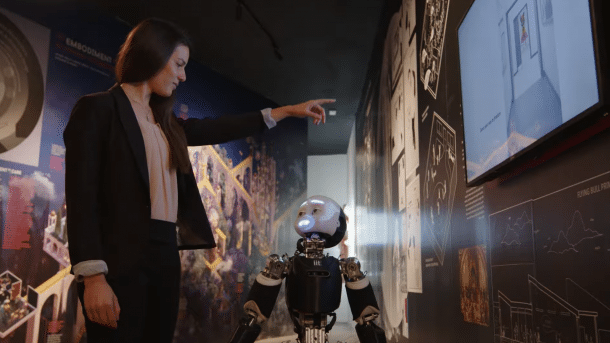

Ein italienisches Forschungsteam hat die neueste Generation des humanoiden Roboters iCub mit Sensoren, Force-Feedback-Systemen und einem AR-Interface verbunden, sodass der Roboter als physischer Avatar in entfernten Umgebungen dienen kann. Mit dem System, das Stefano Dafarra und seine Kollegen in der aktuellen Ausgabe von "Science Robotics" vorstellen, ließen sie einen User unter anderem die Biennale in Venedig besuchen, Texturen ertasten und Gegenstände manipulieren.

Der iCub3 genannte Roboter ist die jüngste Generation einer Entwicklungslinie von humanoiden Robotern des Istituto Italiano di Tecnologia (IIT), die sich ursprünglich recht stark an der menschlichen Anatomie orientieren sollten – künstliche Sehnen und Muskeln sollten für weichere Bewegungen sorgen und so die unmittelbare Zusammenarbeit mit Menschen erleichtern. Hard- und Software sind Open Source.

Videos by heise

Humanoider Roboter: 125 Zentimeter groß und 54 Freiheitsgrade

Im Laufe der Zeit wurde das Design mehrfach angepasst, die Hände verfügen allerdings immer noch über Sehnen-Antriebe, mit denen der Daumen, der Zeige- und der Mittelfinger separat und der Mittel- und Ringfinger gemeinsam bewegt werden können. iCub3 ist 125 Zentimeter groß, wiegt 52 Kilogramm und verfügt insgesamt über 54 Freiheitsgrade. Die Steuerungs-Einheit im Kopf wird von einem Intel Core i7 angetrieben, der mit 1,8 GHz getastet ist. Das System läuft unter Ubuntu-Linux und kommuniziert mit den im Roboter verteilten Sensoren und Controllern.

(Bild: Stefano Dafarra)

Das Avatar-System besteht sowohl aus Eigenentwicklungen als auch aus Consumer-Hardware: Der User steckt in einem Ganzkörperanzug und trägt ein kommerzielles VR-Headset. Der Anzug ist mit iFeel-Sensoren bestückt, die Position und Beschleunigung der Extremitäten an den Roboter melden. iFeel-Aktoren sorgen auch für haptisches Feedback, genau wie die Spezial-Handschuhe und die Schuhe. Ursprünglich bewegten sich die User auf einer Virtualizer-Plattform von Cyberith, einer Art VR-Laufstall, der Laufen auf der Stelle in Bewegungen im virtuellen Raum übersetzt. Weil das System keine seitliche Bewegung unterstützt, verwendeten die Forscher später jedoch das System iFeel Walking.

Empfohlener redaktioneller Inhalt

Mit Ihrer Zustimmung wird hier ein externes YouTube-Video (Google Ireland Limited) geladen.

Ich bin damit einverstanden, dass mir externe Inhalte angezeigt werden. Damit können personenbezogene Daten an Drittplattformen (Google Ireland Limited) übermittelt werden. Mehr dazu in unserer Datenschutzerklärung.

Die in dem Paper beschriebenen Demo-Anwendungen zeigen das Potenzial der Technologie. Allerdings sind die Fähigkeiten des Roboters noch recht beschränkt. So können die Finger beispielsweise nur sehr geringe Kräfte ausüben. Auch das Feedback auf den Operator ist begrenzt, und teilweise noch recht indirekt: Muss der Roboter beispielsweise mit den Armen ein Gewicht heben, wird die Belastung über die Stärke von Vibrationen an den User gemeldet. Langfristig wollen die Robotiker humanoide Roboter-Avatarsysteme entwickeln, die es den Bedienern beispielsweise ermöglicht, Katastrophenhilfe zu leisten und sich selbst dabei weniger Gefahren auszusetzen, oder entlegene und schwer zugängliche Orte in der physischen Welt zu erleben.

(wst)