Lächeln mit 26 Stellmotoren: Roboter erkennt Mimik und reagiert darauf

Forscher haben einem humanoiden Roboter beigebracht, das Lächeln seiner Gesprächspartner zu antizipieren. Das soll ihn vertrauenswürdiger machen.

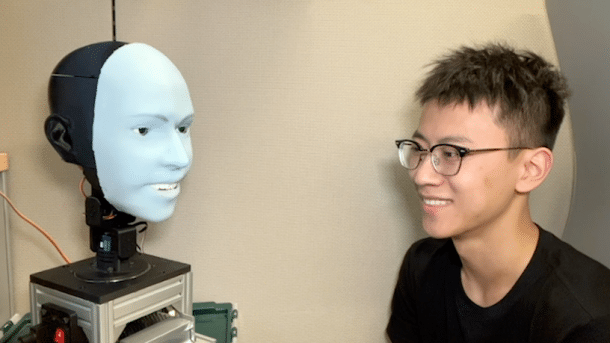

Yuhang Hu (rechts) ist Forscher am Creative Machines Lab der Comlumbia University und Hauptautor der Studie über den lächelnden Roboter Emo.

(Bild: Creative Machines Lab)

- Eike Kühl

Wenn wir mit anderen Menschen Angesicht zu Angesicht kommunizieren, dann geschieht das, teils absichtlich, teils unbewusst, stets mit mehr als nur Sprache: Mit Körperhaltung, Mimik, Blickkontakt und Gesten signalisieren wir unserem Gegenüber, dass wir ihm oder ihr zuhören und welche Emotionen das Gespräch bei uns auslöst. In dieser Hinsicht haben wir Menschen Robotern einiges voraus. Denn obwohl humanoide Roboter immer menschlicher aussehen und sprechen können, sind Interaktionen mit ihnen immer noch ungelenk, da ihnen die Mittel der nonverbalen Kommunikation fehlen.

Videos by heise

Forscherinnen und Forscher der Columbia University in New York wollen das ändern. "Physische humanoide Roboter haben Schwierigkeiten, mit Mimik zu kommunizieren", heißt es zu Beginn ihrer Studie, die vor kurzem im Fachmagazin "Science Robotics" erschienen ist. Das habe zwei Gründe: Erstens sei es nicht einfach, menschliche Gesichtsbewegungen mechanisch umzusetzen – unser Gesicht hat schließlich mehr als 40 Muskeln, mit denen Tausende von Bewegungen möglich sind. Und zweitens müsse eine natürlich wirkende nonverbale Reaktion zum richtigen Zeitpunkt geschehen, idealerweise antizipierend und nicht mit Verzögerung, wie es bei Robotern häufig der Fall ist.

Das Team um den Robotiker Hod Lipson konzentriert sich in seiner Studie auf einen bestimmten Fall der nonverbalen Kommunikation, nämlich auf die "soziale Synchronie". Wenn ein Gesprächspartner beispielsweise lacht oder lächelt, spiegeln wir die Emotion häufig unbewusst zurück, indem wir ebenfalls lächeln. Die Forschenden haben nun versucht, einem humanoiden Roboter namens Emo genau diese Fähigkeit beizubringen: Emo soll antizipieren, wann wir in einer Unterhaltung lachen werden und freundlich zurücklächeln wie es ein Mensch in einer entspannten Unterhaltung tun würde.

Empfohlener redaktioneller Inhalt

Mit Ihrer Zustimmung wird hier ein externes YouTube-Video (Google Ireland Limited) geladen.

Ich bin damit einverstanden, dass mir externe Inhalte angezeigt werden. Damit können personenbezogene Daten an Drittplattformen (Google Ireland Limited) übermittelt werden. Mehr dazu in unserer Datenschutzerklärung.

Emotionserkennung mit zwei KI-Modellen

Das Gesicht von Emo besteht aus flexiblem Silikon, das mithilfe von Magneten mit 26 unabhängig voneinander arbeitenden Stellmotoren verbunden ist. Dadurch sind deutlich mehr Gesichtsbewegungen möglich als bei vielen bestehenden humanoiden Robotern. "Wir versuchen, die komplexe Bewegung menschlicher Lippen durch eine mechanische Struktur nachzubilden", heißt es in der Studie. Durch passive Gelenke und Verbindungen verformt sich das gesamte Gesicht von Emo seinen Mundbewegungen entsprechend und wirkt dadurch mutmaßlich menschlicher.

Um Emotionen zu erkennen und bei Bedarf zu spiegeln, setzt das Team auf eine Kombination aus Kameras und künstlicher Intelligenz. Die hochauflösenden Kameras in den Augen des Roboters verfolgen die Mimik seines Gegenübers. Sie können selbst kleinste Bewegungen erkennen und somit ein Lächeln bereits in seiner Anfangsstufe antizipieren, etwa wenn sich die Mundwinkel nach oben bewegen. Bei Menschen dauert es etwa 850 Millisekunden, um einen Gesichtsausdruck zu machen. In etwa der gleichen Zeit soll es Emo gelingen, die Mimik aufzunehmen, zu analysieren und die Motoren in seinem Gesicht zu bewegen.

Zwei KI-Modelle kommen zum Einsatz. Zum einen wurde Emo quasi mit sich selbst trainiert: Indem der Roboter sich dabei aufnahm, wie er verschiedene Gesichtsausdrücke machte, lernte er, welche Motoren er für welche Ausdrücke aktivieren musste. Ein zweites Modell wurde parallel dazu mit Aufnahmen von menschlichen Gesichtern trainiert. Dadurch lernte Emo, Lachen zu antizipieren. Schon innerhalb weniger Stunden war der Roboter in der Lage, auch kleinste Gesichtsbewegungen zu interpretieren und darauf zu reagieren.

Auch ein menschlicher Roboter wirkt ziemlich künstlich

Mit Emo wollen die Forscherinnen und Forscher aus New York die Kommunikation zwischen Menschen und Robotern natürlicher erscheinen lassen. Vor allem in sozialen Kontexten, etwa bei Robotern in der Pflege, ist es wichtig, dass die Menschen den Robotern vertrauen. Eine natürlich wirkende Mimik im Sinne der nonverbalen Kommunikation könne dabei helfen, schreiben die Forschenden. Da ihr Roboter nicht nur reagiert, sondern antizipiert, gehen die Forschung über frühere "KI-Lachsysteme" hinaus.

Gleichzeitig wissen die Verantwortlichen, dass ein Roboter wie Emo aller Fähigkeiten zum Trotz immer noch unnatürlich oder gar unheimlich wirken könnte – Stichwort Uncanny Valley. "Wir sind uns bewusst, dass der Maßstab für den Erfolg letztlich ist, wie diese Ausdrücke von menschlichen Benutzern wahrgenommen werden", heißt es im Fazit der Studie. Schaut man sie die Demo-Videos an, dann wirkt auch ein vermeintlich menschlicher Roboter wie Emo ziemlich künstlich.

(jle)