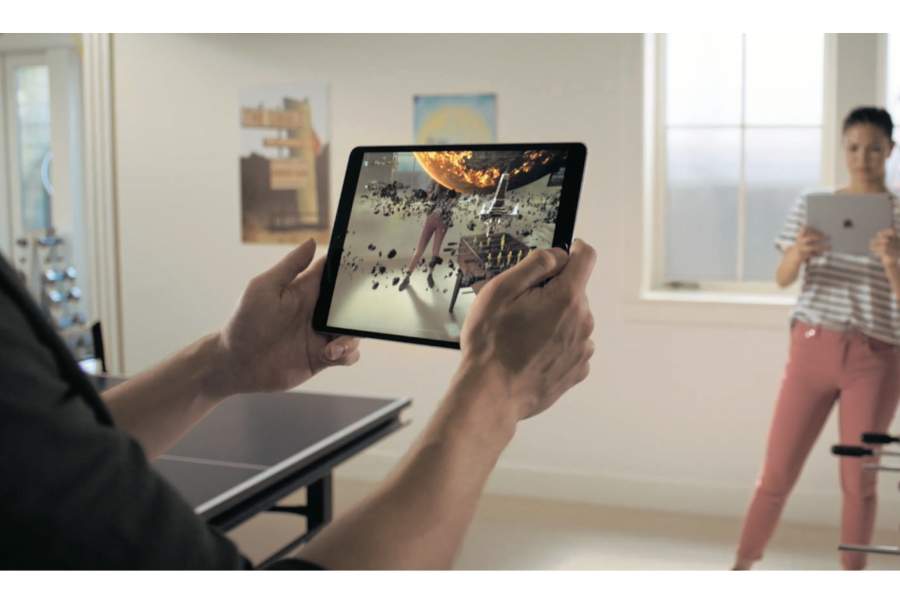

Augmented Reality reloaded

Die Neuerungen von ARKit 2 in iOS 12

Apple hat im Augmented-Reality-Framework von iOS 12 viele Neuerungen hinzugefügt. ARKit 2 kann nun etwa die Umgebung speichern, um diese mit anderen zu teilen – ideal für spannende Multiplayer-Spiele. Es scannt und erkennt reale Objekte. Und virtuelle Objekte können die reale Umgebung reflektieren. Am Beispiel einer SceneKit-App zeigen wir die Highlights im Praxiseinsatz.

Apples Augmented-Reality-Framework (ARKit) ermöglicht seit 2017 die Echtzeit-Darstellung virtueller Objekte in der realen Umgebung anhand der Kamera- und Sensordaten. Die zentrale Komponente aus programmiertechnischer Sicht ist hierbei die Klasse ARSession, welche mithilfe der Kamera und von Bewegungssensoren die reale Umgebung automatisch analysiert und die Position und Ausrichtung des iOS-Gerätes bestimmt. Hierbei kann ARKit Flächen, Bilder, Objekte und Gesichter erkennen.

Basierend auf dieser Analyse erzeugt ARKit ein 3D-Koordinatensystem und fügt sogenannte ARAnchor-Objekte zur Session hinzu. Diese Anker beschreiben das erkannte Objekt und lassen sich mit Knoten einer virtuellen 3D-Szene verknüpfen. Hierbei steuert der Anker anhand einer Transformationsmatrix die Position und Rotation des Knotens. Um ARKit vorzugeben, was es tun soll, benötigt die Session zum Starten eine Konfiguration (ARConfiguration). Eine Einleitung und tiefergehende Beschreibung der Funktionsweise von ARKit finden Sie in Mac & i Heft 01/2018, Seite 136.