Wie sage ich es meinem Auto?

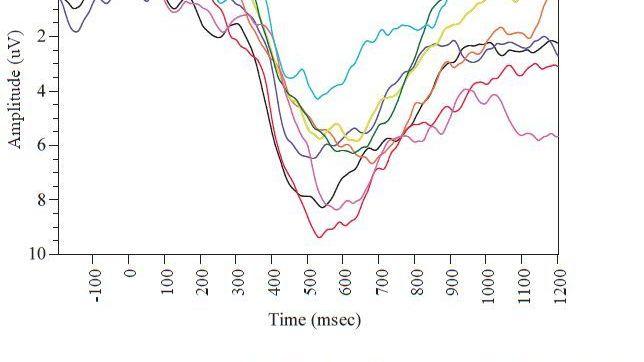

Abb. 3: Evoziertes Potential beim Bremsen in einem Simulator.

Eines der kontroversen Themen beim zukünftigen Autodesign ist die konkrete Art der angemessenen Mensch-Maschine-Kommunikation

Werden wir Autos über Knöpfe oder über sprachlichen Eingaben steuern? Ein neuer Bericht der American Automobile Association zeigt, dass Gespräche mit dem Computer dem Fahrer eine sehr hohe kognitive Last aufbürden.

In vielen Science-Fiction-Filmen reden Menschen direkt mit dem Computer, so in "2001 Odyssee in Weltraum" oder in "Her", ein Streifen, bei dem der Antiheld des Filmes sich sogar in das sprechende Betriebssystem seines Handys verliebt. In der Science-Fiction ist der Computer Butler und Chauffeur, versteht alles auf Anhieb und man braucht sich nicht lange damit zu befassen, die eigenen Wünsche computergenau zu spezifizieren.

Allerdings ist die beste Art der Mensch-Maschine-Kommunikation in der Realität immer produkt- und kontextabhängig. Wahrscheinlich ist eine TV-Fernbedienung mit Knöpfen immer noch besser als die Gestensteuerung über eine Xbox. Man kommt sich beim Wedeln in der Luft selber dumm vor, wenn stattdessen eine einfache Fingerbewegung das Zappen erlaubt. Um die Waschmaschine einzuschalten, braucht man sich mit dem Ding nicht zu unterhalten, der Griff an zwei Drehknöpfen reicht aus. Wenn mich alle Haushaltsgeräte in Gespräche verwickeln würden, wäre ich wahrscheinlich schnell psychotisch.

Google und Apple planen jedoch ihre jeweiligen Betriebssysteme langfristig in moderne Fahrzeuge zu integrieren, inklusive Spracherkennung. Man kann sich dann mit Siri oder Google Now unterhalten und rein sprachlich um Auskunft bitten, z.B. wo ich in der Nähe der Autobahn etwas Asiatisches zu essen finde. Allerdings sind diese beiden "Butler" nicht ganz neutral, da sich ihre Auskünfte nach den Anzeigegebühren für beide Plattformen ergeben. Es wird in etwa so sein, wie einen Staubsauger-Vertreter als Mitfahrer vorne zu haben.

Spracherkennung setzt sich aber langsam durch. Deswegen hat die American Automotive Association (AAA), der amerikanische ADAC, neulich Siri als Auskunfts- und Infotainmentsystem im Fahrzeug getestet.1 Es hat sich ergeben, dass Siri die Fahrer sehr ablenkt und sogar potentiell am meisten im Vergleich mit anderen Arten der Interaktion. Dies hat sicherlich damit zu tun, dass die Technologie noch nicht ganz reif ist und dass sprachliche Missverständnisse noch Wiederholungen oder Neustarts notwendig machen. Es illustriert jedoch, was oben angedeutet wurde: Man braucht nicht unbedingt zu sprechen oder mit Gesten zu steuern, wenn ein Knopf die bessere Schnittstelle sein kann.

Aber gehen wir systematisch vor. Bevor Siri getestet wurde, war das erste, was die AAA tat, eine Art Vergleich zwischen verschiedenen Situationen im Auto herzustellen und diesen einen "kognitiven Lastindex" zuzuweisen. Der Index ist höher, je mehr die Aufgabe geistige Anstrengung vom Fahrer verlangt.

Abb. 1 fasst die Ergebnisse einer Studie von 2013 zusammen.2 Es wurden acht verschiedene Situationen getestet: eine einfache Handlung im Auto ausführen (die mit dem Indexwert 1 belegt wurde), Radio hören, einem Hörbuch folgen, sich mit einem Mitfahrer zu unterhalten, Telefonieren mit dem Handy in der Hand, Telefonieren mit Freisprechanlage, einen Text für eine SMS diktieren und schließlich eine Aufgabe, die Kopfrechnen oder ähnliches erfordert (Operation Span Task - OSPAN).

Die Ablenkung der Autofahrer wurde in Simulatoren und in instrumentierten Autos gemessen. Dafür wurde z.B. beobachtet wie oft ein Licht, das im peripheren Sehbereich eingeschaltet wurde, vom Fahrer übersehen wurde. Daraus ergab sich die kognitive Last - man könnte auch sagen Ablenkung - des Fahrers (aber mehr darüber weiter unten). Vorläufig kann man in Abb. 1 sehen, dass die Unterhaltung mit einem Mitfahrer in etwa so viel ablenkt wie eine Freisprechanlage. Jedoch schaut der Mitfahrer im Auto auch mit nach dem Verkehr und kann deswegen den Fahrer vor Gefahren warnen. Ein Gesprächspartner am Telefon kann das nicht. Aber Diktate für den Computer lenken des Fahrer den Fahrer noch viel mehr ab als ein Handygespräch, während ihn Rechenaufgaben total überfordern (Index 5). Mit Menschen am Telefon zu sprechen, ist also nicht zu empfehlen, wie jeder weiß. Mit dem Computer zu sprechen, scheint aber noch bedenklicher zu sein.

In Europa sind ähnliche Studien durchgeführt worden, wobei der Grad der Ablenkung durch die Sekunden gemessen wurde, die der Fahrer nicht auf die Straße schaute. Das geschieht bei manchen Navigations- und Infotainmentsystemen, die den Bildschirm nicht im Blickbereich haben. Ein solches Gerät kann gefährlich werden, vor allem weil mittlerweile so viele unterschiedliche Informationen am Bildschirm angezeigt werden. Als Leitgröße gilt, dass der Fahrer nicht mehr als zwei Sekunden den Blick von der Straße abwenden darf.3 Allerdings zeigen die Studien der AAA, dass auch mit den Augen auf der Straße, der Kopf ganz woanders sein kann.

Messung der Kognitiven Last

Diese Ergebnisse mögen bis hierher nicht überraschend sein. Dass Gesprächspartner im Auto ablenken, weiß jeder Fahrer bzw. jede Fahrerin. Nach einer Studie ist die Wahrscheinlichkeit eines Unfalls 60% höher, wenn man einen gesprächigen Mitfahrer mitnimmt, statt alleine zu fahren. Und wenn man mehr als zwei gesprächsfreudige Mitfahrer mitnimmt, verdoppelt sich die Unfallgefahr.4

Die Frage ist, wie man, um solche Ablenkungen zu testen, solide Experimente ohne Gefahr für die Probanden ausführen kann. Hier tragen neue Studien des AAA etwas Interessantes bei, indem sie verschiedene Situationen direkt am Simulator, aber auch im Verkehr durchtesteten. Die Fahrdaten und verschiedene biologische Signale, wie Herzschlag oder EEG-Signale, wurden mitgespeichert.

Man kann nicht direkt in den Kopf des Fahrers schauen und deswegen sammelt das AAA-System dreizehn Indikatoren: sieben, die mit Sensoren gemessen werden, und sechs aus der subjektiven Beurteilung des Fahrers (angelehnt an die Metrik der NASA für Lastbeurteilung). Bei den sechs subjektiven Faktoren haben die Probanden nach Erledigung einer Aufgabe eine numerische Benotung zwischen 1 und 21 vergeben für: 1) die geistige Schwierigkeit der Aufgabe, 2) die physische Schwierigkeit, 3) den Zeitdruck, 4) wie erfolgreich die Aufgabe erfüllt wurde, 5) wie schwer es war, erfolgreich zu sein, und 6) wie unsicher, irritiert bzw. frustriert der Fahrer war.

Die sieben gemessenen Indikatoren waren die Reaktionszeit beim Bremsen (wenn bei einem vorausfahrenden Auto die Bremslichter aufleuchten), der Sicherheitsabstand zum Vorderfahrzeug, die Reaktionszeit für Lichter im peripheren Bereich (in zwei Varianten), die Latenzzeit für die Erzeugung eines evozierten Potentials im EEG, die Tiefe des Potentials und der Puls. Alle diese Zahlen wurden so normiert dass sich der Mittelwert Null und die Standardabweichung Eins ergibt (d.h. die Zahlen wurden "normalisiert"). Danach hat man sie alle zusammenaddiert. Für die Ermittlung des kognitiven Index wurde die Benotung der einfachen Aufgabe zu 1 skaliert, die Benotung der Rechenaufgaben im Kopf zu 5, alles Weitere fiel dazwischen.

Reden im Fahrzeug

Es wurden neun verschiedene Aufgaben durch 45 Probanden erledigt, einmal in einem Autosimulator und dann im Verkehr, beim Fahren eines instrumentierten Fahrzeugs. Die Probanden trugen eine Kappe für die Aufzeichnung der EEG-Signale und einen Sensor für die Messung des Herzschlags. Eine kleine LED wurde am Kopf so montiert, dass das Licht immer im peripheren Bereich war. Die Probanden sollten auf Farbwechsel der LEDs achten. Die Ergebnisse am Simulator waren sehr ähnlich wie später am Fahrzeug selbst, d.h. man kann in Zukunft solche Experimente im Labor ohne Verlust an Aussagekraft durchführen.

Die neun Aufgaben für die Probanden sind in der Abb. 2 zusammen mit dem ermittelten kognitiven Belastungen dargestellt. Es handelt sich um:

- eine einfache Handlung im Auto,

- einen sprachlichen Einzelbefehl für das Auto (z.B. Radio einschalten),

- Navigation in einem Email-System durch Sprachbefehle und Nachrichten anhören, die von einer Sprecherin vorgelesen wurden,

- wie die vorherige Aufgabe, aber mit einer synthetischen Stimme,

- wie die dritte Aufgabe, aber der Benutzer kann Nachrichten diktieren,

- wie die vierte Aufgabe, aber der Benutzer kann Nachrichten diktieren,

- sprachliche Navigation in Menüs, die sehr zuverlässig sind,

- sprachliche Navigation in Menüs, wobei gelegentlich Navigationsfehler per Zufall eingestreut wurden,

- und schließlich Interaktion mit Siri.

Für alle sprachlichen Aufgaben ohne Siri hörte ein Mensch die Eingaben vom Fahrer und verwandelte sie in perfekte Transkriptionen (so als ob die Spracherkennung perfekt wäre). Dieses sogenannte "Zauberer von Oz"-Verfahren sollte vermeiden, dass man Siri mit einer minderwertigen Spracherkennung vergleicht. Mit Siri haben die Fahrer Nachrichten verschickt und Facebook bzw. Twitter mit Meldungen gefüttert (was von echten Fahrern zu erwarten, oder besser gesagt, zu befürchten ist). Abb. 2 zeigt das Ergebnis des Experiments:

Wie man in der Abbildung sieht, erzeugt alles, was sprachliche Menü- oder Diktat-Interaktion mit dem Fahrzeug bedeutet, eine höhere kognitive Last als ein Gespräch im Auto. Nachrichten diktieren ist besonders ablenkend, aber Siri hat die kognitive Last 4 erhalten, nicht mehr sehr weit von 5, der maximalen mentalen Beanspruchung. Es ist auch klar warum: Mit Siri können komplexere Aufgaben erledigt werden (z.B. eine Aktualisierung von Facebook-Seiten) und der Fahrer ist damit mental ziemlich "woanders".

Ich hatte oben geschrieben, man kann in den Kopf des abgelenkten Fahrers nicht hineinschauen. Das trifft nicht ganz zu. Die schönste Grafik in den Studien der AAA sind die Kurven für evozierte Potentiale bei Experimenten im Simulator. Die Probanden sollten jedes Mal auf die Bremse treten, wenn das Vorderfahrzeug die Bremslichter eingeschaltet hat. Je tiefer und schneller die Kurve bis zum Minimum fällt, desto aufmerksamer ist die Person. Man sieht sofort: die flachere Kurve ist die von Siri. Die Amplitude des Potentials ist fast nur die Hälfte der Amplitude bei den einfachen Aufgaben.

Was all diese Ergebnisse zeigen sind zwei Sachen: Erstens, man kann nicht beliebig viele Funktionen in Fahrzeuge packen, die dann aufwendig durch Menüs vom Fahrer (beim Fahren) aktiviert werden. Zweitens, sprachliche Interaktion mit dem Fahrzeug lenkt Fahrer mehr ab als Handygespräche und mehr als Gespräche mit Personen im Auto selbst. Oben wurde die Statistik erwähnt: Gespräche mit mehreren Personen im Auto verdoppeln die Unfallgefahr. Gespräche mit Computern beim Fahren sind noch ein Stück gefährlicher. Vielleicht ist das Beste wenn Siri meldet: "Siri not available. Connect to the Internet."