Bilderkennungsprogramme von autonomen Fahrzeugen können ausgetrickst werden

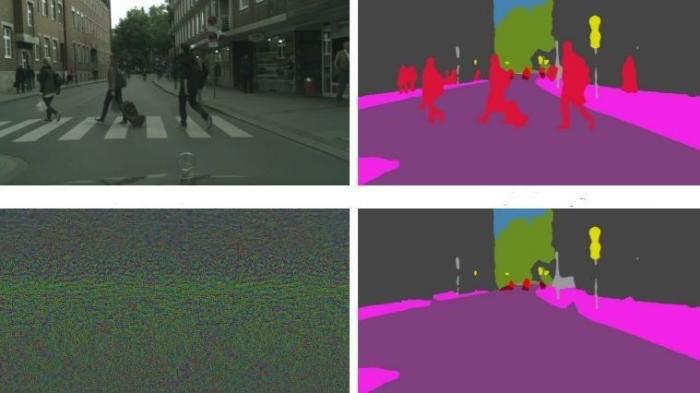

Durch universale Störungen aus dem Bild entfernte Personen. Bild: Jan Hendrik Metzen et al.

Wissenschaftler konnten hypothetisch zeigen, wie auf Kamerabildern die semantische Segmentierung ausgetrickst und etwa Personen nicht mehr erkannt werden können

Dass sich Fahrzeuge, die autonom oder teilautonom mit digitalen Fahrerassistenzsysteme fahren, weniger Unfälle verursachen werden als emotional agierende Menschen, die chronisch unaufmerksam sind, ist zum Begründungstandard für deren Einführung geworden. Allerdings haben sie auch Nachteile, sie können beispielsweise gehackt werden, schlimmstenfalls kann das Fahrzeug von außen übernommen oder die Steuerung manipuliert oder ausgehebelt werden. Zudem ist umstritten, wie KI-Systeme sich in kritischen Situationen verhalten sollen, wenn etwa Unfälle nicht vermieden werden können, sondern blitzschnell entschieden werden müsste, das kleinere Übel zu wählen, also etwa das Leben des Passagiers zu gefährden, um einen anderen Menschen auf der Straße zu verschonen, oder nur einen Menschen/Wagen anzufahren, um mehrere Menschen nicht zu verletzen.

Die KI-Systeme erkennen die Fahrsituation durch Kameras, indem sie die von diesen gelieferten Bilder bzw. Pixel analysieren. So werden bei der Bildverarbeitung durch die so genannte semantische Segmentierung beim maschinellen Lernen aus der Pixelszene durch Strukturierung erst Objekte isoliert, lokalisiert und identifiziert bzw. klassifiziert, also wo die Straße, der Mittelstreifen und der Rand der Fahrbahn verläuft, wo sich welche andere Fahrzeige bewegen oder befinden, was eine Ampel oder ein anderes Verkehrszeichen ist und ob sich andere Menschen, Fahrradfahrer, Kinder oder auch Tiere in der Nähe bewegen oder aufhalten. Es muss also eine Welt durch Aufteilung und Gruppierung der Pixel geschaffen werden, um das Fahrzeug sicher in dieser navigieren zu können.

Wissenschaftler haben nun gezeigt, wie sie in "Universal Adversarial Perturbations Against Semantic Image Segmentation" schreiben, dass die an sich zuverlässig arbeitende Bilderkennung prinzipiell von außen gestört werden könnte. Wenn visuelles Rauschen, das Menschen gar nicht wahrnehmen, dem Input auf bestimmte Weise zugefügt wird, kann die KI ausgetrickst werden bzw. nicht mehr richtig arbeiten. Es gebe sogar, so die Wissenschaftler vom neugegründeten Bosch Center for Artificial Intelligence und von der Universität Freiburg "universale Störungen" für jede Art von Bild, Szene oder Bildverarbeitungssystem, die auch vom maschinellen Sehen nicht bemerkt werden, aber die Verarbeitung täuschen. Das kann auch so weit gehen, dass durch Rauschen bestimmte Objektklassen nicht mehr semantisch segmentiert werden können. So könnte sich bewerkstelligen lassen, dass das KI-System eines Fahrzeugs oder eines anderen Roboters bei der Verarbeitung der Kamerabilder etwa Menschen "übersieht", während die übrige Segmentierung fehlerfrei verläuft, was durchaus unerfreuliche Konsequenzen für diejenigen auf der Straße haben könnte, die damit aus dem Visier rutschen.

Die Motivation für ihre Studie sei es gewesen zu zeigen, wie instabil die gegenwärtigen Ansätze für semantische Segmentierung seien, "wenn sie mit einem Gegner konfrontiert sind", der intendiert, Schäden zu verursachen. Sie verweisen auf andere Studien, die gezeigt haben, dass sich auch die Klassifizierung stören lässt. Abgesehen von autonomen Fahrzeugen ließen sich auch Überwachungskameras so manipulieren, dass die Szene stets intakt bleibt, aber jede Aktivität ausgeblendet wird, so dass man beispielsweise nicht mehr auf dem Bild erkennen könnte, dass ein Angreifer einen anderen Menschen angeht oder eine Fensterscheibe einschlägt und in einen Laden eindringt. Während die Bildverarbeitungsprogramme gegenüber Zufallsrauschen stabil sind, lasse sich die semantische Segmentierung gezielt so stören, dass weder der Input auffällig erscheint noch das Bild für den menschlichen Betrachter.

Die Wissenschaftler haben für ihr Experiment Daten und Bilder von Cityscapes verwendet, das 5000 Szenen mit Annotationen aus 50 Städten enthält. Mit dem generierten Rauschen konnten aus semantisch strukturieren Szenen die darauf befindlichen Personen so entfernt werden, dass maschinelles Bildverstehen sie nicht mehr erkennen könnte und gegenüber Menschen blind würde. Das ist natürlich für statische Bilder einfacher als für dynamische.

Allerdings müsste, wenn die Bilder so manipuliert werden sollen, ein Hacker erst eine Möglichkeit finden, in die von Kameras aufgezeichneten Bilder das Rauschen einzufügen, bevor es von einem Algorithmus semantisch segmentiert wird. Da aber schon gezeigt wurde, dass etwa Gesichtserkennungssysteme von außen durch Masken oder künstliche Gesichtsteile getäuscht werden können, müsse man die Möglichkeiten solcher Angriffe auch auf Überwachungssysteme oder beim automatischen Fahren untersuchen. Auch wenn die Manipulation von außen bislang nur hypothetisch ist, sei es gerade für sicherheitskritische Anwendungen notwendig, Maschinenlernen gegen feindliche Störungen robuster zu machen, und Wege zu finden, wie Angriffe entdeckt werden können.