Der Unfall von Uber in Arizona

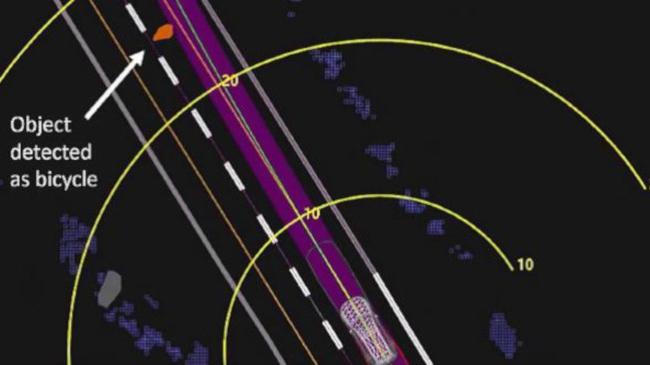

Abb. 2: Abstand in Meter zur Passantin mit Fahrrad 1,3 Sekunden vor der Kollision.

Das amerikanische National Transportation Safety Board hat den vorläufigen Bericht zum Uber-Unfall in Arizona vorgelegt: Die Software hat versagt. Gravierender war aber der Mangel an antizipativen Sicherheits- und Verantwortungsdenken

Ein autonomes Fahrzeug der Firma Uber hat eine Frau am 18. März dieses Jahres in Arizona überfahren. Über den Vorfall wurde damals ausführlich berichtet, weil es sich um die erste Person handelte, die von einem autonomen Fahrzeug überfahren wurde. Nun hat das National Transportation Safety Board einen vorläufigen Bericht über den Unfall vorgelegt, mit - wie mir scheint - belastenden Erkenntnissen über die Software von Uber.

Abb. 1 zeigt den Kontext des Unfalls. Eine Passantin hat ein Fahrrad geschoben und nachts die Straße überquert, direkt vor dem Uber-Fahrzeug. Die Stelle war nicht beleuchtet, die Passantin trug dunkle Kleidung und das Fahrrad hatte keine seitlichen Reflektoren. Laut Bericht haben die Sensoren des Fahrzeugs (Lidar und Radar) die Frau ganze 6 Sekunden vor dem Aufprall zum ersten Mal bemerkt (das wäre in 110 Meter Abstand), ohne dass es zu einer eindeutigen Klassifizierung als Passantin, Auto oder allgemeinem Hindernis kam. So unpräzise wie die Klassifizierung war die Vorhersage der erwarteten Trajektorie des "Hindernisses". Erst 1,3 Sekunden vor dem Aufprall stellte der Steuerungscomputer fest, dass eine Kollision bevorstand. Das Auto war mit 69 km/h unterwegs (Abb. 2).

Die Uber-Ingenieure haben allerdings dem eigenen System nicht vollkommen vertraut, da nach der Aussage von Uber, bei solchen Situationen (unmittelbare Kollision) einprogrammiert war, nicht zu bremsen - vermutlich, um Auffahrunfälle von nachfolgenden Autos zu verhindern. Noch schlimmer: Es wurde keine Warnung an die Sicherheitsfahrerin im Fahrzeug gegeben - weder akustisch noch haptisch.

Bei einer unvermeidlichen Unfallsituation wurde die Verantwortung also an den Sicherheitsfahrer übertragen - unter der Annahme, dass dieser immer brav hinter der Lenkung seine ungeteilte und volle Aufmerksamkeit der Straße widmen wurde. Auch nachts.

Technisches Versagen

Im Nachhinein beruhen solche Unfälle auf einer Kette von Fehlern, die von den Entwicklern immer übersehen werden. Hier liegen mindestens folgende technische Fehler vor:

- Ein erkanntes Hindernis auf einer Straße, die ansonsten fast leer ist, sollte von der Software lückenlos verfolgt werden können.

- Die erwartete Trajektorie kann in einem solchen als dem geschilderten Fall nur die von einem Verkehrsteilnehmer sein, die die Straße durchkreuzen will.

- Akustische und haptische Warnungen an den Sicherheitsfahrer sollten sofort ausgelöst werden, da nicht davon ausgegangen werden kann, dass die Person immer aufmerksam alle Verkehrssituationen verfolgt.

- Tut der Sicherheitsfahrer nichts, kann trotzdem die Vollbremsung automatisch ausgelöst werden, wenn sich zu nahe hinter dem eigenen Fahrzeug keine anderen Fahrzeuge befinden (wie das auch hier der Fall war). Bei niedrigen Geschwindigkeiten kann dies immer gemacht werden wie bei herkömmlichen Fahrassistenzsystemen, die bei Geschwindigkeiten unter 30 km/h automatisch vollbremsen.

Das ist alles gewiss eher trivial - aber dass die Uber-Ingenieure stattdessen voll auf den Sicherheitsfahrer vertraut haben, kann nur einen Grund haben: Die Kontrollsoftware hat im Straßenverkehr in Normalbetrieb zu viele Falschmeldungen ausgelöst - und der Sicherheitsfahrer sollte damit nicht behelligt werden. Um seine Aufmerksamkeit nicht zu beeinträchtigen, wurde auf jegliche Warnung verzichtet. War die Software wirklich so schlecht, hätten die Versuche im öffentlichen Raum sofort eingestellt werden sollen.

Außerdem muss bei der Entwicklung von solchen Systemen, die eine Gefahr für die Öffentlichkeit darstellen können, immer eine "Firewall" zwischen Entwickler und Tester eingerichtet werden. Entwickler hegen immer die Zuversicht, dass nichts Besonderes geschehen kann, dass die Software immer richtig ist.

Die Tester dagegen müssen wie ein advocatus diaboli auftreten, alle bewussten oder unbewussten Annahmen infrage stellen und alle möglichen Konstellationen testen. Einer der ersten zu testenden Situationen wäre gewesen: Was geschieht, wenn der Sicherheitsfahrer nicht aufpasst? Wäre das getestet worden, hätte man alles gestoppt, bis zumindest zusätzliche Sensoren im Auto auch den Sicherheitsfahrer beobachtet hätten.

Technik und Verantwortung

Bei der Betrachtung der Trajektorie des Fahrzeugs in Abb. 2, denke ich jedoch, dass Uber nicht die volle Wahrheit sagt. Man sieht nämlich, dass das Fahrzeug 15m vor der Passantin von der Mittelinie der Spur (der roten Linie) abweicht und der grünen Trajektorie folgt.

Hätten wir ein statisches Hindernis, wäre das Auto knapp an der Passantin vorbeigefahren. Es scheint also, dass die Trajektorienvorhersage von Uber mindestens eine Sekunde der Realität hinterherhinkt. Die Software hat vielleicht berechnet, dass es noch genug Abstand gäbe, um in einer Sekunde an die Frau vorbeizufahren. Bei 69 Km/h fährt das Auto 19 Meter in einer Sekunde. Das ist auch ungefähr der Abstand zu der Passantin, als das Auto die Mitte der Spur verlässt.

Mir scheint, dass sich hier das NTSB sich zu viel auf die Aussagen von Uber stützt. Eine echte unabhängige Untersuchung des Vorfalls sollte mit den Rohdaten starten und die Kontrollsoftware im Betrieb überprüfen. Bereits das von Uber gelieferte Video des Unfalls wirkt unglaubwürdig dunkel. Moderne automotive Kameras sind extrem lichtempfindlich - und der niedrige Kontrast der publizierten Videos sieht nicht so aus, wie etwas, das moderne Kameras liefern würden.

Das Grundproblem ist aber das mangelnde Rechts- und Verantwortungsbewusstsein der Firma Uber. Mit den Angehörigen des Opfers wurde schnellstens außergerichtlich verhandelt, um eine Klage abzuwenden. Wochen nach dem Unfall kann Uber immer noch nicht klipp und klar sagen, dass die Software versagt hat und warum genau. Unabhängige Experten sollten eingeschaltet werden. Daten über sicherlich vorhandene ähnliche Vorfälle der Uber-Fahrzeuge werden auch nicht verraten. Die einzige Konsequenz war, dass Uber seine Testversuche in Arizona einstellte und sich bis auf weiteres auf San Francisco und Pittsburgh konzentriert.

Vielleicht lernt Uber aus dem Vorfall nichts - aber wir Entwickler können zumindest daraus lernen, wie man etwas nicht tut.

Empfohlener redaktioneller Inhalt

Mit Ihrer Zustimmmung wird hier eine externe Buchempfehlung (Amazon Affiliates) geladen.

Ich bin damit einverstanden, dass mir externe Inhalte angezeigt werden. Damit können personenbezogene Daten an Drittplattformen (Amazon Affiliates) übermittelt werden. Mehr dazu in unserer Datenschutzerklärung.