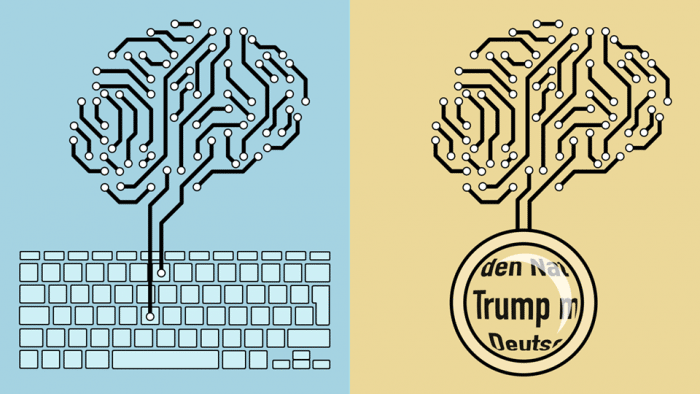

Kann KI mit KI generierte Texte erkennen?

OpenAI hat einen Algorithmus zur Textgenerierung angeblich nicht vollständig veröffentlicht, weil er so gut sei und Missbrauch und Täuschung ermöglicht

Das u.a. von Elon Musk und Peter Thiel gegründete KI-Unternehmen OpenAI hatte im Februar erklärt, man habe den angeblich am weitesten fortgeschrittenen Algorithmus zur Sprachverarbeitung entwickelt. Der Algorithmus wurde lediglich anhand von 40 Gigabyte an Texten oder an 8 Millionen Webseiten trainiert, das nächste Wort in einem vorgegebenen Textausschnitt vorherzusagen. Damit könne man zusammenhängende, sinnvolle Texte erzeugen, die vielen Anforderungen genügen, zudem könne damit rudimentär Leseverständnis, Antworten auf Fragen, Zusammenfassungen und Übersetzungen erzeugt werden, ohne dies trainiert zu haben.

Verfolgt wurde bereits bei dem Vorläufer GPT unüberwachtes Lernen anhand von Big Data, um das KI-Programm anschließend kontrolliert zu optimieren. Das soll beim Nachfolger GPT-2 so gut gelungen sein, dass die Wissenschaftler das trainierte Programm nicht veröffentlichen wollen, um bösartige Anwendungen zu verhindern. Man hat deswegen nur, wie die Autoren schrieben, ein abgespecktes Programm und ein technisches Paper veröffentlicht. Wenn es sich um sehr technische oder esoterische Inhalte handelt, komme das KI-Programm damit schlecht zurecht, ansonsten erzeugt es zumindest in 50 Prozent der Fälle sinnvollen Text über eine Seite lang.

Angeblich könne GPT-2 dafür verwendet werden, automatisch Fake News-Artikel, Beleidigungen oder andere unerwünschte Dinge zu schreiben, weswegen man es nicht in fremde Hände geben wolle. Ob das ethisch gedacht und sinnvoll ist, ist eine andere Frage. Man darf davon ausgehen, dass irgendwo auf der Welt demnächst bessere Sprachprogramme entwickelt werden, die so gut sind, dass sie jeden Turingtest bestehen und Menschen in die Irre führen können. Dazu braucht es auch gar nicht so viel, rudimentäre Sätze, auch mit Fehlern, können Menschen überzeugen oder "infizieren", wenn die Inhalte zur Erwartung passen.

Open AI ermöglichte Wired, das Programm zu nutzen. Bei der Eingabe von lediglich "Hillary Clinton and George Soros" begann die Imagination des KI-Programms zu arbeiten und ergänzte das Schnipsel mit einem Text, den Gegner oder Verschwörungstheoretiker durchaus hätten schreiben bzw. erfinden können:

...are a perfect match, and their agenda appears to be to create a political movement where Soros and his political machine and Clinton are two of the only major players. This is the first time Soros and Clinton have been caught on tape directly colluding in promoting the same false narrative. One of the key revelations in the leaked audio was Clinton's admission to a Russian banker that she knew about the Uranium One deal before it was approved by Congress. Clinton was shown sharing the same talking points that were originally drafted by a Fusion GPS contractor hired by an anti-Trump Republican donor. The leaked audio is the clearest evidence yet that the Clinton campaign and the Hillary Foundation colluded with Fusion GPS to manufacture propaganda against President Trump.

KI-Wettrüsten

Das liest sich tatsächlich wie etwas, was von einem Menschen als Bericht geschrieben worden sein könnte, obgleich die Verschwörungs-Versatzstücke schon sehr deutlich werden und der Gedankengang wirr erscheint. Die Sorge soll darin bestehen, dass mit der Billigproduktion von smarten Schreibautomaten menschliche Trolle und Fake-News-Autoren durch KI-Programme ersetzt werden könnten, um Menschen zu beeinflussen.

Dabei dürfte es eigentlich egal sein, ob hinter Texten Menschen oder KI-Programme stecken, man denkt wohl, die Masse macht es. Es lässt sich allerdings vermuten, dass dann, wenn Automated-Content-Programme Soziale Netzwerke oder andere Bereiche des Internet fluten, das Interesse daran zurückgehen wird. Schon jetzt werden überdies bestimmte Textformen akzeptiert, wenn sie nicht von Menschen geschrieben werden. Für einen Wetterbericht braucht es keinen Wettermoderator, für viele andere Nachrichten auch nicht.

Überdies könnte sich im speziellen Fall auch eine Immunität gegenüber erkennbaren Beeinflussungstexten herausbilden, gleich ob sie von Mensch oder Maschine erzeugt werden. Und es wird sich die menschliche Sprache verändern, um Menschlichkeit zu erkennen zu geben, und Textformen wie Meinungsartikel werden gegenüber scheinbar sachlichen und neutralen Artikeln wichtiger werden, die auch von Algorithme geliefert werden können.

Vorerst haben Wissenschaftler vom MIT-IBM Watson AI Lab und der Harvard University im KI-Wettrüsten mit dem Algorithmus GLTR ein Gegenprogramm gebaut, das erkennen soll, ob ein Text von einem KI-Programm erzeugt wurde. Das Problem daran ist, dass das Aufklärungsprogramm dem Programm GPT-2 zu nahe bleibt. Versucht wurde abzuschätzen, welches Wort am wahrscheinlichsten kommt, weil das das Wort ist, was GPT-2 nehmen würde. Menschen, so die Hypothese, würden vermehrt unwahrscheinliche Wörter wählen. Wenn also eher unwahrscheinliche Ergänzungen vorliegen, würde das für einen von einem Menschen verfassten Text sprechen. Was einem dabei spontan einfällt, wäre die Einschaltung eines Zufallsgenerators, der hin und wieder anderes als das Höchstwahrscheinliche einfügt, um das Aufklärungsprogramm in die Irre zu führen.

Aber schon so fällt es dem Programm schwer, Texte, die von anderen Programmen erzeugt werden, zu erkennen. GPT-2-Texte werden zwar einigermaßen entlarvt, so fand KI-Wissenschaftlerin Janelle Shane heraus, aber wenn sie einen von ihrem Textgenerator erzeugten Text vorlegt, ging der als ein vermutlich von Menschen geschriebener Text durch, weil er dem KI-Programm so unvorhersagbar erschien. Das Problem könnte auch daran liegen, dass GPT-2 nur erkennt, was ein untrainiertes Programm als nächstes Wort als am wahrscheinlichsten selektiert. Das kann eben manchmal überzeugen, oft aber auch nicht, denn offenbar kommt in 50 Prozent der Fälle auch Blödsinn heraus.

Klar ist, dass wir immer mehr mit Texten oder anderem Content konfrontiert sein werden, die oder der nicht von Menschen erzeugt wurden (automated content, Roboterjournalismus, Chatbots). Die Frage aber ist, warum etwa Wetterberichte, Sport-, Wirtschafts- oder Politiknachrichten von Menschen geschrieben werden müssen, um irgendwie besser, wahrer, objektiver etc. zu sein. Wir kennen normalerweise nicht die Journalisten, die Texte schreiben. Wir nehmen zwar an, dass es sich um Menschen handelt, aber das würde eigentlich nur evident, wenn die "Fakten" in eine persönliche Weltsicht integriert werden, woraus ablesbar ist, dass die "Fakten" von einem Individuum ausgewählt, dargestellt und interpretiert werden, der als leibliches Wesen davon betroffen sein könnte oder einen Vorgang aus seinem verkörperten (und endlichen) Dasein in der Welt interpretiert.