Gedankenlesen mit EEG und KI

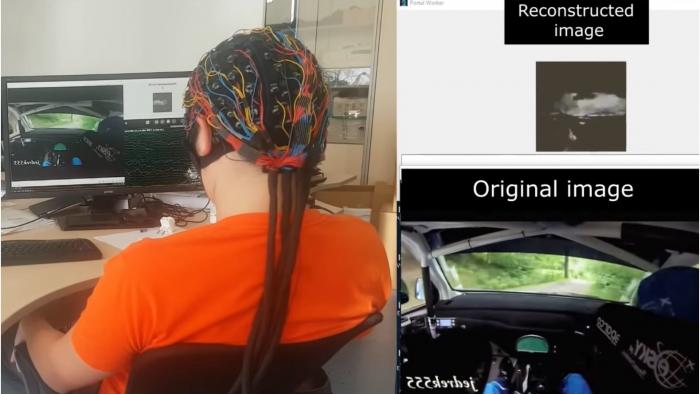

Screenshot aus MIPT-Video

Russische Wissenschaftler stellen eine Technik vor, mit der sich in Echtzeit Bilder rekonstruieren lassen, die ein Mensch gerade sieht

Schon länger wird daran geforscht, dem Gehirn auf die Schliche zu kommen und aus neuronalen Aktivitätsmustern zu erkennen, an was der Mensch gerade denkt oder zumindest was er sieht. Solche Gedankenlesemaschinen sind eigentlich Übersetzungsalgorithmen, die möglichst genau reproduzieren sollen, was das Gehirn verarbeitet. Am weitesten gekommen ist man bei der visuellen Wahrnehmung, hier kennt man die beteiligten Areale und Verarbeitungsmuster ziemlich genau (Der nächste Schritt zur Gedankenlesemaschine?).

Jetzt haben russische Wissenschaftler von der Firma Neurobotics und dem Moskauer Institut für Physik und Technologie vorgeführt, dass sich mit nichtinvasivem Abgreifen der Gehirnaktivität schon einigermaßen gut die Bilder in Echtzeit reproduzieren lassen, die eine Versuchsperson gerade sieht. Die Wissenschaftler haben ein Video veröffentlicht, dass dies auf beeindruckende Weise zeigt, und über ihre Entwicklung einen Artikel veröffentlicht.

Ziel der Forschung ist nicht, Gehirne zu belauschen, sondern Methoden und Geräte für Computer-Gehirn-Schnittstellen zu entwickeln, um Menschen mit kognitiven Störungen oder nach Gehirninfarkten zu unterstützen. Dazu müsse man wissen, wie das Gehirn Signale verarbeitet. Die Wissenschaftler wollen Assistenzsysteme entwickeln, die wie Prothesen oder andere Geräte auf einfache Weise durch die Abnahme von neuronalen Aktivitäten gesteuert werden, die von einem Menschen ohne großes Training willkürlich erzeugte motorische Befehle von Bewegungsabläufen darstellen. Wichtig sei auch, hier ein Neurofeedback zu erzeugen, weil dadurch die Menschen besser und schneller lernen, ihre mentale Zustände zu steuern.

Bislang wurde die Ableitung von wahrgenommenen Bildern aus neuronalen Aktivitäten mittels MRT, was aufwendig und teuer ist, oder durch Implantate im Gehirn geleistet, wie Elon Musk das mit Neuralink anstrebt. Beides sind keine Techniken für eine allgemeine klinische Praxis, sagen die russischen Wissenschaftler. Das Einpflanzen von Neuroimplantaten setze eine aufwendige Operation voraus, überdies würden die eingepflanzten Implantate schnell oxidieren und in wenigen Monaten kaputtgehen können. Die russischen Wissenschaftler haben hingegen die Möglichkeit entwickelt, mit einem EEG mit 20 Elektroden die Gehirnwellen abzunehmen und diese mit einem Deep-Learning-KI-Programm wieder in Bilder umzuwandeln - und das eben nicht-invasiv und in Echtzeit.

Für ihre Versuche zur Demonstration der Technik ließen sie 17 gesunde Versuchspersonen zwei 21-minütige Filme mit verschiedenen Objekten aus 5 verschiedenen Kategorien wie Gesichter, Wasserfälle oder abstrakte Formen auf einem Bildschirm anschauen, während sie auf einem anderen Bildschirm die vom Programm rekonstruierten Bilder sehen konnten. Die jeweils zufällig ausgewählten 117 YouTube-Clips, die zwischen 6 und 10 Sekunden lang und durch einen 1-3 Sekunden langen "schwarzen Bild" als Pause getrennt sind, sollten entweder Stress oder Ruhe oder Konzentration bewirken. Filme anstatt einzelne Bilder wurden auch deswegen verwendet, um die Aufmerksamkeit der Versuchspersonen hoch zu halten, weil Abschweifen und sinkende Konzentration Rauschen oder Inkonsistenzen erzeugen.

Der erste Film diente als Training für das neuronale Netzwerk, der zweite, den die Versuchspersonen nach einer kurzen Pause, anschauten, als Validierung. Das Feedbackmodell wurde anhand von drei der fünf Kategorien trainiert. Dabei wurden zwei neuronale Netzwerke zusammengeschaltet: das ein erzeugte aus "Rauschen" zufällig Bilder einer Kategorie, während das andere aus dem EEG ein ähnliches "Rauschen" erzeugte. In der Folge wurden die neuronalen Netzwerke trainiert, so zu kooperieren, dass das EEG-Signal in Bilder übersetzt wird, die denen gleichen, die die Versuchspersonen sehen. 90 Prozent der rekonstruierten Bilder seien erkennbar der richtigen Kategorie dargestellt worden. Dabei reagiert jede Person anders auf unterschiedliche visuelle Stimuli.

"Wissenschaftler waren gewöhnlich der Ansicht, dass die Untersuchung von Gehirnprozessen mit dem EEG dem ähnlich komme, wenn man die interne Struktur einer Dampfmaschine durch den Rauch herausbekommen will, der aus einer Dampflokomotive kommt", sagt Koautor Grigory Rashkov. "Wir haben uns nicht vorgestellt, dass das ausreichend Informationen enthält, um selbst nur teilweise ein von einem Menschen gesehenes Bild zu rekonstruieren. Es stellte sich jedoch heraus, dass das gut möglich ist."