Wie Sie Benchmarks richtig lesen, um die Performance von PCs zu evaluieren – und wie Sie so das passende System für Ihre Bedürfnisse wählen.

Während es viele Faktoren gibt, die bei der PC-Kaufentscheidung eine Rolle spielen, gehört Performance noch immer zu den wichtigsten Kriterien für Unternehmen jeder Größe. Viele Unternehmen nutzen Performance-Benchmarks, um zu entscheiden, welches System ihren Ansprüchen am besten gerecht wird. Jedoch beleuchten solche Benchmarks oft nicht alle Aspekte der Performance. Basieren sie auf professionellen Anwendungen oder größtenteils Konsumentenanwendungen? Was waren die Umgebungsbedingungen? In diesem Artikel werden wir beleuchten, wie Sie Benchmarks richtig lesen, um die Leistung von PCs zu evaluieren – und wie Sie sicherstellen, dass Sie das richtige System für Ihre aktuellen und zukünftigen Ansprüche wählen.

Die klassische Methode der Leistungsbestimmung

Traditionell verwendeten Unternehmen verschiedenste physische Spezifikationen, wie etwa Prozessor-Taktfrequenz und Cache-Größe, um einen Richtwert für die Performance von PCs zu erhalten. Allerdings gibt es bei dieser Herangehensweise zwei Probleme. Zum Einen können zwei Prozessoren mit gleicher Taktfrequenz aufgrund der Effizienz ihrer zugrundeliegenden Implementierungen enorme Leistungsunterschiede aufweisen. Dieser Unterschied wird für gewöhnlich in „Instructions Per Clock“ (IPC) gemessen. Das zweite Problem ist, dass bei den meisten modernen Prozessoren die Taktfrequenz nicht konstant ist. Dies trifft besonders auf Prozessoren in Notebook-PCs zu, wo die Taktfrequenz durch thermische Limitierungen begrenzt wird. Die Taktfrequenz variiert zudem dramatisch je nach Art der ausgeführten Aufgabe, Dauer der Aufgabe, Anzahl der genutzten Kerne, usw.

Leistungsbestimmung unter realen Bedingungen

Moderne Anwendungen sind hochkomplex und involvieren verschiedenste zugrundeliegende Algorithmen und Datenzugriffsmuster. Aus diesem Grund variiert die gemessene Effizienz eines Prozessors – also die IPC – oft erheblich zwischen verschiedenen Anwendungen und Workloads. Viele Anwendungen umfassen Funktionen zur Darstellung von Grafiken auf dem Bildschirm, zum Lesen von Daten aus dem Speicher oder sogar über das Netzwerk. Für solche Arbeitslasten ist die CPU-Leistung, wenn auch wichtig, nicht der einzige ausschlaggebende Faktor.

Eine der besten Möglichkeiten, die Performance eines neuen PCs zu evaluieren, ist ein Test unter realen Bedingungen. Dabei werden alltägliche Aufgaben im gewöhnlichen Arbeitsumfeld der Benutzer und unter Zuhilfenahme von realen Daten durchgeführt. Die Erfahrungswerte dieser Benutzer werden voraussichtlich besser mit ihrer künftigen Zufriedenheit übereinstimmen und akkuratere Ergebnisse liefern als ein Benchmark allein. Diese Herangehensweise hat jedoch auch ihre Tücken. Unter anderem erfordert eine solche Evaluation mehr Zeit, es kann sich schwierig gestalten, messbare Workloads zu bestimmen, und die Performance auf konsistente, verlässliche und unvoreingenommene Art und Weise zu messen, ist ebenfalls nicht trivial.

Neben individuellen Benutzertests gibt es jedoch noch eine weitere Methode. Dabei können hauseigene Entwickler auf Grundlage des Benutzerfeedbacks „maßgeschneiderte“ Skripte schreiben, um die Performance von Anwendungen auf eine Art zu messen, die mit den Prioritäten der Benutzer übereinstimmt. Diese Herangehensweise kann die Konsistenz der Leistungsmessungen verbessern und besser reproduzierbare Ergebnisse liefern. Allerdings stellt auch dies einen erheblichen Arbeitsaufwand dar und kann beim Wechsel zwischen PC-Generationen zu einem erhöhten Verwaltungsaufwand führen.

Stattdessen setzen die meisten Unternehmen auf branchenübliche PC-Benchmarks, um die Performance ihrer Systeme zu evaluieren. Anstelle eines einzigen Benchmarks können Unternehmen jedoch einen besseren Überblick erhalten, indem sie eine zusammengesetzte Kennzahl aus verschiedenen Benchmarks betrachten.

Abbildung 1 vergleicht drei unterschiedliche Herangehensweisen zur Evaluierung von PC-Performance – Benchmarks, Anwendungsskripte und Benutzerevaluationen – und zeigt, wie die Ergebnisse in der Relevanz für Unternehmen variieren können.

Abbildung 1 – PC-Evaluationsstrategie

Was macht einen guten Benchmark aus?

Bei der Evaluierung von PC-Performance kommen in der Regel zwei Arten von Benchmarks zum Einsatz: „synthetische“ und „anwendungsbasierte“ Benchmarks. Beide Arten können sich bei der Entscheidungsfindung als nützlich erweisen, jedoch können einzelne Benchmarks oft unerwünschte Eigenschaften aufweisen. Dies kann ausgeglichen werden, indem man mehrere Benchmarks gemeinsam betrachtet, um ein umfassenderes, verlässlicheres Bild der Performance zu erhalten.

Ein guter Benchmark sollte so transparent wie möglich sein und eine klare Beschreibung der Testparameter und Testmethoden aufweisen. Im Falle von anwendungsbasierten Benchmarks können Käufer so besser verstehen, ob die getesteten Workloads mit den Einsatzzwecken ihres Unternehmens übereinstimmen. Ohne ausreichende Transparenz kann zudem die Frage aufkommen, ob die Tests so ausgewählt wurden, dass eine bestimmte Architektur besser abschneidet als andere.

Nicht alle anwendungsbasierten Benchmarks sind gleich

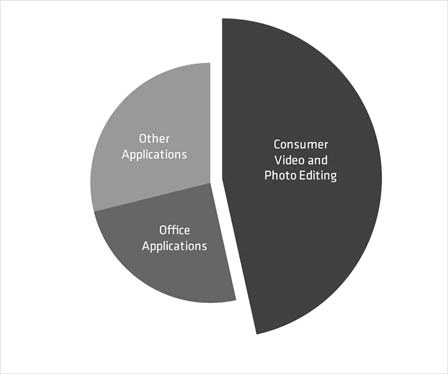

Die Tests eines anwendungsbasierten Benchmarks sollten die Workloads widerspiegeln, die für Ihr Unternehmen relevant sind. Wenn beispielsweise 30–50 % eines Benchmarks aus Anwendungen bestehen, die selten in einem kommerziellen Umfeld eingesetzt werden, dann ist diese Kennzahl wahrscheinlich nicht sehr relevant. Der Benchmark in Abbildung 2 basiert hauptsächlich auf Konsumentenanwendungen und weist nur einen geringen Anteil an Büroanwendungen auf. Dieser Benchmark ist also vermutlich nicht sehr nützlich für die meisten kommerziellen Unternehmen.

Abbildung 2 – Eine für kommerzielle Umgebungen ungeeignete Benchmark-Zusammenstellung

Einige anwendungsbasierte Benchmarks messen zwar die Performance von handelsüblichen Awendungen, repräsentieren jedoch nicht die exakte Version der Anwendung, die in Ihrem Unternehmen eingesetzt wird, oder beinhalten nicht die aktuellsten Leistungsoptimierungen der Softwarehersteller. Genau da kommen synthetische Benchmarks ins Spiel.

So evaluieren Sie das Leistungspotential einer Plattform

Anders als anwendungsbasierte Benchmarks messen synthetische Benchmarks das allgemeine Leistungspotential einer spezifischen Plattform. Während anwendungsbasierte Benchmarks zeigen, wie gut eine Plattform für bestimmte Versionen von bestimmten Anwendungen optimiert ist, sind sie nicht immer ein guter Indikator für die Performance bei neuartigen Anwendungen. Viele Videokonferenzlösungen nutzen beispielsweise mehrere CPU-Kerne, um Funktionen wie die Darstellung virtueller Hintergründe zu realisieren. Synthetische Benchmarks, welche die Multi-Threading-Performance einer Plattform messen, können eine gute Vorhersage darüber treffen, wie gut eine Plattform diese neue Funktionalität bereitstellen kann.

Bei synthetischen Benchmarks sollte man darauf achten, die Parameter zur Bestimmung der Performance nicht zu eng anzulegen. Individuelle Prozessoren, sogar aus der selben Produktfamilie, können selbst kleinste Codezeilen oft unterschiedlich behandeln. Der Wert eines synthetischen Benchmarks sollte aus mehreren individuellen Tests bestehen und mehrere Codezeilen umfassen, welche unterschiedliche Arbeitslasten widerspiegeln. Dies liefert einen weitaus besseren Überblick über die Performance der Plattform.

Multi-Tasking ist schwer zu messen

Anwendungsbasierte Benchmarks tun sich schwer damit, den Workload eines modernen Büroarbeiters zu simulieren, der mehrere Aufgaben gleichzeitig ausführt. Dies liegt darin begründet, dass die simultane Ausführung mehrerer Anwendungen zu einer höheren Fehlermarge führt, als wenn die Anwendungen eine nach der anderen getestet werden. Synthetische Anwendungen, welche die rohe Multi-Threading-Rechenleistung einer Plattform messen, sind eine gute Approximation für die Ansprüche der auf Multi-Tasking angewiesenen Benutzer von heute.

Eine erfolgsversprechende Methode ist es, sowohl anwendungsbasierte als auch synthetische Benchmarks zu betrachten. Durch die Berechnung des Mittelwerts können verschiedene Werte kombiniert und die unterschiedlichen Werteskalen verschiedener Benchmarks angepasst werden. So erhält man den besten Überblick über die Performance einer spezifischen Plattform, sowohl für die Anwendungen von heute als auch für die Bedürfnisse der Zukunft.

Weitere wichtige Erwägungen

Benchmarks sind eine wichtige Komponente jeder Systemevaluation. Jedoch können diese nützlichen Tools auch an ihre Grenzen stoßen:

- Die gemessene Benchmark-Performance kann je nach Betriebssystem (OS) und Anwendungsversion variieren – stellen Sie sicher, dass die entsprechenden Versionen mit denen übereinstimmen, die Sie in Ihrem Unternehmen verwenden.

- Weitere Rahmenbedingungen können ebenfalls Einfluss auf die Ergebnisse nehmen – darunter Hintergrundprozesse, Raumtemperatur und Betriebssystemfeatures, wie virtualisierungsbasierte Sicherheit (VBS). Stellen Sie also erneut sicher, dass die Bedingungen mit Ihren geplanten Einsatzgebieten übereinstimmen.

- Einige Benutzer verwenden womöglich Nischenanwendungen und -funktionen, welche nicht von den Benchmarks abgedeckt werden. Denken Sie darüber nach, Benchmark-Ergebnisse mit Benutzer-Messungen zu kombinieren und diese mit synthetischen Benchmark-Ergebnissen zu korrelieren.

Vorsicht vor Messfehlern

Bei jeder Messung gibt es eine bestimmte „Fehlermarge“, also die Abweichung von einem Testergebnis zum anderen. Die meisten Benchmarks weisen eine Gesamtfehlermarge von 3–5 % auf, die auf eine Vielzahl von Faktoren zurückzuführen ist, darunter die begrenzte Messzeit, der „Butterfly-Effekt“ von kleinen Änderungen in den Hintergrundprozessen des OS, usw. Eine Möglichkeit, diesen Fehler auszugleichen, besteht darin, fünf Messungen durchzuführen, den höchsten und niedrigsten Wert zu verwerfen und anschließend den Mittelwert der restlichen drei Ergebnisse zu ermitteln.

Es ist wichtig, die Fehlermarge bei der Festlegung von Bedarfsanforderungen für mögliche Kaufentscheidungen mit einzubeziehen. Wenn ein Ergebnis von X gut mit der Zufriedenheit der Benutzer korreliert, dann sollte die Bedarfsanforderung vorschreiben, dass Ergebnisse innerhalb von [X-Epsilon, Epsilon] liegen sollten, wobei Epsilon der Fehlermarge entspricht. Wenn Epsilon nicht bekannt ist, kann man in der Regel davon ausgehen, dass es in einem Bereich von 3 bis 5 % liegt.

Abschließende Worte

Die korrekte Evaluierung der Performance ist keine eindimensionale Aufgabe. Es gibt unterschiedliche Techniken, die Unternehmen nutzen können, um zu entscheiden, welches System ihren Ansprüchen am besten entspricht. Die Nutzung eines enggefassten Benchmark-Ergebnisses kann zu inkorrekten Schlussfolgerungen führen. Das beste Gesamtbild erhält man, indem man eine Vielzahl von sowohl anwendungsbasierten als auch synthetischen Benchmarks betrachtet.

Der letzte und wichtigste Schritt in jeder Evaluation ist der Test der Systeme, durch eine Gruppe von Benutzern, in ihrer tatsächlichen Arbeitsumgebung. Wie gut ein System auch in Benchmarks oder Anwendungsskripten abschneidet, letztendlich entscheiden die Benutzer darüber, ob ihre Erfahrung zufriedenstellend ist oder nicht. Egal, ob Sie Benchmarks, Anwendungsskripte oder Benutzertests zur Evaluierung der Performance nutzen – die AMD Ryzen™ PRO 4000 Serie Prozessoren bieten einen neuen Standard von Geschwindigkeit und Effizienz, der auch den hohen Ansprüchen der heutigen Benutzer standhält. Erfahren Sie, wie Sie sich die nötige Notebook-Performance sichern können, um die Computing-Anforderungen von heute und die Business-Ansprüche von morgen zu erfüllen.

Weitere Informationen darüber, wie AMD Ryzen™ PRO Prozessoren die Leistungsanforderungen Ihres Unternehmens erfüllen können, finden Sie unter:

https://www.amd.com/de/processors/laptop-processors-for-business