Marktübersicht: KI-Server mit GPUs im Überblick

Mit der zunehmenden Leistung neuer High-End-GPUs drängen neue Serverarchitekturen auf den Markt. Eine Übersicht über spezialisierte Server für KI-Aufgaben.

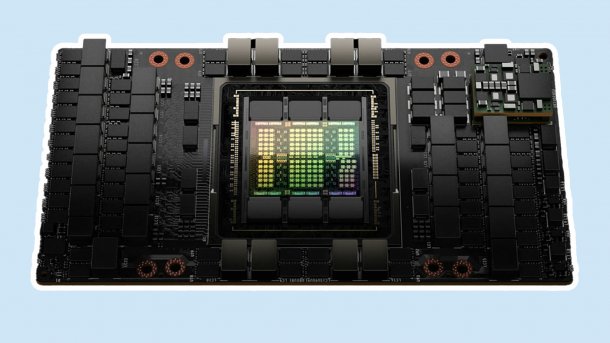

(Bild: Nvidia)

- Hubert Sieverding

Wer den Performancehunger seiner KI-Anwender befriedigen will, kommt mit Standardservern nicht sehr weit. Doch selbst wer zu KI-optimierten Systemen greift, die durch viele PCIe-Slots glänzen, wird schnell an deren Grenzen stoßen. Bereits Anfang 2020, noch bevor die KI-Welle durch die Presse schwappte, konnten wir im Labor mitansehen, wie die zwei Xeon-CPUs eines imposant wirkenden Dell PowerEdge DSS8440 (Test) mit seinen vier Höheneinheiten, 12 Lüftern, vier Netzteilen und gut 50 kg kaum in der Lage waren, den Datenhunger der zehn eingebauten GPUs vom Typ Nvidia V100 über PCIe 4.0 zu befriedigen.

In den letzten vier Jahren ist PCIe doppelt so schnell, die Server sind nochmals größer geworden und der Energiebedarf weiter gestiegen – doch am Engpass zwischen CPU und GPU hat sich wenig geändert. Abhilfe schaffen sollen neue Protokolle und Interfaces wie OAM (Open Application Model) oder die Integration der CPU mit der GPU unter gemeinsamer Nutzung von schnellem HBM-Speicher (High Bandwidth Memory). Welche Systeme mit diesen neuen Techniken der Markt hergibt, zeigt diese Marktübersicht.

Spätestens seit dem KI-Hype um ChatPGT gibt es keinen Serveranbieter ohne GPU-Server mehr. Namhafte Hersteller, die den Trend seit Jahren verpennt haben, widmen in ihren Werbeaussagen einen Universalserver zum GPU-Server um. Dazu reicht es in der Regel aus, passende Netzteile mit hoher Leistung, etwa 2 × 3000 Watt, kräftige Lüfter und PCIe-Slots für doppelbreite GPU-Zusatzkarten bereitzustellen. Besonders gern greifen Hersteller derzeit zu AMDs CPU Epyc 9004, die die momentan größte Anzahl an PCIe-Lanes bietet. Bei Intels Xeon braucht es gegebenenfalls einen PCIe-Switch – insbesondere, wenn zudem viele NVMe-Laufwerke im Spiel sind. Bietet das 2U-Chassis Platz für zwei nebeneinanderstehende H100-GPUs, stimmt sogar die Werbeaussage "Nvidia H100 Tensor Core GPUs können paarweise NVLinked werden", ohne dass das Systemdesign großartig verändert wurde.

Das war die Leseprobe unseres heise-Plus-Artikels "Marktübersicht: KI-Server mit GPUs im Überblick". Mit einem heise-Plus-Abo können Sie den ganzen Artikel lesen.