Missing Link: Vom Wert des LHC – Vor dem Wissen muss man schätzen und suchen

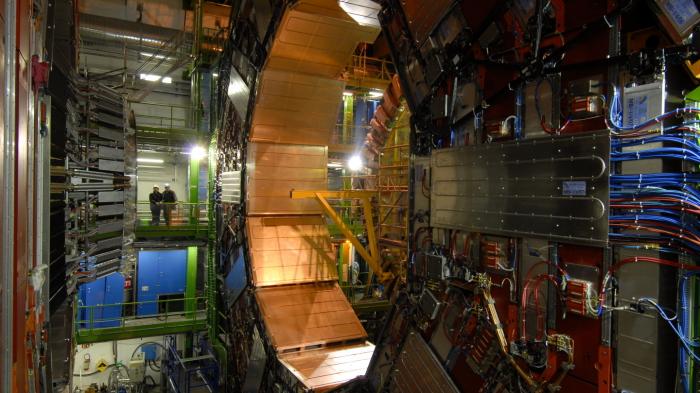

Der CMS-Detektor am LHC während des Baus

(Bild: CERN)

Mit den Mitteln der Physik kann man die Welt auch ohne alle Daten recht präzise beschreiben, am Ende braucht es aber Experimente. Ein Text zum Wert des LHC.

Wie hoch sind die höchsten Berge? Diese Frage kann beantworten, wer die Welt bereist und vermisst. Irgendwann kommt man in den Himalaya, findet den Mount Everest, misst dessen Höhe und kommt auf 8848 Meter über dem Meeresspiegel.

Mit den Methoden der Physik können Größenordnungen aber oft auch mit unvollständigem Wissen richtig abgeschätzt werden. Und wenn man einmal daneben liegt, lohnt es sich meistens, danach Ausschau zu halten, was man übersehen hat. Darum soll es hier gehen, denn das gilt nicht nur für Alltagsfragen sondern auch für die Elementarteilchenphysik und ihre riesigen Experimente wie den Large Hadron Collider (LHC) in Genf, der einigen nicht genug Erkenntnisse geliefert hat [1].

Zurück zu den höchsten Bergen und der Suche nach einer Antwort, ohne dass dafür das Sofa verlassen werden muss: Dazu muss man nur wissen, dass Gestein bei etwa 900 Grad Celsius schmilzt, also zu Lava wird. Nötig ist auch noch die Wärmekapazität von Gestein, also die Menge an Wärmeenergie, die man braucht, um ein Kilogramm um ein Grad zu erwärmen. Dann weiß man, dass man mit etwa 500 Kilojoule ein Kilo Stein schmelzen kann.

Jetzt kann man ermitteln, ab welcher Höhe ein Berg so hoch ist, dass unten das Gestein durch sein Gewicht schmelzen würde. Dazu muss man die Höhenenergie, die durch ein Absacken des Berges frei würde mit der zum Schmelzen benötigten Energie gleichsetzen. Eine kurze Rechnung ergibt für die Höhe h=Q/g (g=9,81 m/s² ist die Erdbeschleunigung). Der Wert h=50 km, den man auf diese Weise findet, ist ein Stück zu groß (er entspricht eher der maximalen Dicke der Erdkruste), trifft aber in etwa die richtige Größenordnung. Nicht schlecht dafür, dass sich dieser Wert vom Sofa aus finden lässt und keinerlei Detailwissen über Geologie und etwa die Formation der Berge im Himalaya erfordert.

Insbesondere können wir aus h=Q/g folgern, dass die Berghöhe umgekehrt proportional zur Schwerebeschleunigung g ist. Diese ist zwar auf der Erde mehr oder weniger gleich, auf dem Mars ist sie jedoch etwa 30 Prozent geringer, der Olympus Mons erhebt sich 26 km über die Marsoberfläche und ist damit der höchste Berg des Sonnensystems. Nach der gleichen Logik würde man auf dem Mond noch höhere Berge erwarten, jedoch gibt es dort keine Plattentektonik oder Vulkanismus, die diese aufwerfen könnten.

Wie groß sind Atome?

Derartige Abschätzungen von Größenordnungen sind allgegenwärtig in der Physik [4], natürlich auch der Quantenphysik, um die es hier eigentlich gehen soll: Als sich Ende des 19. Jahrhunderts schon ihre ersten Zeichen zeigten, aber die genaue Struktur der Quantenmechanik noch unbekannt war, wusste man, dass Elektronen elektrisch geladene Teilchen sind. Aus der Ablenkung eines Kathodenstrahls durch ein Magnetfeld kann man das Verhältnis e/m zwischen der Ladung des Elektrons und seiner Masse bestimmen. Millikan hatte die elektrische Ladung eines Elektrons e=1.6×10⁻¹⁹ As gemessen, woraus sich m=9.11×10⁻³¹ kg ergibt. Darüber hinaus war bekannt, dass für Quantenphänomene das Plancksche Wirkungsquantum h=6.63×10⁻²⁶ Js eine wichtige Rolle spielt, ebenso wie für Elektrostatik die Dielektrizitätskonstante ɛ₀ = 8.85×10⁻¹² A² s⁴/(kg m³), die in der Coulomb-Kraft auftritt.

Diese Naturkonstanten haben verschiedene Einheiten und man kann sie nur auf eine Weise so kombinieren, dass die Einheit einer Energie herauskommt, nämlich R = m e⁴/(ɛ₀ h)². Schon das legt nahe, dass R eine entscheidende Energieskala ist, bei der Elektronen die herausragende Rolle spielen. Natürlich haben auch 0.5 R oder 1000 R die Einheit einer Energie, aber ohne genaueres Wissen über die Zusammenhänge, die bei diesem Elektronensystem eine Rolle spielen, würde man zunächst bei einer Energie in etwa der gleichen Größe wie R zu suchen beginnen. Und in der Tat würde man fündig werden: 8 R ist die "Rydberg-Energie", die Energie, mit der das Elektron eines Wasserstoff-Atoms an seinen Atomkern gebunden ist. Auch andere chemische Energien finden sich in der Nähe der Rydberg-Energie.

Ebenso eine Länge lässt sich aus den Konstanten bilden a = ɛ₀ h² / (e² m). Auch hier sollte man erwarten, dass dies eine typische Länge auf der atomaren Skala ist. Und in der Tat handelt es sich (bis auf einen Faktor 1/π) um den "Bohr-Radius", den Radius eines Wasserstoffatoms.

All diesen Überschlagsrechnungen ist gemein, dass man eine für ein physikalisches System charakteristische Größe abschätzen, den genauen Zahlenwert ohne weitere Kenntnisse der Details aber nicht bestimmen kann. Dafür wäre ein viel besseres Verständnis der Umstände nötig.

Manchmal schlagen solche Schätzungen aber auch komplett fehl: Fällt ein Elektron in einem Atom auf ein niedrigeres Energieniveau zurück, wird die Energie in Form von Licht abgestrahlt. Fragt man nun nach der Wellenlänge dieses Lichts, würde man auch den Bohr-Radius, die wie oben festgestellt einzige charakteristische Länge des Systems, raten. In Wahrheit ist die Wellenlänge jedoch viel größer.

Das liegt daran, dass sobald Licht im Spiel ist, eine weitere Naturkonstante auftritt: die Lichtgeschwindigkeit c. Und mit dieser kann man eine einheitenlose Zahl bilden: α=e² / (ɛ₀ h c) (bis auf einen Faktor 2 die Sommerfeldsche Feinstrukturkonstante). Diese kann auch in Formeln auftauchen, ohne dass man das durch Betrachten der Einheiten feststellen könnte. Was die Lichtemissionen durch Atome angeht, stellt sich heraus, dass zu ihrer Abschätzung nicht wirklich die Wellenlänge charakteristisch ist, sondern die Frequenz, man aus den obigen Atom-Naturkonstanten also eine (inverse) Zeit bilden muss und diese Frequenz dann mittels der Lichtgeschwindigkeit c erst in eine Wellenlänge verwandeln kann. Das Ergebnis ist, dass die charakteristische Wellenlänge nicht a, sondern a/α ist. Dies ist ein wesentlicher Unterschied, da der Faktor 1/α etwa 137 ist.

Durch Schätzen in Richtung Wahrheit

Aus dieser zunächst fehlgeschlagenen Schätzung kann man etwas weiteres beobachten: Die einfachsten Schätzungen müssen nicht immer richtig sein, aber dann kann man der Sache nachgehen und findet vielleicht einen entscheidenden Faktor (wie hier die Rolle der Lichtgeschwindigkeit), den man zunächst übersehen hatte.

Entscheidend ist aber, dass man anders als bei Präzisionsrechnungen für Überschlagsrechnungen noch nicht alle zugrundeliegenden Mechanismen verstehen muss. Daher sind sie in der Forschung besonders hilfreich, wenn es darum geht, zu entscheiden, welche noch unerforschten Fragen man untersuchen will. Hier kann eine Abschätzung wertvolle Hinweise geben, wo man neue Phänomene erwarten kann oder wo es sich in deren Abwesenheit lohnt nach weiteren Erklärungsmustern (wie der Relevanz der Lichtgeschwindigkeit beim Beispiel mit den Wellenlängen) zu suchen.

Dabei gibt es nie eine Erfolgsgarantie und meist kann man nicht einmal eine konkrete Wahrscheinlichkeit benennen, ob etwas erklärungsbedürftig ist oder nur eine zufällige Koinzidenz vorliegt.

(Bild: Philip Halling, Deer under trees, Richmond Park [5], CC BY-SA 2.0 [6] )

Außer Higgs-Teilchen nichts gewesen?

Genau in dieser Situation ist die Teilchenphysik, insbesondere soweit sie an Teilchenbeschleunigern wie dem LHC am europäischen Kernforschungszentrum CERN in Genf betrieben wird. Der wurde konstruiert, um die Physik an der sogenannten elektroschwachen Brechungsskala von etwa 100 GeV bis 1000 GeV (Gigaelektronenvolt) zu untersuchen. Das ist die Energie, die ein Elektron gewinnt, wenn es die entsprechende Spannung durchläuft. Schon am Vorgängerbeschleuniger LEP konnte man die dafür charakteristischen W- und Z-Bosonen vermessen, und insbesondere ihre Masse zu etwa 80 GeV beziehungszweise 91 GeV bestimmen.

Damit die Zusammenführung der elektro-magnetischen Kraft mit der "schwachen Kernkraft" genau wie im Standardmodell der Elementarteilchenphysik vorhergesagt funktioniert, fehlte nur noch das Higgs-Teilchen, das auch tatsächlich am LHC nachgewiesen werden konnte. Dass sich dessen Masse von 125 GeV im vom LHC abgedeckten Energiebereich befinden würde, war keineswegs sicher. Jedoch gab es dafür starke Argumente, die aber nicht logisch zwingend waren (sonst hätte man ja nichts mehr erforschen müssen), sondern nur die Form von Größenordnungsbetrachtungen wie oben hatten.

Der Nachweis der Existenz des Higgs-Teilchens war ein großer, öffentlichkeitswirksamer Erfolg des LHC, der auch in kürzester Zeit mit einem Nobelpreis belohnt wurde. Aber damit ist die Erforschung dieses Teilchens bei weitem noch nicht abgeschlossen. Eine wichtige Vorhersage des Standardmodells ist, dass die Stärke der Streuung des Higgs-Teilchens mit einem anderen Elementarteilchen proportional zu dessen Masse sein muss. Nur so kann das Higgs-Teilchen den anderen Elementarteilchen zu ihren Massen verhelfen. Insbesondere die Produktionsrate von Higgs-Teilchen aus anderen Elementarteilchen sollte direkt aus deren Masse berechenbar sein. Die Vermessung dieser Eigenschaft steckt jedoch noch in ihren Anfängen. Sollten sich hier Abweichungen zeigen, würde das bedeuten, das der Higgs-Effekt noch nicht vollständig verstanden ist.

Es gibt noch eine Reihe von Phänomenen, die nicht vom Standardmodell beschrieben werden. Allen voran die Schwerkraft, die zwischen leichten Elementarteilchen so schwach ist, dass man sie bei Teilchenkollisionen im Beschleuniger nicht wahrnehmen kann: Damit die Gravitation direkt relevant wird, müsste die Kollisionsenergie die Region von 10¹⁹GeV – die "Planckenergie" – erreichen. Für andere Fragen muss man den Blick in den Himmel richten: Kosmologische Beobachtungen belegen, dass ein Großteil der Masse im Universum entweder nicht aus gewöhnlicher Materie besteht oder Einsteins Allgemeine Relativitätstheorie korrigiert werden muss.

Einen Ausweg böten hier neue, schwerere Elementarteilchen ("dunkle Materie"), die jedoch keine nennenswerte Wechselwirkung mit der bekannten Materie haben dürften, etwa sogenannte Wimps (Weakly interacting massive particles). Diese sind jedoch trotz umfangreicher Suche bisher nicht nachgewiesen worden. Dies bedeutet nicht, dass es sie nicht geben kann, nur wissen wir, dass sie schwerer als die bisher im Beschleuniger erreichten Energien sein müssten.

Ein anderes offenes Problem ist unser gegenwärtiges Verständnis der ersten Augenblicke nach dem Urknall. Es ist davon auszugehen, dass im sehr jungen Universum eine Phase sehr schneller Ausdehnung, Inflation genannt, stattgefunden hat, auch wenn es im Detail noch viele Varianten einer solchen Theorie gibt. Allen gemeinsam ist, dass sie nicht mit den bekannten Elementarteilchen des Standardmodells auskommen.

Erwartungen jenseits des Standardmodells

Dass das Standardmodell unvollständig ist, hat aber auch wieder Auswirkungen auf die Physik des Higgs-Teilchens: Nimmt man das Standardmodell, wie es ist, und fügt neue Teilchen (etwa weitere Higgs-artige Teilchen, Wimps oder was immer man für Gravitation oder Inflation braucht) hinzu, hat dies durch Quanteneffekte einen Einfluss auf die Higgs-Masse, die sich zu deutlich höheren Energien verschieben droht. Soll sie umgekehrt beim tatsächlich beobachten Wert nach der Hinzufügung herauskommen, müsste sie vorher viel viel kleiner sein. Anders als andere Parameter des Standardmodells (etwa die Ladungen oder Massen der anderen Teilchen) ist die Higgs-Masse besonders empfindlich gegenüber Änderungen des Modells, man sagt, der (vergleichsweise) kleine Wert der Higgs-Masse ist nicht "natürlich".

Da wir noch nicht genau wissen, welche Änderungen am Standardmodell noch vorgenommen werden müssen, ist diese Aussage über die Higgs-Masse keine präzise Vorhersage, sondern wiederum eine Abschätzung. Es gibt keine logische Gewissheit. Aber es liegt nahe, dass dies kein Zufall ist, sondern sich bei genauerer Suche ein Grund finden lässt, ebenso wie wir oben gesehen haben, dass die Lichtgeschwindigkeit wichtig zur Bestimmung der Wellenlänge ist oder die Existenz von Hirschen erklären kann, warum die Unterseite von Baumkronen einen festen Abstand zum Boden hat.

Susy verzweifelt gesucht

Ein solcher Grund für die Leichtigkeit des Higgs wäre das Vorhandensein einer weiteren Symmetrie, der "Supersymmetrie", die automatisch die starke Abhängigkeit der Higgs-Masse von Variationen des Standardmodells beseitigen würde, da sie die Quanteneffekte deutlich abschwächt. Sie bedingt sogar, dass das Higgs nicht wesentlich schwer als die W- und Z-Bosonen sein kann, was bei 125 GeV im Vergleich zu 80 GeV und 91 GeV noch erfüllt wäre. Allerdings sagt sie zu jeder Sorte von Elementarteilchen eine weitere, verwandte Sorte von Elementarteilchen voraus.

Da dies eine einfache Lösung gleich mehrerer noch offener Probleme wäre, hatten viele Physikerinnen und Physiker gehofft, die vorhergesagten Partnerteilchen am LHC finden zu können. Allerdings wurde bis heute kein einziges nachgewiesen. Dies bedeutet, dass die einfachsten der supersymmetrischen Varianten des Standardmodells nicht richtig sind. Allerdings ist es nach wie vor möglich, dass die Natur eine kompliziertere Version der supersymmetrischen Theorie realisiert hat, in der die Partnerteilchen sich der Beobachtung bisher entziehen konnten.

Bei der Suche danach muss man nur aufpassen, dass sie nach wie vor die Masse des Higgs vor den zu starken Anwachsen bewahren. Oder man muss eine alternative Erklärung für das leichte Higgs finden. Auch in diesem Fall gäbe es für die Physik noch viel zu tun. Jedenfalls braucht es aber eine ungefähre Erwartung, in welchen Richtungen man Ausschau halten muss. Unser Wissen ist heute schon so umfangreich, dass bei den meisten Fragen eine Messung jenseits der Erwartungen ebenso überraschend wäre, wie ein Apfel, der plötzlich nach oben statt nach unten fällt.

Man kann sich auch auf den Standpunkt stellen, die Elementarteilchen sind, was sie sind, und sie haben nun einmal die Massen und Ladungen, die sie haben. Und es gibt keine weiteren Erklärungen, nach denen zu suchen, sinnvoll ist. Dies würde allerdings das Projekt der Grundlagenphysik, die nach immer tieferen Erklärungen der Naturphänomene sucht, und dies auch in den vergangenen Jahrhunderten mit großem Erfolg getan hat, eine vollständige Absage erteilen. Ich sehe auch keinen Grund dafür, hier schon die Flinte ins Korn zu werfen, und nur weil sich die einfachsten Erklärungsversuche als nicht richtig erwiesen haben, gleich die gesamte Suche nach einer Erklärung aufzugeben.

Schon Philipp von Jolly erklärte seinem Schüler Max Planck, bevor Quantentheorie oder Relativitätstheorie sich auch nur abzeichneten, die Physik sei eine hochentwickelte, nahezu voll ausgereifte Wissenschaft die nunmehr, nachdem ihr durch die Entdeckung der Energie gewissermaßen die Krone aufgesetzt sei, wohl bald ihre endgültige stabile Form angenommen haben würde. Wohl gäbe es vielleicht in einem oder dem anderen Winkel noch ein Stäubchen oder ein Bläschen zu prüfen und einzuordnen, aber das System als Ganzes stehe ziemlich gesichert da, und die theoretische Physik nähere sich merklich demjenigen Grade der Vollendung, wie ihn etwa die Geometrie schon seit Jahrhunderten besitzt". Damals war diese Einschätzung falsch, es gibt keinen guten Grund, sie heute für wahrer zu halten.

Sicherlich kann man es mit den Erwartungen auch übertreiben und jederzeit lautstark verkünden, dass das neuste Modell alle bekannten Probleme löst und ganz sicher beim nächstteureren Experiment zweifelsfrei nachgewiesen werden wird. Solche spektakulären Ansagen werden auch von einer Aufmerksamkeitsökonomie gefördert. Bei den meisten Kolleginnen und Kollegen herrscht aber eine gesunde Vorsicht vor, sich dessen bewusst zu sein, wenn man sich auf unsicheres Eis begibt, insbesondere auch wenn es um Begutachtung von Forschungsanträgen geht.

Suche nach Abweichungen vom Standardmodell

Aber selbst wenn man sich nicht eher spekulativen Ansätzen wie der Supersymmetrie widmen will, gibt es am Standardmodell der Elementarteilchen noch viele zu untersuchende Ecken. Der LHC oder zukünftige Teilchenbeschleuniger haben hier noch viel zu vermessen und zu untersuchen, wie etwa den Zusammenhang der Wechselwirkungsstärke mit dem Higgs-Teilchen und der Masse eines Elementarteilchens, oder eine der vielen offenen Fragen rund um Neutrinos. Die sind nur sehr schwer nachzuweisen, entsprechend unvollständig ist unser Wissen über sie.

Nur wenn man das Standardmodell mit Präzisionsmessungen überprüft, wie es der LHC tut, hat man die Möglichkeit, auch Abweichungen wahrnehmen zu können. Solche deuten sich immer wieder an (eine gute Quelle über Nachrichten von solchen Abweichungen ist das Resonaances-Blog [7]). Ich bin überzeugt, dass eine solche früher oder später einen deutlichen Hinweis darauf gibt, wie es nach dem Standardmodell weiter geht. Von der Idee von Peter Higgs zu dem nach ihm benannten Mechanismus und Teilchen bis zu seinem Nachweis am LHC sind auch 40 Jahre vergangen. Der Weg bis zum Nachweis von bislang noch spekulativen Erweiterungen der Teilchenphysik könnte noch mindestens so lange dauern. Wir wissen einfach schon so viel, dass ein Überschreiten der Grenzen immer schwieriger wird. Wenn man sich entschieden hat, weiter zu forschen, geben Abschätzungen einen guten Hinweis darauf, wo man dies zuerst tun sollte. (mho [8])

URL dieses Artikels:

https://www.heise.de/-4244391

Links in diesem Artikel:

[1] https://www.heise.de/hintergrund/Missing-Link-Nichts-Neues-am-LHC-Was-nun-4221966.html

[2] https://www.heise.de/hintergrund/Missing-Link-Nichts-Neues-am-LHC-Was-nun-4221966.html

[3] https://www.heise.de/thema/Missing-Link

[4] https://www.astro.princeton.edu/~burrows/classes/542/papers/Patryk.1975_Weisskopf.pdf

[5] https://www.geograph.org.uk/photo/3003748

[6] https://creativecommons.org/licenses/by-sa/2.0/

[7] http://resonaances.blogspot.com

[8] mailto:mho@heise.de

Copyright © 2018 Heise Medien