Roomba: Wie private Fotos eines Staubsauger-Roboters auf Facebook landen können

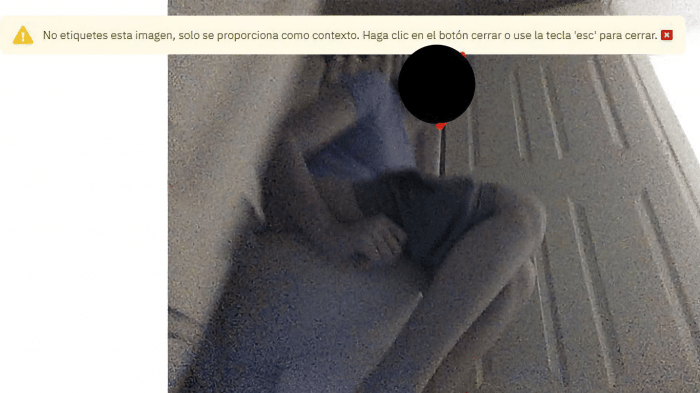

Mensch auf dem Klo, gefilmt von einem Roomba.

(Bild: Screenshot eines Roomba J7, Anonymisierung durch die US-Ausgabe von MIT Technology Review.)

Der Hersteller des Roomba sieht die Schuld für Foto-Leaks nicht bei sich. Testnutzer hätten der Datenerfassung zugestimmt. Diese sehen das aber anders.

Als Informatiker Greg im Dezember 2019 seinen neuen Staubsauger-Roboter auspackte, dachte er eigentlich, er wüsste, worauf er sich da einlässt. Es handelte sich um eine Vorserienversion der Roomba [1] J-Serie von iRobot. Neben seiner regulären Reinigungsarbeit sollte er im Haus umherstreifen, um alle möglichen Daten zu sammeln. Damit wiederum sollte das integrierte KI-System verbessert werden. Gleichzeitig hatte sich Greg verpflichtet, iRobot Feedback zu seiner Nutzererfahrung zu geben.

Das alles hatte er schon einmal gemacht. Neben seiner Arbeit als Ingenieur in einem Softwareunternehmen hatte Greg in den letzten zehn Jahren häufiger Beta-Tests von Produkten durchgeführt. Er schätzt, dass er in dieser Zeit über 50 Produkte getestet hat – von Turnschuhen bis hin zu Smart Home-Kameras. "Das macht mir wirklich Spaß", sagt er. "Der Grundgedanke ist, dass man etwas Neues kennenlernt und hoffentlich an der Gestaltung eines Produkts mitwirkt, sei es bei der Entwicklung einer besseren Version oder bei der Festlegung der Funktionen."

Was Greg jedoch nicht wusste – und seiner Ansicht nach auch nicht erlaubt hatte – war, dass iRobot die Daten von Testnutzerinnen und -nutzern wie ihm an eine weitläufige, globale Lieferkette weitergeben würde. Die wiederum besteht offenbar vor allem aus schlecht bezahlten Beschäftigten außerhalb der USA, die sämtliche Bilder (und jede gefilmte Person) einsehen können, die von den Frontkameras des Staubsauger-Roboters aufgenommen wurde. Und, noch schlimmer: Einige dieser Menschen machen von den Aufnahmen offenbar nach Belieben Screenshots, die dann weitergegeben werden.

Ein Roomba auf Abwegen

Greg, der darum gebeten hat, nur mit seinem Vornamen genannt zu werden, weil er eine Geheimhaltungsvereinbarung mit iRobot unterzeichnet hat, ist nicht der einzige Testnutzer, der sich betroffen und überrascht zeigt. Fast ein Dutzend Personen, die zwischen 2019 und 2022 an dem Programm teilgenommen haben, zeigten sich nach einer Recherche der US-Ausgabe von MIT Technology Review erstaunt darüber, dass das Unternehmen Bilder aus ihren realen Wohnungen verwendet, um seine KI zu trainieren. Sie äußerten Bedenken, wie iRobot mit diesen Daten umgeht und fragen sich, ob diese Praktiken mit den Datenschutzversprechen des Unternehmens übereinstimmen. Viele fühlen sich getäuscht.

"Es besteht eine echte Besorgnis darüber, ob das Unternehmen betrügerisch handelt, wenn Menschen sich für diese Art von hochgradig invasiver Überwachung anmelden und nie ganz verstehen, wozu sie sich bereit erklären", kommentiert Albert Fox Cahn, Geschäftsführer des "Surveillance Technology Oversight Project", das sich für mehr Datenschutz engagiert. "Das Versäumnis des Unternehmens, die Daten der Testnutzer angemessen zu schützen, fühlt sich wie ein klarer Bruch der Vereinbarung auf ihrer Seite an", sagt Greg. Es sei "ein Versagen ... [und] auch ein Vertrauensbruch". Anders gesagt: Wer übernimmt hier die Verantwortung?

MIT Technology Review konnte aufdecken, wie iRobot Fotos und Videos aus den Wohnungen von Testnutzern und Beschäftigten sammelt und sie an Unternehmen weitergibt, die KI-Modelle durch sogenannte Etikettierung mit Daten füttern. Dabei werden Bildbereiche markiert und von Menschen beschriftet, die Algorithmen so trainiert. Zu den beteiligten Firmen gehört das in San Francisco ansässige Unternehmen Scale AI, das über den Globus verstreut lebende Beschäftigte damit beauftragt, diesen Job zu erledigen.

Roomba-Fotos finden ihren Weg ins Internet

Bei der Recherche kam etwa heraus, dass bei einem Projekt im Jahr 2020 prekär beschäftigte "Gigworker" in Venezuela gebeten wurden, Objekte in einer Reihe von Bildern von Innenräumen zu beschriften, von denen einige auch Personen enthielten – deren Gesichter für die Gigworker sichtbar waren. Einige der Beschrifter teilten dann mindestens 15 Bilder – darunter Aufnahmen eines Minderjährigen und einer Frau, die auf der Toilette sitzt – in sozialen Medien, wo sie sich darüber austauschten. Diese Screenshots landeten schließlich in der US-Redaktion von MIT Technology Review. Es folgten Interviews mit den Gigworkern. Auch Rückfragen bei KI-Forschern, die sich mit dem Thema befassen, lassen vermuten, dass dies wahrscheinlich nicht die einzigen Bilder sind, die ihren Weg ins Internet gefunden haben.

Dass sensible Bilder, Videos und Audiodateien Menschen vorgesetzt werden, die mit der Etikettierung zu KI-Zwecken beschäftigt sind, kommt mittlerweile häufiger vor. Und kurz nachdem MIT Technology Review iRobot im vergangenen Herbst um eine Stellungnahme zu den Fotos gebeten hatte, kündigte das Unternehmen seinen Vertrag mit Scale AI. In einem LinkedIn-Posting [2] in Reaktion auf die Berichterstattung wollte iRobot-CEO Colin Angle allerdings nicht bestätigen, dass die bloße Tatsache, dass solche Bilder mitsamt der Gesichter der Testnutzer für Gigworker sichtbar waren, ein Grund zur Sorge sei. Vielmehr schrieb er, dass die Bereitstellung solcher Bilder notwendig ist, um die Objekterkennungsalgorithmen von iRobot zu trainieren.

"Wie werden unsere Roboter so smart? Es beginnt während des Entwicklungsprozesses und auch durch die Sammlung von Daten zum Trainieren von Algorithmen aus dem Bereich des maschinellen Lernens." Außerdem wies er darauf hin, dass die Bilder nicht von Kundinnen und Kunden stammten, sondern von bezahlten Testnutzern ("paid data collectors") und Mitarbeitern. Und die hätten ja eine Einverständniserklärung unterzeichnet.

In dem LinkedIn-Post und in weiteren Erklärungen gegenüber MIT Technology Review haben Angle und iRobot wiederholt betont, dass keine Kundendaten weitergegeben wurden und dass die Teilnehmenden informiert wurden und ihnen bewusst ist, wie die Daten gesammelt werden. Der Versuch, zwischen Kunden und Testnutzern zu unterscheiden, verwirrt jedoch letztere. Denn sie betrachten sich als Teil der breiteren iRobot-Community und fühlen sich herablassend behandelt. Greg und die anderen Betroffenen, die sich gemeldet haben, bestreiten zudem, durch die freiwillige Teilnahme ihre Privatsphäre aufgegeben zu haben. Das sei eine Unterstellung.

Verschwommene Grenze zwischen Verbrauchern und Testnutzern

Außerdem ist die Grenze zwischen Testnutzern und Verbrauchern nicht so klar gezogen, wie es scheint. Zumindest einem der Tester, mit denen MIT Technology Review gesprochen hat, wurde sein Test-Roomba später verkauft. Das war nicht unüblich. Centercode, das Unternehmen, das Testnutzer im Auftrag von iRobot rekrutiert, versucht nämlich, den Schritt vom Testenden hin zum Kunden oder gar "Evangelist" für das Produkt aktiv zu fördern. "Es ist schwer, bessere potenzielle Markenbotschafter zu finden als in der Gemeinschaft der Testnutzer", schwärmt die Firma. Diese hätte eine authentische Stimme, die all ihren (vermutlich technikbegeisterten) Bekannten vom neuen Produkt erzähle.

Für Greg hat iRobot im Umgang mit seiner Test-Community "spektakulär versagt" – insbesondere durch sein Schweigen beim Thema Datenschutzverletzung. iRobot betont, es habe alle Personen benachrichtigt, die auf den 15 in sozialen Medien geteilten Bildern aufgetaucht waren. Ob es auch andere Betroffene gab, wurde nicht kommuniziert. Bei MIT Technology Review meldeten sich keine weiteren Nutzerinnen und Nutzer, die informiert worden waren. Ergo: Statt grundlegend über den Sicherheitsvorfall zu informieren, werden nur einzelne Personen kontaktiert.

Einblick in die Welt der Betatests

Die Reise der iRobot-Daten beginnt auf Testplattformen wie Betabound, die von Centercode betrieben wird. Das Technologieunternehmen mit Sitz in Laguna Hills, Kalifornien, rekrutiert Freiwillige, die Produkte und Dienstleistungen für seine Kunden – in erster Linie Consumer-Tech-Unternehmen – ausprobieren wollen. (iRobot-Sprecher James Baussmann bestätigte, dass das Unternehmen Betabound nutzt, sagte aber auch, dass das nicht bei Testnutzern der Fall war. Centercode reagierte nicht.)

Als Early Adopters sind Beta-Tester oft technisch versierter als der durchschnittliche Verbraucher. Sie begeistern sich für Gadgets und arbeiten, wie Greg, manchmal selbst im Technologiesektor – sie sind also oft mit den Datenschutzstandards vertraut. Eine Überprüfung aller Angebote, die Ende Dezember auf der Betabound-Website aufgeführt waren, zeigt, dass iRobot seit mindestens 2017 über die Plattform testen lässt. Das jüngste Projekt, für das interessanterweise speziell deutsche Testerinnen und Tester gesucht werden, startete erst letzten Monat. Die Staubsauger von iRobot sind bei weitem nicht die einzigen Geräte in dieser Kategorie. Es sind über 300 Tests für andere "intelligente" Geräte mit KI-Technik aufgelistet, darunter "eine intelligente Mikrowelle mit Alexa-Unterstützung" sowie mehrere Staubsauger-Roboter anderer Marken.

Der erste Schritt für potenzielle Tester besteht darin, ein Profil auf der Betabound-Website anzulegen. Anschließend können sie sich für bestimmte Projekte bewerben, sobald diese angekündigt werden. Wenn sie von dem Unternehmen, das den Test durchführt, akzeptiert wurden, unterzeichnen die Testnutzer zahlreiche Vereinbarungen, bevor sie ihr Gerät erhalten.

Betabound-Tester werden jedoch nicht bezahlt, wie in den FAQ der Plattform zu lesen ist: "Unternehmen können nicht erwarten, dass das Feedback ehrlich und zuverlässig ist, wenn Testnutzer dafür bezahlt werden." Stattdessen erhalten die Angeworbenen unter anderem Geschenkgutscheine, die Möglichkeit, ihre Testgeräte später zu behalten, sowie manchmal auch kostenlose neue Produktionsversionen, die geliefert werden, nachdem das von ihnen getestete Gerät offiziell auf dem Markt ist.

Geschenkgutscheine für iRobot-Testnutzer

iRobot erlaubte den Testnutzern bei Betabound allerdings nicht, ihre Geräte zu behalten. Auch fertige Produkte erhielten sie nicht. Stattdessen berichteten uns die Teilnehmer, dass sie Geschenkgutscheine in Höhe von 30 bis 120 US-Dollar dafür erhielten, dass sie die Staubsauger-Roboter über mehrere Wochen hinweg mehrmals pro Woche in Betrieb nahmen. (Sprecher Baussmann sagt, dass "der Betrag, der den Teilnehmern gezahlt wird, je nach Arbeitsaufwand variiert").

Für einige Testnutzer war diese Entschädigung enttäuschend. "Besonders wenn man bedenkt, dass man meinen nackten Hintern jetzt im Internet sehen könnte", so einer von ihnen, der anonym bleiben will. iRobot wirft er Geiz vor. Er habe nur 30 Dollar bekommen, obwohl der Roboter drei Monate lang täglich Daten gesammelt hat.

Als MIT Technology Review im vergangenen Herbst iRobot um eine Stellungnahme zu den 15 geleakten Bildern bat, betonte das Unternehmen, dass jede der Aufnahmen mit einer entsprechenden Einverständniserklärung versehen war. Das Unternehmen wollte die Vereinbarungen jedoch nicht herausgeben und führte "rechtliche Gründe" an. Darin soll unter anderem stehen, dass Videos und Bilder während der Reinigungsarbeiten aufgenommen werden und es möglich ist, sensible Bereiche der Wohnung auszuschließen, etwa jene mit Kindern. All das müssen die Testnutzer laut iRobot absegnen.

Womit sich die Nutzer wirklich einverstanden erklären

Einige Testnutzer haben MIT Technology Review Kopien ihrer Vereinbarungen mit iRobot zur Verfügung gestellt. Dazu gehörten mehrere Formulare, darunter eine allgemeine Vereinbarung mit Betabound sowie eine "globale Testvereinbarung für Entwicklungsroboter". Außerdem gibt es Geheimhaltungsregelungen und solche zum Testablauf und dem Ausleihen von Produkten. Auch werden spezifische Tests beschrieben.

Die Formulare enthalten die von iRobot erwähnten Formulierungen, darunter Verpflichtungen des Unternehmens, die Daten der Testnutzerinnen und -nutzer zu schützen. Sie bringen jedoch wenig Klarheit darüber, was dies genau bedeutet – insbesondere dazu, wie das Unternehmen mit den Nutzerdaten nach ihrer Erfassung umgehen wird und an wen diese Daten weitergegeben werden.

Die "globale Testvereinbarung für Entwicklungsroboter" liegt MIT Technology Review in ähnlichen Versionen von einem halben Dutzend Personen vor. Sie wurde zwischen 2019 und 2022 unterzeichnet. In dem Dokument mit rund 1.300 Wörtern weist iRobot darauf hin, dass es der für die Datenverarbeitung Verantwortliche ist, was gemäß der EU-Datenschutzgrundverordnung (DSGVO) [3] die rechtliche Verpflichtung mit sich bringt, sicherzustellen, dass die Daten nur für rechtmäßige Zwecke erhoben und sicher gespeichert und verarbeitet werden. Darüber hinaus heißt es: "iRobot erklärt sich damit einverstanden, dass Drittanbieter und Dienstleister, die für die Verarbeitung [personenbezogener Daten] ausgewählt werden, auf Datenschutz und Datensicherheit geprüft werden, an eine strenge Vertraulichkeit gebunden sind und den Bedingungen einer Vereinbarung zur Datenverarbeitung ["Data Processing Agreement" laut DSGVO, Anm. d. Red.] unterliegen." Nutzerinnen und Nutzern werden zudem je nach Wohnort zusätzliche Rechte laut den lokal geltenen Datenschutzgesetzen eingeräumt.

Daten für maschinelles Lernen und Training von Algorithmen

Testnutzer Greg ist der Ansicht, dass iRobot gegen Teile der Vereinbarung verstoßen hat. Ihm fehlt die Übernahme der Verantwortung, die das Unternehmen den Testnutzern gegenüber einräumt. iRobot habe leichtfertig reagiert. "Damit bin ich absolut nicht einverstanden." Darüber hinaus mussten alle Testteilnehmer zustimmen, dass ihre Daten für maschinelles Lernen und das Training von Objekterkennungsalgorithmen verwendet werden dürfen.

Insbesondere der Abschnitt der globalen Testvereinbarung über die "Verwendung von Research-Informationen" verlangte von den Nutzern eine Bestätigung, dass "Text, Video, Bilder oder Audio ... von iRobot zur Analyse von Statistiken und Nutzungsdaten, zur Diagnose von technischen Problemen, zur Verbesserung der Leistung eines Produkts, für die Produkt- und Funktionsinnovation, zur Marktforschung, für Handelspräsentationen und für interne Schulungen verwendet werden können – einschließlich maschinellem Lernen und Objekterkennung".

Was hier nicht erwähnt wird, ist, wie iRobot das Trainieren seiner Algorithmen für das maschinelle Lernen durchführt. Nirgendwo wird klar, dass es Menschen sind, die die Etikettierung durchführen, den Algorithmen Klick für Klick beibringen, die einzelnen in den Rohdaten erfassten Elemente zu erkennen. Mit anderen Worten: In den uns vorliegenden Vereinbarungen wird nie ausdrücklich erwähnt, dass Bilder aus der Privatsphäre von anderen Menschen eingesehen und analysiert werden könnten.

Baussmann, der iRobot-Sprecher, sagte, dass die besagte Formulierung "eine Vielzahl von Testszenarien abdeckt" und nicht spezifisch für Bilder gilt, die zur Etikettierung weitergegeben werden. "Manchmal werden die Tester gebeten, Fotos oder Videos vom Verhalten des Roboters zu machen, z. B. wenn er an einem bestimmten Objekt hängen bleibt oder nicht vollständig in seine Dockingstation zurückkehrt." Diese müssten dann an iRobot gesendet werden.

Für Untersuchungen, bei denen Bilder zu Etikettierungszwecken aufgenommen werden, gebe es spezifische Bedingungen, die in der jeweiligen Testvereinbarung festgelegt seien. Es sei iRobot auch nicht klar, ob die Personen, mit denen MIT Technology Review in Kontakt stand, "Teil der Entwicklungsarbeit waren, die sich auf Ihren Artikel bezog". Dennoch: Die globale Testvereinbarung erlaubt es letztlich, die Daten aller Testnutzer zu sammeln und für maschinelles Lernen zu verwenden.

Was bei den Roomba-Nutzern ankam

Juristinnen und Juristen aus dem Datenschutzbereich und spezialisierte Forschende sehen in der iRobot-Einwilligungsvereinbarung ein lückenhaftes System. Und die Unternehmen wissen, dass die Menschen Datenschutzrichtlinien nur selten genau lesen – wenn überhaupt. Die globale Testvereinbarung von iRobot beweise jedoch, so Ben Winters, Anwalt beim Electronic Privacy Information Center (EPIC), der sich auf KI und Menschenrechte spezialisiert hat, dass "selbst wenn man sie liest, keine Klarheit herrscht".

Vielmehr "scheint ein Großteil dieser Formulierungen darauf abzuzielen, das Unternehmen von den geltenden Datenschutzgesetzen zu befreien, aber nichts davon spiegelt die Realität der Funktionsweise des Produkts wider", sagt Cahn und verweist auf die Mobilität der Staubsaugerroboter und die Unmöglichkeit, zu kontrollieren, wo sich potenziell sensible Personen oder Gegenstände – insbesondere Kinder – in ihrem eigenen Haus aufhalten.

"Letztendlich liegt damit ein Großteil der Verantwortung beim Endnutzer", bemerkt auch Jessica Vitak, Informationswissenschaftlerin am College of Information Studies der University of Maryland, die sich mit den aktuellen Praktiken bei Forschungs- und Einwilligungsrichtlinien beschäftigt. Das Dokument gebe keine wirkliche Vorstellung davon, "was schief gehen könnte", sagt sie. Und genau das müssten Testnutzer doch wissen. Nicht nur, dass die Verantwortung abgewälzt wird, es wird auch diesen Personen überlassen, "die Zustimmung aller Personen im Haus einzuholen", erklärt Cahn. Dabei sind alle Bewohner potenziell einem Risiko ausgesetzt.

"Zugegeben, ich wollte einfach nur ein kostenloses Produkt."

Damit entzieht sich iRobot seiner Verantwortung, glaubt Deirdre Mulligan, Professorin an der School of Information der UC Berkeley. Ein Gerätehersteller, der für die Datenverarbeitung verantwortlich ist, könne nicht einfach die gesamte Verantwortung für die Auswirkungen der Anwesenheit eines Geräts in der Wohnung auf die Testnutzer abwälzen.

Einige Teilnehmer räumten ein, dass sie die Einwilligungserklärung nicht genau gelesen hätten. "Ich habe die [Bedingungen] überflogen, aber den Teil über die Weitergabe von Videos und Bildern an Dritte nicht bemerkt – das hätte mich stutzig gemacht", schrieb einer, der den Staubsauger-Robter letztes Jahr drei Monate lang benutzt hat. Viele hielten das alles offenbar für Standardklauseln im Sinne von: Wenn Ihnen etwas nicht gefällt, benutzen Sie unser Produkt nicht. "Zugegeben, ich wollte einfach nur ein kostenloses Produkt."

Einer der Testnutzer gab an, er habe von iRobot ein gewisses Maß an Datenschutz erwartet – und nicht, dass diese sensible Arbeit im Grunde an den billigsten Anbieter outgesourct wird. Bemerkenswert ist, dass viele der Testnutzer, die MIT Technology Review kontaktierten, immer noch sagen, dass sie nicht klar verstanden haben, was die Erhebung ihrer Daten tatsächlich bedeutet – oder wie genau diese Daten verarbeitet und verwendet werden. Fast alle hatten sich die Bedingungen zumindest einmal angesehen.

Ein Tester, Igor, der nur mit seinem Vornamen genannt werden mochte, arbeitet selbst in der IT-Abteilung einer Bank. Er hält sich für überdurchschnittlich gut ausgebildet in Sachen Cybersicherheit und hat zu Hause eine eigene Netzinfrastruktur aufgebaut, die es ihm ermöglicht, sensible Informationen auf seinen eigenen Servern zu hosten und den Datenverkehr zu überwachen. Er sagte, ihm sei klar, dass Videos von seinem Haus aufgenommen und etikettiert würden. "Ich hatte den Eindruck, dass das Unternehmen mit der Offenlegung der Datenerfassung verantwortungsvoll umging", schrieb er in einer E-Mail und verwies auf die Einverständniserklärung und den gut sichtbaren Aufkleber auf dem Gerät mit der Aufschrift "Videoaufnahme läuft". Aber, so betont er: "Ich bin auch kein durchschnittlicher Internetnutzer."

Großer Schock für die Roomba-Tester

Für viele Testerinnen und Tester war der größte Schock der Geschichte um Roomba, wie die Daten nach der Erfassung gehandhabt werden würden – einschließlich der Frage, wie viele Menschen daran beteiligt sein würden. "Ich bin davon ausgegangen, dass sie [die Videoaufzeichnung] nur zur internen Überprüfung dient, falls es ein Problem gibt, wie es üblich ist (dachte ich)", schrieb ein anderer Tester, der anonym bleiben wollte, in einer E-Mail. Und ein anderer Nutzer, der unter dem Initial "B" firmiert, meinte: "Mir ist definitiv in den Sinn gekommen, dass diese Fotos wahrscheinlich zur Kennzeichnung innerhalb eines Unternehmens gesichtet werden würden, aber die Vorstellung, dass sie online durchgesickert sind, ist beunruhigend."

"Die menschliche Überprüfung hat mich nicht überrascht", fügt Greg hinzu, "aber das Ausmaß der menschlichen Überprüfung schon ... die Idee ist im Allgemeinen, dass KI in der Lage sein sollte, das System zu 80 Prozent zu verbessern ... und der Rest ist, denke ich, nur die Ausnahme ... dass [Menschen] es sich ansehen müssen."

Selbst die Teilnehmenden, die wie Igor damit einverstanden waren, dass ihre Bilder angesehen und mit Anmerkungen versehen wurden, sagten, dass sie sich mit der Art und Weise, wie iRobot die Daten im Nachhinein verarbeitete, unwohl fühlten. Die Einverständniserklärung, so Igor, "entschuldigt nicht den schlechten Umgang mit den Daten" und "die allgemeine Speicherung und Kontrolle, die es einem Auftragnehmer ermöglichte, die Daten zu exportieren".

"Ich hatte keine Ahnung, dass die Daten ins Ausland gehen würden"

Mehrere in den USA ansässige Teilnehmende äußerten sich besorgt darüber, dass ihre Daten außer Landes gebracht werden könnten. Die globale Vereinbarung, so stellten sie fest, enthielt eine Formulierung für Teilnehmer "außerhalb der USA", die besagt, dass "iRobot Forschungsdaten auf Servern außerhalb meines Heimatlandes verarbeiten kann ... einschließlich solcher, deren Gesetze möglicherweise nicht das gleiche Maß an Datenschutz bieten wie die meines Heimatlandes" – aber die Vereinbarung enthielt keine entsprechenden Informationen für Teilnehmerinnen und Teilnehmer mit Sitz in den USA darüber, wie ihre Daten verarbeitet werden würden.

"Ich hatte keine Ahnung, dass die Daten ins Ausland gehen würden", schrieb ein in den USA lebender Teilnehmer an MIT Technology Review – eine Meinung, die von vielen geteilt wurde.

Sobald Daten gesammelt werden, sei es von Testnutzern oder von Kunden, haben die Menschen letztlich wenig bis gar keine Kontrolle darüber, was das Unternehmen als Nächstes mit ihnen macht – einschließlich der Weitergabe ihrer Daten an US-Nutzer im Ausland.

US-Bürger haben sogar in ihrem Heimatland nur wenige Möglichkeiten, ihre Privatsphäre zu schützen, so Cahn. Deshalb gibt es in der EU Gesetze zum Schutz von Daten vor der Weitergabe außerhalb der EU – und insbesondere in die USA. "Die Mitgliedstaaten müssen so umfangreiche Maßnahmen ergreifen, um die in ihrem Land gespeicherten Daten zu schützen. In den USA hingegen herrscht weitgehend der Wilde Westen", sagt er. "Die Amerikaner haben keinen vergleichbaren Schutz gegen die Speicherung ihrer Daten in anderen Ländern.

Viele Testerinnen und Tester sind sich der weitreichenden Probleme im Zusammenhang mit dem Datenschutz in den USA bewusst und haben sich deshalb zu Wort gemeldet.

Botschaft für mögliche Roomba-Käufer

"Außerhalb regulierter Branchen wie dem Bankwesen und dem Gesundheitswesen ist das Beste, was wir tun können, wahrscheinlich die Schaffung einer erheblichen Haftung für Datenschutzversagen, denn nur harte wirtschaftliche Anreize werden die Unternehmen dazu bringen, sich darauf zu konzentrieren", schrieb Igor, der Tester, der in der IT-Abteilung einer Bank arbeitet. "Leider sieht das politische Klima nicht so aus, als könnte hier in den USA etwas passieren. Das Beste, was wir haben, ist die öffentliche Beschämung ... aber das ist oft nur reaktionär und fängt nur einen kleinen Prozentsatz dessen ab, was da draußen ist."

In der Zwischenzeit hat Greg eine Botschaft für potenzielle Roomba-Käuferinnen und -Käufer: "Ich würde einfach keinen Roomba kaufen, solange sich nichts ändert und keine Verantwortung übernommen wird – sei es von iRobot selbst oder auf Druck der Regulierungsbehörden.

Außerdem, so warnt er, "vernachlässigt das Unternehmen seine Verantwortung als Anbieter, die Kunden zu informieren [oder] zu schützen – in diesem Fall auch die Tester dieser Produkte."

(jle [5])

URL dieses Artikels:

https://www.heise.de/-7457283

Links in diesem Artikel:

[1] https://www.heise.de/ratgeber/Staubsaugerroboter-lernen-immer-neue-Tricks-7351991.html

[2] https://www.linkedin.com/pulse/building-smart-robots-requires-responsible-colin-angle

[3] https://www.heise.de/thema/DSGVO

[4] https://www.instagram.com/technologyreview_de/

[5] mailto:jle@heise.de

Copyright © 2023 Heise Medien