50 Jahre Intel: Rückblick auf 50 Jahre große Erfolge und große Misserfolge

50 Jahre Intel. Im Bild: Ein Pentium-Prozessor und Andreas Stiller.

(Bild: Moritz Küstner)

Vom Startup zum Marktführer: Ein sehr persönlicher Rückblick auf 50 Jahre Intel von Andreas Stiller.

Mit viel Arbeit und Können, mit viel Glück und Verstand, mit viel Gespür und Paranoia – aber auch mit reichlich Pleiten, Pech und Pannen und mit mitunter recht merkwürdigen Entscheidungen, das ist Intel. So sorgten zuletzt Sicherheitsprobleme bei den Prozessoren und vor ein paar Wochen der unrühmliche Abgang von Firmenchef Brian Krzanich – wegen angeblichen Verstoßes gegen den Verhaltenskodex der Firma – für Stirnrunzeln.

Zeit für einen persönlichen Rückblick. "Persönlich“ ist hier wörtlich gemeint, denn in der folgenden Würdigung stehen stärker die handelnden Personen und etwas weniger die zumeist hinreichend bekannten Produkte im Vordergrund.

Und persönlich ist natürlich auch mein Blickwinkel, beschränkt auf Intels wichtigste Schiene: die Prozessoren, aufgefüllt mit einigen Anekdoten. Immerhin 35 Jahre konnte ich Intel als Journalist begleiteten, war dafür über 50 Mal bei Intel-Veranstaltungen in den USA (Entwicklerforen, Server- und HPC-Workshops, diverse andere Presseveranstaltungen). Hinzu kamen Besuche von Intel in Irland, Israel, China und natürlich auch in München. Zudem erlebte ich Intel auf den legendären Microprocessor Foren, den Hot-Chips- und zahlreichen Supercomputer-Konferenzen.

In den 50 Jahren entwickelte sich Intel zum größten und bedeutendsten Halbleiterkonzern der Welt, wenn auch dieses Etikett seit kurzem der Halbleitersparte von Samsung Electronics zusteht.

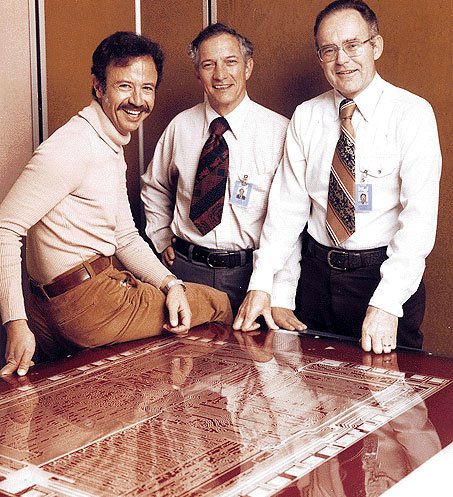

Die Grundlage für diesen Erfolg legte die sogenannte Intel-Trinity: Robert Noyce, Gordon Moore und Andrew Grove; mit den beiden letzten konnte ich auch längere Gespräche führen. Robert Noyce war indes schon 1990 verstorben, ein paar Jahre vor meiner ersten USA-Reise.

Die Trinity

Am 18. Juli 1968 gründeten der Physiker Dr. Robert Norton Noyce und der Chemiker Dr. Gordon Earl Moore, unterstützt vom Hauptinvestor Arthur Rock, die Firma Intel in Santa Clara. Mit dabei wäre gern der wie Noyce und Moore ebenfalls zuvor bei Fairchild arbeitende Chemiker Dr. Andrew Stephan Grove (Geburtsname András István Gróf) gewesen, doch für den 1956 aus dem kommunistischen Ungarn Geflüchteten war es damals kaum möglich, eine Firma in den USA mitzugründen. So musste er sich mit dem Posten als "erster Angestellter" zufriedengeben, immerhin mit Eintrittsdatum 18. Juli 1968. Dennoch bekam er die ID-Nr. 4 und sein von ihm angeworbener ungarischer Landsmann Leslie Vadász die 3, womöglich eine Neckerei der beiden offiziellen Gründer. Nicht dabei haben wollten alle drei einen weiteren Fairchild-Mitarbeiter, der auch gerne mitgemacht hätte, der aber ihnen zu "flamboyant" (extravagant) war: Jerry Sanders. Der war darob richtig wütend und gründete ein Jahr später eine Konkurrenzfirma, mit der Intel noch viel – bis heute – zu tun haben sollte: AMD.

(Bild: Intel )

Noyce war zunächst als Chief Executive Officer mehr für das Geschäftliche zuständig, Moore für die großen Pläne und Visionen und so kümmerte sich Andrew Grove schon früh um das operative Geschäft, wiewohl ihm der offizielle Titel Chief Operating Officer erst 1975 zuerkannt wurde, als sich Noyce vom Tagesgeschäft zurückzog. Er trat den CEO-Posten an Moore ab und wurde Chairman des Aufsichtsrats, den es inzwischen gab. Denn im Oktober 1971, nur drei Jahre nach Gründung, ging Intel unter "INTC" an die Börse NASDAQ (mit 350.000 Aktien à 23,50 US-Dollar).

Die Speicherfirma

Bis dahin war Intel eine reine Speicherfirma – Lästermäuler sagen, dass das auch heute noch der Fall ist, denn moderne Prozessoren bestehen oft zu über 90 Prozent aus Speicher (Caches, Puffer, Register-Files ...). Der allererste Chip namens 3101 war ein Shottky Bipolar-RAM mit 64 Bit, das sich gleich recht gut verkaufte, aber ein richtiger Renner wurde das Produkt Nr. 3 im Jahre des Börsengangs 1971: das DRAM 1103 mit 1 KBit, hergestellt im 10-µm-pMOS. Parallel dazu stellte die Erfindung eines anderen Speicherproduktes die finanzielle Grundlage der nächsten Jahre dar, das per UV löschbare, nicht flüchtige EPROM. Das entwickelte der ebenfalls schon früh von Fairchild zu Intel gekommene Israeli Dov Frohman quasi nebenbei. Eigentlich war er für den Silizium-Prozess und für Qualitätssicherung zuständig, aber die Trinity gab ihm Spielraum für eigene Experimente mit floating gates, auch wenn sie davon wenig verstanden. Merkwürdigerweise blieb sein wichtiger Beitrag für Intel in der Folgezeit wenig beachtet – in der Intel-Biographie von Michael Malon etwa, "The Intel Trinity" werden Frohman und seine EPROMs nicht einmal erwähnt.

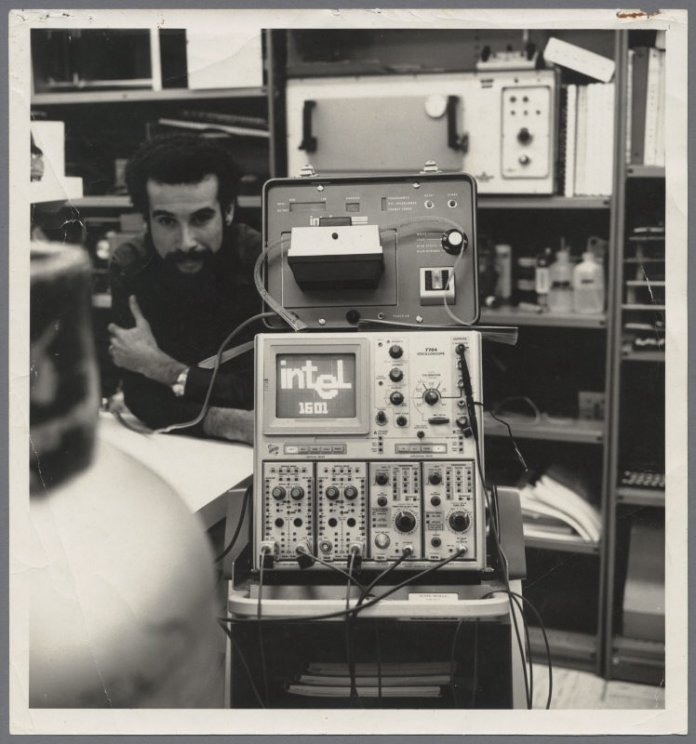

(Bild: Intel)

Dank Speicher und EPROMs bekam Intel den finanziellen Spielraum, sich mit anderen riskanten Entwicklungen zu beschäftigen, insbesondere mit dem Mikroprozessor. Da traf es sich gut, dass die japanische Firma Busicom für ihre Taschenrechner just solche integrierten Chips suchte und 1970 gleichzeitig Intel und Mostek beauftragte. Mostek hatte den MK6010 sogar etwas früher fertig als Intel den 4004, dennoch gilt Intels Chip als der "erste verfügbare kommerzielle Mikroprozessor", und das, obwohl die Patentrechte an dem 4004 zunächst Busicom und nicht Intel besaß. Busicom-Ingenieur Masatoshi Shima hatte zudem einen nicht zu unterschätzenden Anteil an der Entwicklung. Rein rechtlich stünden also Busicom die Lorbeeren des "ersten verfügbaren Mikroprozessors zu", die Firma ging aber 1973 in Konkurs und Intel kaufte die Patentrechte am 4004 zurück.

Dumm nur, dass viele Jahre später, im Jahre 1996, im Rechtsstreit zwischen Texas Instruments und einem weiteren Mikroprozessor-Erfinder namens Gilbert Hyatt, [1] TIs Ingenieur Gary Boone die Ehre der Erfindung des ersten Mikroprozessors vom US Patent Office zugesprochen bekam. Und eigentlich ist das ohnehin alles Pillepalle, denn schon vorher gab es Mikroprozessoren, sogar mit 24 Bit, aber eben nur unter strengster Geheimhaltung fürs Militär.

Bei Intel aber schmückten sich dann Stanley Mazor, Ted Hoff und Federico Faggin mit dieser Ehre und sie zogen 1996 gemeinsam in den National Inventors Hall of Fame ein. Den größten Anteil an der Entwicklung trug dabei Federico Faggin (ebenfalls Ex-Fairchild) – auch wenn Ted Hoff das anders sah. Faggin konnte ich vor ein paar Jahren auf der Hot-Chips-Konferenz kennenlernen und unter anderem ein bisschen über die Anfangszeit mit ihm plaudern.

Er stieg erst 1970 in das schon laufende Projekt "MC4" ein und war dann nicht nur für das Design des vierbittigen 4004 verantwortlich, sondern auch für die Fertigstellung des achtbittigen Nachfolgers 8008. Dann folgten unter seiner Führung noch der 4040 (ein verbesserter 4004) und im Jahre 1974 der breitflächig sehr erfolgreiche 8080-Prozessor. Dafür arbeitete er Tag und Nacht, fühlte sich von Intel für seine aufopfernde Tätigkeit nicht genügend gewürdigt und bei Patenten gar hintergangen. Insbesondere soll auch die von „Mr. Pingelig" Andrew Grove eingeführte "late list" – wer nicht militärisch pünktlich um 8 Uhr im Gebäude war, musste den Grund dafür in einer öffentlichen Liste eintragen – den temperamentvollen Italiener auf die Palme gebracht haben. Auch sein Nachfolger, der spätere Chefentwickler der 8086, Steven Morse (nicht zu verwechseln mit Steve Morse von Deep Purple, den ich voriges Jahr in Hamburg bewundern durfte …) mokierte sich noch lange Zeit später in einem Interview 2008 über diese unwürdige late list.

Intensive Gespräche

In so einer "erstickenden" Atmosphäre wollte Faggin nicht mehr arbeiten und verließ nach einer heftigeren Auseinandersetzung mit Grove Intel am Halloween-Tag 1974. "You son of a bitch" wollte er laut Malone in "The Intel Trinity" Grove zum Abschied noch zurufen, hat sich aber nicht getraut – etliche Jahre später haben sie sich aber wieder vertragen.

Faggin gründete zusammen mit dem Manager Ralph Ungerman und mit einer Finanzspritze von Exxon die Firma Zilog, wo ihm oben erwähnter Masatoshi Shima bei der Entwicklung des Konkurrenzprozessors Z80 half. Die beiden brauchten nur wenige Monate und ihr Z80 wurde ausgesprochen erfolgreich, stahl dem 8080 schnell die Show.

Geräuschvolle Events bei Intel gabs übrigens später des Öfteren. So berichteten Mitarbeiter, dass etwa das "freundliche Gespräc" zwischen Andrew Grove und Microsoft-Chef Bill Gates im gesamten sechsstöckigen Robert-Noyce-Building zu vernehmen war. Es ging dabei um Intels Native Signal Processing (NSP), das Gates als Konkurrenz zu ureigenen Aufgaben des Windows-Betriebssystems sah. Intel lenkte schließlich ein und kippte das NSP-Projekt.

Faggin, Shima und Zilog schafften es allerdings nicht, rechtzeitig einen funktionierenden 16-bittigen Nachfolger des erfolgreichen, 8-bittigen Z80 auf den Markt zu bekommen. Intel setzte hingegen nach dem Grove-Motto "Only the Paranoid survive" alles daran, den 16-bittigen 8086 und seinen kleinen Bruder 8088 noch vor der Zilog- und Motorola-Konkurrenz fertigzustellen.

Mit Glück und Verstand

Und dann kam noch das das Glück hinzu, nämlich dass IBM 1981 recht zufällig diesen kleineren Bruder für den IBM-PC erkor, dessen Erfolg dann unerwartet geradezu durch die Decke ging. IBM verwendete aus Kostengründen den kleinen Bruder 8088 mit 8-bittigem Bus. Dessen in Israel durchgeführte Entwicklung war so streng geheim, dass nicht einmal 8086-Chefarchitekt Steven Morse bis zu seinem Intel-Abschied 1979 davon wusste.

Intel legte dann zügig nach, 80186 (mit integrierter Peripherie) und 80286 kamen 1982 heraus, letzterer war nicht nur ganz erheblich schneller als der 8086 und bot mehr Adressraum, er führte mit dem Protected Mode auch neue Schutztechniken ein, die den Multiuser-Betrieb absichern sollten.

Und dann kam 1985 das ganz, ganz große Ding, der 80386, der die die recht krude 8086-Architektur vom wuseligen 16-bittigen Kopf auf die orthogonalen 32-bittigen Füße stellte. Er setzte sich in einem hausinternen "turf war" gegen eine andere über viele Jahre von Grund auf neu entwickelte 32-Bit-Entwicklung namens iA432 durch, die mit ihrer Performance aber überhaupt nicht in die Pötte kam. Solche hausinternen Konkurrenzkämpfe pflegt Intel seitdem, hieß es damals Hillsboro/Oregon vs. Santa Clara, ist es heute Hillsboro vs. Haifa.

Der 386-Prozessor hatte zwei Väter: John Crawford und Patrick Gelsinger, die beide auch später für den 486 verantwortlich zeichneten und auch an der Entwicklung des Pentium mitwirkten. Gelsinger wurde danach Chief Technology Officer (CTO) und führte das Entwicklertreffen IDF ein, wo ich ihn in aller Regelmäßigkeit traf. Hilfreich waren hier zahlreiche Wetten, die ich mal gewonnen, mal verloren hatte – egal, es war eben ungemein nützlich, um immer ein 1:1 mit Gelsinger zu bekommen. Intels HPC-Chef Raj Hazra verriet mir erst neulich auf der ISC18, dass er es war, den Gelsinger im Jahre 2002 früh morgens um 8 Uhr beauftragte, den verlorenen Wetteinsatz, eine Flasche Wein, zu besorgen, was selbst in San Francisco, einer Stadt die kaum schläft, um diese Uhrzeit nicht ganz einfach ist. Ja ja, ich hatte die Wette gewonnen, denn AMD bekam im Jahr zuvor mehr Patente zuerteilt als Intel und um 9 Uhr war unser Treffen geplant.

(Bild: Andreas Stiller)

Nun könnte man meinen, der große Erfolg des PCs mit seinen vielen Kompatiblen hätte Mitte der 80er Jahre Intels Kasse reichlich gefüllt – aber das Gegenteil war zunächst der Fall. Intel konnte nicht genug liefern, musste günstige Nachbaulizenzen vergeben, investierte in neue Fabs, in Forschung und in die Entwicklung der nächsten Prozessorgenerationen und übernahm sich dabei. In 1985/86 ging's mit dem Profit kräftig bergab und Intel musste erstmals betriebsbedingt Mitarbeiter entlassen.

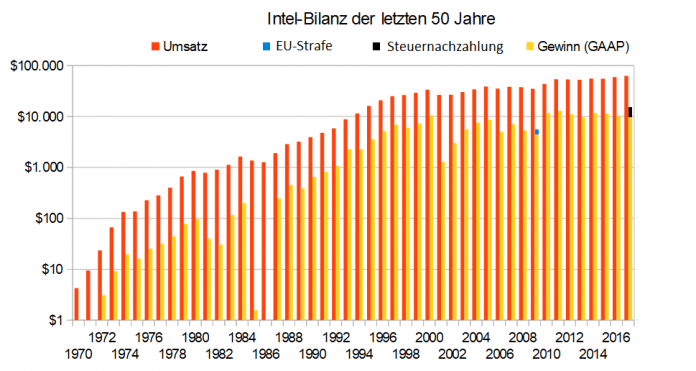

"Wir handelten wie eine 2- bis 3-Milliarden-Firma, statt wie eine mit 1 bis 1,5-Milliarden, die wir geworden sind", lautete Intels Selbstkritik Intel im Annual Report 1986, dem letzten, für den CEO Gordon Moore verantwortlich zeichnete. 1986 war das bislang einzige Jahr, das mit einem Verlust abschloss (rote Zahlen nach GAAP gab's ansonsten nur in zwei Quartalen: 2Q2009, als Intel EU-Strafe einbeziehen musste, und 4Q2017, als das Unternehmen eine immense Steuernachzahlung gemäß der US-Steuerreform entrichten musste). Vielleicht hatte ihm dann der Aufsichtsrat etwas zu viel Sorglosigkeit und zu wenig Geschäftssinn unterstellt. Seinen Posten (und den des Präsidenten) übernahm jedenfalls Andrew Grove; Moore wurde Chairman und Noyce sein Stellvertreter.

Die große Verlade

Mit dem 486 (1989) wurden Cache und Coprozessor integriert, Es gab aber auch eine urige Konstruktion namens 486SX, bei dem optional ein 487-Coprozessor als Zubehör hinzusteckbar war. Beides waren intern jedoch vollständige 486DX-Prozessoren, bei denen man das jeweilige Gegenstück einfach abgeschaltet hatte. Einen Pin beim 487 anders beschaltet, und schon war er ein vollständiger DX. Dieser Marketing-Trick war dann doch etwas zu plump und Intel handelte sich viel Spott und Kritik ein, etwa unter „die große Verlade“ in c't 7/91.

1993 kam der Pentium mit zwei Pipelines, die aber nur synchronisiert und nicht out-of-order arbeiten konnten. Die zweite Pentium-Generation besaß die erste SIMD-Implementierung (Single Instruction Multiple Data) namens MMX. Im Laufe der Jahre sollen dann etliche SIMD-Erweiterungen folgen (SSE, SSE2, SSE3, SSSE3, SSE4, SSE4.1, SSE4.2, AVX, AVX2, AVX512 ...

Der Pentium war noch ausgesprochen gut dokumentiert (ganz im Unterschied zu heutigen Intel-Prozessoren) – bis auf einen geheimen Appendix H. Doch dessen geheime Befehle und Strukturen hatte c't-Autor Christian Ludloff (damals Finanzbeamter in Chemnitz, später x-86-Validator bei Transmeta, inzwischen wie fast alle guten Leute bei Google) auch ohne ihn weitgehend entschlüsselt und nach der Veröffentlichung in c't 11/94 [2] trudelte dann netterweise ein kompletter Appendix H anonym bei uns ein. Wir meldeten das erfreut bei Intel in München, doch dort freuten sie sich eher weniger, aktivierten sofort die Rechtsabteilung, die empört bei uns aufschlug.

Mit Intels Rechtsabteilung hatten wir hinfort noch mehrfach zu tun, etwa nach Tests mit nicht von Intel autorisierten Prototypen. Das schlug zuweilen Wogen bis hin zum Wall Street Journal ("Intel setzt deutsche Presse unter Druck"). Auch zu Dr. Thomas Pabst, der 1997 noch seine Website Tom's Hardware Page als Krankenhausarzt allein von einer Dachstube in England pflegte, schickte Intel die Rechts-Kavallerie, um ihn unter Druck zu setzen. Der internationale Protest half, der Konzern knickte ein und zog sogar personelle Konsequenzen bei Intel Deutschland.

Mit dem Pentium kam noch was anderes Neues auf Intel zu, nämlich der öffentliche Umgang mit Prozessor-Bugs. Der berühmt gewordene FDIV-Bug [3] machte die Runde, nachdem im Oktober 1994 ein Mathematiker auf ihn aufmerksam gemacht hatte und jeder konnte ihn sofort nachvollziehen (das ist heutzutage nur sehr selten der Fall). Zunächst versuchte Intel, den Verrechner beim Dividieren herunterzuspielen ("nur selten und wenn, nur ein bisschen"), aber IBM sah das anders und stellte den Pentium-Vertrieb ein. Das eigentlich Perfide aber war, dass Intel schon länger von dem Bug wusste, ohne es öffentlich mitzuteilen.

Grove zeigte sich geknickt, entschuldigte sich bei der Weltöffentlichkeit, gelobte Besserung und lebenslanges Umtauschrecht und seitdem gibt es die öffentlichen Fehler-Reports "specification updates". Ältere heise-online- oder c't-Leser wissen vielleicht, dass ich als einer von ganz wenigen von diesem lebenslangen Umtauschrecht mehrfach Gebrauch gemacht habe, aber nach dem Tod von Andrew Grove im Jahre 2016 diesen Spaß einstellte (zwei falsch rechnende Pentiums hat c't noch im Museum).

Spekulatives

Während der Pentium noch ein paar Jahre weiterentwickelt wurde, stand seine Ablösung zumindest für den Serverbereich schon 1995 bereit, und zwar mit der komplett neuen Prozessor-Mikroarchitektur P6 und dem damit ausgestatteten Pentium Pro. Unter der Projektleitung von Bob Colwell – die er in seinem Buch "The Pentium Cronicles" spannend und humorvoll beschrieben hat, entstand ein moderner Out-Of-Order-Prozessor mit spekulativer Exekution – die 23 Jahre später mit gewissen grundsätzlichen und zum Teil noch ungelösten Sicherheitsproblemen namens Spectre [4] viel Aufmerksamkeit erregt hat. In Gestalt des Pentium II kam die Architektur einige Zeit später als großes, unhandliches Slot-Modul in die Desktop-PCs.

Doch hier war Konkurrent AMD inzwischen mit dem Athlon sehr erfolgreich. Der Konkurrenzkampf wurde erbittert ausgeführt und der Prozessortakt stieg immer höher. Später verstieg sich Intel sogar zu unfairen Wettbewerbsmethoden gegenüber AMD. Die EU verhängte jedenfalls im Jahre 2009 über eine Milliarde Euro Strafe [5], doch darüber wird auch heute noch gestritten. Mit AMD hat sich Intel aber inzwischen geeinigt und ein weitreichendes Patentaustausch-Abkommen geschlossen – allerdings nur für Patente bis November 2014.

1999 folgte der Pentium III, der vor allem mit seiner individuellen Seriennummer Aufsehen bei allen Datenschützern der Welt erregte. Die sollte per BIOS-Setup abschaltbar sein, doch dann kam ich ins Spiel, indem ich zeigte, dass man sie per ACPI auf den damaligen Boards austricksen und wieder einschalten konnte. "Das musste ja kommen", kommentierte Pat Gelsinger auf dem IDF 1999 gegenüber unserer US-Korresponentin Dr. Sabine Cianciollo.

Die Takterhöhungen beim Pentium III gipfelten dann im Jahre 2000 in der 1,13-GHz-Version. Eine Handvoll Testexemplare wurden weltweit an ausgesuchte Tester verschickt, an c't, Anandtech, an Kyle Benneth von HardOCP und an Thomas Pabst von Tom's Hardware. Die Versionen für c't und Anandtech war offenbar gut vorab gecheckt, denn sie liefen weitgehend problemlos. Die von Thomas und Kyle indes stürzten laufend bei Sysmark 2000 und der Linux-Kompilation ab. Beide mokierten sich in ihren Artikeln [6] darüber kräftig, Intel reagierte und schloss die Kritikaster von Informationen über die nächste Prozessorgeneration Pentium 4 aus – um sich ein paar Wochen später dafür zu entschuldigen und die Probleme zuzugeben.

Intel stoppte die Produktion und schickte den Chef der Mikroprozessorabteilung Albert Yu, der 30 Jahre zuvor ebenfalls von Fairchild zu Intel gekommen war, in die Wüste. Das war dann schon der Job von CEO Craig Barrett, denn Andrew Grove hatte aus Gesundheitsgründen den CEO-Posten im Mai 1998 abgegeben. Ein paar Jahre zuvor war bei ihm Prostata-Krebs diagnostiziert worden, unheilbar hieß es – doch Grove wollte es nicht glauben, investierte einen großen Teil seines Vermögens in die Krebsforschung und hatte Erfolg. Mit den neuen Erkenntnissen und Heilmethoden konnte sein Krebs besiegt werden, Grove überlebte ihn jedenfalls um über 20 Jahre.

Der Taktwettkampf bei den Desktop-Prozessoren hatte bei Intel aber noch andere katastrophale Folgen, er läutete nämlich bereits das Ende der 64-Bit-Architektur Itanium ein, bevor diese überhaupt in Gang gekommen war – denn diese konnte performancemäßig überhaupt nicht mithalten. Aber wegen eines milliardenschweren Vertrages mit Hewlett Packard wurde Itanium aus politischen Gründen bis hin zum vorigen Jahr am Leben erhalten. P6-Schöpfer Colwell versuchte vergeblich, Craig Barrett vom Unsinn des Itaniums zu überzeugen – vergeblich. "Er hörte überhaupt nicht zu", erzählte Colwell später. Colwell und viele weitere Intel-Urgesteine kamen mit dem "Kulturschock" Barrett nicht klar und verließen daher Intel kurz nach dessen Amtsantritt als CEO.

Hammerschläge

Und dann kam es Dicke für Intel. War schon die Athlon-Präsentation von Ex-DEC-Alpha-Entwickler Dirk Meyer auf dem Microprocessor Forum 1998 ein heftiger Schlag ins Kontor, so wurde es 1999 noch heftiger. Getarnt unter dem vergleichsweise harmlosen Titel "ein Prozessor der Athlon-Familie für Workstations und Server" trumpfte AMD-CTO Fred Weber auf und offenbarte überraschend das 64-bittige Hammer-Design – sicherlich eines der Highlights aller Microprocessor-Foren überhaupt.

(Bild: Andreas Stiller)

Intel-Entwickler Harsh Sharangpani hatte zuvor ein paar wenig aussagekräftige Informationen zum ersten Itanium-Prozessor Merced zum Besten gegeben. Damit auf dem Forum überhaupt noch über Itanium gesprochen werden sollte, kopierte Intel in einer Nacht-und-Nebel-Aktion noch ein paar weitere Informationen und verteilte die Kopien am nächsten Tag. Zwei Jahre später auf dem Microprocessor Forum 2001 legte Fred Weber nochmal nach, mit konkreten Details für den ersten Opteron, mit seinem integriertem Speichercontroller, mit Hypertransport-Interfaces und mit ersten Benchmarkergebnissen von SPEC 2000. Und wieder saß ich neben einem führenden Intel-Architekten (seinen Namen soll ich auf dessen Wunsch nicht nennen). Erkennbar aufgeregt fragte er mich nach den Einzelheiten der nur kurz gezeigten SPEC-Ergebnisse, die ich natürlich (mit meiner ersten Digital-Kamera) fotografiert hatte.

Der Itanium hatte es also von Anfang an schwer und als die erste Version Merced im Jahre 2001 erschien, lachte die Welt ob seiner Performance, insbesondere die der x86-Hardware-Emulation. Ein Sysmark-Durchlauf ging gar nicht, brach wegen Timeouts ab – mit so etwas langsamem hatten die Benchmarkentwickler nicht gerechnet. Auch Pat Gelsinger, so hörte ich später, war vom Itanium alles andere als überzeugt – aber offenbar auch nicht wirklich vom Design-Weg des Pentium 4. Dieser Pentium 4 war ein Design, das sich signifikant vom P6 unterschied. Er arbeitete mit einer langen Hyper-Pipeline, die mit sehr hohem Takt lief. Hinzu kam neue Cache-Technik und eine "double pumped ALU". Auf der ISSCC 2001 zeigte aber Gelsinger auf, dass dieser Weg noch innerhalb der Dekade auf Energiedichten hinausliefe, die nicht mehr handhabbar sind, Energiedichten, die in Kernreaktoren oder auf der Sonnenoberfläche üblich sind. "Ich glaube nicht, dass wir einen 5000-Watt-Chip kühlen können." Und so kam es denn auch: Der Pentium 4 lief schon gegen die Power-Wand, als 2004 die Prescott-Version herauskam. Erschwerend kam hinzu, dass der geplante Herstellungsprozess mit 157-nm-Lasern abgeblasen wurde.

Rettung aus dem heiligen Land

Wie gut, dass Intel da noch die Entwicklung aus Haifa in der Hinterhand hatte. Hier war ein paar Jahre zuvor das Projekt Timna grandios gescheitert, das mit integriertem Grafikcontroller und Speicherinterface ausgestattet sein sollte, allerdings für Rambus. Doch Intel gab sehr zum Schrecken von Israel seine Rambus-Pläne auf. Ich habe noch ein paar unveröffentlichte Benchmarkwerte eines Timna-Boards, das ich ohne Intels Segen vermessen konnte (die waren aber nicht so toll). Die Entwickler in Haifa widmeten dann ihre Design-Erfahrungen dem energiesparenden Mobil-Prozessor Pentium M, wie Timna mit alter P6 Architektur – und das Design wurde später, in "Core" umgetauft, der große Rettungsanker für Intel. Da war dann schon der neue CEO Paul Otellini im Amt, der im vorigen Herbst überraschend gestorben ist.

Im Tick-Tock-Stil kam dann in jedem Jahr entweder eine verbesserte Mikroarchitektur oder ein neuer Herstellungsprozess – Nehalem, Westmere Sandy Bridge, Ivy Bridge, Haswell, Broadwell, Skylake – doch die Tick-Tock-Maschine ist dabei etwas ins Stocken geraten; nach Tick-Tock kam Tick-Tock-Tock und jetzt Tick-Tock-Tock-Tock. Jeder neue Prozessschritt wird nunmehr in drei Teilschritte zerlegt, etwa beim stark verspäteten 10-nm-Prozess in 10 nm+ und 10 nm++.

Parallel zu Core 2 wurde im Jahre 2008 Intels Atom-Linie begonnen, gedacht für kleine Notebooks, Netbooks, Tablets, Mikroserver und Smartphones. Doch bei den Smartphones hatte Intel trotz großen Aufwandes so gut wie keinen Erfolg und gab schließlich den Markt auf. Auch im Internet of Things ruderte Intel zurück und kündigte die die Joule-, Edison- und Curie-Prozessoren ab. Und nun verkaufte der Konzern konsequenterweise vor ein paar Wochen auch den Embedded Spezialisten Wind River.

Auch mit einer anderen Altlast schloss Intel derweil ab. Seit etwa 2005 arbeitete Intel am Projekt Larrabee, das Nvidia und AMD auf dem Grafikmarkt Paroli bieten sollte. Als sich abzeichnete, dass das nicht klappen würde, wurde das Projekt in einen Beschleuniger für High Performance Computing umgewidmet. Der Xeon Phi Knights Landing (x200 Family) hatte dann auch hier und da Erfolge, aber der geplante Nachfolger in 10-nm-Technik blieb aus. Stattdessen baute Intel eine für Deep Learning umdesignte Variante namens Knights Mill (x205 Family), und kündigte im letzten Herbst die restliche Xeon-Phi-Linie ab.

... und die Zukunft?

Ob denn der Knights-Mill-Mohikaner in nennenswerten Mengen verkauft wird, muss aber bezweifelt werden – auf der ISC18 war von ihm weit und breit nichts zu sehen, wer will denn auch noch für eine tote Prozessorlinie entwickeln? Vielmehr hat Intel für den PC-Bereich was viel Besseres in petto, einen speziellen Xeon ISX-H für HPC mit zwei Chips im Gehäuse, ein jeder mit bis zu 22 Kernen.

HPC, Server und Cloud sind für Intel ganz wichtige Erfolgsgaranten für die Zukunft, dort, wo es den Markt bislang noch nach Belieben beherrscht und Umsatzsteigerungen wie zuletzt im ersten Quartal 2018 um 24 Prozent auf nunmehr 5,2 Milliarden Dollar gewöhnt ist. Wenn das so weitergeht, könnte die Data Center Group die Client Computing Group (Notebooks, PCs) in etwa drei Jahren überholen.

Mögliches Unheil droht aber noch durch weitere Sicherheitsprobleme, die möglicherweise erhebliche Verzögerungen nach sich ziehen können. Das sogenannte Spectre-Problem ist noch lange nicht ausgestanden. Auch nach der kürzlich offengelegten Schwachstelle harren noch weitere, zum Teil deutlich härtere Kaliber von Spectre NG ihrer Veröffentlichung.

Zunächst aber muss Intel dringend einen Nachfolger für Brian Krzanich [7] finden, der seit 2013 die CEO-Position innehatte. Die erste Wahl, Pat Gelsinger, hat auf Twitter schon abgewinkt – er sei glücklich als CEO von VMware und geht nirgends woanders hin, die Zukunft sei Software (naja, die hat Intel ja auch, etwa die Compiler). Ich hätte ja als Rentner jetzt Zeit ... und wünsche auf jeden Fall: Happy Birthday Intel.

Danksagung

...an alle Intel-PR-Leute, die mich in den 35 Jahren ihrer 50-jährigen Firmengeschichte ertragen mussten, beginnend Mitte der 80er Jahre mit Dr. Jens Bodenkamp, Dr. Heiner Genzken, Hans-Jürgen Werner, Christian Anderka, Martin Strobel, Thomas Kaminski, Florian Ranner, Christoph Schierstaedt, Monika Lischke, Markus Weingartner, Marlo Thompson, Andreas Dott, Olaf Höhne, Klaus Obermeier, Nina Babnik, Belinda Adkisson, Belinda Liviero, Alistair Kemp, Georg Alf, Dan Snyder, Marny Varna, James Reinders, Heinz Bast, Herbert Cornelius und in Erinnerung an Greg Wagnon und Larry Gray und viele mehr … (as [8])

URL dieses Artikels:

https://www.heise.de/-4111405

Links in diesem Artikel:

[1] https://www.heise.de/blog/Prozessorgefluester-284632.html

[2] https://shop.heise.de/katalog/zwischen-den-zeilen-1

[3] https://www.heise.de/news/20-Jahre-FDIV-Bug-Ein-Prozessor-Rechenfehler-macht-Geschichte-2438283.html

[4] https://www.heise.de/news/FAQ-zu-Meltdown-und-Spectre-Was-ist-passiert-bin-ich-betroffen-wie-kann-ich-mich-schuetzen-3938146.html

[5] https://www.heise.de/news/EU-Kommission-verhaengt-1-06-Milliarden-Euro-Geldbusse-gegen-Intel-Update-218689.html

[6] https://www.tomshardware.com/reviews/intel,219.html

[7] https://www.heise.de/news/Unangemessene-Mitarbeiter-Beziehung-Intel-CEO-Krzanich-tritt-zurueck-4089393.html

[8] mailto:as@ct.de

Copyright © 2018 Heise Medien