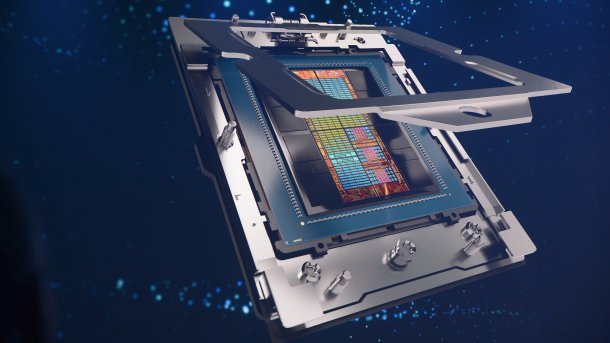

AMD MI300: A-CPU mit Zen-4-Kernen, CDNA3-Beschleuniger und mehr

AMD hat weitere Details zur Instinct MI300 preisgegeben. Es gibt die A-CPU genannte Beschleuniger-Kombination als MI300A und die CPU-lose Version MI300X.

(Bild: AMD)

AMD teilt Intels Ansicht, die meisten KI-Workloads würden heute noch von CPUs gestemmt. KI sei der nächste Schritt in der Umwälzung von Rechenzentren und "Megatrend #1", sagte AMD-Chefin Lisa Su am Dienstag bei einer hauseigenen Veranstaltung in San Francisco. Allein für Rechenzentren erwartet AMD einen 150 Milliarden US-Dollar schweren Markt im Jahr 2027.

Die damit verbundenen Aufgaben wie KI-Training müssten wesentlich schneller und zugleich effizienter vonstatten gehen. Dennoch oder gerade deshalb geht AMD mit MI300 einen Weg, den Intel mit Falcon Shores gerade verlassen hat: Die Kombination von CPU- und Beschleuniger-Kernen in einem Multi-Chip-Modul für die SP5-Fassung. Diese A-CPU-Version MI300A, die als High-Performance-Computing- und KI-Beschleunigerversion gedacht ist, wird bereits geliefert, wenn auch nur in Mustermengen. Sie hat 24 Zen4-Kerne und 128 GByte schnellen Stapelspeicher vom Typ HBM3.

(Bild: c't)

AMD hält sich allerdings alle Optionen offen und will im dritten Quartal 2023 die Instinct MI300X, also die reine Beschleunigervariante mit bis zu 192 GByte HBM3-Stapelspeicher, im Rahmen der Bemusterung an Kunden verschicken. Die sei bei der Herstellung mit einer vergleichsweise einfachen Abwandlung zu produzieren: Ein Quadrant der CDNA3-Beschleunigerkerne wird gegen einen mit Zen-4-Kernen ausgetauscht. Dafür fällt allerdings ein Drittel des HBM-Speichers weg, sodass MI300A "nur" noch 128 GByte hat.

MI300A hat 146 Milliarden Transistoren, 78 Prozent mehr als Bergamo-Epyc-CPUs, und MI300X gar 153 Milliarden. Das würde gut zu der geplanten Verwendung im für 2024 erwarteten 2-Exaflop-Supercomputer El Capitan passen, der auf die MI300 als Hauptrechenleister setzt. Der Bau El Capitans soll noch in diesem Jahr beginnen. Ein Zweisockelsystem als Basis der meisten Supercomputer könnte mit zwei MI300A und sechs oder gar acht MI300X enorme Leistungsdichte bekommen.

192 GByte HBM3 und effizient bei KI-Berechnungen

Durch bis zu 24 GByte pro HBM3-Chipstapel kommt ein MI300-Modul mit acht HBM3-Chips auf bis zu 192 GByte. Die müssen sich, anders als beim Vorgänger, nicht einmal auf zwei separate GCDs inklusive Inter-GCD-Flaschenhals aufteilen, sondern können von jedem Rechenwerk mit voller Geschwindigkeit von 5,218 TByte/s genutzt werden. Bisher waren 3,9 TByte/s bei Nvidias H100 NVL das Höchste der Gefühle. Ob die einzelnen CDNA3-Chiplets inzwischen ohne Umweg über den Interconnect mit dem Speicher kommunizieren können, die gigantische Transferrate also ohne weiteres nutzbar ist, blieb zunächst offen.

[Update 15.06.2023] Auf Nachfrage von c't bestätigte Brad McCredie, AMD Vice President of Data Center and Accelerated Processing bei AMD, dass dies der Fall sei und alle CDNA3-Recheneinheiten mit voller Geschwindigkeit auf den HBM3-Speicher zugreifen können. MI300(X) wird, anders als der Vorgänger MI250(X), als einzelnes Gerät ansprechbar sein. Bei der MI250(X) war die Programmierung noch durch die langsame Verbindung zwischen den beiden GCDs erschwert und durch die Tatsache, dass sich beide als einzelne OpenCL-Geräte präsentierten.

Videos by heise

Bereits zuvor hat AMD mit einer Verbesserung der KI-Trainingseffizienz um Faktor 8 gegenüber dem Vorgänger geworben. Auf der Bühne sagte AMD-Chefin Su am Dienstag hierzu nichts Genaueres, verwies aber auf die geringere Anzahl MI300, die für das Training von KI-Modellen wie Falcon-40B von HuggingFace nötig seien. Alllein dadurch seien MI300-System bereits effizienter.

(Bild: c't)

AMD Infinity Architecture Platform

Datenmengen gehen durch die Decke - nicht nur bei KI-Anwendungen wie ChatGPT und deren Training. Die Steigerung lässt schon jetzt viele KI-Modelle die Speichergrößen der Beschleuniger sprengen. Dass möglichst viel in einem Speicherbereich läuft, ist aus Effizienzgründen sinnvoll, denn eine Verteilung über weitere Knoten bremst die Performance, womit das Trainings länger dauert. Und je mehr Rechner oder Serverschränke beteiligt sind, desto größer sind Leistungsaufnahme und damit die laufenden Kosten.

Auch die 192 GByte für ein MI300-Modul sind irgendwann voll belegt, dafür will AMD die standardisierte Infinity Architecture Platform nutzen. Damit sollen bis zu acht MI300 ihre Speicher gemeinsam verwalten und nutzen können ("kohärent") und dabei mit bis zu 896 GByte/s untereinander kommunizieren. Ähnliches gab es bereits in der Vorgängergeneration Instinct MI250X, wenn auch in langsamerer Form; Konkurrent Nvidia hat für seine A100- und H100-Beschleuniger via NVLink Vergleichbares im Programm.

MI300 - angekündigt im Juni 2022

Vor rund einem Jahr hat AMD nach jahrelanger Wartezeit seinen ersten Kombiprozessor der High-Performance-Computing-Klasse angekündigt. Der Instinct MI300 verwendet einen Verbund aus flotten Zen-4-Kernen und einer CDNA3-GPU mit massig Rechenleistung samt gemeinsam nutzbarem HBM-Stapelspeicher. 3D-gestapelte Chips gibt es obendrauf.

Die CPU und GPU bestehen aus mehreren Chiplets, an die die HBM3-Stacks gekoppelt sind. Bereits eines der Renderbilder ließ erahnen, dass der Träger Platz für acht Speicherbausteine hat. Mit HBM3 sind damit bis zu 192 GByte RAM mit einer Übertragungsgeschwindigkeit jenseits der 5 TByte/s möglich.

(csp)