Die Zukunft der Archive: Die hohen Hürden bei der Datenarchivierung

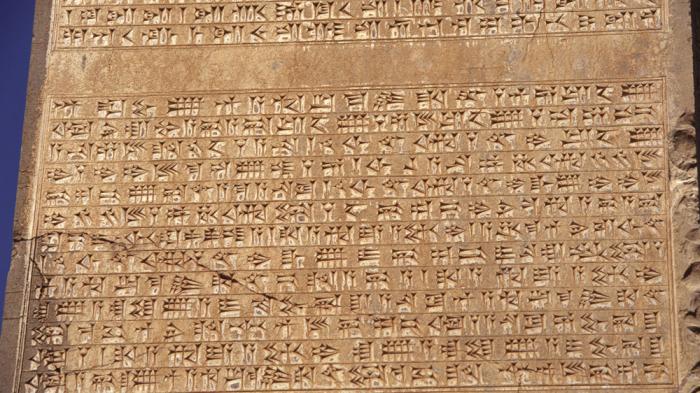

Keilschrifttafel aus Persepolis

(Bild: Nickmard Khoey, Persepolis, CC BY-SA 2.0)

Eine ansteigende Flut digitaler Kulturgüter fordert Archive, Bibliotheken und Museen heraus. Was wird getan, um dieses kulturelle Erbe zu bewahren?

Wer kennt das nicht: Nach einem Systemupdate verweigern Anwendungen den Dienst, in veralteten Formaten gespeicherte Daten lassen sich nicht mehr öffnen, Datenträger sind beschädigt oder es fehlt das passende Lesegerät. Geläufig ist auch die Erfahrung, dass digitale Medien die Erinnerungskultur verändern: Vergangene Ereignisse sind in Chatverläufen, Timelines und Online-Fotoarchiven anders präsent als in klassischen Briefwechseln und Fotoalben. Auch hier droht Datenverlust: Dienste in der Cloud können etwa ihr Geschäftsmodell ändern oder gar den Betrieb einstellen.

Die Sorge um Datenverlust und der Wunsch, zukunftsfähige Nutzungsmöglichkeiten von Daten und Anwendungen zu entwerfen, treiben auch Archivare, Museumskuratoren und nichtinstitutionelle Aktivisten um. Ende November haben sie sich an der Deutschen Nationalbibliothek in Frankfurt am Main auf einer Konferenz [3] versammelt, um über die "Bewahrung des digitalen kulturellen Erbes" zu diskutieren. Diese Konferenz ist Ausgangspunkt der vorliegenden dreiteiligen Serie.

Venus von Willendorf vs. Super Mario

(Bild: Matthias Kabel, CC BY-SA 3.0 [4] )

Archäologische Funde wie die Venus von Willendorf, Höhlenbilder oder sumerische Keilschrifttafeln bieten auch nach Tausenden von Jahren die Möglichkeit zur Untersuchung vergangener Kulturen. Wesentliche Teile der heutigen Kultur sind jedoch nicht in Stein gemeißelt oder in Ton geprägt. Sie manifestieren sich im zunehmend komplexen, im steten Wandel begriffenen Zusammenspiel von digitaler Hard- und Software, von Datenströmen, Dateiformaten und Netzwerkprotokollen. Was davon wird bleiben und zukünftigen Forschergenerationen die Möglichkeit zur Interpretation bieten? Welche Anstrengungen unternehmen die Kulturbewahrer zur Erhaltung, wo besteht Handlungsbedarf?

Empfohlener redaktioneller Inhalt

Mit Ihrer Zustimmung wird hier eine Vimeo-Video (Vimeo LLC) geladen.

Ich bin damit einverstanden, dass mir externe Inhalte angezeigt werden. Damit können personenbezogene Daten an Drittplattformen (Vimeo LLC) übermittelt werden. Mehr dazu in unserer Datenschutzerklärung [5].

Wer diese Fragen angeht, sieht sich mit einer kaum überschaubaren Vielfalt an digitalen Kulturgütern und einer Gemengelage aus konzeptionellen, technischen und nicht zuletzt urheberrechtlichen Fragen konfrontiert. Aktivisten wie der Gründer des Internet Archive, Brewster Kahle [6], oder Stefano Zacchiroli von Software Heritage [7] lassen sich nicht bange machen, ihr etwas hemdsärmelig anmutender Optimismus scheint notwendig: Kahle strebt an, "das gesamte Wissen der Menschheit" frei verfügbar bereitzustellen, und Zacchiroli verfolgt das Ziel, "allen Quellcode, der jemals geschrieben wurde zu sammeln, zu konservieren und zu teilen".

Retrodigitalisierung vs. "born digital"

Ein grundlegendes Merkmal digitaler Archivalien betrifft die Frage, ob diese ursprünglich in analoger Form vorgelegen haben. Das können etwa Digitalisate von historischen Handwerkzeugen und Skulpturen, gedruckten Büchern, Ölgemälden und Bleistiftzeichnungen, 35mm-Filmen, Tonbändern und Schallplatten sein. Man spricht hier auch von Retrodigitalisierung. Inhalte, die, wie Computerspiele, CAD-Daten, Datenbanken und Instagram-Stories, von vornherein digital sind, bezeichnet man als "born digital".

Speichern ist nicht gleich Archivieren, die Arbeit des Archivars beschränkt sich nicht auf das bloße Befüllen seiner Bestände. Die Konzeption und Bereitstellung von Zugriffsmöglichkeiten und Werkzeugen zur Arbeit mit den Inhalten ist wesentlich, denn: Digitale Archive erleichtern nicht nur den Zugriff aus der Ferne und ersparen so manche Forschungsreise. Sie bieten auch die Möglichkeit, Forschungsfragen mittels datenwissenschaftlicher Methoden anzugehen. Sogenannte digitale Geisteswissenschaften untersuchen etwa Aufkommen, Verbreitungsmuster und Kontexte bestimmter Begriffe in Hunderttausenden von Zeitungsartikeln oder Büchern.

Ohne Metadaten läuft nichts

Ob retrodigitalisiert oder born digital: Unabdingbar ist die Anreicherung der Archivalien mit Metadaten, die etwa technische Eigenschaften und Kontexte abbilden. Die Bedeutung von Kontextinformationen ist schon für Hobbyfotografen unmittelbar einsichtig: Wann, wo und von wem wurde ein Bild gemacht? Das lässt sich nicht ohne Weiteres der Datei selbst entnehmen.

Auf dem Weg ins digitale Archiv müssen Metadaten teils händisch, teils in automatisierten Prozessen hinzugefügt werden. Die Bestimmung von Auswahl und Struktur der Metadaten ist alles andere als trivial, denn sie formiert die Möglichkeiten zukünftiger Forschungsfragen.

Bei born-digital-Inhalten ist zudem häufig eine Migration nötig. Gründe dafür sind zum einen die Vermeidung proprietärer oder veralteter Formate zugunsten solcher, die auf offenen Standards basieren. Zum anderen reduziert Migration die vorliegende Formatvielfalt. Ein Artefakt bleibt also bei der Übersiedelung ins digitale Archiv nicht identisch.

Interpretation und Rekonstruktion

Die bereits erwähnte Venus von Willendorf ist mit einem Alter von etwa 30.000 Jahren einer der ältesten erhaltenen Kunstgegenstände der Menschheitsgeschichte. Die Kalksteinfigur hat diesen langen Zeitraum absichtslos überdauert und ist durch glücklichen Zufall gefunden worden. Die absichtliche, gar organisierte Bewahrung von Wissen und Kultur ist wesentlich jüngeren Datums. Doch auch die Überlieferungsgeschichte etwa von antiken literarischen Texten und Urkunden ist wechselvoll und von Zufall, Vergessen, Verlieren, Verschütten und Wiederentdecken geprägt.

Die Interpretation eines archäologischen Fundes wie einer Keilschrifttafel versucht, den Bedeutungs- und Funktionszusammenhang zu rekonstruieren, in dem dieses Objekt gestanden haben mag. Eine einzelne Diskette mag zwar künftigen Archäologen Anlass zu Überlegungen geben – das Eigentliche, sprich: der Inhalt, bleibt verborgen. Der funktionale Zusammenhang, in dem die Diskette gestanden hat – sprich: Laufwerk, PC, Betriebssystem, Treiber und Anwendung muss man im Prinzip vollständig rekonstruieren, bevor eine tiefer gehende Interpretation überhaupt möglich ist.

Ein Kontinuum technischer Zivilisation

Im Hinblick auf das digitale kulturelle Erbe können wir uns auf keinen Zufall verlassen, absichtslose Überlieferung wird es hier nicht geben. Eine funktionierende Überlieferung ist unabdingbar geknüpft an das Fortbestehen einer Zivilisation, die Digitaltechnik beherrscht. Dieser vielleicht banale Gedanke gewinnt an Tiefe, wenn man sich die Paradoxie vor Augen führt, dass die heute entwickelten Tools zur Archivierung und Bereitstellung digitaler Artefakte selbst digitaler Natur sind. Hinzu kommt, dass die gesamte benötigte Infrastruktur digitaler Archivierung in einer technischen Umwelt operiert, die kontinuierlichem Wandel unterworfen ist und daher beständiger Pflege und Entwicklung bedarf, um in Funktion zu bleiben.

Wenn auch klassische Archive und Bibliotheken bereits Orte von Austausch und Wissensproduktion waren, erleben wir mit dem digitalen Wandel eine Dynamisierung dessen, was ein Archiv sein kann und sein sollte. Digitale Archive prozessieren fortlaufend die in ihnen gespeicherten Informationen, fortlaufend sind neue Tools zum Abruf und zur Verarbeitung der Daten in Entwicklung. Ein digitales Archiv, das seine Prozesse nicht beweglich hält und zukünftige Entwicklungen nicht adressiert, ist mittelfristig so gut wie tot.

Freiburger Datenforensik

Einige der eben abstrakt beschriebenen Herausforderungen demonstrierten zwei Konferenzteilnehmer äußerst plastisch an konkreten Beispielen. Dirk von Suchodoletz (Rechenzentrum der Universität Freiburg) stellte ein datenforensisches Projekt vor. Er zeigte, mit welchen Schwierigkeiten Forscher zu kämpfen haben, wenn sie sich mit digitalen Karteileichen konfrontiert sehen, die einen geordneten Archivierungsprozess verpasst haben.

Gegenstand der Bemühungen war ein Konvolut von 17 8-Zoll Disketten aus einem sportmedizinischen Forschungsprojekt der Achtzigerjahre. Zum Erstellungskontext aus Soft- und Hardware lagen keine Informationen vor, geschweige denn ein passender PC nebst Laufwerk und entsprechenden Treibern.

Ein originalverpacktes Laufwerk wurde per Ebay beschafft, zudem ein älterer PC mit Disketten-Controller. Ein aktiver Adapter vom US-Hersteller D Bit komplettierte das Setup, das mit einem Linux System und Tools wie BitCurator und Linux Disk Utilities bestückt wurde.

Auf der Suche nach einem Signal

Erste Tests mit diesem Setup und sicherheitshalber einer unbeschriebenen Diskette fielen ernüchternd aus. Zwar regte sich das Laufwerk, aber essentielle Kommandos brachen mit Fehlermeldungen ab. Immerhin zeigte eine Messung per Oszilloskop direkt am Schreib- und Lesekopf des rotierenden Laufwerks ein ermutigend strukturreiches Signal auf den fraglichen Disketten.

Nach einigen weiteren erfolglosen Versuchen mit Catweasel [8] und anderen Tools gelang dem Elektrotechniker Willibald Meyer vom Rechenzentrum der Durchbruch: Anhand von mit KryoFlux [9] extrahierten Magnetisierungsmustern konnte er das tatsächliche Aufzeichnungsformat und die Struktur der Sektoren auf den Disketten identifizieren.

Schlussendlich konnten die auf den Disketten vorhandenen Textdateien gelesen werden. Die Entschlüsselung der Forschungsdaten hingegen stellte sich als ein unlösbares Problem heraus. Dieses Scheitern verweist auf ein verbreitetes Problem bei explizit für Forschungsprojekte entwickelten Anwendungen und Dateiformaten mit mangelhafter oder fehlender Dokumentation.

Rekonstruktion in Freiburg (7 Bilder) [10]

Christian Keitel vom Landesarchiv Baden-Württemberg bot Einblicke in den Umgang staatlicher Archive mit dem Thema Digitalisierung. Außerdem nannte er einige konkrete Beispiele für schwierige Migrationsprojekte, etwa bei Datenbanken: "Wenn man etwa einen Komplex von 700 Tabellen bekommt, die zahlreiche Verknüpfungen aufweisen, und diesen in künftige Formate überführen will, weil man der Meinung ist, mit Oracle oder mit Db2 lässt sich die Langzeitarchivierung nicht so gut machen: Dann ahnt man, das Komplexität ein Problem ist. Nun sind diese Systeme nicht allein. Sie sind verknüpft mit vielen anderen Systemen, die ihrerseits auch gerne mal aus hunderten von Tabellen bestehen."

Damit nicht genug: Die Systeme tauschen Daten miteinander aus. Vorgaben wie die Gewerberegisterordnung definieren zudem, welche Behörden Abzüge unterschiedlicher Vollständigkeit bekommen. Diese Behörden wiederum verändern die Daten und vermischen und verknüpfen sie mit Daten aus anderen Quellen. In diesen Prozessen sind auch proprietäre Anwendungen verschaltet. "Spätestens jetzt hat die Angelegenheit einen Komplexitätsgrad erreicht, die eine Erhaltung in Gänze unmöglich macht. Wir müssen uns Fragen nach Bewertung und Auswahl stellen."

Einblicke ins Landesarchiv Baden-Württemberg (4 Bilder) [12]

Ausblick

Angesichts der von Keitel und von Suchodoletz präsentierten eindrücklichen Beispiele möchte man der Forderung von Peter Leinen (Deutsche Nationalbibliothek) zustimmen: "Wir sollten die gesamte Entwicklung unserer IT auf negative Folgen für die langfristige Bewahrung der Datenbestände prüfen."

Es wird deutlich, dass proprietäre Formate und Anwendungen ein kapitales Problem für die digitale Langzeitarchivierung darstellen – ein Gedanke, der Wasser auf die Mühlen all jener ist, die konsequenten Einsatz von Open Source im öffentlichen Dienst fordern.

Auf der Konferenz war allenthalben der Wunsch nach mehr Kooperation und Erfahrungsaustausch zwischen den Akteuren der Digitalen Langzeitarchivierung zu vernehmen. Im deutschen Sprachraum ist hier der Kooperationsverbund Nestor [14] aktiv. Kooperation ist in der Tat angebracht, denn so fruchtbar die aktuelle Vielfalt an Bemühungen ist: Langfristig scheinen allgemeingültige Standards notwendig, etwa für Archivierungsprozesse, Dokumentation von Suchwerkzeugen und die Struktur von Metadaten.

In den weiteren Teilen dieser Serie wird es um Web- und Quellcodearchivierung, Computerspiele, Emulatoren und die funktionale Instandhaltung von historischer Hardware gehen.

"Wir brauchen Mut zu unfertigen Projekten"

Interview mit Ina Blümel [15] vom Open Science Lab der Technischen Informationsbibliothek Hannover

heise online: Sie haben ursprünglich Architektur studiert, arbeiten aber nun in Bereichen wie Open Science und digitale Bibliotheken. Wie sind Sie auf diese Themen gestoßen?

(Bild: Ralf Rebmann, CC BY-SA 4.0 [16] )

Ina Blümel: Ende der Neunziger habe ich angefangen, mich mit digitalen Repräsentationsformen von Architekturinformation zu befassen. Etwa mit Animationen, wo man mit virtuellen Kameras durch im Rechner entworfene Architekturen fahren kann. Da ging es nicht mehr um Strichstärken oder Papierwahl, sondern darum: Wie bekomme ich eine Datenmenge X mit einer Bandbreite Y hinreichend gut ausgeliefert, muss ich Abstriche im Detaillierungsgrad machen? Und es ging auch um die Frage, ob wir im Digitalen das Analoge nur kopieren oder ob wir schon in Informationseinheiten denken, die eine weitere digitale Verarbeitung möglich machen. Diese Diskussion gibt ja immer noch, wenn man zum Beispiel an PDF denkt, wo nur das Analoge nachgebaut und auf viele Möglichkeiten digitaler Formate verzichtet wird.

Schließlich habe ich der klassischen Architektur den Rücken gekehrt und mich verstärkt Fragen der Digitalisierung gewidmet. Beim Büro Digitales Bauen in Karlsruhe habe ich im Team mit Architekten, Ingenieuren und Informatikern gearbeitet. Wir haben versucht umzusetzen, was heute im Prinzip von jeder Building Information Modeling Software (BIM [17]) geleistet wird. BIM-Werkzeuge bieten völlig neue Planungsmethoden: Weg von der 2D-Zeichnung mit Grundrissen, Schnitten und Ansichten, hin zum Planen in 3D mit Referenzobjekten wie Wänden, Fenstern, automatischen Auswertungen und so weiter.

Später kam ich an die Technische Informationsbibliothek in Hannover. Anlass war das Projekt Probado (prototypischer Betrieb allgemeiner Dokumente). Wir wollten Workflows entwickeln, die neben textbasierten Inhalten auch Dokumente wie Audiodateien oder eben 3D-Modelle integrieren können. Das waren zunächst ganz dumme Modelle, etwa Dreiecksmeshes. Da mussten wir die Informationen mühsam rausholen, etwa mit Textbausteinen beschreiben, was das Modell überhaupt darstellt. Das sollte möglichst maschinell geschehen, denn Millionen Modelle lassen sich nicht händisch erfassen. Die im Projekt entworfenen Interfaces sollten nicht nur die Suche per Strings, sondern auch ausgehend etwa von Zeichnungen oder einem Raumverbindungsgraphen bieten.

Ein Schwerpunkt ihrer Dissertation ist das Thema Linked Open Data. Was hat es damit auf sich?

Bis vor ca. zehn Jahren hatten sich Bibliotheken damit begnügt, für jedes Item, ob digital oder nicht, ein sogenanntes Recordset anzulegen, also Autor, Titel, Stichworte zum Inhalt usw. Im Analogen und bei Zugriffsformen wie Zettelkästen reicht das aus, aber im Digitalen kann ich ja auch explorativ, also ungerichtet durch Autoren, Werke, Begriffe navigieren. Dazu brauche ich eine andere Repräsentation als Key-Value-Paare. Linked Data basiert auf Information, die in Subjekt-Prädikat-Objekt-Aussagen umgesetzt sind, und benutzt persistente Identifikatoren für die beschriebenen Dinge. Wir benutzen das heute alle intuitiv, meine Kinder kennen gar nichts anderes: Sie bekommen etwa von Google zu einer gesuchten Person mehr Infos in strukturierter Form angezeigt, z.B. die zugehörigen Werke. Sie können dann auf ein Werk klicken, und bekommen Orte eingeblendet, die für dieses Werk relevant sind, und so weiter.

Wie läuft die Integration eines 3D-Architekturmodells in ein digitales Archiv ab, was ist dabei zu beachten?

Was man sich erst einmal vor Augen halten muss: 3D-Modelle liegen in einer Vielzahl von sehr unterschiedlichen Formaten vor. Und ich habe nicht nur Dreiecks- und Polygonmodelle, sondern vielleicht auch Punktwolken oder ganze BIM-Modelle. Dann muss ich schauen, welche Informationen (wie Geometrie, Materialeigenschaften, textuelle Annotationen) enthalten sind, und, ganz wichtig, inwiefern unterstützen frei verfügbare Tools die Formate?

Ich lasse jetzt mal das Thema Langzeitarchivierung außen vor und geh gleich zu den Erschließungs- und Verarbeitungsschritten: Dem Dateiformat kommt eine entscheidende Bedeutung für alle weiteren Schritte der Verarbeitung zu, sofern diese den unmittelbaren Inhalt des Modells betreffen. Hierzu zählen die Anzeige des Modells in einer geeigneten Webanwendung und die Möglichkeit der Auslieferung von 3D-druckbaren Versionen. Wir müssen sicherstellen, dass die anvisierten 3D-Formate in geeigneter Form importiert und gegebenenfalls konvertiert werden können, um eine zukunftsfähige Nutzung zu gewährleisten.

(Bild: Ina Blümel et al [18], CC-BY-NC 3.0 [19] )

Um ein die Suche in Modellbeständen zu ermöglichen, sind die Daten hinsichtlich ihrer inhaltstragenden Merkmale zu analysieren. Ich muss also erst einmal Indexdaten erzeugen. Das können geometrische Eigenschaften in Form von Vektoren sein. Oder es sind statistische Deskriptoren, mit denen man 3D-Modelle auf spezifische Eigenschaften überprüfen kann; bei 3D-Modellen sind dies zum Beispiel Informationen über Farbverteilung auf der Modelloberfläche. Oder ich extrahiere strukturelle Beschreibungen, repräsentiert in Form eines Graphen. Aus diesen Indexdaten lassen sich inhaltlich-technische und quantifizierbaren Attribute erzeugen, zum Beispiel die Größe der Raumflächen. Erst diese Indexdaten werden im Information Retrieval durch Algorithmen miteinander verglichen, um Ähnlichkeiten zu finden.

Inhaltsbasierte Erschließungsmethoden nutzen häufig maschinelle Lernverfahren. Die arbeiten beispielsweise auf Form- oder Strukturmerkmalen, um eine automatische Kategorisierung von 3D-Modellen zu ermöglichen. Derart getaggte Modelle kann man dann wunderbar durchsuchen. Und man kann dann auch 2D, Video, Handschriften etc. in einem Index haben und über all dem suchen. Genau dahin wollen wir ja mit den digitalen Archiven. Neben maschinellen Auswertungen sehe ich eine wachsende Bedeutung von Crowdsourcing.

Können Sie Nutzungsmöglichkeiten benennen, die Sie mittels digitaler Archive im Bereich Digital Heritage vorbereiten?

Wir wollen die Objekte zugänglich machen, die Archive sichtbar machen für jedermann. Unsere Auffassung ist: Kulturerbe gehört jedem. Wenn etwas gut präsentiert wird, dann lädt es zur Nachnutzung ein, dann wird mit den Daten vielleicht was neues Kreatives geschaffen. Zum Beispiel in Initiativen wie Coding da Vinci [20]. Da kommen Bestände aus dem GLAM-Bereich, also Galleries, Libraries, Archives, Museums zusammen mit Hackern und Codern, die mit diesen Daten kreativ arbeiten und unkonventionelle Anwendungen erstellen.

Digitalisate lassen sich durch das Einblenden von Kontextinformationen viel besser vermitteln und sie bieten einen besseren Zugang. Semantische Segmentierung und Verknüpfung von Text, Bild und 3D-Modell bietet da spannende Möglichkeiten. Wenn ich ganze Bestände von verschiedenen Einrichtungen digitalisiert habe und Objekte zusammen zeigen kann, dann macht das Zusammenhänge viel klarer, als wenn ich mühsam von Ort zu Ort gehen muss. Man kann auch in den Archiven und Museen einiges mehr machen, etwa hybride Ausstellungen, die virtuelle und reale Objekte zusammen zeigen.

Die Möglichkeiten wissenschaftlicher Anwendungen sind enorm vielfältig. Wissenschaftler können ihre Diskussionen direkt am Modell und seinen Bestandteilen mittels Annotationen andocken. Das setzt voraus, dass Daten und Metadaten offen bereitstehen. Wir wollen weg von den Silos virtueller Forschungsumgebungen, wo Personen außerhalb des akademischen Elfenbeinturms draußen bleiben. Sinnvoll ist eine aussagenbasierte Beschreibung der Modellinhalte insbesondere für Kulturerbe aufbauend auf eventbasierten Referenzmodelle wie CIDOC CRM [21].

Was sind aus Ihrer Sicht die größten Herausforderungen bei der Erstellung und Pflege von Digitalen Archiven? Was wünschen Sie sich?

Wir sollten den Mut haben zu unfertigen Produkten, also agiler arbeiten. Damit können wir auch zu den Nutzern gehen und sie immer wieder um Feedback bitten, und das dann aufgreifen. Wir tendieren leider im bibliothekarischen, aber auch im Kultur- und Wissenschaftsbereich dazu, lange an ausgefeilten Produkten zu basteln. Wenn wir damit fertig sind, dann ist der Hype schon vorüber und die Leute interessieren sich schon wieder für was anderes.

Partizipation lässt sich in Wissenschaft und Kultur digital phantastisch umsetzen. Warum machen wir so wenig Gebrauch davon? Warum sind die Angebote immer noch so monodirektional? Man kann an Projekten wie Wikipedia die Motivationen studieren, die Leute antreibt, an einem digitalen Allgemeingut mitzuarbeiten. Die Dynamik, mit der neuerdings Wikidata wächst, das strukturierte Informationen zu Personen, Werken, Orten, etc. vorhält ist beeindruckend.

Welche Rolle spielen Unternehmen, öffentliche Institutionen und die förderpolitischen Entscheidungen?

Die Gestaltung des digitalen Wandels wird momentan stark einzelnen Unternehmen überlassen, da sollten öffentlich geförderte Institutionen als vertrauenswürdige Instanzen stärker mitmischen. Allein auf dem Gebiet offener, gemeinsamer Standards, Software, Daten usw. bleibt viel zu tun. Vielfach sind Insellösungen die Regel. Im Bereich Open Data kommt in Deutschland Bewegung in die Sache mit der der Ausschreibung zu nationalen Forschungsdateninfrastrukturen 2019. Aber es braucht auch Industriepartnerschaften. Und wir brauchen Rechtssicherheit. Aktuell gibt es ja dieses scheußliche BGH-Urteil zum Reiss-Engelhorn Museum [22].

Es gab mal eine Zeitlang viel Fördergeld für Digitalisierung, das wurde vornehmlich für 2D genutzt. Nun, da Technologien wie 3D Scanning immer massentauglicher sind, und sich mit Deep Learning Verfahren ganz neue Möglichkeiten auftun fehlt das Geld. Ich setze ja einiges an Hoffnung in die Bewerbung des FET Flagship-Projekts Time Machine [23] um Fördergelder bei der EU. In dem Projekt haben sich um die 200 europäische Institutionen zusammengeschlossen mit dem Ziel, neue Technologien für das Scannen, Analysieren, Zugreifen, Bewahren und Kommunizieren von kulturellem Erbe zu entwickeln.

Aber dann bleibt immer noch die Frage, wer soll die Daten denn dauerhaft archivieren? Und um welche Daten geht es eigentlich? Wer weiß schon, was die Historiker von morgen eigentlich interessieren wird? Und rein ressourcentechnisch gedacht, gibt es DAS zentrale Archiv, das so gut ausgestattet ist, ausfallsicher usw., das alle Informationen manipulations- und fälschungssicher aufbewahrt, quasi als Leviathan aller Archiv-Einrichtungen? Oder gibt es andere Lösungen, und wir landen vielleicht wirklich irgendwann bei einem dezentralen digitalen Archiv oder Museum, so wie es gerade Ansätze im Bereich Blockchain und Peer2Peer-Anwendungen gibt? (mho [24])

URL dieses Artikels:

https://www.heise.de/-4259169

Links in diesem Artikel:

[1] https://www.heise.de/news/Die-Zukunft-der-Archive-Ein-Gedaechtnis-fuers-Internet-und-Quellcode-4259320.html

[2] https://www.heise.de/news/Die-Zukunft-der-Archive-Games-nicht-nur-bewahren-sondern-spielbar-erhalten-4259331.html

[3] https://www.dnb.de/DE/Veranstaltungen/Fachveranstaltungen/fachveranstaltungenUeberblick.html?cms_docId=290108&cms_notFirst=true

[4] https://creativecommons.org/licenses/by-sa/3.0/deed.en

[5] https://www.heise.de/Datenschutzerklaerung-der-Heise-Medien-GmbH-Co-KG-4860.html

[6] https://www.heise.de/news/Online-Archive-Der-Kampf-mit-dem-Copyright-123763.html

[7] https://www.softwareheritage.org

[8] http://www.tim-mann.org/catweasel.html

[9] https://www.kryoflux.com/

[10] https://www.heise.de/bilderstrecke/2567913.html?back=4259169

[11] https://www.heise.de/bilderstrecke/2567913.html?back=4259169

[12] https://www.heise.de/bilderstrecke/2567915.html?back=4259169

[13] https://www.heise.de/bilderstrecke/2567915.html?back=4259169

[14] https://www.langzeitarchivierung.de/Subsites/nestor/DE/Publikationen/Thema/thema_node.html

[15] https://vivo.tib.eu/fis/display/n0000-0002-3075-7640

[16] https://creativecommons.org/licenses/by-sa/4.0/deed.en

[17] https://de.wikipedia.org/wiki/Building_Information_Modeling

[18] http://papers.cumincad.org/data/works/att/ecaade2014_138.content.pdf

[19] https://creativecommons.org/licenses/by-nc/3.0

[20] https://codingdavinci.de/

[21] http://www.cidoc-crm.org/

[22] https://www.heise.de/news/BGH-Urteil-zu-Museumsfotografie-Streit-um-das-kulturelle-Erbe-4257617.html

[23] https://timemachine.eu/

[24] mailto:mho@heise.de

Copyright © 2018 Heise Medien