KI als Entscheidungshilfe für Ärzte: Ethikerin warnt vor "Computerpaternalismus"

Ärzte sollten sich nicht zu 100 Prozent auf KI-Systeme verlassen. Unklarheit gibt es laut Ethikerin Eva Winkler zudem noch bei der Erklärbarkeit der KI-Systeme.

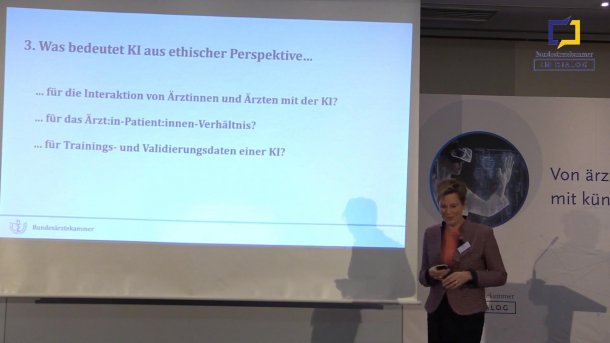

Prof. Eva Winkler zu den ethischen Fragen zu Künstlicher Intelligenz in der Medizin

Das Potenzial von KI-basierten Systemen zur Entscheidungsunterstützung, auch "Clinical Decision Support Systems" genannt, ist groß. Wichtig sei dabei Systemvertrauen, Google und Co. würden schließlich auch Gesundheitsdaten übergeben. Datenleaks könnten nicht verhindert werden, aber das Risiko ließe sich minimieren. Darin sind sich die Experten auf der von der Bundesärztekammer ausgerichteten Veranstaltung zum Thema Künstliche Intelligenz in der Medizin einig.

Weitere wichtige Themen sind laut Prof. Eva Winkler, Vorsitzende der zentralen Ethikkommission (Zeko), dabei die Diagnostik und Bilderkennung. 70 Prozent der von der US-Behörde für Lebensmittel- und Arzneimittel (FDA) zugelassenen Systeme kommen aus dem Bereich Bilderkennung, 30 Prozent aus dem Bereich Entscheidungsfindung,

Sorge vor Fehlentscheidungen

Es gibt aber auch die "dunkle Seite" der KI, wie Lauterbach sie nannte. Die Frage danach, was passiert, wenn die KI noch fehlerbehaftet ist. Ein prominentes Beispiel ist beispielsweise das inzwischen eingestellte Programm IBM Watson for Onkology. Es sei laut Winkler, die an einem der Testzentren für eine deutsche Entwicklung beteiligt gewesen war, nicht leicht gewesen, den Patienten zu erklären, warum die Empfehlungen der KI weit weg von den Leitlinien waren und vom System nicht berücksichtigt wurden. Daher müssten die Systeme "sicher und gut getestet sein". Derzeit bestehe die Befürchtung, dass es noch nicht gut genug ist.

KI-Bias

Als weiteres Beispiel nannte Winkler eine dermatologische Bilderkennung, die bei hellhäutigen Menschen anders als bei dunkelhäutigen Menschen funktioniere. Da sei die Erfolgsrate für dunkelhäutige Menschen deutlich schlechter, weil die Modelle häufig mit Bildern hellhäutiger Patienten trainiert wurden.

Es dürfe zudem nicht zum Automatisierungs-Bias kommen. Nur weil das Ergebnis 100 Mal richtig war, könne es beim 101. Mal trotzdem falschliegen. Aber jeder habe schließlich schon die Erfahrung gemacht, Fehlermeldungen einfach wegzuklicken, so Winkler.

Videos by heise

Computerpaternalismus

Dabei dürfe es nicht Richtung Computerpaternalismus gehen, dass technische Systeme Ärzte bevormunden, denn diese sollten das letzte Wort haben. Kritisch sei es, wenn vor allem junge Assistenzärzte allein aufgrund der Empfehlungen der KI Entscheidungen treffen. Sofern tatsächlich Zeit durch die Effizienz der Algorithmen gewonnen würde, müsste diese auch in Gespräche und Kommunikation mit den Patienten investiert werden. Es könne keine automatisierte Behandlungsentscheidung geben, die den Arzt ersetzt. KI sollte kein Ersatz sein, sondern die Entscheidungsfindung unterstützen – Ärzte sollen Plausibilitätskontrollen mit Erfahrungswissen und Intuition kombinieren.

Ein Fragezeichen habe Winkler noch bei der Erklärbarkeit der Entscheidungen der KI-Systeme. Bei der "Blackbox KI" ist es unter Experten umstritten, ob die notwendige Transparenz hergestellt werden kann, um zu wissen, wie die generativen KI-Systeme entschieden haben. Wichtig sei dabei, die Halluzinationen der KI zu erkennen. Künftig könnten drei von Gesundheitsminister Karl Lauterbach vorgestellte Systeme, Epic, Dragon und GPT-4, gemeinsam zum Einsatz kommen. Dazu müssten die Mitarbeiter in Praxen und Krankenhäusern geschult werden.

Fragen zu Forschungsdaten

Ethische Fragen zu Trainings- und Validierungsdaten müssten ebenfalls geklärt werden. Zudem könnten auch nur "gut kuratierte Daten" helfen. Damit beschäftigt sich die jüngste Stellungnahme der Zeko "Bereitstellung und Nutzung von Behandlungsdaten zu Forschungszwecken". Dabei warf sie auch die Frage nach einer anderen rechtliche Basis für die Bereitstellung von Patientendaten mit Widerspruchsmöglichkeit auf. Auch kommerzielle Player müssten mit eingeschlossen werden, auch weil sie bessere Lösungen haben und den Umgang mit großen Datenmengen gewohnt sind. Dafür brauche es klar definierte Nutzungsrechte.

Auswirkung auf Arzt-Patienten-Beziehung

Ebenso sei es unklar, wie die KI-Entwicklungen in die Arzt-Patienten-Beziehung eingreifen und in welche Richtung das gehen wird. Dazu hatte die bundesweit agierende Ethikkommission im August 2021 eine Stellungnahme zum Einsatz von KI als Entscheidungsunterstützung verfasst, die ethische und rechtliche Fragen aufwerfen und Ärzten als Orientierung dienen soll. Auch bei Triage-Situationen könne KI helfen, im Bereich Prognose und Vorhersage wird ihr Einsatz diskutiert.

(mack)