Maschinen-Ethik: Vertraue mir, ich bin ein Roboter

Alexa, Google Assistant, Siri sind der Anfang. Roboter und virtuelle Agenten mischen sich immer mehr ein. Welcher Ethik folgen sie? Wer vertraut ihnen? Warum?

Vertrauen ist ein sehr empfindliches Gut, das leicht zerstört, aber nur mühsam hergestellt werden kann. Das gilt für Menschen ebenso wie für Maschinen. Wer schon mal erlebt hat, wie nach einem Software-Update auf einmal gar nichts mehr lief oder wertvolle Daten verlorengingen, wird den Versprechungen, mit denen neue Versionen von Programmen oder Betriebssystemen angepriesen werden, künftig mit gesundem Misstrauen begegnen. Auch die Roboter und virtuellen Agenten, die gegenwärtig mit den Füßen scharren, um sich mehr und mehr in menschliche Belange einzumischen, dürfen nicht unbedingt damit rechnen, mit offenen Armen empfangen zu werden.

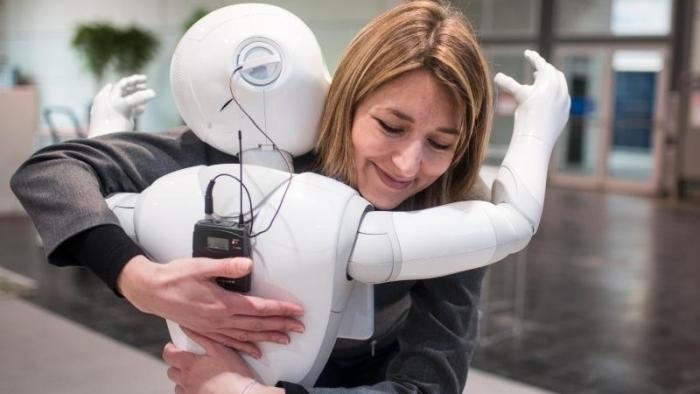

Daran ist nicht allein – und vielleicht nicht einmal in erster Linie – Hollywood mit seinen fiktiven Robotergeschichten schuld, wie Alessandra Rossi (University of Hertfordshire) bei der International Conference on Human-Agent Interaction [1] (HAI) in Southampton vermutete. Ein Werbevideo für den Roboter Pepper, von dem sie Ausschnitte in ihrem Vortrag zeigte, war der sichtbare Beleg, dass auch jenseits von Filmstudios die Fähigkeiten von Robotern gern übertrieben dargestellt werden. Gleichwohl hatte sie sicherlich recht mit ihrer Aussage, dass die Kenntnis von deren tatsächlichen Fähigkeiten ein Schlüsselfaktor für das Vertrauen in diese Technologie und damit für deren gesellschaftliche Akzeptanz ist.

Empfohlener redaktioneller Inhalt

Mit Ihrer Zustimmung wird hier ein externes Video (TargetVideo GmbH) geladen.

Ich bin damit einverstanden, dass mir externe Inhalte angezeigt werden. Damit können personenbezogene Daten an Drittplattformen (TargetVideo GmbH) übermittelt werden. Mehr dazu in unserer Datenschutzerklärung [2].

Vertrauensbildende Maßnahmen

Zur Untersuchung dieser Frage haben Forscher der University of Herfordshire im Rahmen des EU-Projekts SECURE [7] während der UK Robotics Week [8] eine zweitägige Studie mit älteren Schülern (ab 14 Jahre) durchgeführt. Hierbei hatten die Schüler die Gelegenheit, den Roboter Pepper in einem dreistufigen Prozess kennenzulernen: Zunächst sahen sie ein Video über ihn, dann konnten sie direkt mit ihm interagieren und schließlich waren sie aufgefordert, ihn zu programmieren. Nach jeder Stufe waren sie aufgefordert, Fragen zu beantworten, etwa ob sie Pepper bei sich zu Hause haben möchten, ob sie ihm zutrauen, ihnen bei den Hausarbeiten zu helfen, oder wie leicht oder schwer ihnen das Programmieren gefallen ist. Dabei zeigte sich, dass das Vertrauen in den Roboter stieg, je intensiver die Erfahrungen mit ihm waren.

Eine Studie mit kleineren Kindern im Alter von 7 bis 11 Jahren wurde an der University of Amsterdam im Rahmen des Projekts Childrobot [9] durchgeführt, von dem Caroline van Straten berichtete. Auch die Roboter waren kleiner: Die Kinder waren aufgefordert, mit dem 60 Zentimeter großen humanoiden Roboter Nao ein Ratespiel zu spielen. Anschließend wurden sie zu ihren Erfahrungen dabei befragt.

Maschinen-Ethik

Die Forscher wollten wissen, inwieweit Kinder zwischen technologischem und zwischenmenschlichem Vertrauen unterscheiden können. Dabei wird technologisches Vertrauen definiert als die Bereitschaft, sich auf die Empfehlungen einer Maschine zu verlassen, zwischenmenschliches Vertrauen dagegen als die Bereitschaft, sich anderen gegenüber verletzlich zu machen. Bei der Analyse der Äußerungen der Kinder zeigte sich, dass sie ihr Vertrauen in den Roboter überwiegend mit zwischenmenschlichen Kategorien begründeten.

Überrascht waren die Forscher jedoch davon, dass einige Kinder ihr zwischenmenschliches Vertrauen in den Roboter mit dessen technologischen Fähigkeiten oder Begrenzungen begründeten, wofür sie eine dritte Kategorie bildeten. Um dieses Zusammenspiel der verschiedenen Dimensionen des Vertrauens und damit die Entwicklung sozialer Beziehungen zwischen Mensch und Roboter besser zu verstehen, empfehlen die Forscher weitere Studien mit größeren, repräsentativeren Gruppen von Kindern und auch mit Jugendlichen.

Utilitarismus vs. Deontologische Ethik

Damit Roboter und virtuelle Agenten als soziale Akteure in der menschlichen Gesellschaft akzeptiert werden, ist es natürlich auch hilfreich, wenn sie sich ethisch korrekt verhalten. Laura Wächter hat an der Universität Freiburg 30 Versuchspersonen Dialoge mit einem Roboter führen lassen, in denen dieser von moralischen Dilemmata erzählte, die ein anderer Roboter erlebt hatte.

Dabei ging es unter anderem darum, ob ein Roboter lügen darf, um eine von ihm betreute ältere Person zu gesünderem Verhalten zu bewegen, oder ob er einen versehentlich zu hoch ausgefallenen Betrag von Wechselgeld einem Waisenhaus spenden darf. Anschließend sollten die Teilnehmer des Experiments das Verhalten des Roboters bewerten.

Ihre Äußerungen wurden danach kategorisiert, an welcher ethischen Tradition sie sich orientierten: Als "utilitaristisch" bzw. "konsequentialistisch" [10] gilt eine Ethik, die den größtmöglichen Nutzen einer möglichst großen Zahl von Personen anstrebt; eine "deontologische" Ethik [11], nach der bestimmte Handlungen unabhängig von ihren Ergebnissen gut oder schlecht sind, formuliert Regeln, die es zu befolgen gilt (etwa: Du sollst nicht lügen). Außerdem berücksichtigte Wächter in ihrer Studie noch die von Shalom H. Schwartz entwickelte Theorie "universeller Werte [12]", wonach es zehn grundlegende Werte gibt, an denen sich alle Kulturen orientieren.

Recht und Anstand

Interessanterweise kamen Handlungen des Roboters, die utilitaristisch begründet wurden, deutlich schlechter weg als die anderen. Das ist insofern bemerkenswert, als der Utilitarismus wegen seiner Orientierung an Quantitäten für die Programmierer von Robotern durchaus attraktiv [13] erscheinen könnte.

Tatsächlich haben Juristen wie der Rechtswissenschaftler Eric Hilgendorf von der Universität Würzburg bereits die Sorge geäußert, dass etwa die Integration autonomer Fahrzeuge in den Straßenverkehr aus diesem Grund das auf der deontologischen Ethik basierende deutsche Rechtssystem durcheinander bringen könnte. Wächters Studie zufolge scheinen die Vorstellungen von Recht und Anstand offenbar doch tiefer in der Bevölkerung verwurzelt zu sein, als dass ein paar Roboter sie mal eben über den Haufen werfen könnten. Das letzte Wort zu diesem Thema ist aber sicherlich noch lange nicht gesprochen. (jk [14])

URL dieses Artikels:

https://www.heise.de/-4255726

Links in diesem Artikel:

[1] http://hai-conference.net/hai2018/

[2] https://www.heise.de/Datenschutzerklaerung-der-Heise-Medien-GmbH-Co-KG-4860.html

[3] https://www.heise.de/news/HAI-2018-Roboteraugen-sehen-dich-an-4254055.html

[4] https://www.heise.de/news/HAI-2018-Wenn-der-Roboter-die-Kontrolle-uebernimmt-4252225.html

[5] https://www.heise.de/news/HAI-2018-Kann-man-mit-einem-Roboter-diskutieren-4252068.html

[6] https://www.heise.de/news/Ethik-bei-autonomen-Autos-und-das-Trolley-Problem-Was-tut-der-Weichensteller-3766885.html

[7] https://secure-robots.eu

[8] https://www.ukras.org/robotics-week/about/

[9] https://childrobot.org

[10] https://de.wikipedia.org/wiki/Konsequentialismus

[11] https://de.wikipedia.org/wiki/Deontologische_Ethik

[12] http://www.migration.uni-jena.de/project4/values/index.php?lang=de

[13] https://www.heise.de/news/Ethik-bei-autonomen-Autos-und-das-Trolley-Problem-Was-tut-der-Weichensteller-3766885.html

[14] mailto:jk@heise.de

Copyright © 2018 Heise Medien