Nvidia sieht sich bei KI-Chips in Führung und bringt Roboter-Rechenmodul

Trotz vieler KI-Chip-Startups liegen Nvidia-Chips in "MLPerf"-Benchmarks vorne; der Jetson Xavier NX mit 15 Watt ist für Roboter mit KI gedacht.

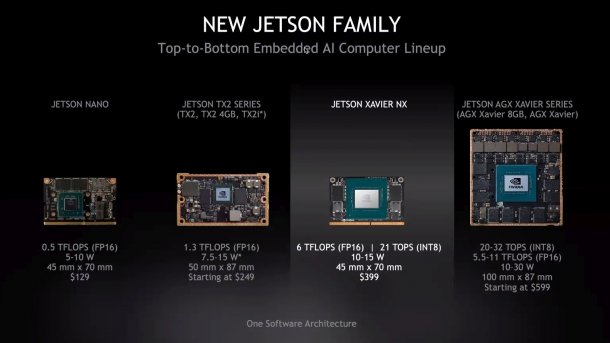

Nvidias Jetson-Module inklusive des neuen Jetson Xavier NX

(Bild: Nvidia)

Nvidia hat am Mittwoch erste Ergebnisse für den Machine-Learning-Benchmark MLPerf Inference 0.5 veröffentlicht. Nach Einschätzung des Chipherstellers gibt es derzeit rund 130 Firmen, die an Hardware-Beschleunigern für KI-Algorithmen arbeiten. Von diesen Konkurrenten beteiligen sich aber bisher nur wenige am Machine-Learning-(ML-)Benchmark MLPerf.

Training und Inferencing

Der Benchmark hat zwei Hauptkategorien: Training und Inferencing. Während es von Nvidia, Intel und Google bereits Resultate für MLPerf Training 0.6 gibt, erscheinen nun auch welche für MLPerf Inference 0.5. Und beim Inferencing, also bei Chips für die Anwendung bereits trainierter Netze wie ResNet und MobileNet, sieht Nvidia die eigenen Tesla- und Xavier-Chips mit großem Abstand in Führung.

KI-Inferencing läuft einerseits in (Cloud-)Servern, um Datenmassen zu klassifizieren, Objekte in Bildern zu erkennen, geschriebene Texte zu übersetzen oder gesprochene Sprache zu erkennen. Andererseits kommt KI-Inferencing in Echtzeit etwa zur Objekterkennung in Kamerabildern in Fahrzeug-Assistenzsystemen oder Robotern zum Einsatz.

(Bild: Nvidia)

Inferencing-Server

Fürs Inferencing im Rechenzentrum empfiehlt Nvidia die hauseigenen Tesla-Karten mit Turing-GPUs, etwa die Tesla T4 (75 Watt) oder auch die deutlich stärkere Titan RTX (280 Watt). Die Tesla T4 schafft bei der Verarbeitung von INT8-Daten bis zu 130 Tops.

Im MLPerf Inference v0.5 "Closed" liegt die Titan RTX laut Nvidia um Längen vor Intels x86-Prozessor Xeon Platinum 9282, aber auch deutlich vor Googles TPU v3 oder dem PCIe-Beschleuniger Habana Goya. Nach eigenen Angaben hat auch nur Nvidia Resultate für alle fünf Teildisziplinen Bildklassifizierung (MobileNet v1, ResNet-50 v1.5), Objekterkennung (SSD-MobileNet v1, ResNet-34) und Sprachübersetzung (GNMT) eingereicht. Die Konkurrenten beschränkten sich jeweils auf weniger Disziplinen.

Jetson Xavier NX für Roboter

(Bild: Nvidia)

Für KI in Fahrzeugen, Robotern oder auch Drohnen entwickelt Nvidia Systems-on-Chip (SoCs) mit ARM-Kernen, GPUs, Kamera-Interfaces sowie Video-De- und Encodern wie Parker (Pascal-GPU) und Xavier (Volta-GPU). Diese SoCs verkauft Nvidia auch auf kompakten "Jetson"-Rechenmodulen.

Ab März 2020 will Nvidia das neue Modul Jetson Xavier NX für 399 US-Dollar verkaufen. Es handelt sich dabei um eine abgespeckte und für niedrige Leistungsaufnahme (10 bis 15 Watt) optimierte Version des teureren Jetson AGX Xavier.

Entwickler können mit einem Software-Patch die Performance des Jetson AGX Xavier begrenzen, um schon jetzt Code für den Jetson Xavier NX zu testen. Letzterer soll bei INT8 bis zu 21 Tops erreichen, bei FP16 bis zu 6 TFlops. Das Steckmodul im Format 70 mm × 45 mm passt in dieselben Fassungen wie der Jetson Nano mit Tegra X1.

Sechs ARM-Kerne und JetPack-SDK

Der Jetson Xavier NX ist mit 8 GByte LPDDR4X-SDRAM bestückt. Sein Xavier-SoC enthält eine Volta-GPU mit 384 CUDA-Kernen, 48 Tensor-Kernen und 2 Deep Learning Accelerators (NVDLA). Zudem stehen sechs ARMv8-Kerne (Nvidia Carmel) bereit.

Über 12 MIPI-CSI-2-Lanes lassen sich 6 Kameras direkt anschließen. Der Video-Decoder verarbeitet zwei 4K-Streams mit 60 Hz gleichzeitig. Nvidia stellt dazu das JetPack SDK bereit, das unter anderem ein Ubuntu-verwandtes Linux als Betriebssystem umfasst sowie Bibliotheken wie CUDA (10.0.326), TensorRT (5.1.6.1), cuDNN (7.5.0.56), VisionWorks und OpenCV. Im Unterschied zum Jetson AGX Xavier ist der VLIW Vision Accelerator beim Xavier NX nicht nutzbar. (ciw)