Vision Pro: Apps dürfen weder Augen, Hände noch Umgebung sehen

Mit 12 Kameras und 5 Sensoren erfasst das Apple-Headset Augenbewegung und Umgebung des Nutzers. Apps sollen darauf nur eingeschränkt Zugriff erhalten.

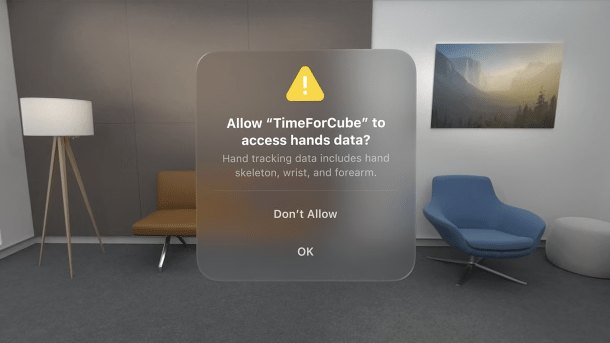

Den Zugriff auf "Handdaten" müssen Nutzer Apps in visionOS erst erlauben.

(Bild: Apple)

Apples Vision Pro setzt auf eine ganze Armada an Sensoren: 12 Kameras und 5 Sensoren, die über Außen- und Innenseite des Headsets verteilt sind, erfassen kontinuierlich die Umgebung sowie die Hand- und Augenbewegungen des Nutzers. Damit Apps keinen Zugriff auf sensible Daten erhalten, soll nur das Betriebssystem in einem "isolierten Systemprozess" lokal auf dem Headset erfassen, auf welche Inhalte oder Dinge der Nutzer gerade blickt.

Augenbewegungen bleiben Apps verborgen

Das Betriebssystem visionOS hebt Bedienelemente hervor, auf die der Träger des Headsets seinen Blick richtet – auch das soll für die gerade genutzte App unsichtbar bleiben: Die Markierung des Interface-Bereichs, auf den sich der Blick richtet, übernimmt eine Rendering-Engine außerhalb der App, so der Hersteller. Erst wenn der Nutzer die Finger in einer Zwickgeste zusammenführt, um die Eingabe auszuführen, wird dies schließlich an die App übermittelt, und zwar als ein simples Signal wie das Antippen eines Bedienelementes auf dem iPhone.

Videos by heise

Das habe auch den Vorteil, dass die Komplexität der Erfassung von Augen- und Handbewegungen sowie der damit getätigten Eingaben rein dem Betriebssystem überlassen wird, merkt der Hersteller an. iPhone- und iPad-Apps benötigen dadurch keine spezielle Anpassung und keine gesonderte Erlaubnis, um auf der Vision Pro per Augen und Fingergeste bedient zu werden. Alle Berechnungen sollen direkt auf der Hardware erfolgen, ergänzt Apple: Die von den Augenkameras erfassten Blickbewegungen würden so nicht nur vor Apps und Webseiten verborgen bleiben, sondern auch vor Apple selbst.

Kein Zugriff auf Kameras der Vision Pro

Auf visionOS portierte iPhone-Apps sind außerdem gar nicht erst in der Lage, die Kameras der Vision Pro zu nutzen, wie Apple in einer weiteren Session für Entwickler erklärte. Will eine iOS-App auf die Hauptkameras zugreifen, die auf der Vorderseite der Vision Pro angebracht sind, erhält sie kein Signal. Die Selfie-Kamera liefert nur dann ein Bild, wenn der Träger des Headsets ein digitales Abbild seines Gesichts erstellt hat, das sich etwa für Videokonferenzen verwenden lässt – dafür werden Augen und Mimik durch das Betriebssystem erfasst.

Auch ARKit-Apps, die virtuelle Elemente in die reale Umgebung des Nutzers bringen, sollen keinen direkten Zugriff mehr auf den Kamera-Stream erhalten, heißt es in einer weiteren Session. Die Apps können den Nutzer aber um Zugriffserlaubnis für Hand-Tracking bitten, um dann Handbewegungen zu erfassen und so Interaktionen mit den virtuellen Inhalten zu ermöglichen.

Vision Pro und visionOS: Technische Details zu Apples Mixed-Reality-Headset (25 Bilder)

Empfohlener redaktioneller Inhalt

Mit Ihrer Zustimmung wird hier ein externer Preisvergleich (heise Preisvergleich) geladen.

Ich bin damit einverstanden, dass mir externe Inhalte angezeigt werden. Damit können personenbezogene Daten an Drittplattformen (heise Preisvergleich) übermittelt werden. Mehr dazu in unserer Datenschutzerklärung.

(lbe)