Robotik-Konferenz RSS: Haben Roboter Intentionen?

Wenn Roboter mit Menschen interagieren sollen, müssen sie auch Intentionen erkennen können. Das ist gar nicht so einfach.

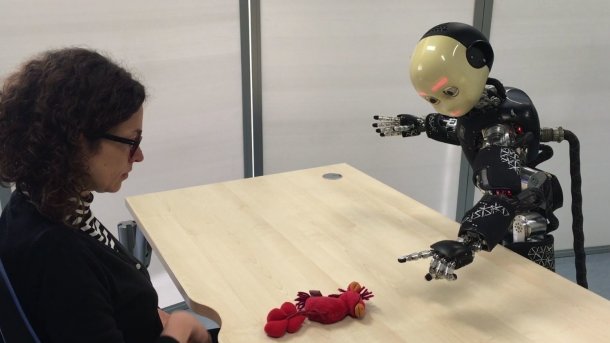

(Bild: IIT Central Research Labs Genova)

Wenn Roboter mit Menschen zusammenarbeiten und sie unterstützen sollen, brauchen sie dafür Autonomie. Denn wenn der mechanische Gehilfe immer erst auf Kommandos von seinem menschlichen Partner warten müsste, wäre er keine große Hilfe, im Gegenteil. Wie sich die Kontrolle zwischen beiden am besten aufteilen lässt, erörterten Forscher jetzt in Freiburg.

Bei der Konferenz RSS (Robotics: Science and Systems) fand dort der Workshop AI and Its Alternatives in Assistive and Collaborative Robotics statt, der Forschungen zum menschlichen Faktor mit ingenieurwissenschaftlichen Ansätzen zusammenbringen wollte. Eher von der humanwissenschaftlichen Seite kam Agnieszka Wykowska vom Italian Institute of Technology (IIT), die den Begriff der "sozialen Einstimmung“ (social attunement) ins Spiel brachte. Diese Einstimmung geschehe zwischen Menschen auf implizite, unbewusste Weise, etwa durch Synchronisation der Blickrichtungen und der Emotionen. Es sei wichtig, diese Mechanismen im Detail zu untersuchen, um Robotern ein natürliches Verhalten zu ermöglichen. Bei der Interaktion mit einem Roboter käme aber erschwerend dessen hybride Natur als sozialer Akteur und Maschine hinzu.

Mensch und Roboter beim Kartenspiel

Wykowska berichtete von einem Experiment, bei dem untersucht wurde, ob die Versuchspersonen einen Roboter eher als Maschine oder als von Intentionen gesteuertes Wesen wahrnehmen. Hierfür wurden ihnen mehrere aus drei Bildern bestehende Sequenzen gezeigt, in denen ein Mensch und ein Roboter miteinander umgehen. Die Teilnehmer des Experiments sollten beschreiben, was dort wohl passiert ist. So waren etwa Mensch und Roboter bei einem Kartenspiel zu sehen. Auf dem zweiten Bild beugte sich der Roboter weit in Richtung des Menschen, der gerade in eine andere Richtung blickte. Versuchte der Roboter, seinem Spielpartner in die Karten zu schauen oder hatte er nur vorübergehend das Gleichgewicht verloren?

Die meisten Probanden neigten zur letzteren Interpretation (mechanistische Sichtweise), viele unterstellten dem Roboter aber auch eine Absicht (intentionale Sichtweise). Als in einer weiteren Phase des Experiments die Hirnaktivität der Teilnehmer per EEG aufgezeichnet wurde, zeigte sich, dass die mechanistische Sicht offenbar größere kognitive Anstrengung erforderte. Die erhöhte Hirnaktivität ließ sich am deutlichsten kurz vor der Entscheidung beobachten, trat aber denen, die zur mechanistischen Sicht neigen, auch im Ruhezustand vor dem Experiment auf, sodass sich deren Verhalten gut vorhersagen ließ. Wykowska vermutet, dass die intentionale Sicht so etwas wie eine Standardeinstellung ist und das Abweichen davon Anstrengung erfordert.

Die Haltung gegenüber dem Roboter könne sich im Verlauf der Interaktion ändern, so Wykowska. In einem weiteren Experiment hätten die Versuchsteilnehmer dem Roboter ein einfaches Lied beigebracht. Nachdem dieser zunächst sehr gut lernte, machte er dann beim gemeinsamen Musizieren auf einmal Fehler. Das hätte Teilnehmer, die zur intentionalen Sicht neigten, dazu gebracht, den Roboter als Maschine wahrzunehmen.

Intentionen erkennen und darauf reagieren

Ob der Roboter selbst Intentionen hat oder nicht, er sollte in der Lage sein, die Intentionen des Menschen zu erkennen und darauf angemessen zu reagieren. Dafür könne es hilfreich sein, die Interaktion zwischen ihnen in Segmente zu unterteilen, schlug Joseph Campbell (Arizona State University) vor. Solche „interaction primitives“ ermöglichten es, Handlungen gleichermaßen zu erkennen und zu generieren. Die Mensch-Roboter-Interaktion ließe sich als Tanz begreifen, als eine Abfolge von Bewegungen.

Die Aufgabe sei ähnlich dem als SLAM (Simultaneous Localization and Mapping) bekannten Problem, sich in einer unbekannten Umgebung zurechtzufinden: Es ginge darum, sich in der Zeit zu verorten und eine Abfolge von Bewegungen im Raum zu generieren. Als große Herausforderung sieht Campbell die Multimodalität menschlicher Interaktion, bei der stets alle Sinne gleichzeitig genutzt würden.

Koppelung über den Tastsinn

Auf den Tastsinn konzentrierten sich Etienne Burdet und Jonathan Eden (Imperial College London). In einem Experiment sollten die Teilnehmer auf einem Monitor mit dem Cursor den Bewegungen eines Kreises folgen. Dabei waren sie zeitweise, ohne dass sie es wussten, mit einem anderen Teilnehmer leicht gekoppelt, "als wären sie durch ein Gummiband miteinander verbunden“, wie Burdet erläuterte. Es zeigte sich, dass diese Kopplung bessere Ergebnisse bewirkte, auch wenn drei oder vier Teilnehmer auf diese Weise zusammenwirkten.

Die Lernphase dauerte dabei immer etwa 15 Sekunden. Der Tastsinn ermögliche einen unmittelbaren Austausch von Informationen, bei dem nicht gelogen werden könne, so Burdet. Eden erläuterte, wie dieses Verfahren in der Neurorehabilitation eingesetzt werden könne, indem Therapeut und Patient haptisch gekoppelt ein Spiel spielten. Der Therapeut könne dabei auch ein Roboter sein. Mithilfe der Theorie der Differentialspiele (Differential Game Theory) ließe sich sein Verhalten so modellieren, dass er sich dem Menschen anpassen könne.

Bei Differentialspielen geht es um die Modellierung von Konflikten im Kontext eines dynamischen Systems. Auf die Mathematik dynamischer Systeme stützen sich auch die Forscher an der EPFL in Lausanne. Damit ein Roboter menschliche Intentionen erkennen könne, käme es darauf an, die richtigen Parameter zu identifizieren, sagte Mahdi Khoramshahi. Im nächsten Schritt könne der Roboter seine Aufgabe entsprechend anpassen.

Harte Probleme für autonome Autos

Bei überschaubaren Anwendungen wie der Neurorehabilitation oder in industriellen Umgebungen, wie sie in dem von der EPFL koordinierten EU-Projekt SecondHands erforscht werden, könnte das schon bald gelingen und ließe sich auch Schritt für Schritt realisieren. Anders ist es mit Robotern, die in der Öffentlichkeit mit ungeschulten Menschen zurechtkommen sollen. Brandon Northcutt vom Toyota Research Institute listete einige Probleme auf, die er als "hart“ bezeichnete und die gelöst werden müssten, bevor autonome Autos auf die Straße gelassen werden dürften. Dazu zählen die Vorhersage und Einschätzung von Risiken, die Einschätzung der Ausrichtung anderer Fahrzeuge und die Risikobewertung von Fußgängern.

Hinzu kämen Sonderfälle wie der auf der Rückseite eines Lieferwagens abgebildete, lebensecht wirkende, fröhliche Zusteller, der ein autonomes Fahrzeug auf der Autobahn durchaus zu einer Vollbremsung verleiten könne. Auch die von Samsung verwendeten Lastwagen, die auf der Rückseite auf einem Bildschirm die Straße vor sich zeigen und damit den Verkehr eigentlich sicherer machen wollen, könnten von einem Roboter falsch interpretiert werden und riskante Brems- oder Ausweichmanöver provozieren. Autonome Fahrzeuge müssten zudem für den jeweiligen kulturellen Kontext, in dem sie eingesetzt werden sollen, trainiert werden. Bis Autos vollständig autonom auf öffentlichen Straßen unterwegs sein werden, dürften daher wahrscheinlich noch 50 Jahre vergehen, schätzte Northcutt.

Siehe dazu auch:

(axk)