Hadoop-Cluster in der Cloud und on Premises

Für die Verarbeitung großer Datenmengen eignet sich das Hadoop-Ökosystem. Ein unabhängiger Provisionierungsmechanismus erhöht die Flexibilität im Cloud-Einsatz.

- Thomas Mager

- Frank Feller

- Silvia Fademrecht

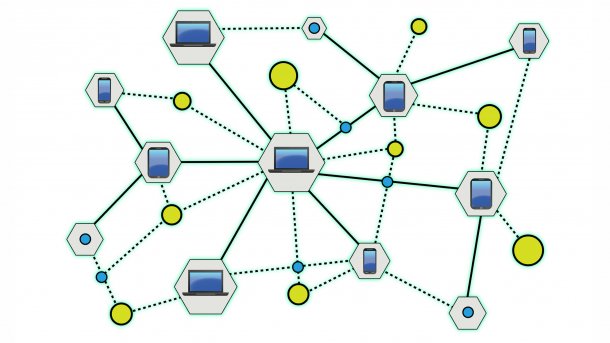

Neue Geschäftsfelder wie das Internet der Dinge erfordern zunehmend den Umgang mit großen Datenmengen, beispielsweise für die Speicherung und Verarbeitung erfasster Sensordaten. Eine breite Datenbasis unterstützt zudem viele Optimierungsszenarien, so im Zusammenhang mit präventiver Wartung, Kundensegmentanalyse, Betrugserkennung, Produktions- und Qualitätsoptimierung.

Das Big-Data-Ökosystem Hadoop hat sich aufgrund seiner Offenheit als Apache-Projekt und seiner Vielzahl an Tools als De-facto-Standard zur skalierbaren Verarbeitung solch großer Datenmengen durchgesetzt. Längst bieten auch Cloud-Provider wie Amazon Web Services (AWS), Google Cloud Platform (GCP) und Microsoft Azure native Hadoop-Funktionalität in ihren Cloud-Umgebungen an, um Anwendungen zur Datenverarbeitung zu entwickeln. Die Ansteuerung der angebotenen Services erfolgt über Cloud-spezifische Schnittstellen, wodurch die Nutzung eine Anpassung an die jeweils gewählte Cloud-Plattform erfordert. Es liegt jedoch nicht im Interesse des Nutzers, seine Anwendung auf eine spezifische Cloud-Plattform zuzuschneiden, da das einen Wechsel des Cloud-Providers durch erhöhte Wechselkosten (Vendor Lock-in) erschwert.

Setzt ein Unternehmen für die Datenspeicherung auf einen Cloud-Provider, bietet es sich an, die Algorithmen zur Datenverarbeitung auch physikalisch nah zu diesen Daten zu bringen. So kann das Unternehmen die Auswirkungen von Netzwerklatenzen und Bandbreiteneinschränkungen minimieren. Im Idealfall befindet sich beides im gleichen Rechenzentrum des Cloud-Providers. Der Effekt, dass bestehende Daten – relativ zur Datenmenge – mehr und mehr Software, Services und Geschäftslogik in ihre physikalische Nähe ziehen, wird im Big-Data-Kontext als Data Gravity bezeichnet.

Das war die Leseprobe unseres heise-Plus-Artikels "Hadoop-Cluster in der Cloud und on Premises ". Mit einem heise-Plus-Abo können Sie den ganzen Artikel lesen.