HAI 2018: Wenn der Roboter die Kontrolle übernimmt

Ein Roboter-Beifahrer kann Autofahrer unterstützen und kritische Rückmeldung geben. In anderen Fällen sollten Roboter besser selbst die Kontrolle übernehmen.

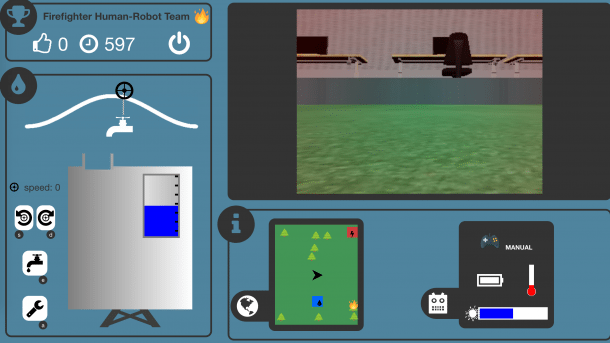

Beim "Firefighter Robot Game" sollen menschliche Mitspieler einen Löschroboter unterstützen – damit werden Daten über die Mensch-Roboter-Interaktion gesammelt, mit denen Roboter lernen, wann sie menschliche Befehle besser missachten sollten.

(Bild: ISAE (robot-isae.isae.fr))

Autonome Fahrzeuge sollen den Straßenverkehr eines Tages sicherer machen, lautet das Versprechen. Solange Roboter das Steuer nicht selbst in die Hand nehmen, können sie aber auch auf andere Weise für mehr Sicherheit auf den Straßen sorgen, etwa indem sie den menschlichen Fahrer warnen, wo er besonders aufpassen muss, und ihm nach der Fahrt eine Rückmeldung geben, was er gut gemacht hat und was nicht.

Ein Roboter als kritischer Beifahrer

Takahiro Tanaka, der an der Nagoya University an einem solchen Roboterbeifahrer arbeitet, berichtete am zweiten Tag der International Conference on Human-Agent Interaction (HAI) in Southampton von den Fortschritten seines Projekts, das er bereits auf der HAI 2017 vorgestellt hatte. Die Zahl der Verkehrsunfälle, die von älteren Fahrern verursacht wurden, hätte in Japan in den vergangenen Jahren zugenommen, sagte Tanaka. Ein kleiner, humanoider Roboter, der links vor dem Fahrer auf dem Armaturenbrett sitzt, soll dem entgegenwirken.

Bei Testfahrten in einem Fahrsimulator untersuchten die Forscher, welche Auswirkungen es auf die Fahrweise hatte, wenn der Roboter nur Warnhinweise gab, nur anschließende Rückmeldungen gab oder beides zusammen. Die Kombination beider Aktivitäten erzielte die besten Resultate, wobei sich bei älteren Versuchsteilnehmern aber insbesondere die Rückmeldungen positiv auswirkten. Jüngere Fahrer profitierten ebenfalls durch eine sicherere Fahrweise von dem Roboterbeifahrer.

Roboter und Menschen in gemischten Teams

Der kleine, nur wenige Zentimeter große Assistent wäre allerdings nicht in der Lage, das Steuer zu übernehmen, falls der Mensch aufgrund einer Herzattacke oder aus anderen Gründen plötzlich die Kontrolle verlieren oder gravierende Fehler begehen sollte. Mit dieser Art Szenario beschäftigten sich Caroline Chanel und Nicolas Drougard vom Institut ISAE-SUPAERO an der Université Toulouse. 80 Prozent der Unfälle mit autonom fliegenden unbemannten Flugzeugen seien auf menschliches Versagen zurückzuführen, weil aufgrund von Stress, Übermüdung oder Langeweile falsche Kommandos gegeben wurden. Um die Zusammenarbeit in gemischten Teams aus Menschen und Robotern sicherer zu gestalten, sei es daher wünschenswert, dass der Roboter erkennen könne, wenn der Mensch überlastet ist, und dessen Anweisungen gegebenenfalls ignoriere.

Lesen Sie dazu auf heise online:

Im Spiel missachten Roboter menschliche Befehle

Ein solches Verhalten müsse vom Roboter gelernt werden, wofür wiederum Daten erforderlich seien. Um diese Daten zu sammeln, haben die Forscher eine Crowdsourcing-Plattform eingerichtet, auf der die Besucher das Firefighter Robot Game spielen können. Es geht darum, einen Roboter bei der Bekämpfung von brennenden Bäumen zu unterstützen, wobei unter anderem darauf zu achten ist, dass er über ausreichend Löschwasser verfügt und seine Batterie rechtzeitig auflädt. Auf diese Weise soll der Roboter zum Beispiel lernen, den Befehl, einen Brandherd anzusteuern, nicht zu befolgen, wenn der Ladezustand des Akkus das nicht mehr zulässt, und sich stattdessen zur Ladestation begeben. Bisher hätten sie mehr als 86 Stunden Missionszeit erfasst, darunter mehr als 48 Stunden menschlicher Handlungen, sagten Chanel und Drougard.

Mit Robotern, die menschliche Befehle missachten, betreten die Forscher zweifellos heikles Terrain. Der Absturz des Germanwings-Fluges 9525 am 24. März 2015, der vom Piloten in Selbstmordabsicht bewusst herbeigeführt wurde, zeigt aber, dass es durchaus Situationen gibt, in denen eine solche Fähigkeit wünschenswert sein könnte.

Virtuelle Agenten für die Werbung

Ähnlich strittig dürften die Forschungen sein, die Naoto Yoshida (Kansai University) vorstellte. Er geht der Frage nach, ob die Wirksamkeit von Plakatwerbung durch virtuelle Agenten erhöht werden kann. Dafür wurde an einer Wand ein Werbeplakat angebracht und ein sechs Meter breiter und drei Meter hoher Bereich darum herum von einem neun Meter davor aufgestellten Projektor erfasst. Etwas dichter an der Wand befand sich eine Kinect-Kamera.

Wenn sie einen sich nähernden Passanten erfasste, wurde auf die Wand eine menschliche Gestalt projiziert, die etwa einen halben Meter vor dem Passanten auf das Plakat zulief und auf verschiedene Weisen darauf reagierte, etwa das Tempo verlangsamte, stehenblieb, das Plakat nachdenklich betrachtete, sich vielleicht auch Notizen machte. Durch die Befragung von Versuchspersonen wollten die Forscher herausfinden, wie die verschiedenen Verhaltensweisen des virtuellen Agenten auf die Passanten wirkten.

Natürlich ließen sich fast alle von dem Geschehen auf der Wand ablenken, verlangsamten ihren Schritt oder blieben sogar stehen. Aber ob das so bleibt, wenn der Neuigkeitseffekt verpufft ist und die Werbeflächen in den Städten von einer Vielzahl solcher virtuellen Animateure bevölkert sind? Wahrscheinlich werden die umworbenen Konsumenten auch für diese neue Stufe des Wettrüstens im Kampf um Aufmerksamkeit schon bald Abwehrmaßnahmen entwickeln – vielleicht gibt es schon auf der HAI 2019 eine Studie über smarte Brillen, die solche Avatar-Attacken frühzeitig erkennen und gezielt ausblenden. (tiw)