Falsche Trainingsdaten verzerren Güte-Einschätzung von KI-Modellen

Laut einer neuen MIT-Studie sind die zehn am häufigsten verwendeten KI-Datensätze mit vielen, teilweise eklatanten Etikettierungsfehlern behaftet.

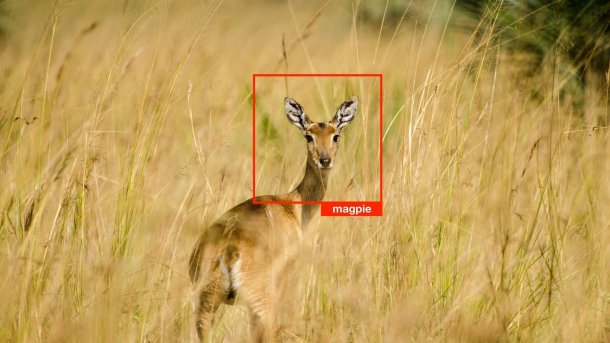

Nein, eine Elster ist das nicht.

(Bild: Jeremy Lwanga / Unsplash)

- Karen Hao

Große Modelldatensätze bilden das Rückgrat der Künstlichen Intelligenz, aber einige sind wichtiger als andere. Denn mit bestimmten Kern-Datasets bewerten Forscher den Fortschritt von Maschinenlern-Modellen. Einer der bekanntesten ist der Bilderkennungsdatensatz ImageNet, der die moderne KI-Revolution mitauslöste. Und auch MNIST gehört dazu: Es stellt Bilder von handgeschriebenen Zahlen von 0 bis 9 zusammen, was bei der Schrifterkennung hilft. Wieder andere Datasets testen Modelle, die darauf trainiert sind, Audio, Text oder Zeichnungen zu erkennen.

Videos by heise

Tags, die daneben liegen

Allerdings haben Studien in den letzten Jahren ergeben, dass diese Datensätze mit schwerwiegenden Mängeln behaftet sein können. ImageNet enthält beispielsweise rassistische und sexistische Label sowie Fotos von Gesichtern, die ohne Zustimmung gesammelt wurden. Die neueste MIT-Studie zum Thema befasst sich nun mit einem weiteren Problem: Viele der Bildetiketten, die sogenannten Tags, sind schlicht und einfach falsch. So wird etwa ein Pilz als Löffel ausgewiesen, ein Frosch als Katze und ein hoher Ton der Sängerin Ariana Grande als Pfiff. Der ImageNet-Testsatz weist eine geschätzte Etikettierfehlerrate von 5,8 Prozent auf. Der Testsatz für QuickDraw, eine Zusammenstellung von Zeichnungen, kommt auf satte 10,1 Prozent.

Wie wurde das untersucht? Jeder der zehn Datasets, die zur Bewertung von Modellen verwendet werden, verfügt über einen eigenen Trainingsdatensatz. Curtis G. Northcutt und Anish Athalye, zwei MIT-Nachwuchsforscher sowie MIT-Absolvent Jonas Mueller entwickelten mithilfe der Trainingsdatensätze ein Modell für maschinelles Lernen und ließen anschließend die Testdaten erneut beschriften. Wenn das Modell-Etikett nicht mit dem des Originals übereinstimmte, wurde der Datenpunkt zur manuellen Überprüfung markiert. Fünf Rezensenten beim Online-Dienst Amazon Mechanical Turk wurden gebeten, darüber abzustimmen, ob das Etikett des neuen Modells oder das Original richtig ist. Stimmte die Mehrheit der Prüfer für die neue Modell-Beschriftung, wurde die des Originals als Fehler gewertet und korrigiert.

Einfach ist besser

Die Forscher prüften insgesamt 34 Modelle, deren Leistung zuvor anhand des ImageNet-Testsatzes gemessen worden war. Dabei ließen sie jedes Modell rund 1500 Beispiele mit falschen Datenbeschriftungen erneut beurteilen. Jene Modelle, die mit den ursprünglichen falschen Etiketten nicht so gut abgeschnitten hatten, gehörten nach der Korrektur zu den besten. Insbesondere die einfacheren Modelle schienen mit korrigierten Daten besser abzuschneiden als die komplizierteren Modelle, die von Technologiegiganten wie Google zur Bilderkennung verwendet werden und als die besten auf diesem Gebiet gelten. Mit anderen Worten: Wir haben möglicherweise eine übertrieben gute Ansicht davon, wie gut diese komplizierten Modelle tatsächlich sind.

Als Fazit ermutigt Northcutt das KI-Feld, sauberere Datensätze zur Bewertung von Modellen und zur Verfolgung des Fortschritts des gesamten Forschungsfeldes zu erstellen. Er empfiehlt seinen Kollegen außerdem, ihre Datenhygiene zu verbessern. Andernfalls, so warnt er, könnten sie das falsche Modell auswählen. Insbesondere dann, „wenn Sie einen Datensatz voller Rauschen haben und damit eine Reihe von KI-Modellen ausprobieren, um sie der realen Welt einzusetzen“. Zu diesem Zweck hat Northcutt den Code, den er in seiner Studie zur Korrektur von Etikettierungsfehlern verwendet hat, als Open-Source-Lösung bereitgestellt. Er sagt, dass er bereits bei einigen großen Technologieunternehmen verwendet wird.

(vsz)