RTX-3090-Schwester mit 150 Watt TDP: Nvidia-Beschleuniger für Server

Nvidia hat die drei GPU-Beschleuniger A30, A16 und A10 aus der Ampere-Baureihe vorgestellt – teils eng verwandt mit den Grafikkarten der Serie GeForce RTX 3000.

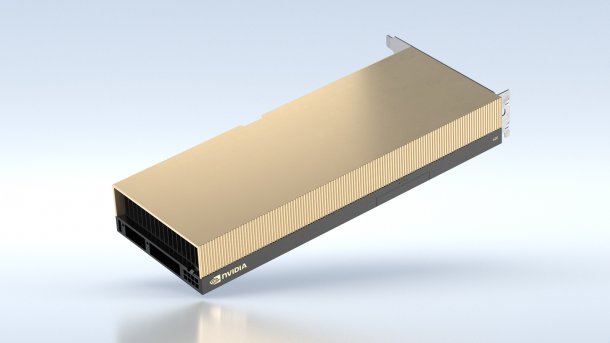

Nvidias A30.

(Bild: Nvidia)

Als Nachfolger der beiden Ampere-Beschleunigerkarten A100 und A40 hat Nvidia am Montag drei weitere Modelle vorgestellt: A30, A16 und A10. Letztere ist eng mit dem Gaming-Topmodell GeForce RTX 3090 verwandt, setzt den Fokus allerdings auf hohe Effizienz statt maximale Rechenleistung. Dem Datenblatt zufolge kommt der gleiche Grafikchip GA102 zum Einsatz, allerdings auf 150 Watt (Thermal Design Power, TDP) abgeriegelt.

Die Differenz von 200 Watt kommt bei den Taktfrequenzen zum Tragen: Nvidia nennt 31,2 FP32-TFlops, gut 13 Prozent weniger als bei der GeForce RTX 3090 (36 TFlops). Die Angaben beziehen sich auf den Boost-Takt, den die A10 bei hoher Auslastung nicht so gut halten dürfte wie das GeForce-Modell. Zudem verbaut Nvidia langsameren, aber weniger stromhungrigen GDDR6-Speicher statt GDDR6X-SDRAM. Die Übertragungsrate zwischen GPU und Speicher sinkt folglich von 936 auf 600 GByte/s.

Videos by heise

Die A10 ist als GPU-Beschleuniger ohne Bildausgänge für Server und Rechenzentren gedacht. Für die Anwendungen dort schaltet Nvidia die Verarbeitung von Datenformaten wie Bfloat16 über die integrierten Tensor-Kerne frei. Grundlegend sollen sich alle Ampere-Modelle gut zum Trainieren von neuronalen Netzen eignen.

(Bild: Nvidia)

HBM2-Stapelspeicher mit 165 Watt TDP

Die A30 entspricht einer abgespeckten A100 mit HBM2-Stapelspeicher – vergleichbare GeForce-Grafikkarten gibt es nicht. Die Rechenleistung der A30 ist mit 5,2 FP64-TFlops beziehungsweise 10,3 FP32-TFlops nahezu halbiert, zudem ist weniger und langsamerer Speicher verbaut. 24 GByte HBM2 erreichen zusammen 933 GByte/s, was mit drei 8-GByte-Stacks möglich wäre. Bei der A100 kommen in der schnellsten Version 80 GByte HBM2e mit etwas mehr als 2 TByte/s zum Einsatz. Dafür nimmt die A30 maximal 165 Watt auf – die A100 je nach Version 250 bis 400 Watt.

Zum dritten Neuling im Bunde schweigt sich Nvidia weitgehend aus. Die A16 stellt eine Multi-GPU-Karte mit vier Mittelklasse-Grafikchips und zusammen 64 GByte GDDR6-Speicher dar. Die maximale Leistungsaufnahme liegt bei 250 Watt. Für Spieler wäre eine solche Karte mangels Multi-GPU-Optimierungen unspannend; Compute-Berechnungen skalieren hingegen gut.

Server mit viel HBM2(e)

Im Zuge der virtuellen Hausmesse GTC 2021 hat Nvidia noch zwei weitere Server-Komplettsysteme angekündigt. Die DGX Station 320G setzt auf vier 80-GByte-Versionen des A100-Beschleunigers mit aufaddiert namensgebenden 320 GByte HBM2e-RAM. CPU-seitig bleibt mit AMDs 64-Kerner Epyc 7742 aus der Zen-2-Generation alles beim Alten. Kostenpunkt: 149.000 US-Dollar. Der DGX Superpod kommt in Form einer Reihe von Server-Schränken mit insgesamt 1125 A100-80G-GPUs daher.

(Bild: Nvidia)

(mma)