Maschinelles Sehen: Der Cortex als Blaupause

Deep-Learning-Algorithmen, die sich am menschlichen Sehen orientieren, verbessern die digitale Bildverarbeitung und -rekonstruktion in der Medizin.

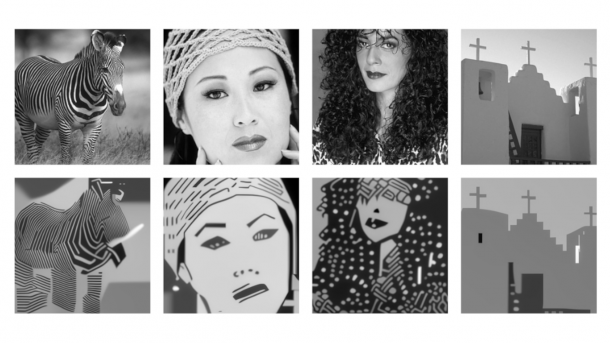

(Bild: Pock – TU Graz/ICG)

- Carina Schipper

Menschen können Bilder und Objekte in Sekundenbruchteilen verarbeiten, selbst wenn diese kaum oder nur bruchstückhaft zu sehen sind. Verantwortlich dafür ist der visuelle Cortex im Gehirn. Mithilfe seiner hocheffizienten hierarchischen Schichtenarchitektur filtert er visuelle Informationen, erkennt Zusammenhänge und vervollständigt das Bild anhand vertrauter Muster, erklären Forscher der TU Graz. Den gesamten Prozess dahinter hat die Wissenschaft noch nicht entschlüsselt, aber man setzt Teile dessen schon jetzt im ML-Umfeld ein.

Deep-Learning-Algorithmen ziehen bei gewissen Mustererkennungsaufgaben inzwischen mit der menschlichen Leistungsfähigkeit gleich oder übertreffen sie sogar. Allerdings hat die Sache einen Haken: Man kann kaum nachvollziehen, was sie gelernt haben, wie sie funktionieren oder wann sie Fehler machen.

Das ERC-Starting-Grant-Projekt HOMOVIS (High Level Prior Models for Computer Vision) am Institut für Maschinelles Sehen und Darstellen der TU Graz geht diesem mangelnden Verständnis auf den Grund. Im Zentrum steht die Frage, wie man bekannte Arbeitsweisen des visuellen Cortex mithilfe mathematischer Modelle berechnen und auf Bildverarbeitungsanwendungen übertragen kann.

Anregungen bei Wertheimer und Euler

Als eine der Arbeitsgrundlagen diente den Grazer Forschern die Gestaltgesetze der Wahrnehmung von Max Wertheimer. Das Konzept des Hauptbegründers der Gestaltpsychologie versucht den Prozess des menschlichen Sehens zu erklären. Ihm zufolge baut der Mensch Reize und Sinneseindrücke zu einem großen Ganzen zusammen. "Der Mensch kann schon anhand einzelner Punkte oder subjektiver Konturen (Scheinkonturen) lückenhafte oder unvollständige Objekte korrekt erkennen. Das menschliche Gehirn ergänzt die fehlende Bildinformation automatisch. Beispielsweise, indem es die Punkte über möglichst glatte Kurven miteinander verbindet", berichtet TU-Projektleiter Thomas Pock.

Videos by heise

Seinem Team ist es erstmals gelungen, Phänomene der Gestaltfindung mithilfe mathematischer Modelle zu beschreiben. Sie basieren auf Leonhard Eulers Elastica. Durch die Gleichung lassen sich Kurven minimalster Krümmung berechnen.

Darstellung in einem höherdimensionalen Raum

Ausgehend von Eulers Elastica entwickelte man in Graz neue Algorithmen, die bestimmte krümmungsabhängige Bildverarbeitungsprobleme lösen, indem sie (2-D-)Bilder und deren Merkmale als Datenpunkte in einem dreidimensionalen Raum darstellen. Daraus ergibt sich mit der Erfassung der Objektkanten eine zusätzliche Variable. Auch dabei orientieren sich die Forscherinnen am menschlichen Sehen. Die Nobelpreisträger David Hubel und Torsten Wiesel fanden 1959 heraus, dass der visuelle Cortex aus orientierungssensitiven Schichten aufgebaut ist.

Aus mathematischer und informatischer Sicht liegt der größte Vorteil dieser dreidimensionalen Einbettung darin, dass sich Bildverarbeitungsprobleme mithilfe konvexer Optimierungsalgorithmen lösen lassen, heißt es aus Graz. In der mathematischen Optimierung bildet die Grenze zwischen konvexer und nicht konvexer Optimierung die große Hürde, die lösbare von nicht lösbaren Problemen unterscheidet.

Momentan arbeiten die Wissenschaftler an verbesserten Modellen, die die bekannten strukturellen Eigenschaften des visuellen Cortex mit Deep-Learning-Algorithmen kombinieren. Sie wollen Modelle entwickeln, die genauso gute Ergebnisse liefern wie derzeitige Deep-Learning-Algorithmen, aber zu einem tieferen Verständnis über die gelernten Strukturen führen. Bei der Rekonstruktion von Computertomografien und Magnetresonanzbildern lassen sich laut Pock bereits Erfolge vorweisen: "Mit den neu entwickelten Algorithmen lassen sich nun trotz weniger aufgenommener Daten Bilder mit höchster Qualität rekonstruieren. Das spart Zeit und Rechenleistung und somit auch Kosten."

(csc)