H100 NVL: Nvidias Speichergigant fürs KI-Training

Erstmals aktiviert Nvidia bei einer Hopper-GPU den sechsten Speicher-Controller. Damit steigt die Übertragungsrate auf enorme 3,9 TByte/s.

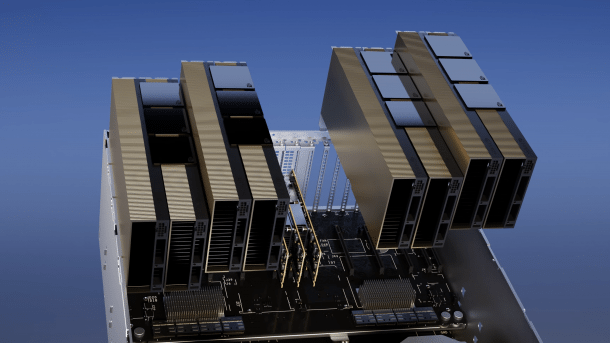

Vier Doppelpack-H100-NVL in einem Server.

(Bild: Nvidia)

Nvidia legt eine neue Version seiner Hopper-GPU H100 mit mehr und schnellerem Speicher auf: Die H100 NVL verwendet sechs statt fünf HBM3-Speicherstapel. Eine H100 NVL kommt so auf eine Speicherkapazität von 94 GByte und eine Übertragungsrate von 3,9 TByte/s. Zwei Modelle im Doppelpack sind über NV-Links miteinander verbunden und stellen zusammen 188 GByte bereit.

Zum Vergleich: Das aktuelle Desktop-Topmodell GeForce RTX 4090 begnügt sich mit 24 GByte GDDR6X-RAM, das gut 1 TByte/s übertragen kann.

Schon die bisherigen H100-Varianten hatten physisch sechs HBM3-Stapel für das SXM5-Modul beziehungsweise HBM2e-Stapel auf der PCI-Karte, allerdings blieb ein Stapel stets ungenutzt, um die Ausbeute funktionstüchtiger Exemplare zu erhöhen. Im Falle der H100 NVL werden zu diesem Zweck von den sechsmal 16 GByte HBM3 nur noch 2 GByte deaktiviert, wie uns Nvidia auf Nachfrage bestätigte. Offenbar ist bei einem HBM3-Stapel eine einzige Speicherlage inaktiv.

Videos by heise

KI-Training im Fokus

Nvidia bewirbt die H100 NVL explizit zum Training großer KI-Modelle – ChatGPT wird als Beispiel angeführt. Dementsprechend legt der Hersteller den Fokus auf die integrierten Tensor-Kerne: Im FP16-Format sollen sie 1979 Teraflops erreichen, bei nochmals halbierter FP8-Genauigkeit den doppelten Wert, also 3958 Teraflops. In klassischen Workloads stemmen die Shader-Kerne wie die SXM5-Version 34 FP64- beziehungsweise 67 FP32-Teraflops.

(Bild: Nvidia)

Das spricht für den gleichen Chipausbau wie bei der SXM5-Version der H100-GPU mit 132 Shader-Multiprozessoren, 16.896 Shader-Kernen, 528 Tensor-Cores und einem Rechentakt von rund 1,8 GHz. Der Chipauftragsfertiger TSMC fertigt die 814 mm² riesige GPU im 4-Nanometer-Prozess 4N.

Unter Dauerlast dürfte die H100 NVL je nach Anwendung allerdings langsamer sein als die bisherige H100 SXM5, da Nvidia die maximale Leistungsaufnahme von 700 auf 350 bis 400 Watt absenkt. Das wiederum dürfte der Effizienz zugutekommen.

Die H100 NVL kommt ausschließlich als PCI-Express-5.0-Steckkarte. Als GPU-Beschleuniger hat das Modell keine Bildausgänge; zudem fehlen ihr Lüfter, sodass sie zwingend auf eine starke Gehäusebelüftung angewiesen ist. Nvidia erwartet Partnersysteme für Server und Rechenzentren, die bis zu acht H100-NVL-GPUs verwenden. Zu den Preisen äußert sich Nvidia noch nicht.

(mma)