Quantencomputer: Wie Fujitsu instabile Qubits in den Griff bekommen will

Der Technikkonzern Fujitsu versucht das Problem der instabilen Qubits durch die Kombination mit Hochleistungscomputing zu verbessern.

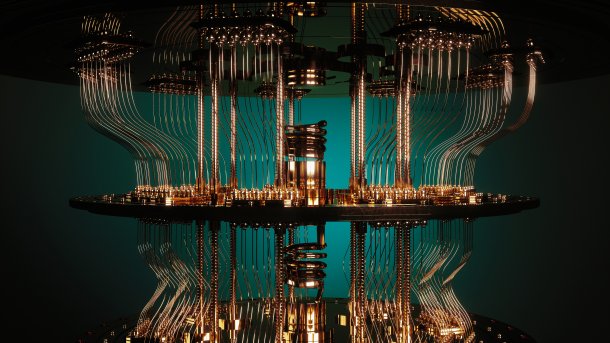

(Bild: Bartlomiej K. Wroblewski / Shutterstock.com)

- Martin Kölling

Das Rennen um den Quantencomputer gewinnt an Fahrt. Anfang Oktober haben der japanische Technologiekonzern Fujitsu und das Grundlagenforschungsinstitut Riken ihre neue Quantencomputer-Plattform für Forschungseinrichtungen und Unternehmen geöffnet. Sie kombiniert einen gemeinsam entwickelten 64-Qubit-Quantencomputer mit einem von Fujitsu entwickelten Quantensimulator, der mit Hilfe des konzerneigenen Supercomputers Fugaku 40 stabile Qubits imitieren kann. Diese "hybride Plattform", wie Fujitsu sie nennt, soll die Fehleranfälligkeit heutiger Quantensysteme ausgleichen.

Quantencomputer nutzen quantenmechanische Phänomene Verschränkung, um Berechnungen für bestimmte Anwendungen um ein Vielfaches schneller durchzuführen als klassische Computer. Der Bau zuverlässiger und skalierbarer Quantencomputer hat sich jedoch als enorme Herausforderung erwiesen. Die meisten Experten sind sich einig, dass es noch Jahre dauern wird, bis ein fehlertoleranter Quantencomputer mit mehr als einer Million Qubits gebaut werden kann, der in der Lage ist, klassische Supercomputer in praktischen Anwendungen zu übertreffen.

Videos by heise

Zahlreiche Technologieunternehmen wie IBM, Google, Microsoft und Start-ups wie Rigetti und IonQ arbeiten daran, die Zahl der Qubits zu erhöhen und Fehler zu reduzieren. IBM hatte im November letzten Jahres einen Quantenprozessor mit 433 Qubits vorgestellt und will laut seiner eigenen Roadmap noch in diesem Jahr erstmals einen Quantenchip mit mehr als 1000 Qubits präsentieren. Auch Intel ist mittlerweile mit von der Partie: Der Chiphersteller präsentierte in diesem Sommer unter der Bezeichung "Tunnel Falls" einen Quantenchip. Der hatte zwar nur 12 Qubits – der Chip steht in den USA zu Forschungszwecken zur Verfügung – laut Intel soll die darin verwendete Technologie aber besser skalieren als die supraleitenden Qubits von IBM und Google, so dass Intel hier schnell aufholen will

Der Leiter des Quantenlabors von Fujitsu, Shintaro Sato, sieht auch den eigenen Konzern im Quanten-Rennen gut positioniert. "Ich glaube, wir können aufholen", sagt er bei der Vorstellung der neuen Plattform. Fujitsus anvisiertes Ziel ist es, sein Modell bis 2026 auf 1000 Qubits zu erweitern. Nach Einschätzung von Sato werden aber noch zehn Jahre oder mehr vergehen, bis es einen fehlertoleranten Quantencomputer gibt.

Skalierbarkeit und Fehlerkorrektur

Zwei Entwicklungen stimmen Sato besonders hoffnungsvoll: die Skalierbarkeit von Fujitsus Qubits und die Fortschritte bei der Fehlerkorrektur durch die Hybridplattform. Beim Quantenchip von Fujitsu werden Kabel und Sensoren von der Rückseite an den Chip herangeführt. Dadurch können die Qubits dicht gepackt und laut Sato einfach ergänzt werden.

Eine der Hürden ist die Fehleranfälligkeit der Qubits. Das Quantenrauschen beeinträchtigt bisher die Genauigkeit der Rechner massiv. Quantencomputer sind anfällig für Rauschen aus verschiedenen Quellen, wie elektromagnetische Felder von WiFi oder Mobiltelefonen, kosmische Strahlung, aber auch dem Einfluss benachbarter Qubits aufeinander. Diese Störungen führen dazu, dass die Informationen, die ein Qubit enthält, sich ändern können. Zudem können die Qubits bei der Durchführung einer Quantenlogikoperation auch Fehler erleiden.

Zusammen mit der noch sehr begrenzten Zahl an Qubits in heutigen Quantencomputer hat das zur Folge, dass die zur Zeit existierenden Quantencomputer nur wenige spezielle Probleme lösen können, große Berechnungen aber noch nicht genau genug durchführen, erklärt Sato.

Als Beispiel nennen die Forscher die Berechnung von Molekülen. Bei kleinen Molekülen ist der Quantenalgorithmus viel effizienter als klassische Rechenmethoden. Doch bei großen Molekülen nimmt das Rauschen so stark zu, dass klassische Hochleistungsrechner überlegen sind.

Kombination mit Quantensimulator

Als Zwischenlösung setzen Unternehmen wie IonQ, Rigetti Computing und neuerdings auch Microsoft und IBM auf die Kombination von Quantencomputern und Simulatoren. Ein Alleinstellungsmerkmal von Fujitsu ist der Einsatz des konzerneigenen Supercomputers Fugaku, der derzeit die Nummer zwei unter den Supercomputern ist. Ein "Workload Broker" teilt die Berechnungen zwischen der Quantencomputer-Plattform und dem Simulator auf. Fujitsu sieht den aktuellen Simulator als Höhepunkt der Entwicklung. Der Simulator kann derzeit 40 Qubits fehlerfrei simulieren.

Aktuell kann der hybride Quantencomputer von Fujitsu die Energieniveaus kleiner Moleküle bereits deutlich schneller berechnen als ein Supercomputer. Bei großen Molekülen braucht er wegen der vielen Fehler allerdings länger. Durch die Kombination mit Simulatoren kehrt sich das Verhältnis jedoch wieder um. Das Problem: Die Technik stößt an ihre Grenzen. "Es ist schwierig, den Quantensimulator weiter zu verbessern", sagt Sato.

Vivek Mahajan, Technikchef von Fujitsu, glaubt, dass trotz des großen Hypes und der enormen Investitionen in die Quantenphysik größere praktische Anwendungen noch Jahre entfernt sein dürften. "Zumindest vorläufig glauben wir nicht, dass Quantencomputer herkömmliche Computer ersetzen werden", sagt er. Mehr noch: "Wir glauben, dass das Hochleistungsrechnen, die herkömmliche Datenverarbeitung und Quantencomputer nebeneinander existieren werden, selbst wenn das Quantencomputing ausgereift ist."

(jle)