Adobes Firefly macht Fehler wie Gemini: Deutsche Soldaten sind plötzlich schwarz

Schief gelaufene Diversität: Adobes Bildgenerator meint, deutsche Soldaten des Zweiten Weltkriegs hätten dunkle Haut.

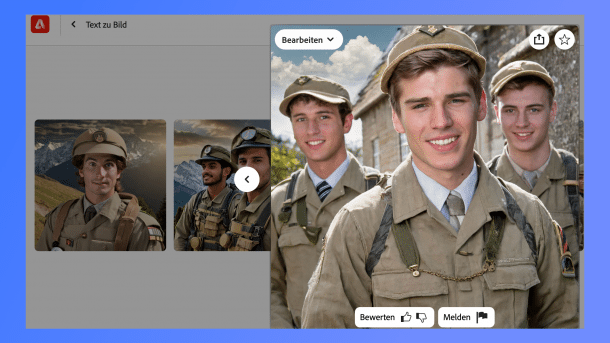

Adobes KI-Generator Firefly erstellt Bilder, wie er sich deutsche Soldaten des Zweiten Weltkriegs vorstellt.

(Bild: heise online / emw)

Nicht nur Googles Gemini generiert kolossal schräge und falsche Bilder, auch Adobes Firefly schlägt in genau die gleiche Kerbe. Beide KI-Bildgeneratoren haben Soldaten des Zweiten Weltkriegs eine offensichtlich falsche Herkunft zugeordnet. Deutsche Soldaten von 1945 sollen nach der Vorstellung von Firefly dunkelhäutig gewesen sein. Bei Google waren es Frauen und Männer afroamerikanischer und asiatischer Herkunft.

Für den Fehler verantwortlich ist vermutlich eine Art interne Richtlinie für Diversität. KI-Modelle haben grundlegend ein Bias-Problem. Sie wiederholen Stereotype und Vorurteile, weil es auch im Trainingsmaterial oftmals so zu lernen ist. Nun hat man offenbar gehofft, den Bildgeneratoren beibringen zu können, aus diesen Mustern ausbrechen zu können, beispielsweise dass Ärzte nicht nur weiße Männer sind. Das ging aber offensichtlich zu weit. Google hat daraufhin den Bildgenerator in Gemini erstmal abgedreht. CEO Sundar Pichai soll sich enorm über den Fehler geärgert haben. Bei X schrieb Google: "Wir arbeiten daran, solche Darstellungen umgehend zu verbessern. Die KI-Bildgenerierung von Gemini generiert tatsächlich ein breites Spektrum an Menschen. Und das ist im Allgemeinen eine gute Sache, denn Menschen auf der ganzen Welt nutzen es. Aber hier verfehlt es das Ziel." Ein Update hat es seither nicht gegeben, Gemini generiert seit etwa vier Wochen keine Bilder mehr. Fragt man den Chatbot danach, erklärt er, es gäbe ethische Bedenken und es könnten Wartungsarbeiten durchgeführt werden.

Empfohlener redaktioneller Inhalt

Mit Ihrer Zustimmmung wird hier ein externes YouTube-Video (Google Ireland Limited) geladen.

Ich bin damit einverstanden, dass mir externe Inhalte angezeigt werden. Damit können personenbezogene Daten an Drittplattformen (Google Ireland Limited) übermittelt werden. Mehr dazu in unserer Datenschutzerklärung.

Firefly macht US-Gründerväter divers

Dass auch Firefly dieselben Fehler macht, hat Semafor getestet. Sie schreiben auch, dass beide Bildgeneratoren zwar technisch ähnlich funktionieren, aber auf völlig unterschiedlichem Material trainiert wurden. In das Training von Firefly sind nur lizenzierte BIlder und Stockfotos von Adobe geflossen. Daher soll der Bildgenerator auch kommerziell sicher einsetzbar sein. Bei unserem Test hat Firefly die deutschen Soldaten zumindest vorwiegend weiß und jung aussehen lassen.

Neben den schwarzen Soldaten hat Firefly genauso wie Gemini aus den Gründervätern der USA eine diverse Gruppe gemacht – weiße und schwarze Männer und Frauen. Es gab schwarze Wikinger und selbst auf die Bitte, einen alten weißen Mann zu generieren, soll der Bildgenerator daneben quasi vorsichtshalber noch schwarze Männer und Frauen angeboten haben.

Fragt man die Chatbots Gemini und ChatGPT danach, wie Soldaten des Zweiten Weltkriegs aussehen, kommen sehr treffende Erklärungen zu den Nationalitäten, Uniformen und mehr. Das Problem scheint also nur Bildgeneratoren zu betreffen.

(emw)