Google I/O: Barrierefreie Apps zahlen sich aus

Barrierefreiheit hilft dem Machine Learning, Machine Learning verhilft zu mehr Barrierefreiheit. Entwickler sollen Apps von Beginn an barrierefrei konzipieren.

Szene der Google I/O 2017

(Bild: Daniel AJ Sokolov)

"Rückmeldungen von Endanwendern mit Behinderungen sind entscheidend. Holen Sie sich Rückmeldungen während der Designphase, während der Programmierarbeit und bei Tests vor der Veröffentlichung ihrer App", empfiehlt Googler Scott Adams allen Android-Entwicklern, "Nicht nach dem Release. Das dauert länger, aber Sie stellen dadurch ein besseres Produkt her." Automatische Tests sind zwar hilfreich, reichen alleine jedoch nicht aus. Gleichzeitig hilft barrierefreie Gestaltung an unerwarteter Stelle.

Eine Milliarde Menschen ist in der einen oder anderen Weise motorisch oder Sinnes-eingeschränkt. Hinzu kommen situationsbedingte Einschränkungen, die jeden treffen. Beispielsweise wenn man in hellem Sonnenlicht eine Bildschirmanzeige nicht deuten kann, aufgrund lauten Lärms Tonausgaben nicht hört, oder einfach eine Taste nicht drücken kann, weil man beide Hände voll hat. Daher investiert Google laufend in Barrierefreiheit und setzt immer stärker auf maschinelles Lernen.

Zusätzlich hat sich der Datenkonzern nun die Unterstützung Samsungs gesichert. Gemeinsam haben sie dem Android-Screenreader Talkback das größte Update seit seiner Einführung vor zwölf Jahren verschafft. Es gibt ein Dutzend neue Fingergesten, von denen die meisten anpassbar sind. Außerdem arbeiten Talkback und die Sprachsteuerung Voice Access nun zusammen, so dass Talkback Sprachbefehle umsetzen kann.

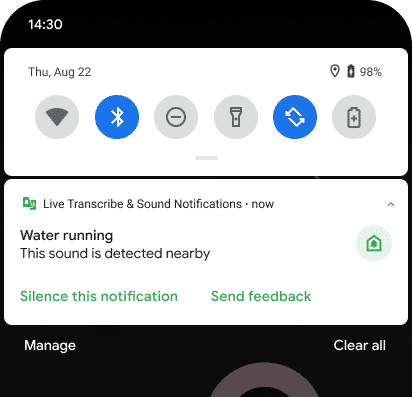

Mehr Sprachen und Geräusche für Live Transcribe

Die Sprach- und Geräuscherkennungs-App Live Transcribe hat ebenfalls ein Update erfahren. Sie unterstützt inzwischen mehr als 80 Sprachen und Dialekte, die noch dieses Jahr offline funktionieren sollen. Es müssen dann keine Tonaufnahmen auf irgendwelche Server übertragen werden. Bereits jetzt können Anwender direkt in der selben App Text eingeben, was Dialoge wesentlich erleichtert, und dem Wörterbuch eigene Worte hinzufügen.

Geräuscherkenung mit Androids Live Transcribe (5 Bilder)

(Bild: Google)

Außerdem soll Live Transcribe bald auch bei der Geräuscherkennung individuell angepasst werden können. Hat ein Haushalt beispielsweise eine ungewöhnliche Türklingel, die wie Vogelgezwitscher klingt, kann das Handy darauf trainiert werden, um den gehörlosen Nutzer in der Folge auf das "Klingeln" aufmerksam zu machen. Lebensrettend kann die Verbindung mit Wearables sein, etwa wenn ein Feueralarm erkannt und der Benutzer über den Vibrator seiner Smartwatch geweckt wird.

Zu schwierig ist nach wie vor die getrennte Spracherkennung zweier Personen in einer Unterhaltung oder einem Interview. Häufig überlappen sich die gesprochenen Worte, was die künstliche Intelligenz (KI) verwirrt. In diesem Bereich hat sich offenbar die österreichische Philips Speech einen Vorsprung erarbeitet. Deren SmarktMike Duo erfasst und transkribiert als erstes Gerät menschliche Dialoge in Echtzeit sprechergetrennt.

Barrierefreiheit ist SEO

Für fehlsichtige Android-Nutzer kommt alsbald eine neue Lupe, die nur einen Ausschnitt des Bildschirms vergrößert, während der Rest im Hintergrund in Originalgröße sichtbar bleibt. Die alte Lupe, die den gesamten Bildschirm vergrößert, bleibt parallel erhalten. Bereits auf manche Handys ausgerollt ist ein Update der Bildschirmhelligkeit: Diese lässt sich nun besonders weit herunterregeln. Das erleichtert das Lesen in sehr dunklen Umgebungen und allgemein für lichtempfindliche Menschen – wer unter Migräne leidet, wird es Google danken.

Programmierer erinnert Google daran, auf die Grundbausteine zu achten. Dazu zählen unter anderem gute Kontraste zwischen Vorder- und Hintergrund (in der Regel mindestens 4.5:1), ausreichend große Touchfelder, Alt-Texte für Bilder und ordentliche Label für Icons und andere grafische Elemente. Diese im Sourcecode enthaltenen Beschreibungen sind übrigens nicht nur für Screenreader unabdingbar, sondern auch für die Umsetzung von Sprachbefehlen – und sie unterstützen die maschinelle Analyse der Webseite oder App.

Barrierefreiheit ist also auch Optimierung für Suchmaschinen – die immer öfter innerhalb von Apps crawlen. Im neuen Page Experience Ranking legt Googles Suchmaschine besonderes Augenmerk auf Barrierefreiheit. Entfallen können Label allerdings für Elemente, mit denen der User nicht interagieren kann und die Screenreader sowie Sprachsteuerung ausdrücklich ignorieren sollen.

Neue Unterstützung für Entwickler

Um Programmierern barrierefreie Gestaltung ihrer Apps zu erleichtern, geht Google daran, das Accessibility Test Framework for Android (ATF) in Android Studio zu integrieren. Bisher gibt es ein kostenlos ATF Scanner Toll im Play Store, sowie Integration in die Testsuiten Espresso und Robolectric. Nun hat ATF auch in die Canary Builds des Android Studio Einzug gehalten und soll "bald" in der stabilen Version ankommen.

Dort weist ATF auf mögliche Probleme hin, unterbreitet Lösungsvorschläge und stellt auch einen Link zur einschlägigen Dokumentation bereit. "Das ist kein Ersatz für manuelle Tests", warnte allerdings Googler Shailen Tuli. "Automatisierte Überprüfungen haben ihre Grenzen. Zum Beispiel können sie sehen, ob es ein Label gibt, aber nicht, ob das Label Sinn hat."

Maschinelles Labeln mit Datenschutz

Parallel setzt Google auf maschinelles Lernen: Anfang des Jahres hat es der Sprachsteuerung Voice Access ein Bilderkennungssystem namens IconNet hinzugefügt. Es versucht, auf dem Bildschirm angezeigte Icons zu erkennen und Sprachbefehlen zugänglich zu machen – das geschieht komplett lokal auf dem Handy. IconNet verrät Google also nichts über den Bildschirminhalt.

(Bild: Google)

Hat die Bilderkennung anfangs gut 30 Icons erkannt, sind es neuerdings mehr als 70. Das hat zwei Vorteile: Einerseits bekommen diesen Icons auch dann ein Label, wenn der Entwickler darauf verzichtet oder es vergessen hat. Und zweitens werden die Bezeichnungen für Sprachbefehle vereinheitlicht. Von Entwicklern bereits vergebene Label funktionieren weiterhin, auch wenn sie anders heißen.

KI für Blinde nachgeschärft

Fortschritte meldet Google bei der App Lookout, die für Blinde und Sehschwache konzipiert ist. Lookout nutzt die Smartphone-Kamera und künstliche Intelligenz (KI), um Objekte in der Umgebung sowie Strichcodes zu erkennen. Das Unternehmen hat die Algorithmen durch Adversarial Attacks gehärtet und aktiv nach unfairen Voreingenommenheiten (unfair bias) gesucht.

Lesen Sie bei heise Developer:

Stolpersteine bei mobilen Anwendungen überwinden

- Teil 2: Praktische Umsetzung für Android

Außerdem wurden Ergebnisse aus Nutzertests eingearbeitet: Je nach dem, was ein Algorithmus erkennen soll, ist unterschiedliches Feintuning angezeigt. Die KI zur Erkennung von Dollarnoten muss möglichst exakt arbeiten und soll, wenn sie sich nicht sicher ist, lieber gar nichts ausgeben. Andernfalls könnte ein Blinder dazu verleitet werden, statt einem Dollar hundert Dollar zu reichen.

Die KI zur Erkennung von Möbeln hingegen soll Objekte auch dann einordnen, wenn sie sich nicht ganz sicher ist. Ob es sich um einen Ohrensessel oder ein Sofa handelt, ist zweitrangig. Wichtig ist für blinde Benutzer, dass ein großes Hindernis im Raum steht, und dass es sich wahrscheinlich um ein Wohnzimmer, jedenfalls nicht um ein Badezimmer handelt. Ebenfalls für Blinde interessant: Googles Braille Keyboard unterstützt nun auch Arabisch und Spanisch.

Computer lernt Gebärdensprache

Zur freien Verfügung (Lizenz Apache 2.0) gestellt hat Google im April sein Project Shuwa (japanisch für Gebärdensprache). Dabei handelt es sich um ein Framework zur automatischen Erkennung von Gebärden samt Gesichtsausdrücken und Körperbewegungen in kurzen Videos. Das soll eines Tages ein Baustein für automatische Übersetzung von Gebärdensprache werden.

Trainiert ist Project Shuwa bisher auf die Gebärdensprachen Japans und Hongkongs. Wer möchte, kann sich mit Project Shuwa nun an eine der über 150 weiteren Gebärdensprachen wagen.

(ds)