KI-Beschleuniger für Server mit XDNA-Technik des AMD Ryzen 7040U

Gigabyte packt 16 KI-Inferencing-Beschleuniger vom Typ AMD Alveo V70 mit XDNA-Technik in einen Rackserver. Die Karten sollen Video- und Sprachdaten analysieren.

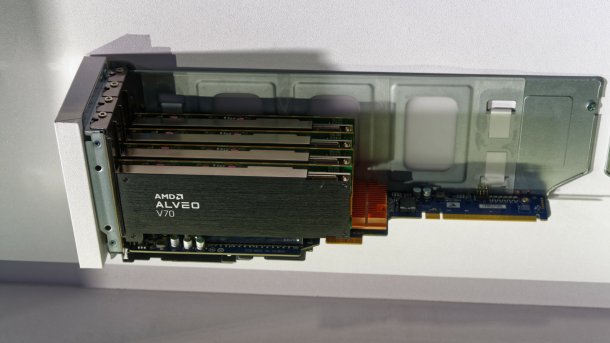

Vier KI-Beschleuniger vom Typ AMD Alveo V70 für Server.

(Bild: c’t-Magazin)

Für die Echtzeitanalyse von Videos oder auch zur Sprachverarbeitung im Rechenzentrum brauchen Server schnelle und effiziente KI-Inferencing-Beschleuniger. AMD hatte schon zur CES den Alveo V70 angekündigt, den es als PCIe-Karte der 75-Watt-Klasse gibt. Auf der Computex zeigte Gigabyte einen Server mit zwei AMD Epyc 9004, der bis zu 16 dieser Alveo-V70-Beschleuniger aufnimmt. Jede Karte liefert laut AMD/Xilinx bis zu 202 BFloat16-Tera-OPS (202 TOps) und bei INT8 sogar 404 TOps.

(Bild: c’t-Magazin)

Als Programmierschnittstelle stellt AMD/Xilinx via GitHub das Unified Inference Frontend (UIF) 1.1 bereit, das Machine-Learning-Frameworks wie ONNX, PyTorch, TensorFlow und Windows ML optimal an die Hardware anbinden soll. Für die Zukunft ist der AMD Unified AI Stack 2.0 geplant.

XDNA-Technik auch im Mobilprozessor Ryzen 7040U

Während die meisten Smartphone-Chips bereits KI-Inferencing-Beschleuniger wie Apples Neural Engine (ANE) enthalten, kommen solche Einheiten bei x86-Prozessoren von AMD und Intel erst auf den Markt. Allerdings beherrschen die AVX-Einheiten moderner x86-CPUs KI-Befehle wie VNNI und die GPU-Shader integrierter Grafikprozessoren lassen sich ebenfalls fürs Inferencing einspannen.

Doch erst mit Intel Meteor Lake und AMD Ryzen 7040U alias Phoenix kommen x86-Mobilprozessoren mit dedizierten KI-Einheiten, die Intel VPU nennt und AMD "Ryzen AI" beziehungsweise XDNA. Das "X" bezieht sich auch auf die zugekaufte FPGA-Sparte Xilinx, die die "Versal AI Cores" seit einigen Jahren entwickelt.

Microsoft arbeitet an der Integration von Machine-Learning-Beschleunigern ins Betriebssystem Windows und stellte dazu vor 5 Jahren die API Windows ML (WinML) mit ONNX vor. In Windows 11 sind beispielsweise die Windows Studio Effects zur Echtzeitverarbeitung von Webcam-Bildern enthalten, die WinML/DirectML nutzen.

(ciw)