Microsoft Cobalt und Maia: ARM-CPU und KI-Beschleuniger für die Azure-Cloud

Schon lange wurde spekuliert, dass auch Microsoft hauseigene Chips entwickelt; nun kündigt das Unternehmen Cobalt 100 und Maia 100 für 2024 an.

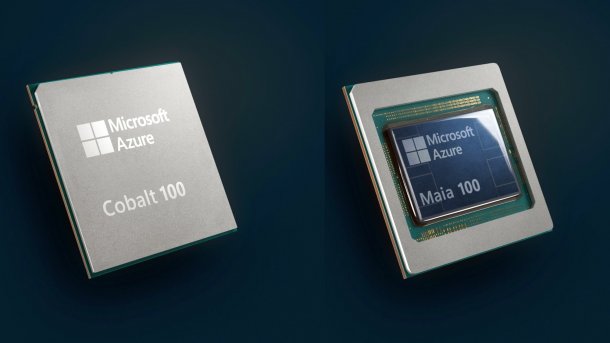

Der ARM-Prozessor Microsoft Azure Cobalt 100 und der KI-Beschleuniger Azure Maia 100.

(Bild: Microsoft)

Auf der "Hausmesse" Ignite lässt Microsoft die Chip-Katze aus dem Sack: Die Firma hat nicht nur einen eigenen ARM-Prozessor für die Azure-Cloud entwickelt, sondern auch einen KI-Beschleuniger. Zur Eröffnung der Ignite stellt das Unternehmen die neue Hardware in diesen Minuten vor.

Die ARM-CPU Microsoft Azure Cobalt 100 und der KI-Prozessor Microsoft Azure Maia 100 sollen ab 2024 zum Einsatz kommen. Zunächst will Microsoft die eigenen Chips für eigene Dienste verwenden, also nicht als Basis für mietbare Cloud-Instanzen. Außerdem will man sie für OpenAI-Dienste einspannen.

Laut Microsoft ist Maia sowohl für KI-Training als auch für Inferencing nutzbar. Genauere Angaben zu Rechenleistung, RAM-Ausstattung oder Leistungsaufnahme macht Microsoft bisher nicht. Das Produktfoto deutet auf modulare Chiplet-Bauweise hin.

Microsoft Azure gehört zu den größten Cloud-Anbietern von Instanzen mit KI-Beschleunigern, insbesondere mit den besonders begehrten Nvidia-H100-Chips. Microsoft kündigte auf der Ignite auch neue Azure-Instanzen mit anderen KI-Beschleunigern an, etwa mit AMD Instinct MI300X und ab kommendem Jahr mit Nvidia H200.

Microsoft folgt der Meute

Nach Amazon (CPU-Serie Graviton) und Alibaba (XuanTie) ist Microsoft nun der nächste große Cloud-Dienstleister, der eigene ARM-Prozessoren einsetzen möchte. Microsoft sammelt bereits Erfahrungen mit ARM-Instanzen und offeriert welche auf Prozessoren der Firma Ampere (Altra/Altra Max).

(Bild: Microsoft)

Dienste auf solchen ARM-Chips werden typischerweise billiger vermietet als auf x86-Prozessoren von AMD und Intel. Vermutlich nutzen die Cloud-Hyperscaler die ARM-Technik jedoch auch strategisch, um höhere Rabatte bei AMD und Intel herauszuschlagen.

AMD und Intel kontern wiederum mit eigenen "Cloud-Native"-Serverprozessoren mit sehr vielen x86-Kernen wie AMD Epyc 9004 "Bergamo" (bis zu 128 Kerne) und dem 2024 kommenden Intel Sierra Forest (bis zu 288 Kerne). AMD und Intel verkaufen mehr als die Hälfte ihrer Serverprozessoren an Cloud-Dienstleister, die meisten an die großen Hyperscaler.

Noch mehr Cloud-Hyperscaler entwickeln eigene KI-Beschleuniger, etwa Google (TPU), Amazon (Inferentia/Trainium), Alibaba (Hanguang), Baidu (Kunlun) und Huawei (Ascend). Gleichzeitig gibt es eine Vielzahl an anderen KI-Chips, während allerdings Nvidia den Markt dominiert. Welche Technik sich in Rechenzentren durchsetzen wird, ist derzeit schwer absehbar.

Hören Sie dazu auch: Podcast Bit-Rauschen, Folge 2023/10

Empfohlener redaktioneller Inhalt

Mit Ihrer Zustimmmung wird hier ein externer Podcast (Podigee GmbH) geladen.

Ich bin damit einverstanden, dass mir externe Inhalte angezeigt werden. Damit können personenbezogene Daten an Drittplattformen (Podigee GmbH) übermittelt werden. Mehr dazu in unserer Datenschutzerklärung.

(ciw)