Nvidia DGX GH200: Rechenbeschleuniger für große KI-Modelle

Mit 256 Grace-Hopper-Kombichips soll das Serversystem Exaflops-Leistung erreichen, sofern simple KI-Datentypen zum Einsatz kommen.

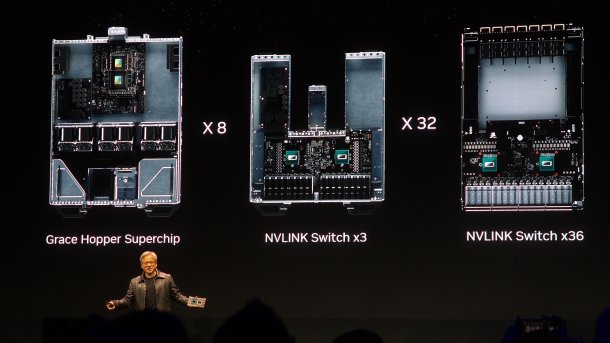

Der Chiphersteller Nvidia setzt weiterhin auf das Zugpferd KI-Hardware, was dem Unternehmen derzeit Milliardengewinne beschert. Auf der Keynote zur IT-Messe Computex hat Nvdia-CEO Jensen Huang das Serversystem DGX GH200 vorgestellt, in dem 256 Grace-Hopper-Kombibeschleuniger rechnen. Diese sind per NVLink verbunden und sollen eine Rechenleistung von einem Exaflops (1 Trillion Operationen pro Sekunde) bieten.

(Bild: Nvidia)

Diese Angabe bezieht sich aber auf den für KI-Berechnungen verwendeten 8-Bit-Datentyp FP8 und ist deshalb nicht mit den Performance-Angaben von Supercomputern vergleichbar, die mit Gleitkommazahlen doppelter Genauigkeit (FP64) ermittelt werden. Dort erreicht ein DGX-GH200-System rund 17 Petaflops (0,017 Exaflops).

Videos by heise

Erstkunden Google, Meta und Microsoft

Die verwendeten Grace-Hopper-Chips GH200 bestehen aus einer Grace-CPU mit 72 Neoverse-V2-ARM-Kernen und der H100-GPU mit Tensor-Kernen, die auf einem Package untergebracht sind. Untereinander kommunizieren sie per NVLINK mit 900 GByte/s, ebenso wie mit den anderen GH200-Chips des Servers. Insgesamt können die 256 Kombibeschleuniger auf 144 TByte gemeinsam genutzten Speicher zugreifen.

(Bild: Nvidia)

Deshalb eignen sich DGX GH200 besonders gut dafür, große Modelle für generative KI-Anwendungen zu trainieren. Dazu zählen unterem anderem Sprachmodelle wie ChatGPT oder Bildgeneratoren. Wenig überraschend heißen die Erstkunden Google, Meta und Microsoft. Aber auch Nvidia selbst will einen KI-Supercomputer namens Helios bauen, der aus vier DGX-GH200-Servern besteht.

Offene Serverarchitektur MGX

Für kleinere Server hat Nvidia zudem die offene Serverarchitektur MGX vorgestellt. Auf ein, zwei oder vier Höheneinheiten können dort Serverhersteller das komplette GPU-Portfolio von Nvidia mit Grace-CPUs, GH200 oder x86-Prozessoren kombinieren. Dabei kooperiert der Chiphersteller mit Asrock Rack, Asus, Gigabyte, Pegatron, QCT und Supermicro.

(Bild: Nvidia)

(chh)