Tensorflow: Amazons Alexa mit Gebärdensprache bedienen

Es muss nicht immer Sprachsteuerung sein: smarte Lautsprecher lassen sich auch mit Gebärdensprache bedienen, wie ein Maker demonstriert.

- Helga Hansen

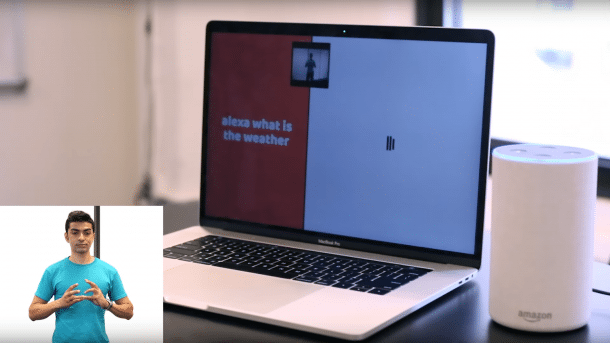

Ob Wettervorhersage oder Witz – wer von seinem smarten Lautsprecher Informationen möchte, muss ihn (oder sie) ansprechen. Wer mit den Geräten nicht sprechen möchte oder kann, bleibt da schnell außen vor. Der Bastler Abhishek Singh kann mit seiner Amazon Alexa dagegen in Gebärdensprache kommunizieren.

Alles was Singh dafür nutzt, ist ein Laptop mit Webcam, auf dem die Machine-Learning-Bibliothek TensorFlow läuft. Über die Kamera erkennt der Rechner die Gebärden, in diesem Fall in amerikanischer Gebärdensprache. Mittels künstlicher Intelligenz werden die Befehle in Text übersetzt und von der Sprachausgabe vorgelesen. Nun kann Alexa darauf reagieren. Ihre Antworten werden wiederum vom Rechner erkannt und als Text dargestellt.

Empfohlener redaktioneller Inhalt

Mit Ihrer Zustimmung wird hier ein externes YouTube-Video (Google Ireland Limited) geladen.

Ich bin damit einverstanden, dass mir externe Inhalte angezeigt werden. Damit können personenbezogene Daten an Drittplattformen (Google Ireland Limited) übermittelt werden. Mehr dazu in unserer Datenschutzerklärung.

Maschine spricht mit Maschine

Da er keinen Datensatz mit Gebärden gefunden hatte, um TensorFlow zu trainieren, hat Singh ihn einfach selbst begonnen. Dafür hat er Gebärden so lange vor der Webcam wiederholt, bis sie zuverlässig erkannt wurden und den entsprechenden Wörtern zugewiesen. Die möglichen Antworten hat er ebenfalls transkribiert. Für ein Projekt, bei dem die meiste Zeit Maschinen miteinander sprechen, ist das einiges an Aufwand. Tatsächlich sei es eher ein Gedankenexperiment, so Singh, das die Grenzen inklusiven Designs auslotet. Eine Anleitung zum Nachbauen und eine Livedemo hat er trotzdem zur Verfügung gestellt.

Der Aufbau kommt zeitlich passend: In den USA hat Amazon letzte Woche mit "Tap to Alexa" ein Feature eingeführt, mit dem Amazon Echo Show, ein Alexa-Lautsprecher mit Touchscreen, einfacher über den Screen bedient werden kann. Außerdem gibt es eine Untertitelfunktion, die Alexas Antworten auch als Text ausgibt. Eine Erkennung von Gebärdensprache ist allerdings nicht enthalten.

Barrierefreie Technik

Dabei ist Singh nicht der einzige, der mit der Alternative zur Lautsprache experimentiert. Mit dem Roboterarm Aslan und dem SignBot gibt es zwei Projekte, die künstlichen Händen das Gebärden beibringen wollen. Andere Firmen sind in Sachen Barrierefreiheit auch weiter. Google bietet seit kurzem Morsezeichen als Eingabemöglichkeit für Android-Smartphones an, während Microsoft für die Spielekonsole Xbox einen speziellen Hub vorstellte. An ihn können verschiedene Controller angeschlossen werden, die Menschen mit Behinderungen das Zocken vereinfachen. (hch)