Ethische Grenzen: Streit in der EU um Regeln für künftige KI-Systeme

Derzeit diskutiert die EU-Kommission darüber, was künstliche Intelligenz (KI) künftig dürfen soll und was nicht. Die Vorschläge einer Expertenkommission sind wenig ambitioniert.

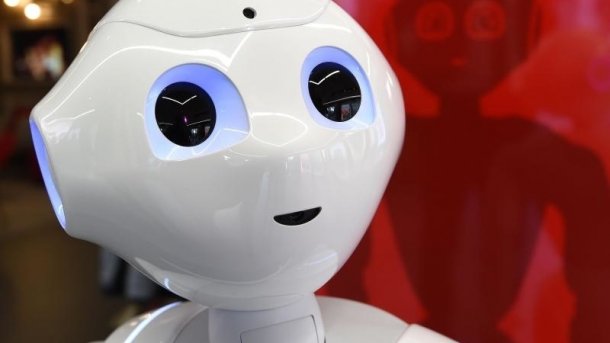

(Bild: dpa, Hauke-Christian Dittrich)

- Monika Ermert

Die „Hochrangige Expertengruppe zur KI“ (AI HLG) hat Anfang April ihre Richtlinien für eine vertrauenswürdige KI vorgelegt. Die EU-Kommission hatte das Gremium im Sommer vergangenen Jahres beauftragt. Auf Grundlage von vier ethischen Grundsätzen für die Entwicklung und Anwendung von KI-Systemen formulierten die 52 Kommissionsmitglieder in dem Papier sieben Anforderungen für KI-Unternehmen und deren Entwickler.

Grundsätze sind die Anerkennung der Handlungsautonomie des einzelnen und des Prinzips „do no harm“, also keinen Schaden anzurichten und niemanden zu verletzen, sowie Fairness und Nachvollziehbarkeit. Zu den sieben Anforderungen, auf die KI-Entwicklungen abzuklopfen seien, gehören technische Robustheit und Sicherheit, Vertraulichkeit und klare Datenhaltungsregeln, Transparenz, Nichtdiskriminierung, Berücksichtigung gesamtgesellschaftlicher Effekte und Maßnahmen zur Rechenschaftslegung. Über allem steht die Autonomie und Kontrolle für den einzelnen.

Wie gut sich diese Regeln in der Entwicklung und in Anwendungen einbauen lassen, sollen Unternehmen ab dem Sommer bis Ende 2019 testen.

Die Debatte über eine ethische KI flankiert ein mit den Mitgliedsstaaten abgestimmtes großes Investitionsprogramm: 20 Milliarden Euro sind bis Ende 2020 vorgesehen, davon 1,5 Milliarden EU-Gelder. Damit möchte man die vertrauenswürdige „KI made in Europe“ gerne in dem von China und den USA dominierten Markt positionieren.

(Bild: Qinetiq North America)

Streit um die Besetzung

Zeitgleich mit der Veröffentlichung des Berichts meldete sich aber ein erbostes Mitglied der Kommission zu Wort. Thomas Metzinger, Ethikprofessor von der Universität Mainz, sprach in einem im Berliner Tagesspiegel veröffentlichten Kommentar von einem viel zu sehr auf Unternehmensinteressen getrimmten Kompromiss.

Knapp die Hälfte der 52 Vertreter kämen aus Unternehmen, nur vier von 52 seien Ethik-Experten, mokierte sich Metzinger und bezeichnete die „Geschichte“ von der „vertrauenswürdigen KI“ als „ein von der Industrie erdachtes Marketing-Narrativ, eine Gute-Nacht-Geschichte für die Kunden von morgen.“

Entsetzt zeigte sich Metzinger aber vor allem darüber, dass das Gremium nicht bereit war, echte rote Linien zu ziehen. Zusammen mit Urs Bergmann von Zalando hatte Metzinger etwa tödliche autonome Waffensysteme oder Social Scoring im Stil Chinas als „nicht verhandelbar“ empfohlen. Doch soweit mochte das EU-Expertengremium nicht gehen. Metzingers Rat lautet angesichts der Entwicklungen, der Industrie die Ethikdebatte wieder wegzunehmen.

Selbstregulierung nur Verzögerungstaktik

Dabei gibt es für die KI-Größen durchaus Gegenwind. Massive Kritik handelte sich Googles KI für seine frischgebackene Ethikkommission ein. Nachdem fast 2500 Google-Mitarbeiter die Besetzung des „Advanced Technology External Advisory Council“ (ATEAC) mit der als ultrakonservativ und homophob geltenden Kay Coles James von der Heritage Foundation kritisiert hatten, schloss Google die ATEAC nach nur einer Woche kurzerhand wieder.

Im EU-Parlament hat man sich mit dem Thema KI schon eingehender beschäftigt. 2017 hat das Parlament die Kommission mit einem Initiativbericht auf das Thema KI angesetzt. In einem im Februar verabschiedeten Folgebericht rügt es die Kommission dafür, dass sie es in der laufenden Legislaturperiode nicht mehr geschafft hat, gesetzliche Regelungen zur Haftung von KI-Unternehmen vorzulegen.

Der Bericht hält klar fest, dass rein automatische Killerdrohnen verboten werden sollen. Zugleich fordern die Parlamentarier, dass jeder erfahren muss, wenn eine ihn betreffende Entscheidung automatisiert gefällt wurde. Er kann dagegen Einspruch erheben. Im Fragenkatalog der Expertenkommission klingt das aber erst einmal nur so: „Haben Sie Einspruchsmöglichkeiten für den Fall vorgesehen, dass es zu einem Schaden oder negativen Folgen kommt?“ (uma)