Machine Learning: Azure Seeing AI soll Bilder präzise erkennen und beschriften

Angeblich ist die App treffsicherer als viele Menschen: Microsoft hat einen neuen Algorithmus entwickelt, der Bilder mit passenden Bildunterschriften versieht.

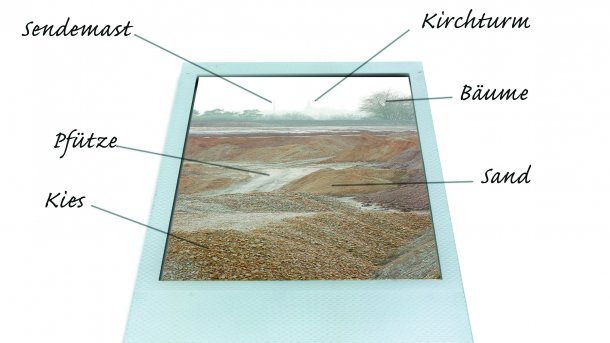

Diese Bildunterschrift wurde nicht mit Azure Seeing AI verfertigt.

- Silke Hahn

Microsofts Azure AI Cognitive Services haben einen neuen Algorithmus für das Image-Captioning vorgestellt, der gemäß erster Tests an die menschliche Fähigkeit zu akkurater Bildbeschreibung heranreichen soll. Laut Blogeintrag plant Microsoft, sein KI-System zur automatischen Bildbeschreibung auch außerhalb von Microsoft-Produkten als Standalone-Software anzubieten, und zwar in der Azure-Cloud. Die Kamera-App "Seeing AI" erhält nun als erstes Microsoft-Produkt eine Aktualisierung, die Implementierung des Algorithmus in Produkte der Office-Suite wie PowerPoint, Outlook und Word soll laut Blogeintrag des Entwicklerteams folgen.

Kamera-App beschreibt sichtbare Objekte in Textform

Die App "Seeing AI" hat Microsoft schon 2017 herausgegeben. Als Assistenz-App nutzt sie das Kameraauge des Smartphones, um Blinden und eingeschränkt Sehenden die Welt zu beschreiben. Laut Herausgeber kann sie Haushaltsgegenstände identifizieren und zuordnen, Texte lesen und scannen, Szenen beschreiben und sogar Freunde wiedererkennen. Aber auch Bilder aus der virtuellen Welt, anderen Apps, E-Mails und sozialen Netzwerken lassen sich mit Seeing AI erfassen und beschreiben. Es gibt also Bewegung im Bereich der Bilderkennung mit KI, speziell im Versehen von Bildern mit Alternativtext.

Videos by heise

Für Menschen mit eingeschränkter Sehfähigkeit könnten das gute Nachrichten sein: Über das "alt"-Attribut erhalten Bilder eine Beschreibung in Textform, um Menschen mit Sehschwäche (oder einer schwachen Internetverbindung) die Wahrnehmung visueller Inhalte im Internet, in Dokumenten und sozialen Medien zu ermöglichen. Der Alternativtext lässt sich zum Beispiel mit Lesegeräten ausgeben. In der Realität sind die alt-Attribute, die allen einen barrierefreien Zugang zu visuellen Inhalten ermöglichen würden, oft leer oder nicht korrekt befüllt.

Nutzersicht auf Assistenz-Apps wie Seeing AI

Die AppleVis-Community, eine seit 2012 bestehenden Gruppe blinder und sehgeschädigter Internetnutzer, hat 2019 Seeing AI zur "besten App" für Menschen mit beeinträchtigter Sehfähigkeit gewählt. Seit Veröffentlichung der App 2017 empfahl diese Experten-Community die App mehrfach als praxistaugliches Assistenz-Tool (zumindest für Nutzer von Apple-Geräten mit iOS-Betriebssystem).

Im Blogeintrag des Entwicklerteams von Microsoft heißt es zu der aktualisierten Version mit dem neuen Algorithmus, dass dieser doppelt so treffsicher sei wie das vorherige Bildbeschriftungssystem, das Microsoft seit 2015 entwickelt hat. Vorab hatten die Entwickler des Microsoft-Cognitive-Services-Teams Testergebnisse in einem wissenschaftlichen Aufsatz veröffentlicht, aus dem hervorgeht, dass der von den Azure AI Cognitive Services erarbeitete Algorithmus an Vergleichswerte "menschlicher" Benchmarks heranragt oder die Vergleichsmarken im Test sogar leicht übertrifft. Solche Testergebnisse sind allerdings mit Vorsicht zu genießen, da es hier nicht um die tatsächliche Bildwahrnehmung und Deutungsfähigkeit durch Menschen geht, sondern um errechnete Vergleichswerte, und die Benchmarks von Nocaps decken wohl nur einen Teilbereich möglicher visueller Konzepte der menschlichen Wahrnehmung ab.

Potenzial von KI-Software für Barrierefreiheit

Microsoft ist nicht der erste und nicht der einzige Anbieter von Apps und Algorithmen zur Bilderkennung und automatisierten Bildbeschriftung. So hat Facebook 2018 ein (weiteres) Tool zur Objekterkennung vorgestellt, das als Open-Source-Projekt Detectron läuft. Die zugrundeliegende Software ist in Python verfasst und ergänzt ein breiteres Portfolio des Anbieters im Bereich Bildanalyse.

Auch Google arbeitet im Rahmen seines ML-Kits und dem Projekt Firebase an automatisierter Software zur Bilderkennung und möglicherweise auch Bildbeschriftung. Zuletzt hatte Googles Android-ML-Kit mit dem Transkribieren handschriftlicher Notizen über die Digital Ink Recognition API von sich reden gemacht, die in rund 300 Sprachen funktionieren soll. Kurz vorher hatten Googles ML-Entwickler das Android ML Kit aus seiner engen Anbindung an das ML Kit SDK von Firebase gelöst, um sich mit dem neuen Kit auf KI-Anwendungen für den mobilen Bereich zu konzentrieren. Nach dem Entwicklungssprung aus der ML-Abteilung von Microsoft ist spannend, womit Facebook und Google wohl als Nächstes aufwarten.

Mehr Informationen zu dem neuen Algorithmus von Microsoft lassen sich dem Blogeintrag der Cognitive Services entnehmen. Das Feature steht über die Azure Cognitive Services zur Verfügung. Interessierte können sich auf den AI-Seiten von Microsoft über die App Seeing AI informieren, die im App-Store zum Download bereitsteht.

(sih)