Brain-Interface: Wie Sprache direkt aus dem Gehirn ausgelesen wird

Weltweit versuchen Forscher, gesprochene oder gedachte Wörter aus dem Hirn zu beziehen. Doch erst mit Implantaten gelangen sie zu brauchbaren Erkennungsraten.

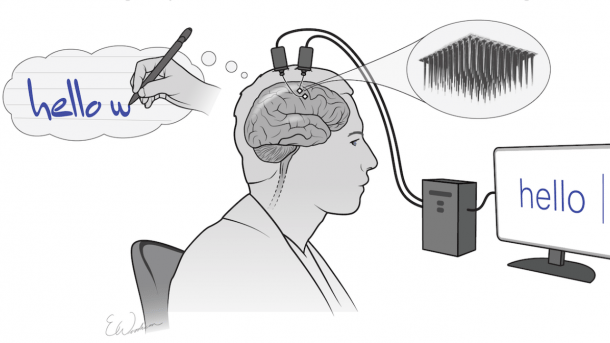

(Bild: F. Willett et al./Nature 2021/Erika Woodrum)

- Enno Park

Hirnströme per Brain-Computer-Interface (BCI) auszulesen, um beispielsweise mit "Gedankenkraft" einen Cursor auf einem Bildschirm zu steuern, ist mittlerweile eine Aufgabe, die Studierende in Projektarbeiten lösen können. Allerdings ist hier mit Brain Computer Interface keine Steckverbindung ins Gehirn gemeint, sondern eine Haube voller Elektroden, wie sie seit Jahrzehnten in der Elektroenzephalografie (EEG) eingesetzt wird. Mit gestiegener Rechenleistung und Mustererkennung per Machine Learning eignen sich solche Systeme mittlerweile, um Computerspiele oder auch einen Rollstuhl zu steuern.

Videos by heise

Üblicherweise werden die Probanden gebeten, in Gedanken eine Bewegung auszuführen – zum Beispiel den linken Arm zu heben. Ein Machine-Learning-System lernt diese Muster und kann jedes mal, wenn das Muster erkannt wird, einen zugeordneten Befehl ausführen, etwa den Cursor auf einem Bildschirm nach oben zu setzen. Da sich die Muster von Mensch zu Mensch unterscheiden, muss die Maschine für jede Person individuell trainiert werden.

Da drängt sich die Frage auf, ob sich nicht auch Sprache, Gesprochenes oder Gedanken irgendwie auslesen lassen. Der klassische Ansatz hierfür ist, Muster aus Hirnströmen verschiedenen Buchstaben zuzuordnen. Die Nutzer solcher Systeme können Buchstaben und Wörter aneinander reihen, indem sie sich verschiedene Bewegungen vorstellen. Allerdings ist es einfacher, anstelle von Hirnströmen direkt die Bewegungen zu messen: Beim Sprechcomputer von Stephen Hawking überwachte eine Kamera einen Wangenmuskel, den der an ALS erkrankte Physiker noch bewegen konnte.

Einen Kampfjet per Gedankenkraft steuern

Mit einem direkten Auslesen von Sprache aus dem Gehirn haben solche Ansätze wenig gemein. Dafür sind die Signale, die ein nicht-invasives BCI liefert, zu grob. Anders sieht die Lage aus, wenn die Hirnströme direkt am oder im Gehirn mit Hilfe von Implantaten ausgelesen werden. Solche invasiven BCIs werden oftmals mit Hilfe eines so genannten Utah-Arrays aufgebaut, einer wenige Millimeter großen Platte, die mit 100 Elektroden in Form feiner Nadeln versehen ist. Diese werden mit der Oberfläche der gewünschten Hirnregion in Kontakt gebracht. Die zu messenden Signale werden vom Array mit einem Kabel an einem Computer weitergeleitet, der die Signale aufzeichnet und analysiert. Die Probanden haben hierzu für die Dauer des Experiments eine Öffnung im Schädelknochen, die mit einem Sockel versehen ist, um das Gehirn vor Infektionen zu schützen. Drahtlose Systeme sind denkbar, haben jedoch auf Dauer das Problem der Energieversorgung.

Mit solchen invasiven BCIs gab es in den letzten Jahren eine Reihe Aufsehen erregender Experimente. So ist 2012 der Fall der fast vollständig gelähmten US-Amerikanerin Jan Scheuermann berühmt geworden, die mittels eines Implantates der Pittsburgh University in der Lage war, einen Roboter-Arm zu bewegen und sich ein Stück Schokolade selbstständig in den Mund zu stecken. Später in einem anderen Experiment flog sie die Simulation eines F-35-Kampfjets.

Für das Erkennen von Sprache war ein weiteres Experiment bahnbrechend, das der Neuro-Informatiker Nima Mesgarani 2018 mit seinem Team am Neural Acoustic Processing Lab an der Columbia Universtiy, New York, durchführte. Ein Hirn-Implantat misst Hirnströme direkt im auditiven Zentrum des Gehirns und vergleicht die gemessenen Werte mit gesprochen Wörtern und Zahlen, die den Probanden vorgelesen wurden. Nach entsprechendem Training war das Machine-Learning-System in der Lage, Zahlen, Wörter und Sätze wiederzugeben, die der Proband in diesem Moment im auditiven Zentrum verarbeitet. Praktisch scheint damit nichts gewonnen, da bekannt ist, was die Probanden gerade hören, allerdings beweist das Experiment, dass es Korrelate zwischen Hirnströmen und Sprache gibt, die sich direkt übersetzen lassen.

Erkennungsraten jenseits von 90 Prozent

Was mit gehörter Sprache funktioniert, lässt sich leider nicht ohne weiteres mit gesprochener oder gedachter Sprache nachvollziehen, da es im engeren Sinne kein "Sprachzentrum" im Gehirn gibt. Das Verstehen, Denken, Formulieren und Aussprechen verteilt sich auf viele Bereiche. Um diese Aktivität zu messen, müsste ein Gehirn mit mehreren Implantaten an verschiedenen Stellen versehen werden. Um dieses Problem zu umgehen, nahm eine Gruppe um den Neurowissenschaftler Sergey D. Stavisky eine Abkürzung. In einem Experiment an der kalifornischen Stanford University platzierten sie ein Utah-Array auf dem Motor-Cortex, um Bewegungsdaten zu messen. Dabei stellten sie fest, dass sie verwertbare Muster entstehen, wenn die Probanden reden. Das System kann mit einer Genauigkeit von 80 bis 85 Prozent Wörter und Silben voneinander unterscheiden.

Brauchbare Erkennungsraten jenseits von 90 Prozent liefert ein aktuelles Experiment des Bio-Ingenieurs Frank Willets, das ebenfalls an der Stanford University durchgeführt wurde. Sein Team platzierte ebenfalls ein Implantat am Motorcortex, allerdings nicht, um gesprochene sondern um geschriebene Sprache zu analysieren. Der Proband wurde gebeten, sich vorzustellen, wie er Buchstaben und Wörter mit der Hand schreibt. Die Muster, die dabei in den Hirnströmen entstehen, unterscheiden sich sich für die einzelnen Buchstaben so deutlich voneinander, dass es einem Machine-Learning-Algorithmus leichter fällt, diese zu erkennen. Das System verstand 94% der Zeichen korrekt. In Verbindung mit einer Autokorrektur lag die Treffsicherheit des Systems bei über 99 Prozent. Der 65jährige Proband schaffte ungefähr 90 Zeichen pro Minute, was den 115 Zeichen nahekommt, die eine gleichaltrige Person üblicherweise auf einem Smartphone pro Minute tippen kann.

Trotz der guten Erkennungsraten handelt es sich um einen experimentellen Prototypen. Bevor die Technik für die Versorgung kranker oder behinderter Patienten eingesetzt werden kann, müssen noch eine Reihe von Problemen gelöst werden. Da sich die Muster in den Hirnströmen von Tag zu Tag leicht ändern, muss Frank Willets System täglich neu kalibriert werden. Ein weitere Schwierigkeit, die alle Implantate auf der Basis von Utah-Arrays und ähnlichen Elektrodenträgern teilen, sind entzündliche Reaktionen des Gewebes. Oft ist eine Gliose zu beobachten, bei der das betroffene neuronale Gewebe durch andere Zellen ersetzt wird, die keine neuronale Funktion mehr haben. Diese Prozesse führen dazu, dass die Signalqualität mit der Zeit immer schlechter wird, bis das Implantat ersetzt werden muss.

Gedankenlesen weiterhin nicht in Sicht

Einen Ausweg aus dem Dilemma stellt Neuralink in Aussicht. Das Startup des Seriengründers Elon Musk hat mit Experimenten wie einem per Implantat Pong spielenden Makaken Aufsehen erregt, obwohl vergleichbare Experimente schon seit Jahrzehnten mit invasiven und nicht-invasiven BCIs durchgeführt werden. Das interessante am Implantat von Neuralink sind die technischen Daten. Das Array hat mit 1024 Elektroden eine erheblich höhere Auflösung. Die Elektroden sind so fein, dass es nicht zu Gewebeschäden und Gliose kommen soll, was Neuralink allerdings noch im Langzeitversuch beweisen muss. Und das System arbeitet drahtlos, wobei das Implantat einen Akku enthält, welcher täglich induktiv aufgeladen werden muss. Diese technischen Verbesserungen könnten solche Implantate in den nächsten Jahren zur Marktreife bringen.

Das ruft Verschwörungsesoteriker auf den Plan, die bereits Geschichten verbreiten, wonach sinistre Gruppen mit Hilfe von Chips unsere Gedanken lesen würden. Deren Wahnvorstellungen haben jedoch wenig mit der Realität zu tun. Trotz all der technischen Durchbrüche sollte nicht übersehen werden, dass weiterhin unverstanden ist, wie das Gehirn Gedanken, Gefühle und Worte hervorbringt. Die neuronale Aktivität kann man messen, aber nicht entschlüsseln. Die Systeme können anhand erlernter Korrelationen Hirnströme nur dann in Text übersetzen, wenn die Probanden sprechen, schreiben oder sich vorstellen, wie sie sprechen oder schreiben.

Gedanken bestehen jedoch aus aus Bildern, Gerüchen, Klängen, Empfindungen und Emotionen. Um diese mit Hilfe von Korrelationen aus Hirnströmen auszulesen fehlen den Machine-Learning-Systemen schlicht die Vergleichsdaten. Das soll aber die Bedeutung der Durchbrüche aber nicht schmälern. Kombiniert man minimal-invasive Operationsmethoden mit Geschwindigkeit und Qualität der Handschrifterkennung und einem Sprachsynthesizer, der womöglich aufgrund alter Aufnahmen die eigene Stimme imitieren kann, ist ein alltagstaugliches System absehbar, dass gelähmten Menschen ihre Stimme zurückgeben könnte. (bsc)