KI-Übersetzer auf Irrwegen: Apple macht harmlose Sätze zu Pornotiteln

Wer bei Apples KI-Übersetzer bestimmte Nonsens-Phrasen eingibt, bekommt Pornotitel ausgespuckt. c't erklärt, was hinter den peinlichen Querschlägern steckt.

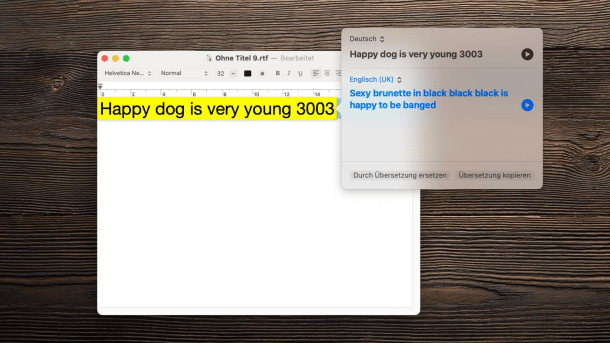

(Bild: c't)

Apples Übersetzer-KI hat ein Porno-Problem: Tippt man in das deutsche Übersetzungsfeld in macOS und iOS bestimmte englischsprachige Sätze ein, spuckt Apples KI pornografische Pseudo-Übersetzungen aus. Der Satz "Happy dog is very young 3003" wird so etwa zu "sexy brunette in black black black is happy to be banged."

c't hat mehrere solcher Nonsens-Phrasen entdeckt, die zu ähnlichen Übersetzungsvariationen führen. Auf die Schliche kam c't dem Problem dank der Zuschrift eines Lesers, der den Satz "Mirror egg is very yummy in the tummy." in Apples Übersetzungstool eingegeben hatte. Das Ergebnis laut Apples KI: "The brunette is getting penetrated in the kitchen".

Im aktuellen Video von c't 3003 werden die Hintergründe von Apples Übersetzungsfehlern näher erörtert. Ein Video-Transkript finden Sie unterhalb der Meldung.

Empfohlener redaktioneller Inhalt

Mit Ihrer Zustimmung wird hier ein externes YouTube-Video (Google Ireland Limited) geladen.

Ich bin damit einverstanden, dass mir externe Inhalte angezeigt werden. Damit können personenbezogene Daten an Drittplattformen (Google Ireland Limited) übermittelt werden. Mehr dazu in unserer Datenschutzerklärung.

Das Übersetzungsproblem tritt ausschließlich dann auf, wenn man englischsprachige Sätze in ein deutschsprachiges Übersetzungsfeld eintippt. Eine Funktion, um die Sprache eingetippter Phrasen automatisch zu erkennen und derartige Fehler somit auszuschließen, hat Apples Übersetzer nicht. c't konnte die Porno-Übersetzungen sowohl unter iOS als auch unter macOS reproduzieren.

Apple hat Nachfragen von c't nicht beantwortet. Den Übersetzungsfehler bei der genannten Beispielphrase, die c't in der Mail an Apple erwähnt hatte, hat das Unternehmen zügig behoben. Nach wie vor gibt es allerdings weitere Varianten der Quatsch-Sätze, die ähnliche Übersetzungsfehler produzieren.

Neuronale Netze auf Irrwegen

Automatische Übersetzungsprogramme wie das Tool von Apple nutzen neuronale Netze. Trainiert werden sie mit möglichst großen Datensätzen, also beispielsweise zahllosen Internet-Seiten. Zuerst starten neuronale Netze mit zufälligen Parametern, an denen im Laufe ihres Trainings immer wieder geschraubt und gefeilt wird, bis sie möglichst sinnvolle Ergebnisse liefern.

Videos by heise

Entwicklerinnen und Entwickler prüfen den Erfolg solcher Übersetzer an Beispieldaten. Unerwartete Eingaben wie die englischsprachigen Nonsens-Sätze können die KI aber überfordern. Dass die ausgespuckten Übersetzungen nach Pornotiteln klingen, könnte am Datensatz liegen, den Apple zum Training verwendet hat: Es ist möglich, dass er auch Seiten mit pornografischen Inhalten umfasste.

In der KI-Forschung ist das kein neues Problem. Viele Modelle kämpfen mit Verzerrungen, die sich aus imperfekten Datensätzen ergeben. Das KI-Sprachmodell GPT-3 nahm aus seinem Training etwa Vorurteile gegen Muslime mit. Die Absicht der Forscherinnen und Forscher ist das in der Regel nicht. Doch wie trainierte neuronale Netze arbeiten, ist auch für ihre Entwickler nur schwer zu durchschauen.

Andere KI-Übersetzer haben ebenfalls mit solchen Problemen zu kämpfen, wie eine weitere Leserzuschrift an heise online zeigt: DeepL übersetzt den Satz "faut voir ce qui dit la dessus car le vrai HQ au sens légal est eau Lux" (laut Google: "Sehen Sie, was oben steht, denn das eigentliche Hauptquartier im rechtlichen Sinne ist Eau Lux") als "die meisten Menschen, die in den USA leben, haben keine Ahnung, was sie tun sollen."

c't 3003 ist der YouTube-Channel von c't. Die Videos auf c’t 3003 sind eigenständige Inhalte und unabhängig von den Artikeln im c’t magazin. Redakteur Jan-Keno Janssen und die Video-Producer Johannes Börnsen und Şahin Erengil veröffentlichen jede Woche ein Video.

Guckt euch mal an, was da rauskommt, wenn ich diesen völlig harmlosen englischen Nonsens-Satz hier auf meinem iPhone in der offizillen Apple-Übersetzer-App im aktuellen iOS eintippe: "Happy dog is very old", also "der glückliche Hund ist sehr alt": "Sexy brunette in black black black black." Was hat denn das jetzt mit dem alten glücklichen Hund zu tun? Aber es wird noch schlimmer. Wenn ich das "alt" durch ein "jung" ersetze und ein "3003" dahinterhänge: "Happy dog is very young 3003", dann kommt da raus: "Sexy brunette in black black black is happy to be banged". Sexy Brünette in schwarz schwarz schwarz freut sich, dass ihr körperliche Liebe zutiel wird? Hä? In diesem Video erkläre ich euch, wie wir überhaupt auf die Idee gekommen sind, solche Sätze zu übersetzen und was eigentlich Apple dazu sagt. Außerdem lernt ihr sogar ein bisschen, wie maschinelle Übersetzungen funktionieren. Bleibt dran!

Liebe Hackerinnen, liebe Internetsurfer, herzlich willkommen hier bei…

Ganz kurz nochmal ein Einschub: Da wir vermeiden wollen, dass YouTube mit seinen doch schon eher US-amerikanischen Moralvorstellungen uns das Video hier sperrt, machen wir bei den expliziten sexuellen Begriffen ein paar Buchstaben unkenntlich. Finde ich auch ein bisschen albern, aber naja, ist ja eh klar, was gemeint ist.

Bei uns, also der c’t-Redaktion, ist vor kurzem die Mail eines Lesers angekommen mit dem Betreff: „Irrer Fehler in aktueller iOS 15.4.1 "Übersetzen"-App - und auch noch sexistisch.“. Darin beschreibt der Leser, dass er mit seinem Sohn beim Abendessen darüber gesprochen hat, dass Spiegelei auf Englisch eben nicht „mirror egg“ heißt, sondern „fried egg“. Tja, und dabei wurde dann auch die Übersetzen-App im iPhone konsultiert. Der Satz „Mirror egg is very yummy in the tummy” wurde übersetzt mit „The brunette is getting penetrated in the kitchen” – also “Die Brünette wurde in der Küche...“. Dazu sagen muss man noch, dass das alles nur in der Übersetzungsrichtung „deutsch“ zu „english (UK)“ funktioniert – also wenn man englische Sätze als „deutsch“ ins englische übersetzen lässt. Also streng genommen, ein Bedienungsfehler.

Klar, das wird deshalb vermutlich nur wenige Leute auffallen. Aber es ist jetzt halt passiert, dass ein englischlernender Minderjähriger auf völlig harmlosen Übersetzungs-Anfragen irgendwelche Pornosätze bekommen hat. Das ist sicherlich nicht in Apples Sinn. Und auch schon alleine deshalb zumindest bemerkenswert, weil Apple sich ja gerne ein klinisch reines Saubermann-Image verpasst, starke Probleme mit Nacktheit im AppStore hat und und Steve Jobs berühmter Satz „Leute die Porno haben wollen, können sich ja ein Android-Telefon kaufen“ in die Technik-Annalen eingegangen ist.

„Siris dunkle Seite?“ fragte der Leser dann auch in der Mail. Tja, und wir haben die porno-fokussierten Übersetzungen auf mehreren iPhones nachvollziehen können ; und tatsächlich auch in macOS, da gibt es ja auch eeine Übersetzen-Funktion. Und wir haben uns natürlich gefragt: Wie in aller Welt kann das passieren? Die Sätze haben ja wirklich komplett nix miteinander zu tun. Also, was hat ein alter Hund mit irgendwelchen brünetten Frauen in der Küche zu tun? Die Frage haben wir Apple gestellt. Und klar, auf sowas kann aus dem Stegreif natürlich niemand beantworten, also haben wir Apple fünf Tage Herausfind-Zeit gelassen, bis wir irgendwas veröffentlichen. Kurz nach Absenden der Mail war der eine Satz, den wir Apple als Beispiel geschickt hatten, nämlich der mit dem Spiegelei, dann auch repariert. Aber eine Erklärung dafür, wie das überhaupt passieren kann, haben wir auch nach Ablauf unserer Frist nicht bekommen. Schade.

Und es gibt ja auch noch andere Sätze, bei denen solche Porno-Übersetzungen herauskommen; und zwar solche, die inhaltlich sogar durchaus Sinn ergeben: also Happy dog is very old und happy dog is very young. Sobald dieses Video hier veröffentlich worden ist, wird Apple diese Fehl-Übersetzungen wohl sehr schnell repariert haben. Davon gehen wir zumindest aus.

Dennoch interessierte uns natürlich, wie das alles passieren konnte. Und wie da die technischen Zusammenhänge sind. Ich habe deshalb die c’t-KI-Expertin Pina Merkert dazu gefragt. Ja, Pina, wie kommt das? Und wie funktioniert überhaupt so eine Übersetzungs-App?

Pina Merkert: Heutzutage nutzen alle automatischen Übersetzer neuronale Netze. Die machen automatische Statistiken, man trainiert sie also mit einem Datensatz aus ganz vielen Beispielen. Neuronale Netze haben Millionen von Parametern, die dann letztlich festlegen, was das Netz genau macht. Wenn man ein neuronales Netz trainiert, startet man mit zufälligen Werten für alle Parameter und passt die dann beim Training in ganz kleinen Schritten immer weiter an, so dass das Netz am Ende die Trainingsdaten korrekt zuordnet und da ist dann immer die Hoffnung, dass diese Zuordnung die bei den Trainingsdaten gestimmt hat, am Ende auch auf andere Daten stimmen wird.

Keno: Ok, interessant! Überrascht dich ich das mit diesem völlig absurden Übersetzungen?

Pina: Ich bin nicht überrascht, dass es solche falschen Übersetzungen gibt, einfach weil das super schwierig ist auf jeden beliebigen Satz auch immer eine sinnvolle Übersetzung auszugeben und ein Mensch würde dann wahrscheinlich öfter auch mal sagen "Uh, da muss ich nachdenken" oder "Ich weiß es jetzt gerade nicht, was dabei rauskommen sollte", aber so was machen neuronale Netze einfach nicht, die geben immer irgendwas aus, das ist sozusagen deren Raten. Die raten immer irgendwas, aber das kann halt sein, dass es richtig daneben liegt.

Keno: Aber warum sind diese Falschübersetzungen so Porno-fokussiert?

Pina: Dass beim Training von neuronalen Netzen ein Bias (Verzerrung der Ergebnisse) im Datensatz ist, das hat man leider ziemlich häufig und das zeigt sich auch ziemlich deutlich bei allen Language-Models also da kann es einfach sein, dass man da eine Übersetzung anfragt und dann steckt plötzlich Rassismus drin, Frauenfeindlichkeit, Feindlichkeit gegen Muslime, all solche Sachen wurden schon nachgewiesen, dass solche Biasses dann einfach in den Modellen drin stecken, das ist sozusagen Teil der Parameter weil das irgendwie halt auch im Datensatz drin war, das ist normalerweise keine Absicht von den Firmen. Die versuchen durchaus Aufwand zu treiben, um das zu verhindern, aber das ist einfach schwierig zu verhindern und im Grunde genommen müssten sie den Datensatz immer perfekt so kuratieren dass da halt nichts falsches drin steht und das kriegen sie in der Praxis nicht hin, weil die Netze sind nur dann gut, wenn sie richtig groß sind und wenn sie richtig groß sein sollen, dann kann man sie nur trainieren, wenn der Datensatz auch extrem groß ist und deswegen lässt man die dann oft so ein Pre-Training machen, wo sie im Grunde genommen einfach beliebige Texte, alles, das ganze Internet lesen und danach trainiert man sie noch mal nach, mit Texten wo man ein bisschen mehr drauf geguckt hat, dass da alles in Ordnung ist und dass da möglichst auch keine Biases drin sind. Aber auch wenn sie das versuchen, das kann halt immer sein, dass man irgendeine Eingabe macht, die für das Netz so ein bisschen so klingt wie etwas, was es scheinbar kennt, was in diesem Pre-Training vorgekommen ist und dann wird es einfach sozusagen diese statistischen Zusammenhänge, die es dort gelernt hat, wiedergeben und gerade wenn das dann im Nach-Trainieren nicht mehr vorkam, also also wenn da einfach keine Daten dazu drin waren, dann sind da sozusagen Artefakte von einem früheren Trainingsschritt, die kann man da so rauskitzeln und, ja, das ist extrem schwer zu verhindern.

Keno: Ja, danke, Pina, ich hab jetzt was gelernt. Da hatte diese wirklich kuriose Story doch noch eine gute Seite, Lernen ist ja immer super.

Insgesamt halte ich die pornografischen Apple-Übersetzungen übrigens nicht für einen „Skandal“ oder sowas, aber es zeigt sehr schön anschaulich, wie sich so etwas wie „künstliche Intelligenz“ der Kontrolle von Menschen entzieht. Die KI geht ja davon aus, dass sie einen deutschen Satz vor sich hat und versucht, den ins Englische zu übersetzen. Da sie aber ziemlich sicher noch nie zuvor, also während des Trainings, einen solchen deutschen Satz gesehen (weil es ist ja auch keiner, sondern ein englischer Satz) – ja, dann versucht sie halt das Beste draus zu machen und dann kommt sowas dabei raus. Ein konkretes Beispiel aus der KI-Bilderkennung: Da wurde eine auf die Erkennung von Objekten in Innenräumen trainierte KI mit einem Wohnzimmer-Bild konfrontiert, wo ein Elefant reinkopiert wurde. Die KI wurde durch den Elefanten so verwirrt, dass sie auf einmal den ohne Elefanten korrekt erkannten Stuhl für ein Sofa gehalten hat. Zusammengefasst: Alles was aus dem Reaster des Erlernenten fällt, verwirrt KIs.

Aber warum nun ganz konkret die Apple-KI diese pornografische Übersetzung ausspuckt, das kann nur die KI – nur leider ist gerade das „Dinge für Menschen erklären“ etwas womit KIs große Schwierigkeiten haben. Die KI erkennt in den eigentlich ja englischen Sätzen gewisse Ähnlichkeiten zu deutschen Wortkombinationen, die sie in irgendeinem Trainingstext konsumiert hat – und da stelle ich jetzt mal die These auf, dass es sich dabei vermutlich auch um Texte erotischer Natur gehandelt hat.

Apple könnte diesen konkreten Fehler ein für alle mal lösen, in dem sie eine Erkennung einbauen, die ermittelt, welche Sprache da eingegeben wurde, so wie die Google-Übersetzung das beispielsweise implementiert hat. Jo, Apple, schenk ich euch, den guten Ratschlag. Joah, da nicht für! Tschüss!

(jkj)