Sperma und Gebärmutter: Midjourney sperrt Begriffe rund um die Fortpflanzung

Laut der Firma handelt es sich um eine vorübergehende Maßnahme, Menschen davon abzuhalten, das System zur Erstellung "schockierender" Bilder zu missbrauchen.

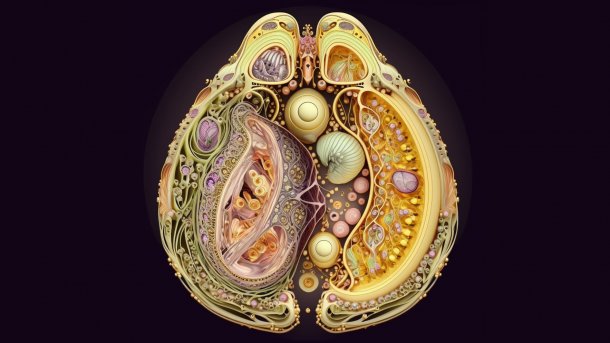

Ein juwelenbesetzter Eierstock, erstellt mit Midjourney.

(Bild: Julia Rockwell)

- Melissa Heikkilä

Midjourney, neben DALL-E 2 und Stable Diffusion aktuell der beliebteste KI-Bildgenerator, hat neue Maßnahmen ergriffen, um die Erstellung potenziell problematischer Outputs zu verhindern. Dazu wird eine Vielzahl von Begriffen, die mit dem menschlichen Fortpflanzungssystem zusammenhängen, als Prompt verboten, wie eine Überprüfung durch MIT Technology Review ergab.

Wenn jemand Worte wie "Plazenta", "Eileiter", "Milchdrüsen", "Sperma", "Gebärmutter", "Harnröhre", "Gebärmutterhals", "Jungfernhäutchen" oder "Vulva" (jeweils in englischer Sprache getestet) in Midjourney eingibt, markiert das System das Wort als verbotene Eingabeaufforderung und lässt es nicht zu. Manchmal werden Nutzer, die einen dieser Prompts ausprobiert haben, für eine begrenzte Zeit gesperrt, weil sie laut dem System versucht haben, "verbotene Inhalte" zu erstellen. Andere Wörter, die sich auf die menschliche Biologie beziehen, wie "Leber" und "Niere", bleiben hingegen erlaubt.

Der Gründer von Midjourney, David Holz, gab an, dass das Verbot der Begriff eine "Überbrückungsmaßnahme" sei, um zu verhindern, dass Menschen "schockierende oder blutrünstige Inhalte" erstellen, während das Unternehmen seine "KI verbessert". Holz zufolge beobachten die Moderatoren der Firma derzeit, wie die Wörter verwendet werden und welche Art von Bildern dabei herauskommen. Man wolle das Verbot regelmäßig anpassen. Das Unternehmen verfügt bereits über eine Seite mit Community-Richtlinien, auf der die Art von Inhalten aufgelistet ist, die auf diese Weise blockiert werden könnten – darunter sexuelle Darstellungen, bestimmte Horrorinhalte ("Gore") und sogar das Pfirsich-Emoji.

Videos by heise

KI-Modelle wie Midjourney, DALL-E 2 oder Stable Diffusion werden auf Milliarden von Bildern trainiert, die aus dem Internet zusammengetragen wurden. Untersuchungen eines Teams der University of Washington hatten ergeben, dass die Modelle dabei auch einen bestimmten Bias erlernen, der zu einer Sexualisierung von Frauen führen kann, was sich dann in den von den Bildgeneratoren produzierten Bildern widerspiegelt. Die enorme Größe des Datensatzes macht es fast unmöglich, unerwünschte Bilder in den Trainingsdaten zu entfernen, zum Beispiel solche mit sexuellem oder gewalttätigem Inhalt – oder solche, die zu voreingenommenen Darstellungen führen könnten. Je häufiger etwas im Datensatz vorkommt, desto stärker ist die neuronale Verbindung, die das KI-Modell zu diesem Inhalt herstellt, was bedeutet, dass es mit größerer Wahrscheinlichkeit in den vom Modell erzeugten Bildern vorkommt.

Schrittweise zum besseren Bild

Die Wortzensur von Midjourney zeigt das schrittweise Vorgehen des Anbieters, das Problem zu lösen. Einige Begriffe, die sich auf das männliche Fortpflanzungssystem beziehen – wie "Sperma" und "Hoden" – sind ebenfalls gesperrt, aber die Liste der verbotenen Wörter scheint überwiegend mit weiblicher Anatomie zu tun zu haben.

Das Prompt-Verbot wurde zuerst von Julia Rockwell, einer klinischen Datenanalystin bei Datafy Clinical, und ihrer Freundin Madeline Keenen, einer Zellbiologin an der Universität von North Carolina in Chapel Hill, entdeckt. Rockwell benutzte Midjourney, um ein humorvolles Bild der Plazenta für Keenen zu erstellen, die diese untersucht. Zu ihrer Überraschung stellte Rockwell fest, dass der Begriff "Plazenta" als Eingabeaufforderung verboten war. Daraufhin experimentierte sie mit anderen Wörtern, die mit dem menschlichen Fortpflanzungssystem zu tun haben, und fand das gleiche Ergebnis vor.

Die beiden Forscherinnen zeigten jedoch auch, dass es möglich ist, diese Verbote zu umgehen und sexualisierte Bilder zu erzeugen, indem man andere Schreibweisen von Wörtern – oder Euphemismen – für sexuelle oder gewaltvolle Inhalte verwendet. In ihren Untersuchungen, die sie mit MIT Technology Review teilten, fanden sie heraus, dass der Prompt "gynäkologische Untersuchung" – in der britisch-englischen Schreibweise – einige höchst problematische Bilder erzeugte: eines von zwei nackten Frauen in einer Arztpraxis und ein anderes von einer glatzköpfigen Person mit drei Gliedmaßen, die ihren eigenen Bauch aufschneidet.

(Bild: Midjourney / Julia Rockwell)

Midjourneys grobschlächtiges Verbot von Prompts, die sich auf die Fortpflanzung beziehen, zeigt, wie schwierig es ist, Inhalte von generativen KI-Systemen zu moderieren. Es zeigt sich auch, dass die Tendenz von KI-Systemen, Frauen zu sexualisieren, bis hin zu ihren inneren Organen reicht, glaubt Rockwell.

Es geht auch anders

Das muss nicht so sein. OpenAI (DALL-E 2) und die Stable-Diffusion-Herstellerin Stability AI haben es inzwischen geschafft, unerwünschte Ausgaben und Prompts herauszufiltern, so dass sie, wenn man dieselben Wörter in ihre Bilderzeugungssysteme eingibt, sehr unterschiedliche Bilder erzeugen. Die Eingabeaufforderung "gynäkologische Untersuchung" ergab bei DALL-E 2 Bilder einer Person, die ein in der Realität nicht vorhandenes medizinisches Gerät hält, und bei Stable Diffusion zwei verzerrte, maskierte Frauen mit Gummihandschuhen und Laborkitteln. Beide Systeme erlaubten auch die Eingabe von "Plazenta" und produzierten daraufhin biologisch ungenaue Bilder von Organen.

(Bild: DALL-E 2 / Stable Diffusion / Melissa Heikkilä)

Ein Sprecher von Stability.AI sagte, dass das neueste Modell der Firma über einen Filter verfügt, der problematische und unangemessene Inhalte von Nutzern blockiert – sowie über ein Tool, das Nacktheit und andere unangemessene Bilder erkennt und dann ein unscharfes Bild liefert. Das Unternehmen verwendet eine Kombination aus Schlüsselbegriffen, Bilderkennung und anderen Techniken, um die von seinem KI-System erzeugten Bilder zu kontrollieren. OpenAI hat auf eine Bitte um Stellungnahme nicht reagiert, wie DALL-E 2 dies macht.

Die Werkzeuge zum Herausfiltern unerwünschter, von KI erzeugter Bilder sind jedoch noch sehr unvollkommen. Da KI-Entwickler und -Forscher noch nicht wissen, wie sie ihre Modelle systematisch überprüfen und verbessern können, behelfen sie sich mit pauschalen Verboten wie jenen, die Midjourney eingeführt hat, kommentiert Marzyeh Ghassemi, Assistenzprofessorin am MIT, die sich mit der Anwendung von maschinellem Lernen im Gesundheitsbereich beschäftigt.

Es ist unklar, warum Verweise auf gynäkologische Untersuchungen oder die Plazenta – ein Organ, das sich während der Schwangerschaft entwickelt und das Baby mit Sauerstoff und Nährstoffen versorgt – gewaltvolle oder sexuell explizite Inhalte hervorrufen würden. Aber wahrscheinlich hat es etwas mit den Assoziationen zu tun, die das Modell zwischen den Bildern in seinem Datensatz hergestellt hat, so Irene Chen, Forscherin bei Microsoft Research, die sich mit maschinellem Lernen für eine diskriminierungsfreie Gesundheitsversorgung beschäftigt.

Modelle mit schädlichen Assoziationen

"Es muss noch viel mehr getan werden, um zu verstehen, welche schädlichen Assoziationen die Modelle lernen könnten, denn wenn wir mit menschlichen Inputs arbeiten, werden die Systeme auch Vorurteile lernen", sagt Ghassemi.

Neben der Zensur von Wörtern gibt es andere Ansätze, mit denen Technologieunternehmen dieses Problem angehen könnten. Ghassemi zufolge könnten beispielsweise bestimmte Prompts – etwa solche, die sich auf die menschliche Biologie beziehen – in bestimmten Kontexten erlaubt, in anderen jedoch verboten werden.

"Plazenta" könnte etwa erlaubt sein, wenn die Wortfolge im Prompt signalisiert, dass der Benutzer versucht, ein Bild des Organs zu Bildungs- oder Forschungszwecken zu erstellen. Wurde der Prompt jedoch in einem Kontext verwendet, in dem jemand versuchte, sexuelle oder gewalthaltige Inhalte zu erzeugen, könnten sie verboten werden.

Wie grobschlächtig auch immer – die Maßnahmen von Midjourney wurden offenbar mit den richtigen Absichten durchgeführt. "Diese Leitplanken sind dazu da, Frauen und Minderheiten davor zu schützen, dass verstörende Inhalte über sie erstellt und gegen sie verwendet werden", sagt Ghassemi.

(jle)