Für Super-KI-Supercomputer: Cerebras' Riesen-CPU mit 4 Billionen Transistoren

Dank Fertigung mit 5- statt 7-Nanometer-Technik wächst die Rechenleistung der Wafer Scale Engine WSE-3 auf bis zu 126 PFlops für KI-Datentypen.

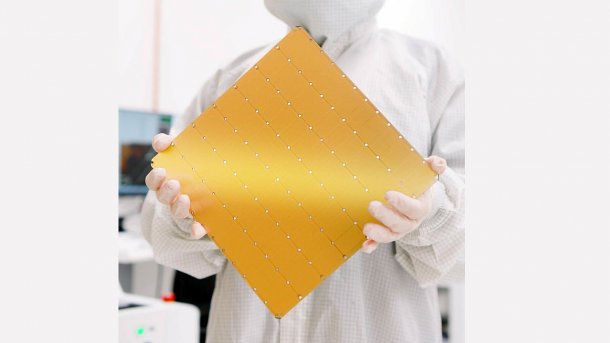

Cerebras Wafer Scale Engine WSE-3

(Bild: Cerebras)

Die kalifornische Firma Cerebras legt nach: Der Riesenprozessor Wafer Scale Engine kommt in einer neuen Generation WSE-3 aus der 5-Nanometer-Produktion von TSMC. Mit der Anzahl der Transistoren – jetzt insgesamt 4 statt bei der WSE-2 rund 2,5 Billionen – steigt die Rechenleistung bei ähnlicher elektrischer Leistungsaufnahme.

Mit der WSE-3 bestückt Cerebras die nächste Generation der hauseigenen KI-Systeme namens CS-3. Diese lassen sich mit zusätzlichen Speichererweiterungen koppeln, um noch größere KI-Modelle trainieren zu können. Cerebras verspricht, dass ein CS-3-Cluster KI-Modelle mit bis zu 24 Billionen Parametern trainieren kann.

Videos by heise

Rekord-Prozessor

Wie die Vorgängerinnen WSE (2019) und WSE-2 (2021) belegt die WSE-3 die gesamte nutzbare Fläche eines 30-Zentimeter-Siliziumwafers. Die 4 Billionen Transistoren verwendet Cerebras nicht nur für 900.000 KI-Rechenkerne, die sehr schnell miteinander vernetzt sind, sondern auch für 44 GByte schnelles SRAM.

(Bild: Cerebras)

Über schnelle Schnittstellen lassen sich bis zu 2048 CS-3-Systeme miteinander koppeln.

Außerdem können an jede CS-3 über die Schnittstelle SwarmX zusätzliche Speichererweiterungen (MemoryX) mit jeweils 1,5 TByte, 12 TByte oder 1,2 Petabyte RAM angeschlossen werden.

Laut Cerebras kann ein "kompakter Cluster" aus vier CS-3 ein KI-Modell mit 70 Milliarden Parametern in einem einzigen Tag optimieren (Tuning). Allerdings kostet eine einzige CS-2 rund 2,5 Millionen US-Dollar; genaue Preise nennt Cerebras öffentlich nicht.

Ein Rechenzentrum mit 2048 CS-3 soll laut Cerebras das generative KI-Sprachmodell Llama 70B in einem Tag trainieren können. Solche Rechenzentren baut Cerebras derzeit gemeinsam mit der Firma G42 des arabischen Investors Mubadala auf.

Dünn besetzte Matrizen

Cerebras hebt eine Besonderheit der WSEs hervor: Sie sind so ausgelegt, dass sie dünn besetzte Matrizen (sparse matrices) automatisch schneller verarbeiten. Sie sollen dabei auch von "unstructured sparsity" profitieren. Auch Hauptkonkurrent Nvidia betont, dass seine KI-Beschleuniger wie der H100 "Hopper" dank Sparsity die doppelte Rechenleistung etwa bei der Verarbeitung von Int8-Werten erreiche.

Die auf Cerebras-Maschinen trainierten Modelle sollen sich auf Inferencing-Servern mit KI-Rechenbeschleunigern von Qualcomm besonders effizient nutzen lassen. Dazu kooperieren die beiden Firmen.

Ihr könnt die c't auch bei WhatsApp abonnieren: Wir schicken werktäglich Einordnungen zu aktuellen Themen und Einblicke in den Redaktionsalltag.

(ciw)