Kein CSAM-Scanning auf dem iPhone: Australische Regierung beschwert sich

Apple will die iPhones seiner Kunden nun doch nicht automatisiert auf Missbrauchsbilder scannen. Der australische e-Safety Commissioner widerspricht.

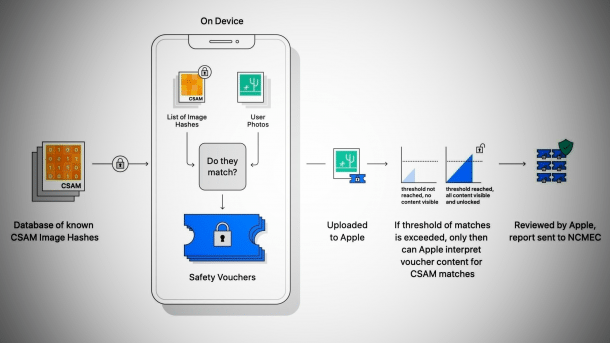

CSAM-Scanning bei Apple: So war es eigentlich geplant.

(Bild: Apple)

Apple bekommt politischen Gegenwind für seine Entscheidung, die Geräte von iCloud-Foto-Nutzern doch nicht automatisiert auf Missbrauchsbilder abzusuchen. Die australische Regulierungsbehörde für Digitales, der e-Safety Commissioner, teilte in dieser Woche in Sydney mit, man habe festgestellt, dass das Unternehmen bei iCloud "nicht proaktiv auf Missbrauchsbilder scannt". Dies sei "alarmierend".

Australische Regierung: "Eindeutig unzureichend"

Es zeige eine "eindeutig unzureichende und inkonsistente Nutzung der allgemein verfügbaren Technologie zur Aufdeckung von Material über Kindesmissbrauch und Grooming", so die Behördenchefin Julie Inman Grant in einem Statement. Neben Apple wurde auch Microsoft für ein ähnliches Verhalten bei OneDrive kritisiert. Während Apple auf Anfragen gegenüber der Nachrichtenagentur Reuters zum Thema nicht reagierte, hieß es von Microsoft, man passe seine Reaktionen im Kampf für die Kindersicherheit ständig an.

Videos by heise

Das sogenannte CSAM-Scanning in der iCloud, das direkt auf Apple-Geräten erfolgen sollte, war unter Datenschützern und Sicherheitsexperten hochgradig umstritten gewesen, weil man die Gefahr einer Backdoor auf die Geräte sah. Apple gab sich anfangs hart und wollte die Technik unbedingt umsetzen, kassierte sie nun aber sang- und klanglos – und führte zudem endlich eine Ende-zu-Ende-Verschlüsselung der meisten iCloud-Daten ein.

Apple: Kinder lassen sich auch ohne Scanning schützen

Apple hatte sich in der vergangenen Woche offiziell dazu entschieden, mit dem angekündigten Erkennungs-Tool für Bildmaterial, das sexuellen Missbrauch von Kindern zeigt, "nicht voranzuschreiten". In einer Medienstellungnahme hieß es demnach: "Kinder lassen sich schützen, ohne dass Firmen dafür persönliche Daten durchkämmen müssen."

Eine andere Funktion zum Kinderschutz ("Communication Safety") bleibt in iOS und anderen Apple-Plattformen aber enthalten: iMessage-Nachrichten werden lokal auf Nacktbilder gescannt, sollten Apple das Sicherheitsfeature aktiviert haben. Kinder und Jugendliche sollen so davon abgehalten werden, solches Material zu versenden. Zuvor hatte Apple geplant, Eltern automatisiert darauf aufmerksam zu machen, wenn Nacktaufnahmen entdeckt werden, dies dann aber wieder gestrichen.

Empfohlener redaktioneller Inhalt

Mit Ihrer Zustimmung wird hier ein externer Preisvergleich (heise Preisvergleich) geladen.

Ich bin damit einverstanden, dass mir externe Inhalte angezeigt werden. Damit können personenbezogene Daten an Drittplattformen (heise Preisvergleich) übermittelt werden. Mehr dazu in unserer Datenschutzerklärung.

(bsc)