Klein aber fein: Neues multimodales KI-Modell von Apple

In einem Forschungspapier stellen Apple-Wissenschaftler MM1 vor. Dabei handelt es sich um ein neuartiges multimodales KI-Modell mit cleverem Pre-Training.

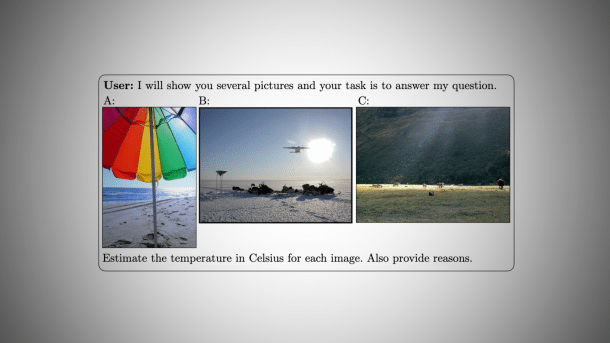

Fragestellung an MM1: Apples Modell versteht sich auch auf Temperaturschätzungen – rein aus Bildern.

(Bild: Apple / arxiv.org)

Apples KI-Forschungsabteilung hat mit MM1 ein weiteres Large Language Model (LLM) vorgestellt. Es arbeitet als sogenanntes MLLM multimodal, kann also nicht nur mit Texten, sondern auch mit Bildern umgehen. Laut einem in der vergangenen Woche vorgestellten Papers des Teams um die Hauptautoren Brandon McKinzie und Zhe Gan lässt es sich auf bis zu 30 Milliarden Parameter ausdehnen. Damit wäre MM1 deutlich kompakter als große Modelle wie GPT-4 oder Google Gemini und somit weniger leistungshungrig. Dennoch soll MM1 durch ein spezielles Pre-Training konkurrenzfähig sein.

SOTA trotz geringer Größe

Eine sorgfältige Mischung aus Bild-Beschriftungen, Bild-Text- und Nur-Text-Daten sei entscheidend, um ein multimodales Pre-Training im großen Maßstab durchzuführen, das "State-of-the-Art (SOTA)-Ergebnisse in mehreren Benchmarks" erreiche. Als Beispiele der Möglichkeiten von MM1 zeigen die Apple-Forscher, wie das Modell aus Bildern verschiedener Orte Rückschlüsse auf deren aktuelle Temperaturverhältnisse zieht – inklusive Begründung, wie es dazu kommt. Es ist dabei auch ein sogenanntes Multi-Step-Reasoning über mehrere Bilder hinweg möglich – in Form einer Gedankenkette (Chain of Thought).

Videos by heise

Im Rahmen der Arbeit an MM1 wurde auch erforscht, welche Komponenten der LLM-Architektur besonders wirksam waren. Das reicht von einfachen Dingen wie der Auflösung der Trainingsbilder bis hin zur Komplexität des visuellen Encoders, den MM1 verwendet. "Wir hoffen, dass die von uns gelernten Lektionen [bei der Erstellung von MM1] der KI-Community helfen werden, starke Modelle zu entwickeln, die über die eine einzelne spezifische Modellarchitekturen oder Datenstrategien hinausgehen", so McKinzie und Co.

Apple-Forscher wollen mehr Offenheit

In seinem Paper übt das Apple-Team aber auch Kritik. "Die meisten Arbeiten zu multimodalen großen Sprachmodellen, sowohl offene als auch geschlossene, geben so gut wie nichts über den Prozess preis, den sie durchlaufen haben, um zu ihren algorithmischen Designentscheidungen zu gelangen." Dies gelte insbesondere für die wichtige Pre-Training-Phase. "Um die Forschung in diesem Bereich voranzutreiben, halten wir es für unerlässlich, Prinzipien und Lehren für den Aufbau solcher Modelle zu destillieren."

Die gehe über konkrete Implementierungen der einzelnen Komponenten hinaus. "Daher dokumentieren wir in diesem Papier den MLLM-Erstellungsprozess und versuchen, Lehren für die Gestaltung zu formulieren, die hoffentlich für die KI-Community von Nutzen sind." Weitere Infos zu MM1 finden sich auch in einem eigenen Artikel bei den Kollegen von The Decoder.

Empfohlener redaktioneller Inhalt

Mit Ihrer Zustimmung wird hier ein externer Preisvergleich (heise Preisvergleich) geladen.

Ich bin damit einverstanden, dass mir externe Inhalte angezeigt werden. Damit können personenbezogene Daten an Drittplattformen (heise Preisvergleich) übermittelt werden. Mehr dazu in unserer Datenschutzerklärung.

(bsc)