Nvidia bringt A100-Beschleuniger mit 80 GByte HBM2E und 400G Infiniband

Nvidias HPC-Beschleuniger A100 zielt mit 80 GByte HBM2E-RAM auf riesige Datensätze und Nvidia-Tocher Mellanox bringt Infiniband-Karten mit 400 GBit/s.

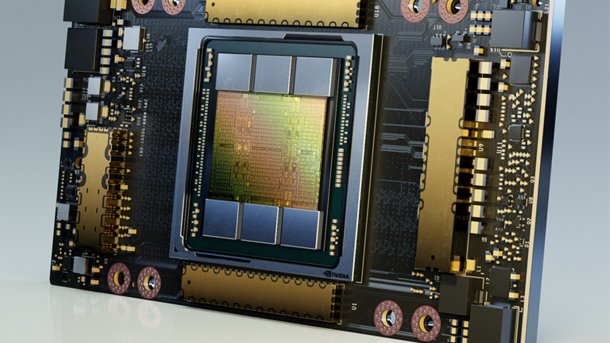

Nvidias A100: Jetzt mit auf 80 GByte verdoppeltem Speicher

(Bild: Nvidia)

Gerade einmal ein halbes Jahr nach der Vorstellung des Rechenbeschleunigers Nvidia A100 mit Ampere-Architektur bringt Nvidia eine aufgebohrte Version auf den Markt. Beim A100 80GB ist der Name Programm: Es handelt sich um die gleiche GPU auf dem gleichen SXM4-Modul, nur am Speicher hat Nvidia geschraubt und ihn auf fette 80 GByte verdoppelt.

Die A100 80GB sollen im ersten Quartal 2021 als FRU-Upgrade-Kits verfügbar sein, um bestehende Installationen aufzurüsten. Erste Lieferungen erwartet Nvidia im Januar, größere Mengen ab Februar. Einzeln wird es die A100 im SXM4-Format weiterhin nicht geben – nur in den HGX-Baseboards, wie sie etwa in der DXG Station verbaut sind. Dort können dann vier A100 auf einen via NVLink vereinheitlichten Pool von 320 GByte Speicher zugreifen.

Erste Exemplare der DGX A100 640 GB seien bereits an Partner wie die University of Florida ausgeliefert worden.

HBM2E statt 6144 Bit

Beim Speicherausbau klotzt Nvidia. Anstatt den sechsten Speichercontroller und damit auch den sechsten HBM-Chip freizuschalten, nutzt Nvidia HBM2E-Chips mit verdoppelter Kapazität von jeweils 16 GByte. Fünf von ihnen sorgen zusammengenommen für eine Transferrate von über 2 TByte/s – genauer 2,036 TByte/s. Damit dürften sie, auch wenn Nvidia offiziell keine Taktraten nennt, mit 1590 MHz getaktet sein und folglich knapp 32 Prozent schneller arbeiten als auf Nvidias "alter" A100 mit 40 GByte.

Der beschleunigte und vergrößerte Speicher beschert der A100 80GB laut Nvidia in manchen Anwendungen einen deutlichen Performance-Schub. Am meisten profitierten riesige Datensätze, die zuvor nicht in den lokalen Speicher passten. Das sei zum Beispiel beim Training eines KI-gesteuerten Empfehlungssystems (DLRM, Huge CTR Framework mit einem 450-GByte-Datenset) der Fall, das nun bis zu 2,6x so schnell (+160%) gelänge. Auch Big-Data-Analyse an einem 10 TByte umfassenden Datenset laufe deutlich schneller – Faktor 1,9 (+90%) nennt Nvidia hier. HPC-Benchmarks wie Quantum Espresso, welches immerhin auch 1,6 TByte an Daten nutzt, liefen 1,8x (+80%) so schnell.

Für das KI-Inferencing holt Nvidia nach eigenen Angaben 25 Prozent Leistung heraus – auf dem Spracherkennungssystem RNN-T, bei dem 7 MIG-Instanzen à 10 GByte parallel laufen, die gut in den Speicher der A100 80 GB passen. Die Energieeffizienz will Nvidia auf über 25 GFlops/Watt gesteigert haben.

Videos by heise

Schnelles 400G-Infiniband

Auch die Supercomputer-Hersteller dürften sich freuen: Nvidia-Tochter Mellanox bringt mit 400 GBit/s eine neue Geschwindigkeitsstufe für noch schnelleren Datenaustausch einzelner Knoten. Die Karten sollen mit passiven Kupferkabeln bis zu 1,5 Meter Länge arbeiten und damit ohne weiteres innerhalb eines Racks nutzbar sein. Für größere Strecken brauche es dann aber aktive Kupferkabel oder gleich Lichtwellenleiter. Atos, Dell, Fujitsu, Inspur, Lenovo und Supermicro sollen bereits Interesse bekundet haben. (csp)