Vorbild "Die Sims": ChatGPT treibt in virtueller Stadt autonome Agenten an

Was passiert, wenn man ChatGPT mit den Sims kreuzt? Eine Forschergruppe der Stanford University und von Google hat es ausprobiert.

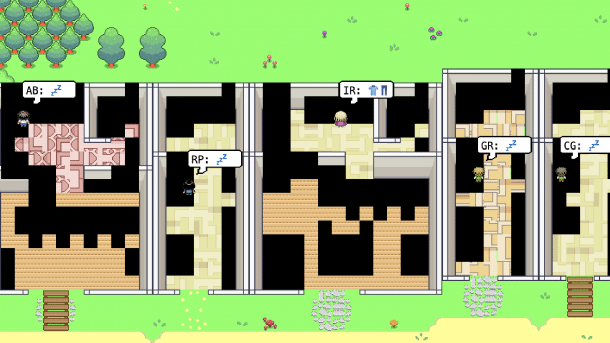

Die meisten Bewohner der virtuellen Stadt schlafen noch, doch Isabella Rodriguez (IR) zieht sich bereits an.

(Bild: Demo-Version zum Paper "Generative Agents" von Joon Sung Park et al.)

Forschende von Google und der Stanford University haben ChatGPT verwendet, um die Kommunikation und das Verhalten einfacher autonomer Software-Agenten in einer simulierten Umgebung zu steuern. Die 25 Software-Agenten, die in der "Smallville" genannten virtuellen Gemeinschaft "leben" und "arbeiten", zeigen nach Angaben der Forschenden nicht nur "realistische menschliche Verhaltensweisen", sondern auch "emergente soziale Interaktionen". Der Plan, eine Valentinstag-Party zu feiern, der einem der Agenten vorgegeben wurde, führte etwa dazu, dass die simulierte Person Einladungen an andere Agenten verschickte und vorher den Raum dekorierte, in dem die Feier stattfinden sollte – und sich dabei, weil die Zeit knapp war, sogar Hilfe organisierte.

Videos by heise

"Generative Agenten wachen auf, machen Frühstück und gehen zur Arbeit; Künstler malen, während Autoren schreiben; sie bilden sich Meinungen, nehmen sich gegenseitig wahr und beginnen Gespräche; sie erinnern sich an vergangene Tage und denken über sie nach, während sie den nächsten Tag planen", schreiben die Forscher in ihrem Paper, zu dem es auch eine Demo-Version gibt.

All diese Aktionen führen die Software-Agenten aber nicht wirklich aus. Sie werden vielmehr als Text ausgegeben, der wiederum dann anderen Agenten als Input dient, genau wie die Beschreibung der einzelnen Orte in Smalville. Das Sprachmodell spricht also gewissermaßen in verschiedenen Rollen mit sich selbst und spielt parallel die Handlungen von 25 Agenten wie in einem textbasierten Rollenspiel durch.

Neues Verhalten von Software-Agenten

Das hat den Vorteil, dass das Spektrum der Verhaltensweisen der Agenten überraschend vielfältig ist. Zwar ist die Simulation von Verhalten in einer Modell-Umgebung nicht neu – US-Wissenschaftler nutzen Multi-Agengen-Systeme beispielsweise, um politische Maßnahmen gegen die Opiod-Krise durchzutesten – aber in der Regel agieren die Software-Agenten in einer solchen Simulation auf der Basis einfacher Wenn-Dann-Regeln. Ihr Verhaltensspektrum ist dadurch sehr begrenzt. Zwar sind in der Vergangenheit auch Beispiele von Agenten mit "kognitiver Architektur" gezeigt worden, die in der Lage sind zu lernen und neue Verhaltensweisen zu entwickeln. Ihre Fähigkeiten reduzierten sich aber darauf, wie man Gegner abschießt – kommunizieren und zusammen arbeiten ist für sie deutlich zu komplex.

Sprachmodelle können deutlich mehr – insbesondere kommunizieren. Eines der Probleme, das Joon Sung Park und seine Kollegen dabei allerdings lösen mussten, ist die begrenzte "Kontextlänge" des Sprachmodells. Der Input-Prompt, in dem Informationen über den virtuellen Ort, die Vorgeschichte und eventuelle Ziele des Agenten enthalten sein müssen, hat eine maximale Länge von 2.048 Token – was ganz grob 6.000 Wörtern entspricht. Um die Agenten konsistent handeln zu lassen, verknüpften die Forschenden das Sprachmodell deshalb mit einer Datenbank, die den "Gedächtnisstrom" jedes Agenten enthält.

Die Datei besteht zum einen aus "Beobachtungen" des Agenten – wo bin ich, wie ist der Zustand der Gegenstände an diesem Ort? Was tue ich? –, die mit einem Zeitstempel versehen sind. In dem Erinnerungsstrom sind aber auch abstraktere Zusammenfassungen von Ereignissen und Interaktionen enthalten, sowie Pläne und Vorhaben. Beides – abstrakte Zusammenfassungen und Pläne – lassen die Autoren ebenfalls von ChatGPT erzeugen. Vor jeder Aktion sucht dann ein Abfragemodul die aktuellsten und relevantesten Einträge aus dem Gedächtnisstrom und erzeugt daraus den Kontext für den nächsten Input-Prompt.

Interaktionen zwischen den Agenten

Es läge relativ nahe, den Software-Agenten eine Art Intelligenz zuzuschreiben. Das tun die Autoren des Papers aber nicht, obwohl ähnliche Systeme, die große Sprachmodelle mit externer Software wie Planungsmodulen etc. verknüpfen und sie so "autonom" machen, gerade viel Aufmerksamkeit auf sich ziehen. Ob große Sprachmodelle mehr können, als nur Texte zu ergänzen – insbesondere logische Folgerungen zu ziehen, Pläne zu erstellen oder über Ziele und Absichten von anderen Agenten oder Menschen zu spekulieren – ist derzeit heftig umstritten. Prinzipiell sind es zwar "nur" Textergänzer. Tatsächlich können große Sprachmodelle wie ChatGPT in Form von fiktiven Szenarien gestellte Aufgaben dieser Art aber immer wieder lösen. Rein pragmatisch betrachtet funktioniert das System damit tatsächlich.

In der Veröffentlichung führen die Forscher drei "emergente" Verhaltensweisen auf, die sich einzig aus den Interaktionen zwischen den Agenten ergaben: Die "Informations-Diffusion"-Agenten gaben Informationen weiter, wenn es zweckmäßig war –, Koordination der Aktionen mehrerer Agenten untereinander und das Knüpfen neuer Beziehungen untereinander. Charmanterweise konnten die Forschenden das direkt überprüfen, indem sie die einzelnen Agenten während der laufenden Simulation immer wieder "interviewten".

(Bild: Joon Sung Park et al.)

Um die Agenten in Computerspielen einzusetzen, ist das System allerdings zu langsam und zu rechenintensiv. Die Forscher schlagen deshalb vor, die Software zum Beispiel für das Design von Online-Communities zu verwenden, weil man damit die Auswirkungen bestimmter Regeln und Verhaltensweisen testen kann. Trotzdem hat auch dieses System mit einem grundlegenden Problem zu kämpfen, das alle Anwendungen von großen Sprachmodellen plagt: Ob sich das System stabil verhält, wissen die Autoren nicht. Bisher haben sie die Simulation nur über zwei virtuelle Tage laufen lassen. Es besteht durchaus die Gefahr, dass das Sprachmodell halluziniert oder sprachlich aus dem Ruder läuft – und einzelne Agenten dann nicht mehr mit den anderen interagieren können.

Siehe auch:

- ChatGPT bei heise Download

(jle)