Missing Link: Nichts Neues am LHC – Physiker in der Sackgasse?

Der LHC sucht seit 10 Jahren nach neuen Teilchen. Außer dem in den 60er Jahren vorhergesagten Higgs-Boson hat er nichts gefunden. Physiker wissen nicht weiter.

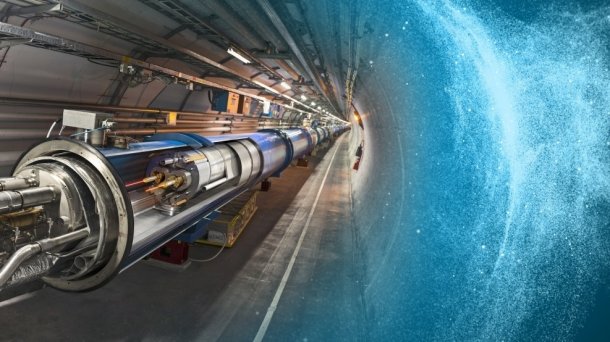

(Bild: © 2015-2018 CERN)

Sie reden von einer Krise, hier in den Grundlagen der Physik. Seit 40 Jahren haben wir keine neuen Naturgesetze mehr gefunden. Der Fortschritt stagniert. Nichts geht. Keiner weiß, was zu tun ist.

Ja, wir haben 2012 das Higgs-Boson gefunden und dafür gab es 2013 einen Nobelpreis. Aber die Theorie zum Higgs-Boson wurde bereits in den 60er Jahren entwickelt. Ja, wir haben bemerkt, dass Teilchen mit Namen Neutrinos eine Masse haben und nicht, wie zuvor angenommen, masselos sind. Auch dazu gab es kürzlich, im Jahre 2015, einen Nobelpreis. Aber die Theorie der Neutrinomassen stammt aus den 50er Jahren. Ja, wir haben Gravitationswellen gefunden, und auch die waren einen Nobelpreis wert, in 2017. Aber die Allgemeine Relativitätstheorie, die das vorhersagte, ist mehr als 100 Jahre alt.

Es ist nicht so, dass es den Physikern an Daten fehlt – es ist nur so, dass die Daten immer nur wieder die bereits bekannten Theorien bestätigen und nichts Neues enthüllen. Das Problem sind nicht die Experimente. Das Problem ist die mangelnde Vorhersagekraft der theoretischen Physiker. Denn die haben viele Vorhersagen gemacht, zum Beispiel für den Large Hadron Collider (LHC) am CERN in Genf, und diese Vorhersagen lagen alle daneben.

Wenig Aufregendes am LHC

Der Large Hadron Collider läuft seit September 2008 und ist derzeit der weltgrößte Teilchenbeschleuniger. Genau gesagt beschleunigt er Protonen in einem 27 Kilometer langen Ring nahezu auf Lichtgeschwindigkeit und bringt sie dann zur Kollision an vier verschiedenen Punkten, wo die Physiker dann messen, was passiert. Gerade wurde am LHC die zweite Phase der Messungen beendet. Um weitere Optimierungen an der Maschine vorzunehmen, ist jetzt erst einmal Pause bis 2021. Eine gute Gelegenheit, um Bilanz zu ziehen.

Am LHC wurden außer dem Higgs-Boson auch einige neue, aber nicht elementare, Teilchen gefunden; Teilchen also, die aus schon bekannten, kleineren Teilchen zusammen gesetzt sind. Anhand der besseren Daten haben theoretische Physiker außerdem ihre Modelle für die Struktur von Protonen verbessern können. Auch die Eigenschaften der bekannten Teilchen – etwa deren Masse und Zerfallszeit – haben die Physiker dank des LHC viel besser bestimmen können.

In vielerlei Hinsicht hat der LHC daher die Forschung vorangebracht. Aber theoretischen Physikern zufolge hätte der LHC noch weitere aufregende Entdeckungen machen sollen: Supersymmetrische Teilchen, zum Beispiel, oder zusätzliche Raumdimensionen, oder kleine Schwarze Löcher. Irgendwas Neues halt. Das ist aber nicht geschehen. Mit diesen Vorhersagen lief also etwas gründlich schief.

Die erste Aufrüstung des LHC (8 Bilder)

(Bild: © 2013 CERN)

Reihenweise Fehlschläge

Dass der LHC keine neuen Teilchen gefunden hat, ist nicht die einzige Vorhersage in den Grundlagen der Physik, die nicht eingetroffen ist. Genauso schlecht gelaufen ist es mit der Suche nach den Teilchen, aus denen die Dunkle Materie gemacht sein soll.

Aus Dunkler Materie bestehen angeblich 85 Prozent der gesamten Materie im Universum. Das haben Astrophysiker geschlussfolgert aus vielen Beobachtungen, die darauf hinweisen, dass die Gravitationsanziehung der normalen Materie allein nicht ausreichend ist, um unser Universum zu erklären. Zum Beispiel gibt es nicht genug normale Materie, um galaktische Strukturen so zu bilden, wie wir sie sehen. Normale Materie reicht auch nicht, um zu erklären, wie schnell sich Galaxien in Clustern bewegen. Dazu braucht man zusätzliche Materie, die anders ist als die Materie, mit der wir normalerweise zu tun haben. Dunkel eben.

Aber woraus ist Dunkle Materie gemacht? Ein Teilchen sollte es sein, sagten die Teilchenphysiker. Und danach hat man gesucht, bereits seit den 80er Jahren, mit immer größeren Detektoren. Solche Experimente finden normalerweise tief unter dem Boden statt, in alten Minen – weil man mit dem vielen Gestein störende Signale der kosmischen Hintergrundstrahlung herausfiltern kann. Aber gefunden hat man die Teilchen dennoch nicht.

Genauso gescheitert sind zahlreiche Experimente, die nach einer fünften Kraft suchten.

In den Grundlagen der Physik gibt es derzeit nur vier Kräfte. Das ist neben der Gravitation, die von Einsteins Allgemeiner Relativitätstheorie beschrieben wird, die elektromagnetische Kraft und die zwei Kernkräfte (schwach und stark), die vom Standardmodell der Teilchenphysik beschrieben werden. Nun haben Astrophysiker aber vor 20 Jahren gemerkt, dass das Universum sich nicht nur ausdehnt, sondern dass diese Ausdehnung zudem schneller wird. Für die Allgemeine Relativitätstheorie bedeutet das, das die sogenannte "kosmologische Konstante" nicht null ist.

Um den Wert der kosmologischen Konstante zu erklären, haben theoretische Physiker sich neue Kräfte ausgedacht, die benannten fünften Kräfte. Danach hat man gesucht, – etwa indem zum Beispiel die Gravitationskraft auf kleinen Abständen ganz genau gemessen wurde. Dort gab es aber nur die gute, alte Gravitation zu finden. Also auch diese Theorien zu den fünften Kräften waren alle falsch, zumindest soweit man sie überhaupt testen kann.

Was ist los mit den Theoretikern?

Um zu verstehen, was hier passiert ist, lohnt sich ein Blick in die Geschichte der Naturwissenschaften. Anfang des 20. Jahrhunderts haben Physiker die Grundlagen ihres Gebiets komplett überholt. Nicht nur fand Einstein heraus, dass Raum und Zeit zusammengehören und gekrümmt sind, auch bemerkte Heisenberg, dass die Materie einer unvermeidbaren Unschärfe unterliegt. Heisenberg, Schrödinger und einige andere hellen Köpfen, zogen damals den Schluss, dass Materie durch die Quantenmechanik beschrieben werden muss.

Die Quantenmechanik war dramatisch erfolgreich und das nicht nur, weil man damit die Ordnung des Periodensystems und die, damals schon lange bekannten, Atomspektren berechnen konnte. Die Quantenmechanik ist auch diejenige Theorie, auf der alle Technik beruhen, auf die wir uns heute so selbstverständlich verlassen: Halbleiter und Transistoren, Laser und Digitalkameras, Atomuhren, LEDs, und Magnetspinresonanz – alles das haben wir nur dank der Quantenmechanik. Da sind die Physiker zurecht stolz drauf.

Nachdem sie die Quantenrevolution abgehakt hatten, begannen Physiker dann, die Struktur der Materie auf kleineren und kleineren Abständen zu testen. Dabei fanden sie erst die Bestandteile der Atome, dann die Bestandteile der Atomkerne, und dann wiederum die Bestandteile der Bestandteile der Bestandteile. All diese Einsichten fassten sie in den 70er Jahren im Standardmodell der Teilchenphysik zusammen.

Schöne Ideen

Die Theorie des Standardmodells beruht stark auf der Idee von Vereinheitlichung und Symmetrie. Vereinheitlichung deshalb, weil man erst die elektrische mit der magnetischen Kraft zusammenfügte, und danach die elektromagnetische mit der schwachen Kernkraft zur sogenannten "elektroschwachen Kraft". Die starke Kernkraft jedoch sitzt immer noch etwas im Abseits und will nicht so ganz mit der elektroschwachen zusammenpassen. Symmetrisch ist das, weil jede dieser Kräfte von recht einfachen Symmetrieprinzipien abgeleitet werden kann.

Nachdem sie also nun das Standardmodell hatten, dachten die Physiker, man könnte den bisherigen Erfolg auf dieselbe Art und Weise fortsetzen. Entsprechend versuchte man sich an der sogenannten "großen Vereinheitlichung" der drei Kräfte im Standardmodell oder gleich an der "Theorie von Allem", bei der auch noch die Gravitation mit drin sein soll. Aber diese Methode funktionierte nicht.

Verschiedene Ansätze zur großen Vereinheitlichung, die auf Symmetrien basieren, wurden schon in den 80er Jahren experimentell ausgeschlossen. Das war möglich, weil diese Theorien vorhersagten, dass Protonen zerfallen können, was nicht beobachtet wurde. Die Physiker aber wollten die Idee von Vereinheitlichung und Symmetrie nicht aufgeben. Daher haben sie seitdem immer weitere solcher schön symmetrischen Theorien vorgeschlagen. Die Theorien sind dabei zunehmend komplexer geworden sind, um weiterhin mit den Daten im Einklang zu sein.

Wie der Name schon vermuten lässt, steckt der Wunsch nach Symmetrie auch hinter der Theorie der Supersymmetrie. Die Supersymmetrie erweitert das Standardmodell durch die Hypothese von neuen Partnerteilchen, die zu den schon bekannten Teilchen passen sollen. Die Idee der Supersymmetrie wird von theoretischen Physikern auch bereits seit den 80er Jahren verfolgt und ist schon ganz zu Anfang in Konflikt mit Beobachten geraten. Anstatt die Theorie aufzugeben, haben Theoretiker die Supersymmetrie jedoch aufgepeppt, sodass der Widerspruch mit dem Experiment nun nicht mehr auftritt. Nach den supersymmetrischen Partnerteilchen wird derweil immer noch gesucht.

Natürlichkeit

Ein weiteres Kriterium, das Physiker außer Symmetrien derzeit gerne zur Theorieentwicklung benutzen, ist, dass sie in einer Theorie nur bestimmte Zahlen haben wollen. Wir reden hier nicht von Zahlen mit Einheiten, wie zum Beispiel Längen, sondern reine Zahlen ohne Einheiten. Eine gute Theorie, so denkt man in den Grundlagen der Physik heute, sollte nur Zahlen haben die nahe an Eins sind. Nicht zu groß und nicht zu klein, sondern gerade richtig.

Einen besonderen Grund dafür gibt es nicht. Es wäre halt schön, wenn die Natur so wäre. Tatsächlich nennen Physiker solche hübschen Zahlen auch "natürliche Zahlen". Die Idee dazu kommt aus der Intuition, dass wir in unserem täglichen Leben sehr große oder sehr kleine Zahlen selten rein zufällig antreffen. Unnatürliche Zahlen brauchen normalerweise eine Erklärung.

Stellen Sie sich zum Beispiel vor, Sie pflanzen Karotten, und eine von denen wird 1000 Mal so groß wie die anderen. Da glauben Sie doch, da muss etwas dahinterstecken! Genau so geht es den Physikern mit unnatürlichen Zahlen. Da muss eine Erklärung dafür her. Und dazu postulieren sie dann neue Teilchen oder Symmetrien. Die bereits erwähnte Kosmologische Konstante ist in etwa so ein Fall. Zu klein, sagen die Physiker, eine fünfte Kraft soll es richten. Es gibt noch ein paar andere solcher anstößigen Zahlen, die Masse vom Higgs-Boson zum Beispiel. Die Supersymmetrie soll erklären, warum die so klein ist.

Nun ist es aber so, dass Sie Ihre Riesenkarotte deshalb kritisch beäugen, weil sie schon viele Karotten gesehen haben. Wenn es um die "Theorie von Allem" geht, dann haben die Physiker aber keine Erfahrung, mit der sich das Erstaunen rechtfertigen ließe. Für die Zahlen in unseren Theorien können wir auch keine Erfahrung sammeln, denn wir können keine Universen mit anderen Grundgesetzen im Garten züchten. Es gibt daher keinen Grund zu erwarten, dass die Zahlen in den Theorien im Sinne der Physiker "natürlich" sein müssen.

Es war dieser Glaube, dass natürliche Zahlen irgendwie besser sind, wegen dem so viele Physiker dachten, dass der LHC neben dem Higgs-Boson noch etwas anderes sehen sollte. Dasselbe Argument steckt hinter der Hoffnung, dass man Teilchen mit dem Namen "Axionen" in einem der extra für sie gebauten Detektoren finden sollte. Und Zahlenspiele, die sich auf vermeintlich – aber nicht nachweisbar – unwahrscheinliche Zufälle stützen sind auch der Grund, warum viele Physiker dachten, Dunkle Materie sind eine Art Teilchen namens WIMPs (Weakly Interacting Massive Particles), die man ebenfalls nicht gefunden hat.

Das Argument Schönheit hat Geschichte

Schon in der Vergangenheit haben Schönheitsargumente Physiker oft in die Irre geführt, denn viele wissenschaftliche Theorien, die einst für schön gehalten wurden, waren schlicht falsch. Zum Beispiel die Idee, dass die Planeten sich auf Kreisbahnen bewegen, wie die Astronomen lange dachten. Eigentlich sind es Ellipsen. Oder, wie Kepler dachte, dass die Durchmesser dieser Kreisbahnen durch reguläre Polyeder, die Platonischen Körper, bestimmt sind. Stimmt aber nicht. Oder dass Atome eigentlich Knoten in einem unsichtbaren Aether sind. Leider auch falsch.

Auf der anderen Seite sind da die hässlichen Theorien, die gut funktionieren. Die Quantenmechanik, zum Beispiel, die finden viele Physiker heute immer noch hässlich. Sie ist aber ausgesprochen erfolgreich. Oder das sich dynamisch entwickelnde Universum. Vor 100 Jahren fanden die Physiker diese Idee abstoßend, sie ist aber wahr.

Man lernt von diesen historischen Beispielen zweierlei. Erstens ist das, was schön ist, nicht immer wahr. Zweitens, was Wissenschaftler als schön bezeichnen, hat sich im Laufe der Zeit geändert und wird sich wohl auch weiter ändern. Wenn Sie heute einen Astronomen fragen, ob Ellipsenbahnen hässlich sind, tippt der sich vermutlich nur den Kopf. Wenn ich jedoch meinen Kollegen in den Grundlagen der Physik solche historischen Beispiele dafür vorhalte, dass Schönheit eine Theorie nicht vielversprechend macht, sagen sie mir, dass solche alten Ideen, die einst für schön gehaltenen wurden, ja eigentlich auch nicht schön waren. Hinterher ist man eben immer klüger.

Was tun?

Um zu rekapitulieren: In den Grundlagen der Physik verlässt man sich seit den 70er Jahren auf Schönheitsargumente. Diese funktionieren nicht und die Vorhersagen treffen nicht ein. Dennoch korrigieren die Physiker ihre Methoden nicht. Was geht hier vor sich?

Für mein Buch "Das hässliche Universum" habe ich mit vielen Physiker in den betroffenen Gebieten darüber gesprochen, warum sie denn so dickköpfig an Methoden festhalten, die nur falsche Vorhersagen produzieren. Erst einmal bekomme ich da oft das Argument von der Erfahrung: Hat doch vorher funktioniert. Wie die oben genannten Beispiele belegen, stimmt das aber nicht. Es ist eher so, dass Physiker sich vorzugsweise an die Fälle erinnern, wo schöne Theorien erfolgreich waren, wie in der Entwicklung des Standardmodells und der Allgemeinen Relativität.

Mein Eindruck ist vielmehr, dass Physiker an schönen Theorien arbeiten, weil sie das gerne machen. Und weil Ihre Kollegen das auch gerne machen, kann man zu solchen Theorien gut wissenschaftliche Artikel veröffentlichen, die dann – ganz wichtig – auch von anderen Physikern gerne zitiert werden. Aus der Sicht der Theoretiker sieht das wie Fortschritt aus. Es wird veröffentlicht, es wird diskutiert, man hält Konferenzen. Alles ist gut. Ob man dabei was über die Natur lernt, spielt eine untergeordnete Rolle. In seinem 1996 erschienenen Buch "An den Grenzen des Wissens" prägte der US-amerikanische Wissenschaftsjournalist John Horgan dafür den Ausdruck "ironische Wissenschaft".

Dass man Theorien auf Schönheitsargumente aufbaut, die nicht funktionieren, ist daher heute in den Grundlagen der Physik allgemein akzeptierte wissenschaftliche Praxis. Man lernt das so. Alle anderen machen das auch. Und das gibt Physikern den Eindruck, sie machen alles richtig. Wenn nun einer etwas anders machen will, dann ist das schwierig. Das dauert länger und dann wird es nicht ordentlich zitiert. Wissenschaftler, die etwas anders machen wollen, finden daher heute keine Forschungsgelder und keine Stelle. Sie steigen aus. Und so bleibt der Status Quo erhalten.

Dass sich erfolglose wissenschaftliche Methoden in Wissenschaftskollektiven festsetzen können, gibt es natürlich nicht nur in der Physik. Das Schönheitsgefasel ist ein spezielles Problem der Physiker, aber das grundlegende Problem, dass Wissenschaftler heute an dem arbeiten müssen, was schnelle Ergebnisse liefert und bei den Kollegen populär ist, findet sich in allen Fachbereichen.

In der Psychologie, zum Beispiel, sind jahrzehntelang statistische Analysemethoden benutzt worden, von denen lange bekannt war, dass sie zu Trugschlüssen führen. Warum? Weil es einfach war und alle das machten. In der Medizinforschung führt man auch weiterhin die meisten Studien an Mäusen durch, obwohl bekannt ist, dass die Ergebnisse von Mäusen schlecht auf Menschen übertragbar sind. In vielen Fällen lassen sich die Ergebnisse von Mäusen nicht mal auf Ratten übertragen. Wieso hält man also in den Mäusen fest? Mäuse sind billig und einfach und jeder benutzt sie. Also bleibt man dabei.

Wir brauchen dringend eine Reform des Wissenschaftssystems, um solchen Unfug in der Zukunft zu verhindern. Ein größerer Teilchenbeschleuniger wird dieses Problem nicht lösen. (mho)