Nvidia Jetson TX2: Embedded-Modul mit Pascal-GPU

Nvidia baut die Jetson-Familie von Rechenmodulen für leistungshungrige Anwendungen in autonomen Fahrzeugen, Drohnen und Kameras weiter aus.

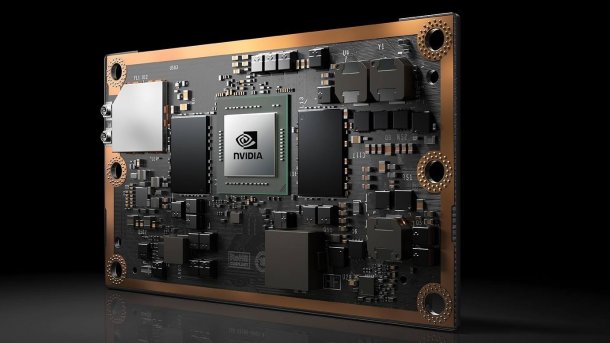

Nvidia Jetson TX2 mit Parker-SoC.

(Bild: Nvidia)

Entwickler von Embedded Systems etwa für autonome Autos, Überwachungskameras oder auch Drohnen können bei Nvidia das Rechenmodul Jetson TX2 für 399 US-Dollar vorbestellen. Ein Entwickler-Kit inklusive Adapterplatine mit vielen Anschlüssen kostet 599 US-Dollar. Die Auslieferung soll am 14. März beginnen – da startet in Nürnberg die Fachmesse embedded world.

(Bild: Nvidia)

Herzstück des Jetson TX2 ist das ARM-SoC namens Parker: Es vereint zwei Rechenkerne mit der von Nvidia selbst entwickelten Denver-Mikroarchitektur mit vier Cortex-A57-Kernen und einer Pascal-GPU. Letztere verfügt über 256 Shader-Cores.

Bis auf die Denver-Cores ähnelt die Ausstattung des Parker der des Tegra X1 auf dem Jetson TX1, aber der Neuling ist wesentlich leistungsfähiger: Die Pascal-GPU liefert mehr Rechenleistung und Nvidia hat auch die Anbindung des LPDDR4-Speichers von 64 auf 128 Leitungen verdoppelt. Die CPU- und GPU-Kerne des Jetson TX2 können mit 58,3 GByte/s auf 8 GByte RAM zugreifen.

Mehr Leistung, höhere Effizienz

Laut Nvidia haben sich Rechenleistung und Effizienz beim Jetson TX2 im Vergleich zum Jetson TX1 verdoppelt. Letzterer ist weiterhin erhältlich, kostet jetzt aber 299 statt 399 US-Dollar.

(Bild: Nvidia)

Der Jetson TX2 läuft in unterschiedlichen Betriebsmodi. Maximale Effizienz soll er liefern, wenn seine Leistungsaufnahme auf 7,5 Watt begrenzt ist (Max-Q). Dann taktet die GPU mit maximal 854 MHz, die Cortex-A57-Kerne sind auf 1,2 GHz limitiert. Im Max-P-Modus verheizt Jetson TX2 bis zu 15 Watt, taktet seine GPU mit bis zu 1122 MHz und die CPU-Kerne mit 1,4 oder 2 GHz – je nachdem, ob nur die A57-Kerne oder nur die Denver-Kerne oder alle gemeinsam laufen.

Auf dem Jetson TX2 läuft Linux for Tegra (L4T 27.1) auf Basis von Ubuntu 16.04 mit Kernel 4.4. Das SDK JetPack 3.0 steht ebenfalls zum Start der embedded world zum Download bereit. Nvidia packt TensorRT 1.0 für Deep Learning Inferencing hinein, aber auch die Deep-Neural-Network-Bibliothek cuDNN 5.1, das Bildverarbeitungspaket VisionWorks 1.6, CUDA 8 sowie eine Multimedia-API, über die sich etwa die HEVC-De- und Encoder ansprechen lassen.

[Update:] In Europa kostet das Entwicklerkit mit Jetson TX2 649 Euro. Nvidia gewährt Universitäten Rabatt, für sie kostet es 350 Euro. (ciw)