Bildbearbeitung: Adobe-KI soll manipulierte Gesichter erkennen

Adobe forscht daran, wie sich Bildmanipulationen automatisiert erkennen lassen. Auf die Anwendung eines bestimmten Werkzeugs wurde jetzt eine KI trainiert.

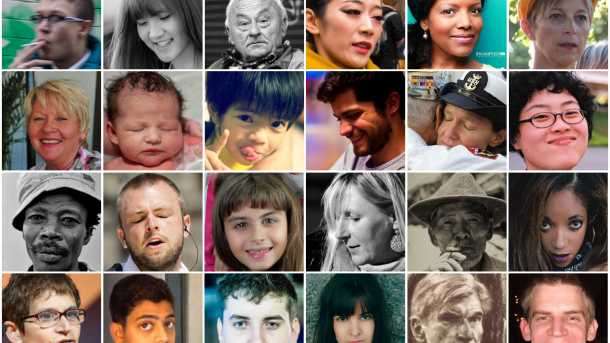

Unveränderte und manipulierte Bilder, für Menschen kaum unterscheidbar. Tipp: Die ersten beiden Zeilen zeigen unveränderte Bilder, die Zeilen drei und vier manipulierte.

(Bild: UC Berkeley / Adobe Research)

Adobe hat zusammen mit Forschern der Universität in Berkeley einem künstlichen neuronalen Netz beigebracht, Bildmanipulationen von Gesichtern zu erkennen. Trainiert ist das Netz auf Anwendungen eines bestimmten, aber gerne genutzten, Photoshop-Tools – dem Werkzeug "Face Aware Liquify".

Face Aware Liquify

Face Aware Liquify (FAL) ist ein Werkzeug, das es erlaubt Gesichter halbautomatisch zu modifizieren. Diverse Parameter wie Augengröße, Gesichtsform oder Mundform lassen sich dabei über einfache Schieberegler verändern. Photoshop verzerrt dann das Bild und erlaubt so etwa Gesichtsausdrücke hervorzurufen, die im originalen Bild nicht – oder zumindest nicht so sehr – zu sehen sind. Anders als bei Face-Swaps und verwandten Manipulationen, sind die mit FAL erstellten Effekte oft subtil und zeigen kaum offensichtliche Artefakte. Es seien solche "klassischen Bildbearbeitungsmethoden, die am meisten zur zunehmenden Verbreitung manipulierter visueller Inhalte beitragen", schreiben die Forscher in ihrer Veröffentlichung.

Empfohlener redaktioneller Inhalt

Mit Ihrer Zustimmung wird hier ein externes Video (TargetVideo GmbH) geladen.

Ich bin damit einverstanden, dass mir externe Inhalte angezeigt werden. Damit können personenbezogene Daten an Drittplattformen (TargetVideo GmbH) übermittelt werden. Mehr dazu in unserer Datenschutzerklärung.

Das von den Forschern trainierte neuronale Netz kann per FAL manipulierte Bilder nicht nur erkennen, sondern oft auch ableiten, wie das Bild modifiziert wurde, und die Bearbeitung weitgehend rückgängig machen. Als Trainingsdaten dienten dabei automatisiert erstellte Manipulationen, die durch ein Skript entstanden, das die von Face Aware Liquify angebotenen Parameter zufällig verändert hat. Obwohl das keine normale Nutzung des Tools darstellt, konnte das Netz nicht nur gleichartig konstruierte Validierungsdaten weitgehend korrekt klassifizieren. Es war auch erfolgreich bei der Erkennung von Manipulationen in einer Testmenge an Bildern, die ein menschlicher Photoshop-Künstler erstellt hatte.

Manipulationserkennung besser als Menschen

Das neuronale Netz wurde mehrfach mit verschieden präparierten Ausgangsdaten gefüttert, um zu sehen wie sich Faktoren wie die Auflösung der Bilder, Bildkompression und nicht-manipulative Operationen wie Größenänderungen auswirken. Gemessen wurde nicht nur die schlichte Klassifikation von manipuliert und nicht-manipuliert, sondern auch andere Beurteilungsmaße, wie die korrekte Zuordnungsrate, wenn ein manipuliertes und ein originales Bild vorgelegt wurde (Two-alternative forced choice, 2AFC). Das beste Modell erzielte dabei eine korrekte Zuordnungsrate von 99,4 Prozent, weit besser als die von Menschen erzielten 53,5 Prozent, wie Adobe hervorhebt. Letzteres ist nur knapp besser als ein Münzwurf.

(Bild: UC Berkeley / Adobe Research)

Allerdings handelte sich bei der menschlichen Kontrollgruppe um Arbeitskräfte, die über Amazons Mechanical Turk angeworben wurden und keine Erfahrung in der Erkennung von Bildmanipulationen hatten. Auch war die Zeit, die sie hatten, um eines der beiden präsentierten Bilder als manipuliert zu erkennen, mit sechs Sekunden relativ kurz bemessen.

Hinzu kommt, dass die menschlichen Tester auch nur auf den automatisiert erstellten Trainingsdaten derart schlechte Ergebnisse zeigten. Die von einem Künstler kreierten Manipulationen erkannten sie im 2AFC-Test zu 71,1 Prozent korrekt. Dieser Unterschied ist den Forschern nach darin begründet, dass der Künstler generell stärkere – und dadurch sichtbarere – Änderungen am Bild durchführte. Während Menschen das offenbar ausnutzen konnten, sank die Erkennungsrate des künstlichen neuronalen Netzes hier interessanterweise. Sie war mit 92,0 Prozent aber immer noch deutlich besser als die der menschlichen Vergleichsgruppe. Die Forscher vermuten daher gewisse grundsätzliche Unterschiede zwischen den automatisiert manipulierten Trainings-Bildern und den vom Menschen veränderten Test-Bildern.

Vertrauen in digitale Bilder dank KI?

Ob derartige Systeme dazu taugen "das Vertrauen in und die Glaubwürdigkeit von digitalen Medien zu erhöhen", wie Adobe es sich wünscht, scheint zweifelhaft. Abhängig vom Anwendungsfall mögen auch Erkennungsraten von über 90 Prozent nur unzureichende Sicherheit bieten. Außerdem werden auch die Tools zum Erstellen von Manipulation immer besser und vor allem einfacher zu bedienen. Ironischerweise sind es gerade die Programme von Adobe und zunehmend auch künstliche Intelligenz, die Bilderfälschen für alle möglich machen. (syt)