Making of: Wie eine KI Beethovens 10. Sinfonie vollendet hat

Ahmed Elgammal erklärt im TR-Interview, wie die KI tickt, die Beethovens "Unvollendete" zu Ende komponiert hat, und was das für Musik und Kunst bedeutet.

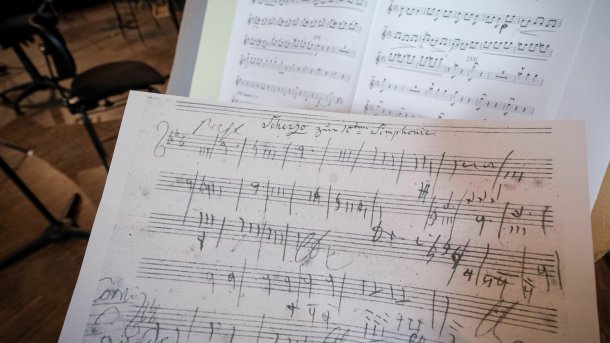

Original-Skizzen von Beethoven neben den Noten der künstlichen Intelligenz.

(Bild: Deutsche Telekom)

Am 9. Oktober 2021 wurde die von einer KI vervollständigte 10. Sinfonie von Beethoven erstmals öffentlich aufgeführt. Die KI stammt von Ahmed Elgammal, der an der Rutgers University im US-Bundesstaat New Jersey das Art and Artificial Intelligence Laboratory leitet. Elgammal forscht seit langem zu künstlicher Kreativität und hat ein Start-up, das Künstler mit KI experimentieren lässt. IM Interview mit Technology Review erklärt er, wie das Projekt funktioniert hat, und welche Konsequenzen solche KIs für Kunst und Künstler in Zukunft haben könnten.

Technology Review: Das Erste, was mir in den Sinn kam, als ich von Ihrer Arbeit gelesen habe, war, dass Sie etwas Ähnliches machen wie die Leute mit den großen Sprachmodellen: Sie beginnen mit einer Eingabeaufforderung und das Modell vervollständigt diese, richtig?

Ahmed Elgammal: Absolut richtig. Das Modell, das wir verwenden, ist den Modellen, die bei der Verarbeitung natürlicher Sprache verwendet werden, sehr ähnlich. Denn im Grunde ist Musik eine Sprache. Musik ist eine Folge von Noten mit einer gewissen Dauer, das heißt, eine Folge von Symbolen, und Sprache ist eine Folge von Wörtern – das ist also eine sehr natürliche Parallele.

Aber wir haben verschiedene Modelle entwickelt. Es gibt im Wesentlichen vier verschiedene Aufgaben, die wir bewältigen müssen. Jedes Modell, das diese Aufgabe löst, hat eine etwas andere Architektur. So gibt es die Aufgabe, ein Thema auszuwählen und darauf basierend eine längere Musiksequenz zu entwickeln. Dann gibt es eine Harmonisierung, die zu einer Melodie führt. Dann gibt es noch eine so genannte Überbrückungsaufgabe. Dabei liegen zwei Musiksegmente vor oder es sollen ein oder zwei Elemente hinzufügt werden. Die Aufgabe ist es, diese in der Mitte zu verbinden und auch zu lernen, wie man sie abschließt. Die vierte Aufgabe schließlich ist die Orchestrierung der gesamten Komposition.

Videos by heise

Unterscheidet sich die Architektur der einzelnen Modelle oder ist sie im Grunde bei allen gleich?

Alle Modelle basieren hauptsächlich auf der Transformer-Architektur aus der Sprachverarbeitung. Wir haben zum Beispiel Skizzen. Sie sind Ausgangspunkte für das Hauptthema, das zweite Thema und solche Dinge, und wir wollen im Grunde genommen Beethovens Art der Entwicklung lernen, die der natürlichen Sprachverarbeitung sehr ähnlich ist. Wir alle wissen jedoch, dass, wenn man anfängt zu schreiben und KI verwendet, um einen Satz in einem neuen Text fortzusetzen, früher oder später im Grunde genommen Unsinn dabei herauskommt. Die KI hält sich nicht wirklich an eine kohärente Geschichte, und das war mehr oder weniger eines der größten Probleme, die wir hatten.

Empfohlener redaktioneller Inhalt

Mit Ihrer Zustimmung wird hier ein externes YouTube-Video (Google Ireland Limited) geladen.

Ich bin damit einverstanden, dass mir externe Inhalte angezeigt werden. Damit können personenbezogene Daten an Drittplattformen (Google Ireland Limited) übermittelt werden. Mehr dazu in unserer Datenschutzerklärung.

Die erste Herausforderung besteht also darin, wie wir diese Modelle so trainieren können, dass sie sich an das Thema halten. Wir haben also ein musikalisches Thema, und man muss bei der Entwicklung darauf achten, dass die KI nicht von diesem musikalischen Thema abweicht. Das ist etwas ganz anderes als bei der Sprache, denn wenn man schreibt, hat man einen Gedanken im Kopf. Um das zu erreichen, müssen wir also zuerst die Modelle ändern, so dass eine hohe Aufmerksamkeit auf dem Thema bleibt. Außerdem brauchten wir Trainingsdaten, die auf eine spezifische Weise gelabelt sind. Wir haben also Musikexperten hinzugezogen, die markiert haben, dass dies ein Thema ist und dies eine Entwicklung.

Gesamte klassische Musik zu Beethovens Zeiten als Trainingsdaten

Große Sprachmodelle funktionieren meistens erstaunlich gut. Das liegt aber an einem sehr großen Datensatz für das Training und daran, dass es sich um sehr, sehr große Modelle handelt. Aber ich glaube, eines Ihrer Probleme ist der Mangel an guten Trainingsdaten in der Musik, oder haben Sie genug Daten?

Ja, das ist eines der Probleme, mit denen wir zu kämpfen haben. Wir haben nur neun Sinfonien von Beethoven. Als Erstes haben wir also vortrainierte Basismodelle verwendet, die auf einer großen Gruppe von Beispielen gelernt haben. Wir haben die gesamte klassische Musik verwendet, die wir haben – alles, was Beethoven wahrscheinlich gehört hat, als er aufwuchs. Auf dieser Grundlage kann man nun die Feinabstimmung vornehmen und die Modelle auf Performance ausrichten.

Aber ehrlich gesagt denke ich, dass Musik in gewissem Sinne viel einfacher ist als Sprache, weil Musik eine sehr strukturierte Sprache ist. Sprache hat eine semantische Ebene, und ohne explizite Beschreibung der Semantik braucht man einen riesigen Korpus an Trainingsdaten, um das fehlende Verständnis der Semantik zu kompensieren. Musik ist in erster Linie eine Abfolge von Wörtern mit einer mathematischen Struktur, die einer Vielzahl von Beschränkungen unterliegt. Das ist also uns zum Vorteil gereicht, aber andererseits reagiert man in der Musik sehr empfindlich auf jede falsche Note.

War es der endgültige Prozess der Ausgabe, der in einem Schritt gemacht wurde, oder haben Sie ihn in verschiedene Schritte aufgeteilt und alles zusammengeführt?

Letzteres. Wir haben Beethovens Skizzen und ein gewisses Verständnis davon, was das Hauptthema sein würde und was als zweites Thema kommt. Wir haben also die vorliegenden Musiksegmente, die Seeds, verwendet, um diese Abschnitte von der KI ausfüllen zu lassen, und dann wird alles am Ende zusammengesetzt.